强化学习也将陷入死胡同。

昨天夜里,前OpenAI研究员Kevin Lu 发了一篇长文,直指当下AI研究的核心问题:我们都在错误的方向上努力。

他的观点很是犀利:

真正推动AI大规模进步的不是Transformer,而是互联网。

这话听起来像是在开玩笑。

但Kevin Lu给出了一个让人深思的论证:没有互联网提供的海量数据,就算有了Transformer,我们也造不出GPT-4。

数据才是AI的命脉,这个道理大家都懂,但研究者们却选择性地忽略了它。

Transformer是个分心的玩具

Kevin Lu提到了一个有趣的现象:自从GPT-4发布以来,已经过去了两年多,但我们很难感受到基础模型有什么质的飞跃。

为什么?

因为我们进入了一个新的时代:从计算受限转向了数据受限。

在计算受限的时代,更高效的架构确实能带来更好的性能。但现在,所有方法的性能都会趋同,因为瓶颈不在算法,而在数据。

Kevin Lu甚至大胆地说:就算没有Transformer,用CNN或者状态空间模型,我们也能达到GPT-4.5的水平。

但问题是,没有互联网,就算有Transformer,我们也造不出GPT-2。

互联网:AI的培养皿

Kevin Lu把互联网比作AI诞生的「原始汤」(primordial soup),这个比喻很是贴切。

互联网为next-token prediction提供了完美的数据源:

多样性

从小众语言到冷门粉丝文化,只要有人关心,就会在互联网上留下痕迹。这些内容最终都会被永远地刻进AGI的记忆里。

天然技能课程

从小学生的Khan Academy,到大学的MIT开放课程,再到前沿的arXiv论文,互联网自然地形成了一个从易到难的学习阶梯。

用户自发贡献

最关键的是,人们想要使用互联网。这不是研究员人工构建的数据集,而是活生生的人类智慧的记录。

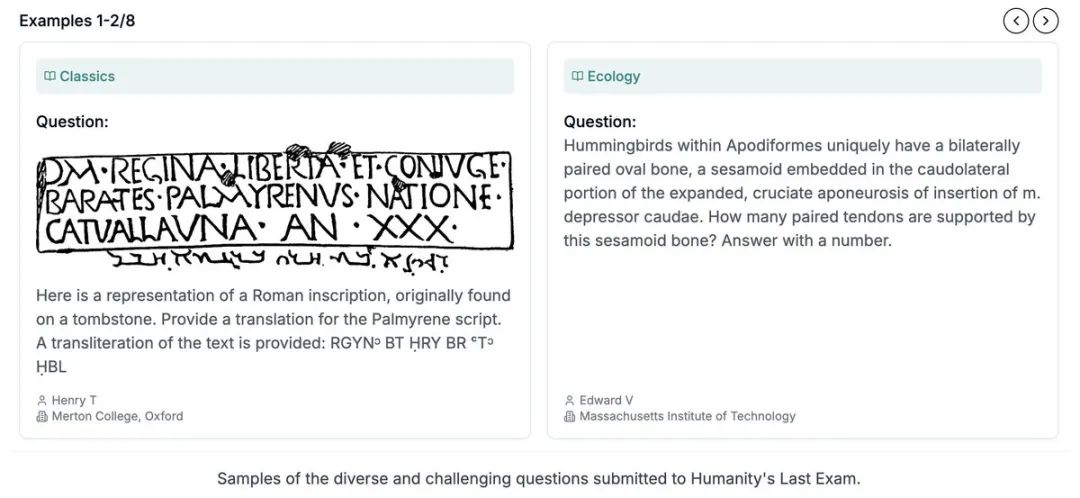

Kevin Lu引用了Alec Radford在2020年的一次演讲:

每次我们构建数据集,就是把世界上其他所有东西的重要性设为0,把数据集里的东西重要性设为1。我们可怜的模型!它们知道得太少,却还有太多东西被我们隐藏了。

强化学习的困境

既然互联网是监督学习的完美搭档,那强化学习的「互联网」在哪里?

Kevin Lu认为这正是问题所在。目前的强化学习要么依赖于:

人类偏好(RLHF)

收集困难,噪声巨大,而且不同人的偏好可能完全相反。

可验证奖励(RLVR)

局限于数学、编程等狭窄领域,很难泛化到其他任务。

而研究者们在做什么?

还在调整Q函数的裁剪方式,研究新的时序高斯探索方法……

这些都不会带来真正的突破。

产品才是出路

Kevin Lu的核心观点是:

要创造强化学习的「互联网」,必须从产品入手。

他列举了几个可能的方向:

机器人技术

但面临奖励标注困难、形态差异、现实差距等挑战。

推荐系统

某种程度上是人类偏好的延伸,但更有针对性。

AI研究

让AI来训练AI,优化基准测试性能。

交易系统

有清晰的指标(赚钱),但你的RL智能体很可能会学会「不玩」。

计算机操作数据

类似Adept尝试的方向,教模型执行计算机操作。

但这些都还不够。Kevin Lu梦想的是一个像互联网一样丰富、多样、有经济价值的RL任务生态系统。

这需要的不是RL理论经验,而是产品思维。

研究与产品的协同设计

Kevin Lu特别强调了研究与产品协同设计的重要性。

互联网之所以完美,是因为:

-

它是去中心化的,任何人都可以贡献知识 -

它有自然的激励机制(点赞、广告收入) -

它是经济可行的,便宜到人人都能用 -

人们真的想用它

这些特性不是研究员设计出来的,而是产品自然演化的结果。

AGI不应该只是在数学题上表现优秀,而应该真正改变人类的生活。

如果这是我们的目标,那么从一开始就应该考虑AGI的产品形态。

写在最后

Kevin Lu的文章,也让我想到了一个问题:

当所有研究者都在优化算法时,谁来优化数据?

互联网用了20年时间,创造了一个让AI得以诞生的数据海洋。现在,我们需要为强化学习创造同样的东西。

这不是一个技术问题,而是一个生态问题。

如Kevin Lu所说,未来五年或将由一次大规模的强化学习训练决定。

如果我们还在摆弄RL算法的小零件,而不是思考如何创造新的数据源,那我们可能会重蹈2015-2020年RL研究的覆辙——

做了很多研究,但都不重要。

所以,也许是时候从实验室走出来,去真实世界创造些什么了。

毕竟,改变世界的从来不是算法,而是产品。

Kevin Lu 原文

(文:AGI Hunt)