量子计算机拥有革新药物研发、材料设计和基础物理学的潜力,前提是我们能让它们稳定可靠地运行。某些问题,传统计算机需要数十亿年才能解决,而量子计算机只需几个小时。然而,这些新型处理器比传统处理器更容易受到噪声的影响。为了让量子计算机更加可靠,尤其是在规模化应用时,我们需要精确地识别和纠正这些错误

今天,谷歌在《自然》杂志上发表了一篇论文,介绍了AlphaQubit,一个基于人工智能的解码器,能够以最先进的精度识别量子计算错误。这项合作汇集了Google DeepMind的机器学习知识和Google Quantum AI的纠错专业技术。精确识别错误是使量子计算机能够进行大规模长时间计算的关键一步

量子计算错误的纠正原理

量子计算机利用物质在最小尺度上的独特属性(例如叠加和纠缠)来以比经典计算机少得多的步骤解决某些类型的复杂问题。这项技术依赖于量子比特(或量子位),它们可以通过量子干涉来筛选大量可能性以找到答案

量子比特的自然量子态非常脆弱,容易受到各种因素的干扰:硬件中的微观缺陷、热量、振动、电磁干扰,甚至宇宙射线(无处不在)

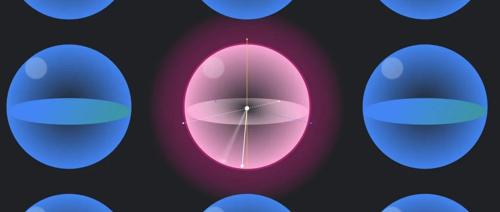

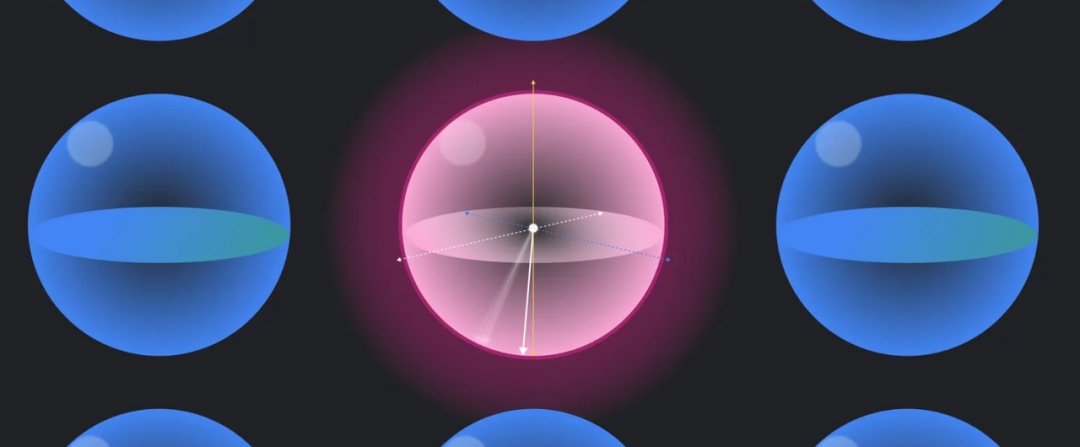

量子纠错提供了一种前进的道路,它利用冗余:将多个量子比特分组到一个逻辑量子比特中,并定期对其进行一致性检查。解码器通过使用这些一致性检查来识别逻辑量子比特中的错误,以便对其进行纠正,从而保留量子信息

图:九个物理量子比特如何组成一个逻辑量子比特,以及一致性检查和AlphaQubit解码的过程

AlphaQubit:基于神经网络的解码器

AlphaQubit是一个基于神经网络的解码器,它借鉴了Transformer。利用一致性检查作为输入,它的任务是正确预测逻辑量子比特在实验结束时测量时是否与其准备状态发生翻转

研究人员首先训练模型解码来自Sycamore量子处理器(量子计算机的中央计算单元)内部一组49个量子比特的数据。为了教会AlphaQubit通用的解码问题,他们使用量子模拟器生成了数亿个涵盖各种设置和错误级别的示例。然后,通过提供来自特定Sycamore处理器的数千个实验样本,对AlphaQubit进行微调,以完成特定的解码任务

在对新的Sycamore数据进行测试时,AlphaQubit与之前的领先解码器相比,在准确性方面树立了新的标准。在最大的Sycamore实验中,AlphaQubit的错误率比张量网络方法(一种精度很高但不切实际的慢方法)低6%。AlphaQubit的错误率也比相关匹配(一种足够快且可扩展的精确解码器)低30%

图:AlphaQubit与其他解码器在不同规模实验中的性能对比

面向未来系统的AlphaQubit扩展性

为了了解AlphaQubit如何适应具有较低错误级别的更大设备,研究人员使用多达241个量子比特的模拟量子系统的数据对其进行了训练,因为这超出了Sycamore平台上的可用数据

AlphaQubit再次优于领先的算法解码器,这表明它也将在未来的中型量子设备上发挥作用

图:AlphaQubit在更大规模模拟实验中的性能表现

此外,AlphaQubit系统还展示了高级功能,例如接受和报告输入和输出的置信度的能力。这些信息丰富的接口可以帮助进一步提高量子处理器的性能。当使用包含多达25轮错误纠正的样本训练AlphaQubit时,它在多达100,000轮的模拟实验中保持了良好的性能,这表明它能够泛化到超出其训练数据的场景

迈向实用量子计算

AlphaQubit代表了在将机器学习用于量子纠错方面的一个重要里程碑。但仍然面临着速度和可扩展性方面的重大挑战

例如,在快速超导量子处理器中,每次一致性检查每秒测量一百万次。虽然AlphaQubit擅长准确识别错误,但它仍然太慢,无法实时纠正超导处理器中的错误。随着量子计算朝着商业相关应用所需的数百万个量子比特发展,还需要找到更有效的数据方法来训练基于AI的解码器

谷歌研究团队正在结合机器学习和量子纠错方面的开创性进步来克服这些挑战,并为可靠的量子计算机铺平道路,以解决世界上一些最复杂的问题

链接:Nature论文

https://www.nature.com/articles/s41586-024-08148-8

转译编辑整理自:

https://blog.google/technology/google-deepmind/alphaqubit-quantum-error-correction/

⭐

(文:AI寒武纪)