随着人工智能的迅猛发展,AI对数据的依赖越来越高,尤其是在大语言模型(LLM)需要大规模、高质量的数据集来进行训练与应用时,网络数据采集成为了关键的环节。

然而,现有的许多爬虫工具往往面临性能瓶颈、数据结构化处理不足等问题,导致在面对复杂的网络数据时难以应对。

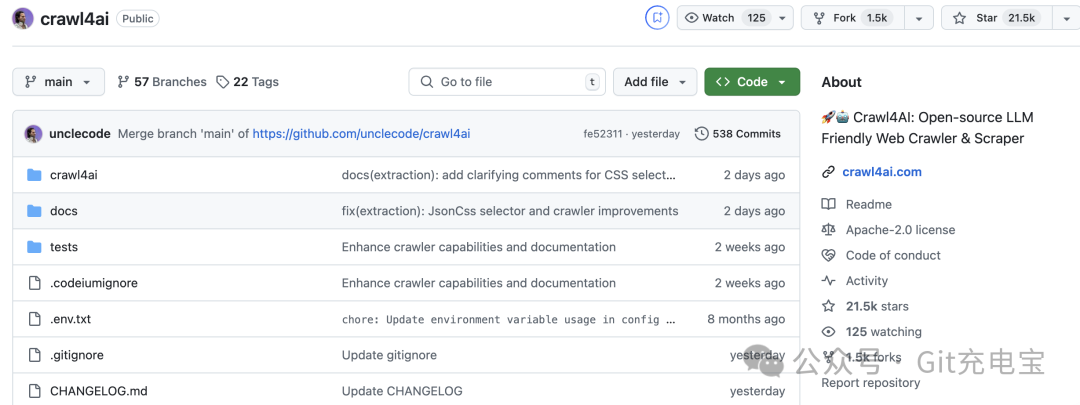

今天,我要给大家介绍一款当下 GitHub 上备受关注的开源项目:Crawl4AI,它不仅仅是一个高效的网络爬虫工具,更是为 AI 时代量身定制的数据采集利器。

Crawl4AI 提供了一套完备的解决方案,专为大语言模型(LLM)数据需求量身设计,从而提高了数据抓取的效率、降低了成本,并进一步完善了数据的结构化处理和智能化操作。

核心特色

为 LLM 量身定制

-

• Markdown 适配 RAG 应用

-

• 优化数据格式,提升数据处理效率

-

• 能够更好地理解和使用抓取到的信息

极致性能

-

• 速度提升 6 倍

-

• 简单、复杂的网页抓取都能高效完成

-

• 提高生产力,并兼顾成本控制

浏览器掌控

-

• 全面浏览器集成

-

• 支持从会话管理到代理设置的全面控制

-

• 模拟浏览器的所有操作,绕过防爬虫机制

-

• 支持自动化浏览器任务

智能算法

-

• 降低对昂贵模型的依赖

-

• 智能调节抓取策略

-

• 节省成本的同时,仍能保证抓取效果

开源部署

-

• 灵活集成与部署

-

• 完全开源,且不需要 API 密钥

-

• 可快速集成到 Docker 或任何云平台中

新版本 0.4.24x 更新亮点

优化 JSON 处理机制

-

• 增强了对 JSON 数据格式的处理能力

-

• 更容易地对数据进行后续处理和存储

增强 SSL 安全性

-

• 对 SSL 安全性进行增强

-

• 确保抓取过程中数据的安全传输

-

• 避免敏感信息泄露

亚马逊产品信息提取

-

• 新增了针对亚马逊平台的产品信息提取功能

-

• 精准抓取产品名称、价格、评分、评论等信息

-

• 助力电商数据分析

重构内容过滤系统

-

• 优化了内容过滤机制

-

• 更精准地过滤掉无用数据

这些升级使得 Crawl4AI 在网络数据抓取方面更加智能、高效,为开发者和数据分析师提供了更强大的支持。

安装指南

Crawl4AI 支持简单的安装和部署,无论是开发者、数据分析师,还是研究人员,都可以快速上手。

方式一:Python 方式安装

可只是使用 Python 包的安装方式,在爬虫程序中直接调用。

pip install crawl4ai

crawl4ai-setup # Setup the browser当安装 Crawl4AI 时,crawl4ai-setup 应该会自动安装并设置 Playwright。不过,如果您遇到任何与 Playwright 相关的错误,您可以使用以下方法手动安装它:

playwright install

如不起作用,还可尝试以下命令:python -m playwright install chromium

使用示例,创建一个简单的爬虫:

import asyncio

from crawl4ai import *

async def main():

async with AsyncWebCrawler() as crawler:

result = await crawler.arun(

url="https://www.nbcnews.com/business",

)

print(result.markdown)

if __name__ == "__main__":

asyncio.run(main())方式二:Docker部署

由于Docker 部署方式,官方说明已经丢弃,不久后会有更新版本上线。

所以此种方式,当下暂不过多罗列了。

使用场景与优势

AI 训练数据采集

-

• 可以帮助你快速抓取大量符合特定要求的文本数据

-

• 尤其是针对大语言模型(LLM)的训练数据

电商数据分析

-

• 针对电商平台,尤其是亚马逊

-

• 提供了精确的产品信息抓取功能

-

• 能够帮助用户分析商品的价格、评分、评论等数据

-

• 方便进行市场趋势分析和竞争对手监控

新闻与文章抓取

-

• 对于需要实时获取新闻、文章、论坛等动态内容的应用

-

• 通过强大的浏览器模拟功能,保持数据源的时效性

市场研究与竞争情报

-

• 对竞争对手的网站进行深度抓取

-

• 帮助企业获取市场和行业的相关数据

-

• 支持企业进行智能决策

写在最后

Crawl4AI 不仅是一个爬虫工具,更是为 AI 时代量身定制的智能数据采集利器。

通过智能算法、AI集成、浏览器控制和高性能抓取,Crawl4AI让数据采集变得更加智能、便捷且高效。

无论是大规模数据抓取,还是细致的结构化数据提取,Crawl4AI 都能高效处理,并且提供了灵活的部署方式,让开发者和数据分析师能够轻松集成。

如果你正在寻找一款高效、灵活且开源的爬虫工具,Crawl4AI 会是你不可错过的选择。

GitHub 项目地址:https://github.com/unclecode/crawl4ai

在线使用文档:https://crawl4ai.com/mkdocs

好了,今天的分享到此结束,感谢大家抽空阅读,我们下期再见,Respect!

(文:开源星探)