年底国内各个AI玩家杀疯了,前两天完全开源的Deepseek R1 震撼整个AI业界,今天字节又联合清华整活,一个强大的原生的开源 AI Agent UI-TARS震撼上线

看了UI-TARS的论文,我给大家划划重点

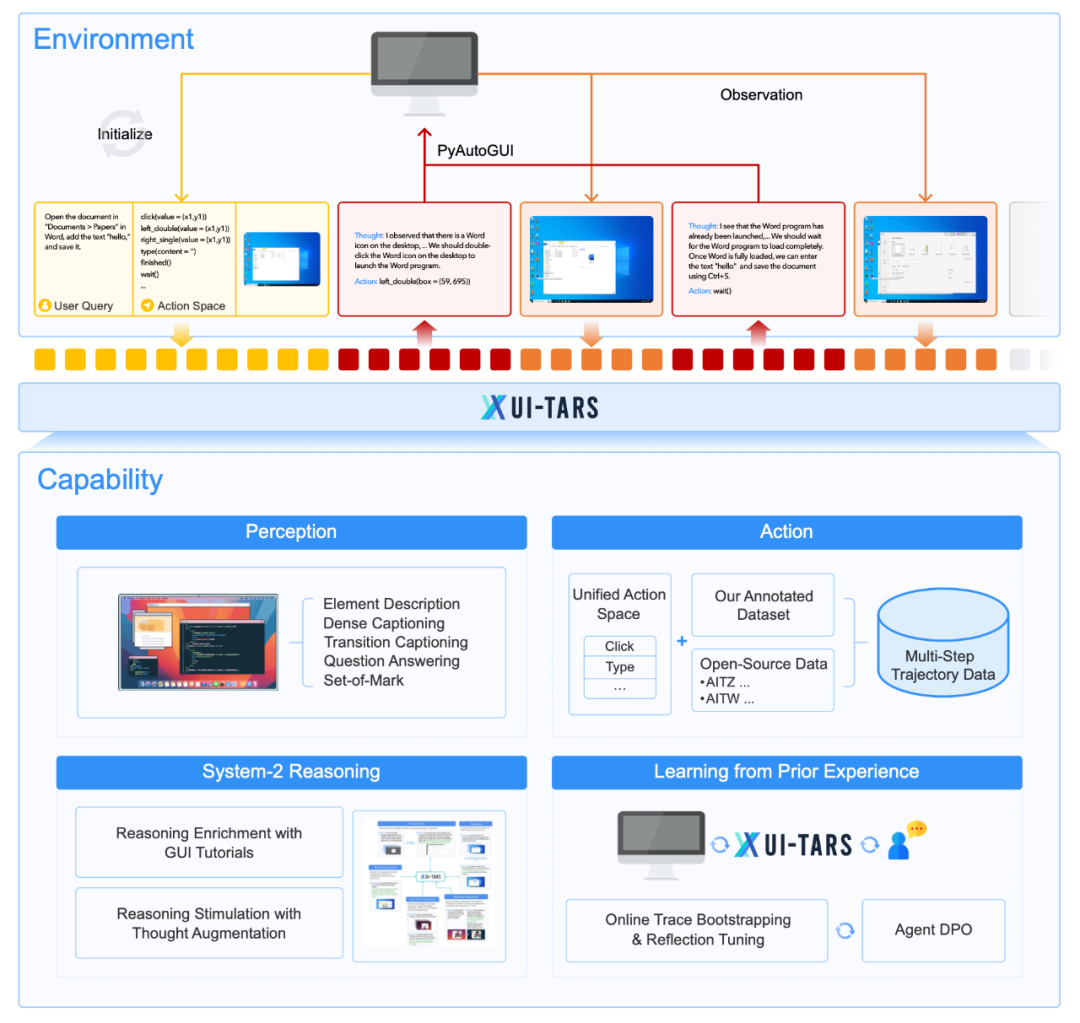

【纯视觉感知】:告别文本依赖,像人眼一样“看”懂GUI!

传统的GUI自动化方案,很多都依赖于解析网页代码(HTML)或者软件的API接口。但这种方式有两个致命缺陷:一是平台限制,不同平台、不同软件的底层代码和API都不一样,导致自动化方案难以通用;二是容易失效,一旦网页或软件界面改版,代码或API接口变动,自动化脚本就可能直接崩溃。

而 UI-TARS 彻底抛弃了这些“拐杖”,它就像人类一样, 直接“看”屏幕截图 来理解GUI界面!这听起来很简单,但背后却蕴含着巨大的技术突破!想象一下,我们人类操作电脑,难道是先去解析软件的代码吗?当然不是!我们直接看屏幕上的按钮、图标、文字,就能理解界面的布局和功能,并做出相应的操作。 UI-TARS 正是模拟了人类这种最自然的GUI交互方式!

这种 纯视觉感知 的优势是显而易见的: 无需API,无需解析代码,天然跨平台! 无论是Windows、macOS、Android、iOS,甚至是各种网页应用, UI-TARS 都能轻松应对! 这才是真正的 通用GUI自动化!

【端到端架构】:感知、推理、动作一体化,更智能高效!

传统的智能体框架,往往将感知、推理、动作等模块 割裂开来,导致信息传递效率低下,模块之间容易出现脱节。就像组装电脑,各个零件性能再好,如果主板不行,整体性能也会大打折扣。

UI-TARS 采用了 【端到端】 的架构,将感知、推理、记忆、动作 【融为一体】!就像一个 大脑 一样,信息在各个模块之间 无缝流动, 协同工作, 从而实现更高效、更智能的决策和执行。这种架构不仅提升了运行效率,也为后续的 自学习和进化 奠定了坚实的基础

【系统2推理】:从“快思考”到“慢思考”,应对复杂任务游刃有余!

我们人类的思考方式,分为“快思考”和“慢思考”两种模式。“快思考” 依赖直觉和经验,快速做出反应,适合处理简单、重复的任务;“慢思考” 则更加理性、深入,需要进行逻辑分析和规划,适合处理复杂、需要策略的任务

传统的自动化方案,往往只能进行 “快思考”, 处理一些简单的点击、输入操作还可以,但面对复杂的、需要多步骤、多策略的任务就束手无策了

UI-TARS 创新性地引入了 【系统2推理】 机制,使其兼具 “快思考” 和 “慢思考” 两种能力!** 面对简单任务, UI-TARS可以像 “快思考” 一样, 快速响应,高效执行;面对复杂任务, UI-TARS 则会切换到 “慢思考” 模式,进行 任务分解、长期规划、试错反思, 从而 更可靠、更智能地完成任务!这种 “快慢结合” 的推理能力, 才是 UI-TARS 能够应对各种复杂GUI场景的关键所在!

【迭代自学习】:越用越聪明,持续进化!

传统的自动化方案,一旦开发完成,就很难再进化升级,只能被动地等待开发者更新。就像买了一台固定配置的电脑,用久了就会落伍。UI-TARS 具备 【迭代自学习】 能力, 能够像 【生命体】 一样, 在 【真实世界】 中不断学习和进化!它可以通过 在线收集用户交互数据, 过滤掉噪声数据, 提炼出高质量的训练样本, 然后 反思自身的错误, 不断优化模型参数, 提升自身性能! 越用越聪明, 越用越强大!

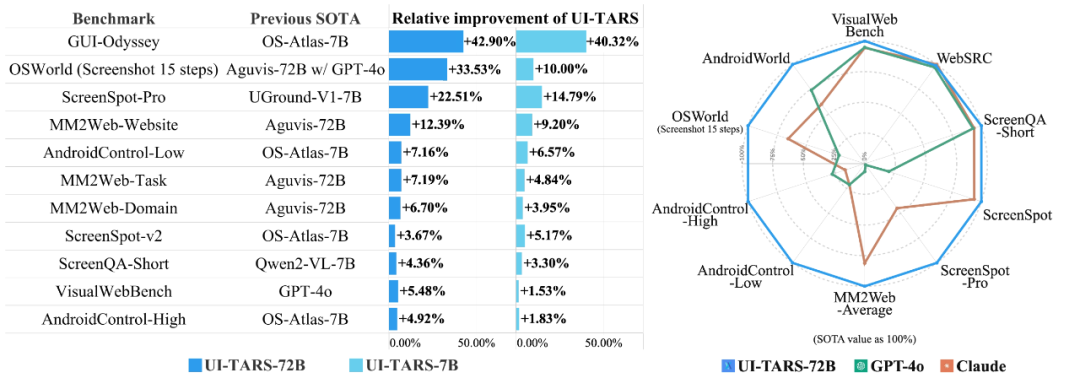

可能有些朋友看到这里会觉得有点抽象, UI-TARS 到底有多厉害?我们还是用 【硬核数据】 说话!

在【GUI智能体领域最权威的基准测试】 中, UI-TARS 的表现简直可以用 【炸裂】 来形容!

-

• 【10+项基准测试 全面 SOTA】!在 感知、Grounding、GUI任务执行 等 超过10项关键指标的测试中, UI-TARS 全面超越所有现有模型, 霸榜 SOTA 榜单!

-

• 【OSWorld 挑战赛 实力碾压 商业巨头】!【OSWorld】 被誉为 GUI智能体的 “世界杯”, 难度极高, 竞争激烈!在这个顶级赛事中, UI-TARS 更是 技惊四座, 力压 Claude 和 GPT-4o 等 商业巨头

-

• 【AndroidWorld 移动端 同样惊艳 远超 GPT-4o】!不仅在桌面端表现出色, UI-TARS 在 【移动端 基准测试 AndroidWorld】中, 同样 惊艳四座, 大幅领先 GPT-4o!

写在最后:

UI-TARS,这是一种原生的 GUI 智能体模型,它将感知、动作、推理和记忆集成到一个可扩展且适应性强的框架中。在诸如 OSWorld 之类的具有挑战性的基准测试中取得了最先进的性能,UI-TARS 的性能超越了 Claude 和 GPT-4o 等现有系统。提出了几项创新,包括增强的感知、统一的动作建模、系统 2 推理和使用在线轨迹的迭代改进,所有这些都使智能体能够有效地处理复杂 GUI 任务,而只需最少的人工监督

原生智能体模型的核心能力,包括感知、动作、推理和记忆,这些能力构成了 GUI 智能体未来发展的基石。虽然原生智能体代表着向前迈出的重要一步,但未来在于主动和终身学习的整合,在这种学习中,智能体自主地通过持续的真实世界交互来驱动自己的学习

飞书中文部署文档:

https://bytedance.sg.larkoffice.com/docx/TCcudYwyIox5vyxiSDLlgIsTgWf

体验:

https://huggingface.co/spaces/Aheader/gui_test_app

paper:

https://arxiv.org/abs/2501.12326

github:

https://github.com/bytedance/UI-TARS

⭐

(文:AI寒武纪)