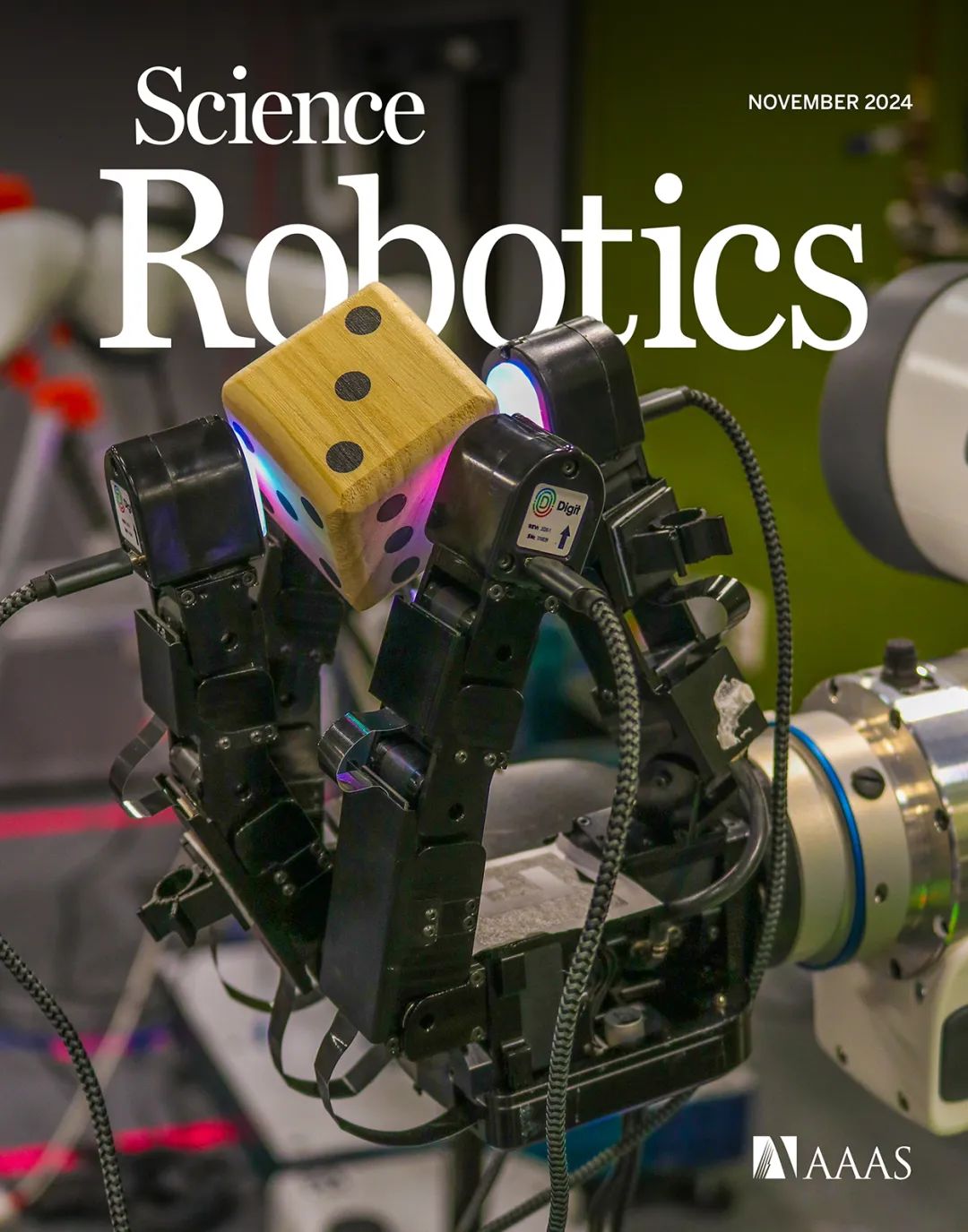

这一突破来自卡内基梅隆大学和Meta AI等机构的最新研究。研究团队开发了名为NeuralFeels的系统,让机器人通过视觉和触觉的结合,实现了对未知物体的精准感知与操控。这项研究还登上了Science Robotics的封面。

系统的核心是一个Allegro机器手,手指末端装配了四个DIGIT视觉触觉传感器,还有一个Intel

RealSense D435 RGB-D相机固定在约27厘米外的位置。机器人能一边转动物体,一边实时构建物体的三维形状,同时追踪其位置姿态。

这套系统最令人惊艳的是它的通用性。在实验中,研究人员让机器人抓取了各种形状和大小的物体,从6厘米到18厘米不等。测试结果令人惊喜:平均重建精度达到81%,位置追踪误差仅4.7毫米。如果是已知物体的形状,精度还能进一步提升到2.3毫米。

更厉害的是,即便在视觉受阻的情况下,这套系统依然能保持稳定性。当相机视野被严重遮挡时,触觉信息的加入能让追踪精度提升高达94%。这意味着机器人即便在”看不清”的情况下,也能通过”摸”来准确感知物体。

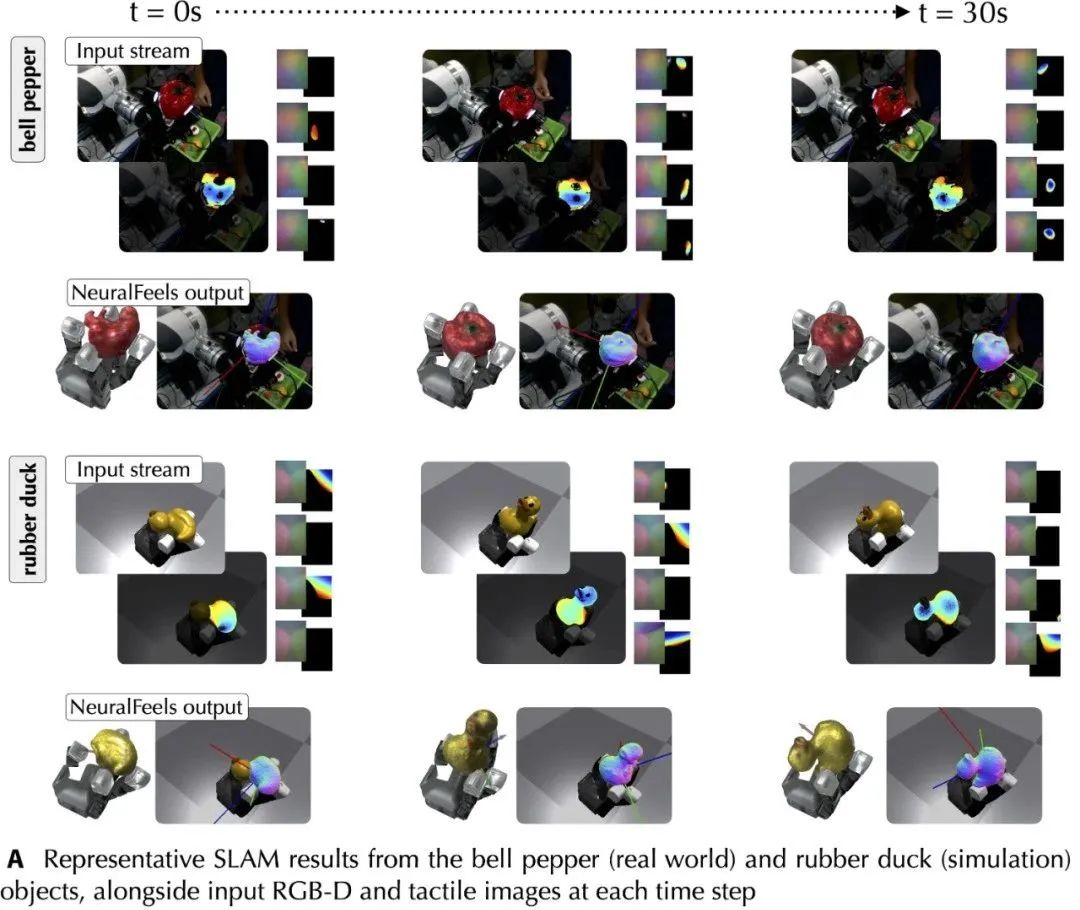

研究团队进行了大量的实验验证,包括70组实验数据,每组实验持续30秒。实验既在现实环境中进行,也在模拟环境中进行。在模拟环境中,物体的平均移动速度达到25毫米/秒,旋转速度达到32.6度/秒;在真实环境中也能达到20毫米/秒的移动速度和9.9度/秒的旋转速度。

NeuralFeels系统的核心技术在于它巧妙地将神经场(Neural

Fields)技术与多模态感知相结合。这种方法可以让机器人在线学习物体的几何特征,而不需要预先知道物体的形状。

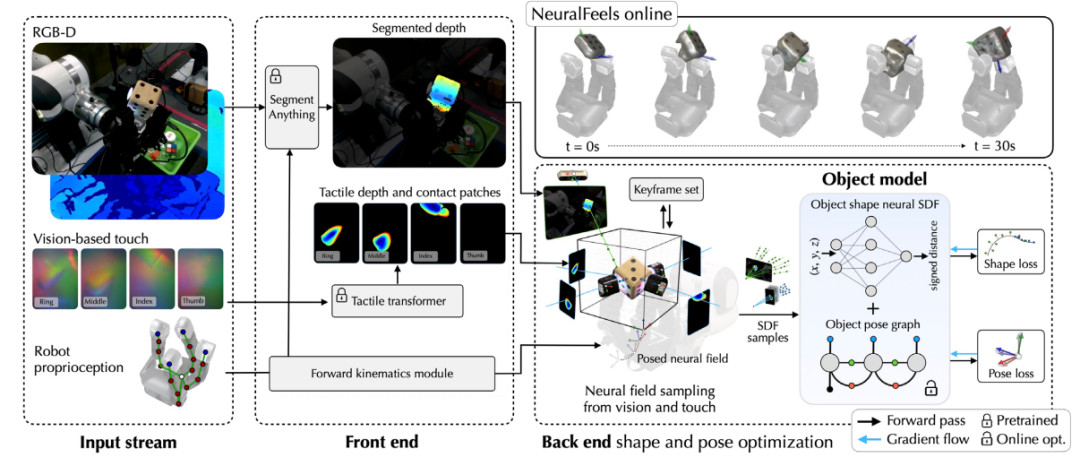

系统的前端负责处理原始的视觉和触觉数据,将它们转换成深度信息。研究团队采用了目前最强大的视觉基础模型之一SAM(Segment Anything Model),能够精确地分割出物体轮廓。同时,他们还开发了专门的触觉转换器(Tactile Transformer),可以将触觉图像转换为精确的接触深度数据。

在后端处理中,系统采用了交替优化的策略:一方面优化神经网络来重建物体形状,另一方面通过位姿图优化来追踪物体位置。这种方法不仅能实时更新物体模型,还能有效处理传感器噪声和遮挡问题。

研究团队的一个重要创新是将视觉基础的触觉感知视为一个局部的视觉问题。虽然视觉和触觉传感器看似不同,但它们都可以用类似的方式处理。不过,触觉图像有其特殊性:它们的视野范围更小,深度范围通常以厘米计,而且在非接触区域会出现深度不连续的情况。

为了解决这些挑战,系统在不同尺度上采样数据:对视觉数据采用米级尺度,对触觉数据采用厘米级尺度。同时,系统只对触觉数据的表面点进行采样,而对视觉数据则同时采样空闲空间和表面点。

这种模块化的设计使得系统具有很强的扩展性。其他类型的触觉传感器只要能在仿真环境中准确模拟,就可以轻松集成到系统中。同时,系统还可以集成其他场景表示方法,以及添加更多的状态约束。

研究团队对NeuralFeels系统进行了深入的性能评估,特别关注了两个关键场景:视觉受阻情况和深度感知噪声。这些场景在现实世界中经常出现,也是测试系统稳健性的重要标准。

在视觉受阻实验中,研究人员模拟了200个不同位置的相机视角,每个相机都朝向机器人,形成一个半径为0.5米的球面分布。这些不同的视角会产生不同程度的机器人-物体遮挡,很好地模拟了真实场景中的各种情况。

实验结果显示:在所有相机位置上,触觉信息的引入平均带来了21.2%的性能提升,在某些严重遮挡的视角下,提升甚至达到了94.1%。这说明触觉信息在视觉受限时可以起到关键的补充作用。

在深度感知噪声实验中,研究人员通过添加像素偏移、量化误差和高频噪声来模拟真实RGB-D传感器的各种误差。结果表明,随着噪声程度的增加,触觉信息的作用越发明显,能够有效降低追踪误差的分布范围。

特别值得一提的是,系统在处理未知物体时表现出色。在实验中,绝大多数试验的形状重建质量都随时间提升 – 在模拟环境中,95%的试验显示持续改善;在真实环境中,也有83%的试验呈现出进步趋势。

尽管NeuralFeels取得了令人瞩目的成果,但研究团队也坦承系统仍存在一些限制和待改进之处。比如在现实世界中,触觉传感器的灵敏度往往低于仿真环境,这导致接触信号相对稀疏。此外,机器人的抓取策略在现实中的可靠性也不如仿真环境,有时需要人工干预。

更具挑战性的是,目前系统仍局限于固定相机设置,需要在线手眼标定或自我中心视觉。对于玻璃和金属等视觉上具有挑战性的物体,深度不确定性的建模也还需要进一步改进。

不过这些问题并不妨碍该研究的重要价值。事实上,NeuralFeels为机器人操作开辟了新的可能性。目前的方案已经可以处理几何形状,未来还可以进一步探索物体的材质、摩擦力等物理属性。这些信息对于更复杂的操作任务至关重要,比如使用工具或处理柔软物体。

研究团队已经开源了他们的FeelSight数据集,包含了大量的视触觉交互数据。这个数据集记录了机器人在30秒内操作各种物体的视觉、触觉和本体感觉数据。这些数据将有助于推动该领域的进一步发展。

展望未来,随着深度学习和机器人技术的不断进步,我们有理由相信机器人将能够完成更多复杂的操作任务。比如精确插入、非抓取式滑动,甚至是像人类一样灵活地使用各种工具。正如研究人员所说,要达到人类水平的灵巧操作,机器人必须能够从多模态感知中推断出空间意识,以此来推理接触互动。

[1]https://www.science.org/doi/10.1126/scirobotics.adl0628

[2]https://suddhu.github.io/neural-feels/

(文:机器人大讲堂)