2025年1月20日,深度求索公司正式发布了其最新的人工智能推理模型 DeepSeek-R1。该模型通过强化学习技术与极少量标注数据的结合,在推理能力上实现了突破,表现出色,尤其在数学推理、自然语言推理和代码生成等领域,性能与OpenAI的o1正式版相媲美。DeepSeek-R1的推出,标志着人工智能推理技术迈出了新的一步,为全球AI技术生态带来了新的机遇。

一、高性能推理能力

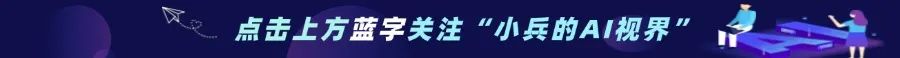

DeepSeek-R1在数学推理、代码生成、自然语言推理等多种复杂任务中,表现出色,与OpenAI o1正式版在推理速度和准确性上不相上下。通过强化学习技术,DeepSeek-R1能在极少的标注数据支持下,高效执行复杂推理任务,减少了模型训练的成本和时间。

-

数学推理:在AIME 2024上获得79.8%的pass@1得分,略微超过OpenAI-o1-1217。在MATH-500上,它获得了惊人的97.3%的得分,与OpenAI-o1-1217的性能相当,并且显著优于其他模型。

-

代码生成:在代码竞赛任务中展示了专家级水平,因为它在Codeforces上获得了2,029 Elo评级,超过了该竞赛中96.3%的人类参与者。对于工程相关的任务,DeepSeek-R1的表现略好于DeepSeek-V3,这有助于开发者在现实世界中开展工作。

-

自然语言推理:在MMLU、MMLU-Pro和GPQA Diamond等基准上,DeepSeek-R1取得了出色的成绩,显著优于DeepSeek-V3,在MMLU上得分为90.8%,在MMLU-Pro上得分为84.0%,在GPQA Diamond上得分为71.5%。

深度求索为DeepSeek-R1提供了MIT License开源协议,用户可以自由使用和商用。这一开放性使得全球开发者和企业能够灵活地将其集成到不同应用中,并且可以进行二次开发。尤其值得注意的是,DeepSeek-R1支持模型蒸馏,开发者能够基于该模型生成和训练其他专用模型,进一步推动AI技术的创新与普及。

三、 API服务与定制化计费

DeepSeek-R1不仅提供了强大的推理能力,还通过API服务支持定制化计费,使得企业和开发者可以根据自身需求灵活使用。这为不同规模的企业提供了极大的便利,降低了使用高性能AI模型的门槛。

四、技术突破:从零开始的推理能力进化

1.DeepSeek-R1-Zero:纯RL训练的“自我觉醒”

传统LLM的推理能力通常需要大量人工标注的监督数据,但DeepSeek-R1-Zero首次验证了无需任何SFT数据,仅通过强化学习即可实现推理能力的自主进化。其核心创新在于:

-

算法框架:采用Group Relative Policy Optimization(GRPO),通过组内奖励对比优化策略,避免传统RL中复杂价值模型的依赖。

-

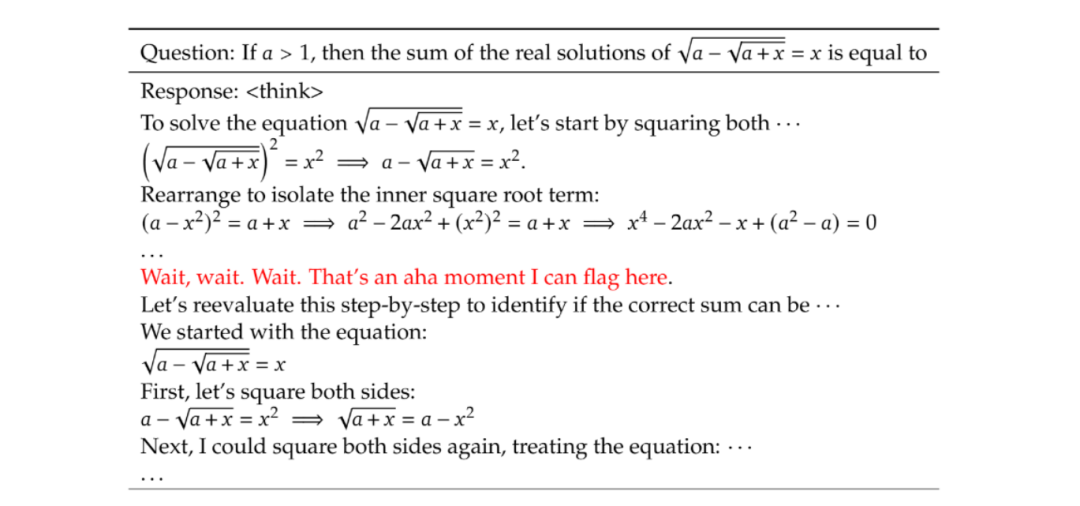

自我进化现象:模型在训练中自发涌现出“反思”(Re-evaluation)、“多步验证”(Multi-step Verification)等复杂推理行为。例如,在解决数学方程时,模型会主动纠正早期错误步骤。如图:

2.DeepSeek-R1:带有冷启动的强化学习

为了解决DeepSeek-R1-Zero在可读性和语言混合方面的挑战,并进一步提高推理性能,DeepSeek-R1在RL之前结合了多阶段训练和冷启动数据。具体步骤包括:

-

冷启动:通过多阶段训练和冷启动数据,提高模型的初始性能。

-

面向推理的强化学习:在冷启动之后,通过强化学习进一步优化模型的推理能力。

-

拒绝采样和监督微调:通过拒绝采样和监督微调,进一步提升模型的性能和稳定性。

-

所有场景的强化学习:在多个场景中应用强化学习,确保模型在不同任务中的表现一致性。

五、蒸馏:用推理能力增强小型模型

DeepSeek-R1不仅可以作为高性能的推理模型,还可以作为教师模型,将推理能力蒸馏到更小的模型中,且蒸馏后的模型具有出色的性能。例如:

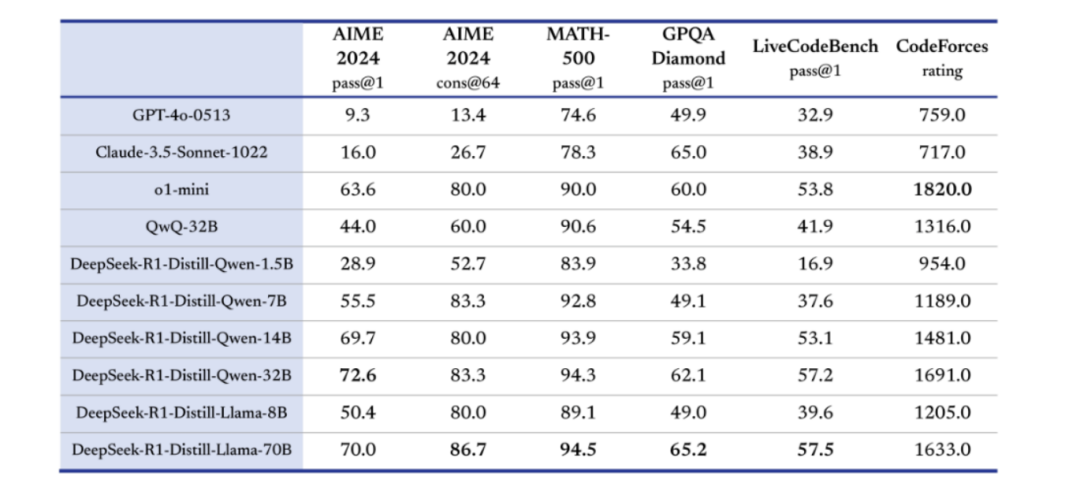

DeepSeek-R1-Distill-Qwen-1.5B:在AIME 2024测试中超越了GPT-4o-0513等非推理模型。

DeepSeek-R1-Distill-Qwen-7B:在所有评估指标上均超过了QwQ-32B-Preview。

DeepSeek-R1-Distill-Qwen-32B 和 DeepSeek-R1-Distill-Llama-70B:在大多数基准测试中显著超过o1-mini。

这些结果充分展示了蒸馏技术的有效性,以及DeepSeek R1强大的推理能力和泛化能力。

1、使用API

DeepSeek-R1提供了API服务,用户可以通过以下步骤获取API和密钥;以下是一个使用DeepSeek-R1 API进行多轮对话的代码样例:

from openai import OpenAI# 初始化客户端client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")# 第一轮对话messages = [{"role": "user", "content": "9.11 and 9.8, which is greater?"}]response = client.chat.completions.create(model="deepseek-reasoner",messages=messages)# 获取推理内容和回复内容reasoning_content = response.choices[0].message.reasoning_contentcontent = response.choices[0].message.content# 打印推理内容和回复内容print("Reasoning Content:", reasoning_content)print("Content:", content)# 第二轮对话messages.append({'role': 'assistant', 'content': content})messages.append({'role': 'user', 'content': "How many Rs are there in the word 'strawberry'?"})response = client.chat.completions.create(model="deepseek-reasoner",messages=messages)# 获取推理内容和回复内容reasoning_content = response.choices[0].message.reasoning_contentcontent = response.choices[0].message.content# 打印推理内容和回复内容print("Reasoning Content:", reasoning_content)print("Content:", content)

2.使用GitHub

你还可以在GitHub上探索更多资源和逐步指南,以无缝集成DeepSeek R1到你的应用中。访问GitHub Models博客文章:GitHub Models博客(https://github.com/deepseek-ai/DeepSeek-R1) 。根据GitHub上的信息,以下是相关资料和使用步骤:

模型下载:

-

DeepSeek-R1 Models:

DeepSeek-R1-Zero:671B参数,37B激活参数,128K上下文长度。下载链接:

https://huggingface.co/deepseek-ai/DeepSeek-R1-Zero

DeepSeek-R1:671B参数,37B激活参数,128K上下文长度。下载链接:

https://huggingface.co/deepseek-ai/DeepSeek-R1

-

DeepSeek-R1-Distill Models:

DeepSeek-R1-Distill-Qwen-1.5B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Qwen-14B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-8B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Llama-8B

DeepSeek-R1-Distill-Llama-70B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Llama-70B

-

DeepSeek-R1-Distill Models:

DeepSeek-R1-Distill模型可以像Qwen或Llama模型一样使用。例如,你可以使用vLLM轻松启动服务:

vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --tensor-parallel-size 2 --max-model-len 32768 --enforce-eager你也可以使用SGLang启动服务:

python3 -m sglang.launch_server --model deepseek-ai/DeepSeek-R1-Distill-Qwen-32B --trust-remote-code --tp 2七、未来展望:持续创新与拓展

DeepSeek R1的出现无疑为LLMs的发展带来了新的思路和方法,但研究团队并没有满足于此。他们在论文中指出了未来的研究方向,旨在进一步提升DeepSeek R1的性能和应用范围。未来的研究将集中在以下几个方面:

-

进一步优化推理能力:通过更先进的强化学习算法和更大的数据集,进一步提升模型的推理能力。

-

多模态推理:探索将推理能力扩展到多模态任务,如图像和文本的联合推理。

-

实时推理:优化模型的推理速度,支持实时推理任务,如在线对话系统和实时内容生成。

DeepSeek R1的发布不仅展示了其在推理能力上的卓越表现,还通过开源和API服务,为全球开发者和企业提供了强大的工具,推动AI技术的创新与普及。随着技术的不断发展,DeepSeek R1有望在更多领域发挥重要作用,为AI技术的发展带来新的突破。

(文:小兵的AI视界)