今天是2025年02月07日,星期五,大年初十,北京,天气晴,降温的厉害。

我们今天来看看老刘说NLP技术社区第27讲线上交流以及昨日发生的一些有趣的事儿。

专题化,体系化,会有更多深度思考。大家一起加油。

一、老刘说NLP技术社区第27讲线上交流

最近Deepseek-R1受到广泛关注,开工这几天,大家大多数算法从业者都被其裹挟,开启部署以及场景脑洞等热潮,这其实引申出了许多误区。而加之这段时间的内容特别多,也特别乱,苦的是一线落地研发人员,感觉已经偏离了其技术本身的东西,所以,社区想着说,还是从技术根本逻辑出发,来看看里面的一些东西,以正视听。

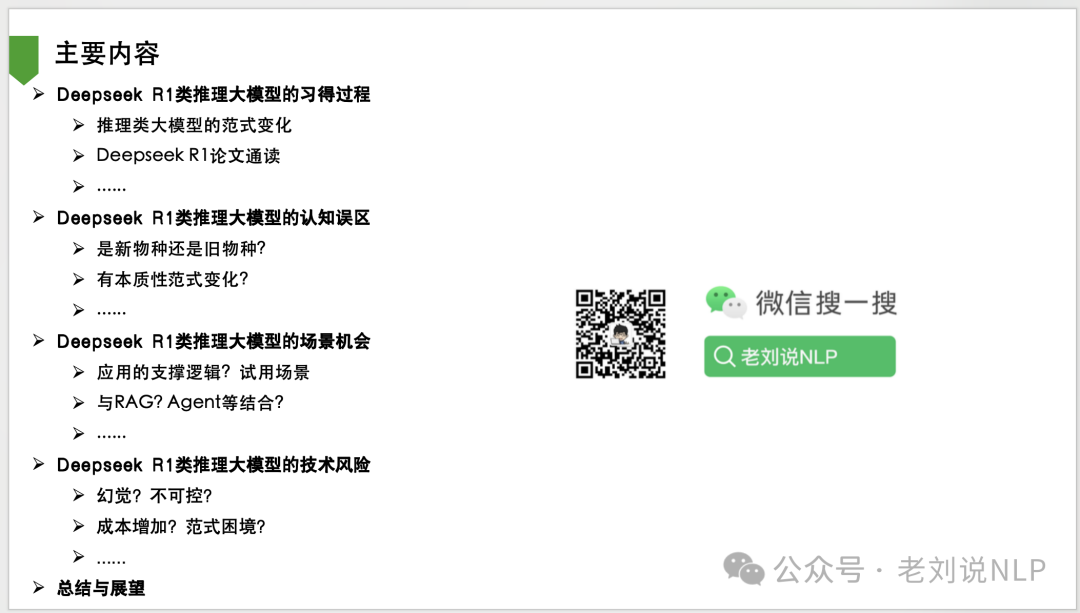

因此,社区觉得,这个时间不能等了,还是需要尽快清理一下,所以,进行社区2025年社区第一讲,同时也是老刘说NLP技术社区第37讲,题目定为 《Deepseek R1类推理大模型的习得过程、认知误区、场景机会及技术风险》,分享针对社区成员进行,感兴趣的可以加入,加入方式见文末。

围绕这个四个点,我们首先来看看,Deepseek R1类推理大模型的习得过程,包括推理类大模型的范式变化、Deepseek R1论文通读等;

然后看看Deepseek R1类推理大模型的认知误区,现在这个的确信息很混乱,是新物种还是旧物种?有本质性范式变化?跟之前的模型有什么区别,这个需要了解。

技术本身,其实与我们大多数人无关,我们更多的是关注,其好不好用,能不能解决问题,所以还是要回到落地问题。所以,从其基本逻辑出发,我们可以看看Deepseek R1类推理大模型的场景机会,其作为一个多了一个think形式化过程以及推理能力略强的模型,其应用的支撑逻辑?适用场景有哪些,与2024年的RAG、Agent等又有哪些潜在的结合机会?

当然,机会是机会,机会与风险并存,其也必然存在着一些落地风险,如这几天所说的推理大模型普遍存在的幻觉问题,其推理延迟带来的时间成本问题,以及带来的逻辑诡辩陷阱,这其实都是加剧了一些落地风险。

我们以纯技术的角度来看待一个事物,总会更平静、更客观,并且能够更长期主义,我们需要有这种木桶原则,方能走的更远。

二、简单看昨日的一些有趣的事儿

我们再看相关进展,先说prompt的这个问题,DeepSeek-R1对Prompt非常敏感。few-shot提示会持续降低其性能。这里建议用户直接描述问题并指定输出格式(采用zero-shot,不要加示例),以获得最佳结果。但这是R1的问题,得改,所以可以等待R2 等后续的工作。但现在很多人说不需要提示词,这个是很难让人信服的。

另外,说到关于推理大模型的幻觉。Vectara 的机器学习团队对 DeepSeek 系列的两款模型进行了深入的幻觉测试,结果显示,DeepSeek-R1的幻觉率高达14.3%,显著高于其前身 DeepSeek-V3的3.9%。这表明,在增强推理的过程中,DeepSeek-R1产生了更多不准确或与原始信息不一致的内容。推理增强模型可能会比普通的大语言模型更容易产生幻觉。

这一现象在DeepSeek系列与其他推理增强模型的比较中表现得尤为明显。以 GPT 系列为例,推理增强的 GPT-o1与普通版 GPT-4o 之间的幻觉率差异,也验证了这一推测。https://www.vectara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3。所以,不要想着用deepseek的思考就能省事;

当然,这种结论,其实都是相对的,而不是绝对的,这取决于大模型评估的方式和数据集。think过程,在具体业务场景,可能自相矛盾逻辑混乱,评测集只看answer,这些都是风险。

此外,昨日,Gemini 2.0系列全新发布三款模型:Flash、Pro和Flash-Lite,全部进入大模型竞技场前十;Gemini 2.0 Pro成为谷歌最强模型,具备200万tokens上下文窗口,在13项评测中获11项第一;Gemini 2.0 Flash-Lite针对成本优化,具备100万tokens长文本能力。

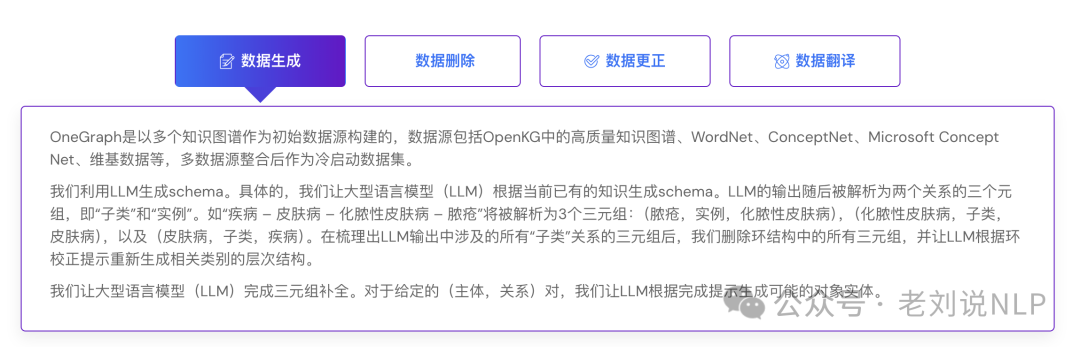

另外,关于OneGraph,http://onegraph.openkg.cn/,里面提到的知识图谱构建的几个大模型流程,感兴趣的可以留意下;

(文:老刘说NLP)