项目简介

一款能够捕捉实时会议音频、实时转录并生成摘要的人工智能会议助手,同时确保用户隐私。非常适合希望专注于讨论同时自动捕捉和组织会议内容,无需外部服务器或复杂基础设施的团队。

View full Demo Video

查看完整演示视频

为什么?

尽管有许多会议转录工具可用,此方案通过提供以下特点脱颖而出:

-

隐私优先:所有处理都在您的设备上本地进行

-

成本低廉:使用开源 AI 模型而非昂贵的 API

-

灵活:离线工作,支持多个会议平台

-

可定制:自托管并修改以满足您的特定需求

-

智能:内置知识图谱,实现跨会议的语义搜索

功能

✅ 现代响应式用户界面,实时更新

✅ 实时音频捕获(麦克风+系统音频)

✅ 使用 Whisper.cpp 进行实时转录 ✅ 说话人分离

✅ 本地处理以保护隐私

✅ 将应用打包为 Mac Os

🚧 导出为 Markdown/PDF

注意:我们有一个基于 Rust 的实现,该实现探索了更好的性能和本地集成。它目前实现了:

✅ 从麦克风和系统音频实时捕获音频

✅ 使用本地运行的 Whisper 进行实时转录

✅ 说话人分割

✅ 富文本编辑器用于笔记

我们目前正在从事:

✅ 导出为 Markdown/PDF

✅ 导出为 HTML

LLM 集成

后端通过统一界面支持多个LLM提供商。当前实现包括:

支持提供商

-

Anthropic(Claude 模型)

-

Groq(Llama3.2 90 B,Deepseek)

-

Ollama (本地模型)

配置

创建包含您的 API 密钥的 .env 文件:

# Required for AnthropicANTHROPIC_API_KEY=your_key_here# Required for GroqGROQ_API_KEY=your_key_here

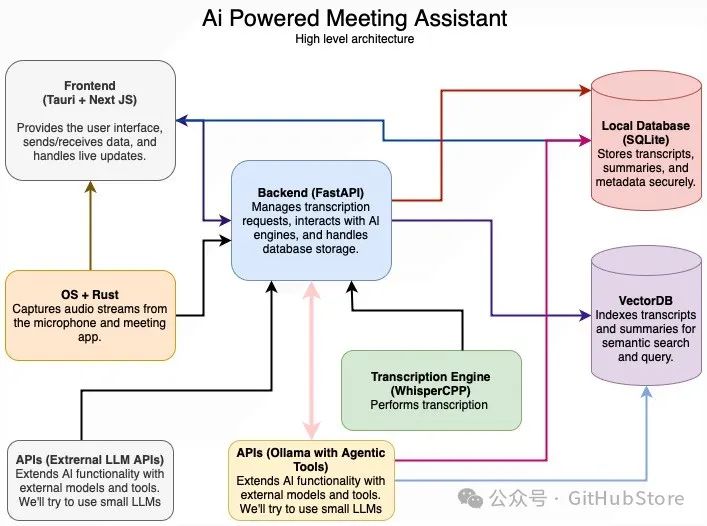

系统架构

核心组件

-

音频捕获服务

-

实时麦克风/系统音频捕获

-

音频预处理管道

-

使用 Rust (实验性) 和 Python 构建

-

转录引擎

-

Whisper.cpp 用于本地转录

-

支持多种模型大小(微型->大型)

-

GPU 加速处理

-

LLM 编排器

-

统一的多服务商接口

-

自动回退处理

-

分块处理,重叠

-

模型配置:

-

数据服务

-

ChromaDB:转录嵌入的向量存储

-

SQLite:进程跟踪和元数据存储

-

API Layer

-

POST /upload

-

POST /process

-

GET /summary/{id}

-

DELETE /summary/{id}

-

FastAPI 端点

部署架构

-

前端:Tauri 应用 + Next.js(打包可执行文件)

-

后端:Python FastAPI:

-

转录工作者

-

LLM 推理

先决条件

-

Node.js 18+

-

Python 3.10+

-

FFmpeg

-

Rust 1.65+(用于实验性功能)

设置说明

-

前端设置

运行打包版本

前往发布页面下载最新版本。

解压文件并运行可执行文件。

提供音频捕获和麦克风访问的必要权限(仅需要屏幕捕获权限)。

开发运行

# Navigate to frontend directorycd frontend# Give execute permissions to clean_build.shchmod +x clean_build.sh# run clean_build.sh./clean_build.sh

2. 后端设置

# Create and activate virtual environmentpython -m venv venvsource venv/bin/activate # Windows: .\venv\Scripts\activate# Navigate to backend directorycd backend# Install dependenciespip install -r requirements.txt# Start backend servers./clean_start_backend.sh

项目链接

https://github.com/Zackriya-Solutions/meeting-minutes

扫码加入技术交流群,备注「开发语言-城市-昵称」

(文:GitHubStore)