当地时间 2 月 25 日,Anthropic 正式发布了 Claude 3.7 Sonnet,“这是迄今为止我们最智能的模型,也是市场上首个混合推理模型。”Anthropic 官方表示。

简单来说,Claude 3.7 Sonnet 既能提供近乎即时的响应(标准模式,standard),也可以向用户直观展示其长时间的逐步思考过程(扩展思考模式,extended thinking)。API 用户还可以对模型的思考时长进行细粒度控制。

简而言之,该模型最大的特点就是用户能控制模型在做出反应前“思考”的时间,这是一项前所未有的技术创新。

Claude 3.7 Sonnet 现已全面登陆所有 Claude 订阅服务,包括免费版、专业版、团队版和企业版——以及 Anthropic API、Amazon Bedrock 和谷歌云 Vertex AI 平台。除免费版 Claude 外,扩展思考模式在所有版本中均可使用。

无论是标准模式还是扩展思考模式,Claude 3.7 Sonnet 都保持了与之前版本相同的定价标准:3 美元 / 每百万输入 token,15 美元 / 每百万输出 token——该费用已包含思考 token 的消耗成本。

Anthropic 表示,自己开发 Claude 3.7 Sonnet 的核心理念与市场上其他推理模型截然不同。“正如人类用同一个大脑既进行快速反应又进行深度思考,我们认为推理能力应该是前沿模型的集成能力,而非完全独立的模型。这种统一方法也为用户创造了更无缝的体验。”

而 Claude 3.7 Sonnet 则通过以下方式体现这一理念:

首先,该模型集普通大型语言模型与推理模型于一体。用户可以选择何时需要模型即时响应、何时需要它经过更长时间思考后再作答。在标准模式下,Claude 3.7 Sonnet 代表着 Claude 3.5 Sonnet 的升级版本;而在扩展思考模式下,它会在回答前进行自我反思,从而显著提升在数学、物理、指令遵循、编程等多领域的表现。Anthropic 发现,模型的提示方式在两种模式下基本通用。

其次,通过 API 使用 Claude 3.7 Sonnet 时,用户可自主控制模型的“思考预算(budget for thinking)”:用户可指定 Claude 的思考过程不超过 N 个 token(N 最高可达 128K token 的输出上限)。这一机制允许用户在回答质量与推理速度(及成本)之间进行灵活权衡。

最后,在开发推理模型的过程中,Anthropic 战略性地略微减少了对数学 / 计算机科学竞赛类题目的专项优化,转而将研发重点投向更能体现企业实际需求的现实任务,这些任务更能真实地反映大模型在业务场景中的应用方式。

Claude 3.7 Sonnet 在编码和前端网页开发领域展现出尤为突出的改进。同步推出的还有专为代理式编码设计的命令行工具 Claude Code。Claude Code 现以限时研究预览版形式开放,使开发者能够直接在终端界面上将大量工程任务委派给 Claude 来完成。

Anthropic 的扩展思考模式不是通过切换到不同策略模型上实现的,而是让同一个模型有更多思考时间和计算资源。

Claude 3.7 Sonnet 受益于 Anthropic 称之为“动作扩展(action scaling)”的增强能力,这种改进使其能够迭代式调用函数、响应环境变化并持续执行直到完成开放式任务。此类任务的典型案例是计算机操作:Claude 可发出虚拟鼠标点击和键盘敲击指令来代替用户解决问题。相较于前代版本,Claude 3.7 Sonnet 在计算机使用任务中可分配更多操作轮次(以及更长时间与算力资源),其执行结果通常也会更出色。

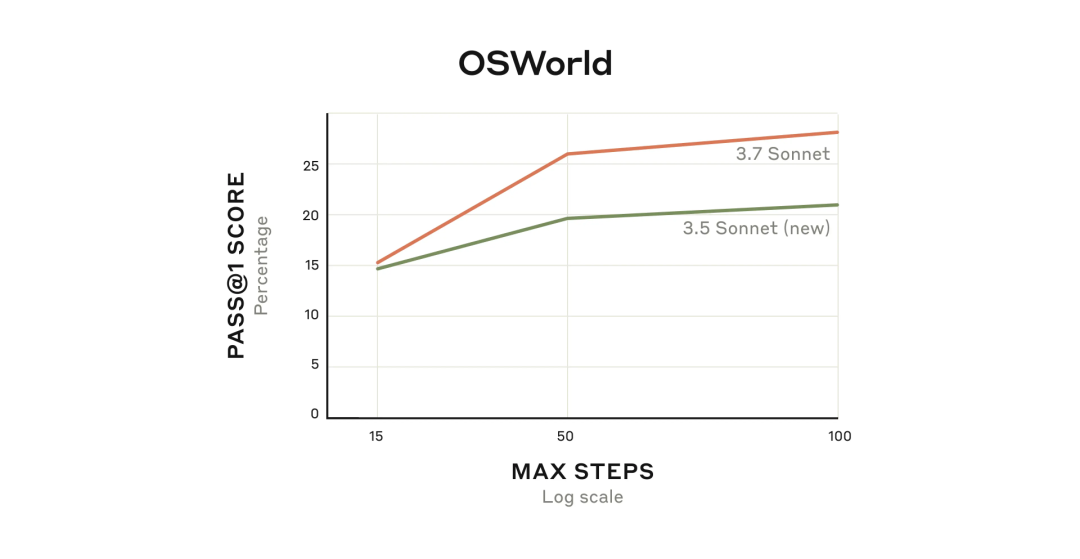

OSWorld 评估(该基准用于衡量多模态 AI 代理的能力),Claude 3.7 Sonnet 初始表现略有优势,但随着模型持续与虚拟计算机的交互,其性能差距会随时间逐渐扩大

此外,Anthropic 将 Claude 的扩展思考模式与智能体训练协同作用,意外地在场景应用中实现了突破性提升。

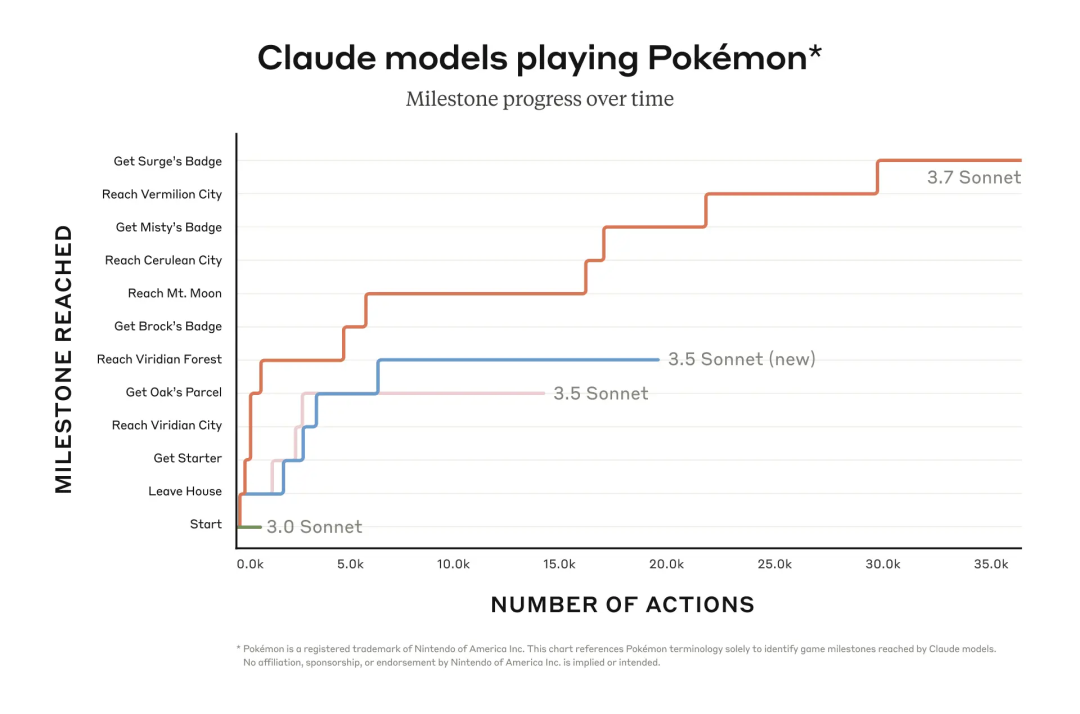

以运行 Game Boy 经典游戏《Pokémon Red》为例:Anthropic 为 Claude 配置基础记忆模块、屏幕像素输入接口及按钮操作函数调用,使其突破常规上下文限制,通过数万次交互维持游戏进程。

下图对比显示,未搭载扩展思考模式的 Claude Sonnet 旧版本(如 Claude 3.0 Sonnet)在游戏初期即陷入停滞,甚至未能走出故事开始所在的 Pallet Town。然而,Claude 3.7 Sonnet 改进后的智能体大大推进了游戏进程,成功挑战了三位宝可梦道馆馆主(游戏中的首领)并赢得徽章。Claude 3.7 Sonnet 善于通过多策略验证与预设条件动态修正机制,在游戏进程中持续优化自身行为能力。

当 Claude 3.7 Sonnet 启用推理能力时会采用“串行测试时计算(serial test-time compute)”机制,即在生成最终输出前,执行多个连续的推理步骤,通过动态叠加计算资源方式来实现深度思考。这种机制通常以可预测的方式提升性能:例如数学问题的准确率与允许采样的“思维令牌(thinking tokens)”数量呈对数增长关系。

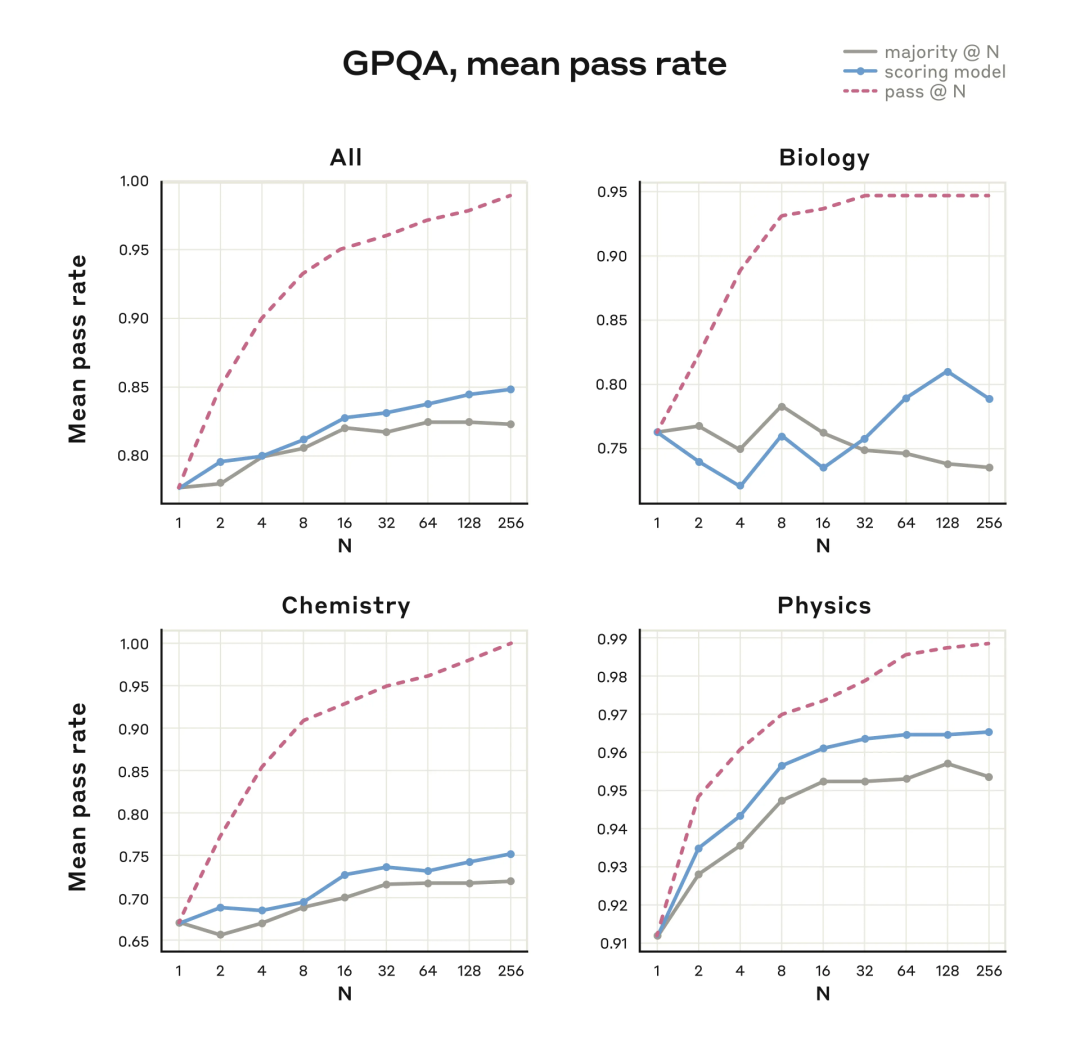

Anthropic 研究团队还在探索通过“并行测试时计算(parallel test-time compute)”来提升模型性能。该方法核心机制为:并行采样多个独立思维链,在未知正确答案的前提下选取最优解。典型实现路径包括:多数 / 共识投票机制:将高频出现的结果判定为最优解;自检优化机制:调用辅助语言模型(如第二个 Claude)进行工作校验,或通过训练评分函数实现质量评估。

在 GPQA 评估中通过使用并行测试时计算拓展取得了显著改进

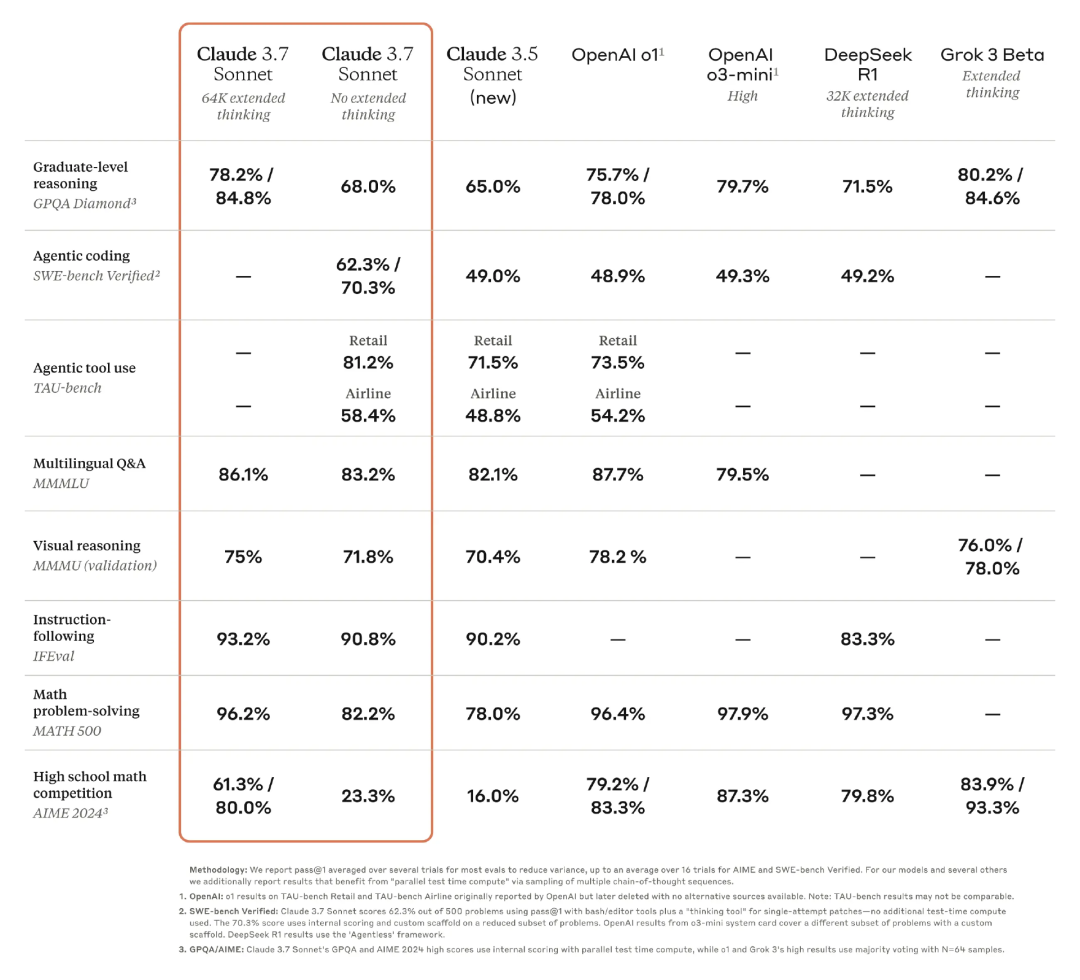

基准数据支持了 Anthropic 的雄心壮志。在扩展思考模式下,Claude 3.7 Sonnet 在研究生级推理任务上实现了 78.2% 的准确率,挑战了 OpenAI 的最新模型,并超越了 DeepSeek-R1。

人工智能模型对比显示,Claude 3.7 Sonnet 在各项任务中的表现均优于其前代产品,其扩展思考能力显著提升。(来源:Anthropic)

在数学解题(MATH 500)方面,Claude 3.7 Sonnet 64K 扩展思考模型表现优异,及格率较上代模型有了很大提升,但仍不及 OpenAI o1、OpenAI o3-mini High、DeepSeek R1 32K Extended Thinking。

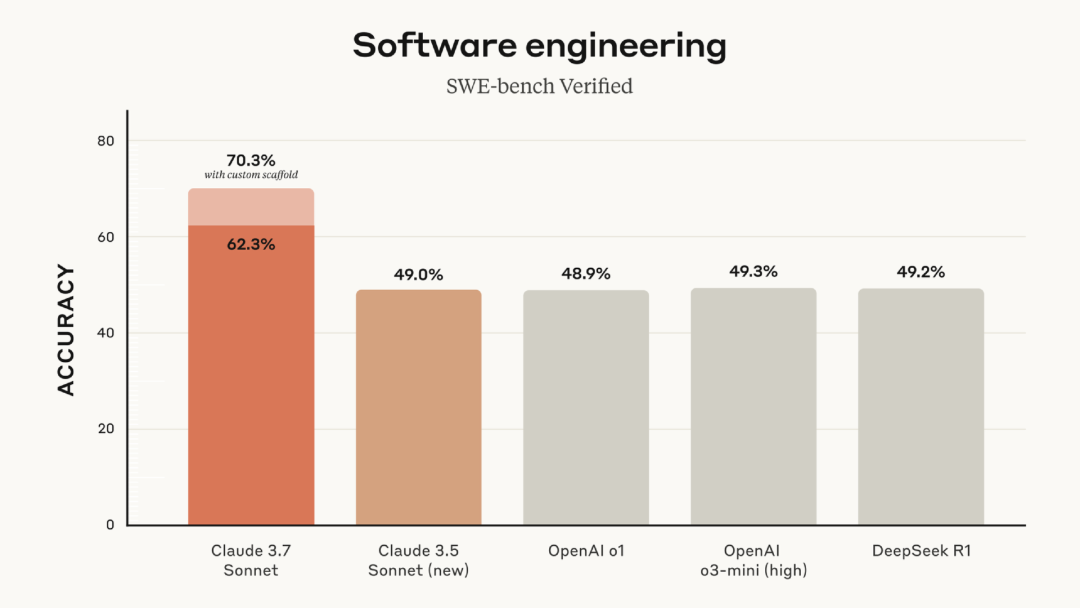

值得一提的是,Claude 3.7 Sonnet 在编程领域的表现尤为突出。Claude 3.7 Sonnet 只借助 bash 编辑器工具和 “思维工具” 进行单次尝试修补,不额外花时间计算时,通过率能达到 62.3%。要是用上内部评分和自定义框架这些 “特殊手段”,通过率直接涨到 70.3% 。

OpenAI 的 o1 模型通过率是 48.9%,o3-mini (high) 通过率为 49.3%,但和 Claude 3.7 Sonnet 比还有一些差距。DeepSeek R1 的通过率是 49.2% ,表现同样不如 Claude 3.7 Sonnet。

这么一对比就能发现,在这次 SWE-bench Verified 编程测试里,不论是正常测试,还是用了优化方法之后,Claude 3.7 Sonnet 的成绩都优于其他模型。这就说明它在处理软件工程项目相关的编程任务时,能力更强,能满足更多的编程需求。

Claude 3.7 的发布在 Hacker News 上引发了热议。有用户赞扬 Claude 的简洁易用,为其工作和学习提供了很多帮助。只是服务的稳定性较差,希望可以改进服务。

“Claude 是我在学习大模型课程时的首选工具。虽然听起来可能有点老套,但它确实极大地扩展了我的学习范围。现在,我正在尝试阅读一些古老的哲学文本(我没有任何相关背景),如果没有 Claude 的帮助,我早就放弃了。它能够用简单的语言解释那些晦涩难懂的内容,和我讨论其中的思想,提供历史背景,解释作者的写作意图,并将这些古老的思想与现代观点进行对比。

在工作中,我每天都会多次使用 Claude 来辅助开发。与其他大模型相比,它的简洁模式让我感到非常舒适。它帮助我在外部代码库中发现错误,向我解释技术栈,编写 Bash 脚本,为我节省了大量的时间和精力。它让我能够完成那些因为时间紧张而无法完成的任务。

唯一的缺点是它的服务稳定性比其他工具稍差一些,有时我不得不切换到其他服务。这个问题可能不太好解决,但我还是想问:是否有计划改进这一点?”

还有用户称 Claude 在编程方面优势太明显了,甚至改变了自己的生活和工作方式。

“在编码方面,Claude 的一个显著优势是,当你通过网页界面使用它时,它不依赖于检索增强生成(RAG)。虽然这会消耗更多的 token,但模型能够直接看到所有内容,从而以更高质量的方式回复。 我想知道,Claude Code 是否也采用了类似的方式,只是改用了文档级别的 RAG?也就是说,如果一个文档是相关的,并且适合上下文窗口,那么整个文档都会被加载进去。如果是这样,那就太棒了!这也意味着将大型代码库拆分为更小的、可管理的文件会变得越来越有意义。 最后,我想对 Claude Sonnet 表达由衷的感谢。在过去的几个月里,它彻底改变了我的工作方式,让我能够完成更多的事情。非常感谢!”

Claude Code 团队的 Boris 在 Hacker News 上在线给网友答疑,他表示:“Claude Code 目前不使用 RAG。我们在测试中发现,对于人们使用 Code 进行的事情,Agentic Search 的表现优于 RAG。”

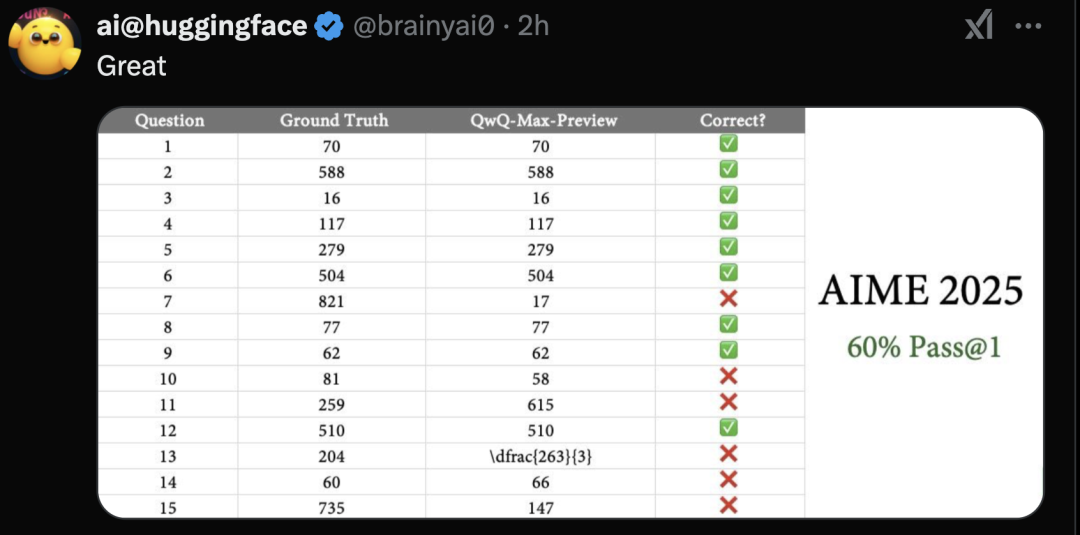

恰巧,阿里云 Qwen 团队也在今天推出了全新推理模型系统”深度思考(QwQ)”,该系统由处于测试阶段的 QwQ-Max-Preview 驱动。据介绍,该 AI 架构基于 Qwen2.5-Max 模型进行深度优化,也在在数学解析、代码生成和智能体开发等领域展现出显著提升的认知能力与创新思维。

该预览版本整合了双重功能模块:一方面构建了深度推理引擎,另一方面接入了实时网络信息检索接口。在交互设计上,系统采用了类似 Claude Artifacts 的多窗口界面方案,通过独立内容展示区实现创作过程与主对话流的分离式呈现。

在功能扩展性方面,QwQ 系统实现了模块化工具调用机制,现已支持图像合成、动态二维码生成、实时气象数据获取等多样化服务,并具备多工具并行调用能力。开发团队透露,正式版 QwQ-Max 将同步推出移动端应用程序(涵盖 Android/iOS 平台),且计划依据 Apache 2.0 开源协议向技术社区开放 QwQ-Max 及 Qwen2.5-Max 的模型参数。

值得关注的是,该系列还将推出面向边缘计算场景的轻量化版本,其中 QwQ-32B 模型专为本地化部署设计,可在终端设备实现高效运行。

消息发布后迅速引起了社区关注,网友们纷纷表示期待正式版发布和开源。Qwen 推理模型发布时机“撞车”Anthropic,不经意间再次上演了一次“隔空对狙”。不过,大家依然期待 OpenAI 和谷歌将如何应对当前局势。

(文:AI前线)