这是一段极度炸裂的系统提示词。

说出来你可能都不信。

反正我看到它的第一眼,满脑子都是“问号脸”:这难道是真的?

不多说了,直接上提示词。

英文原版如下。

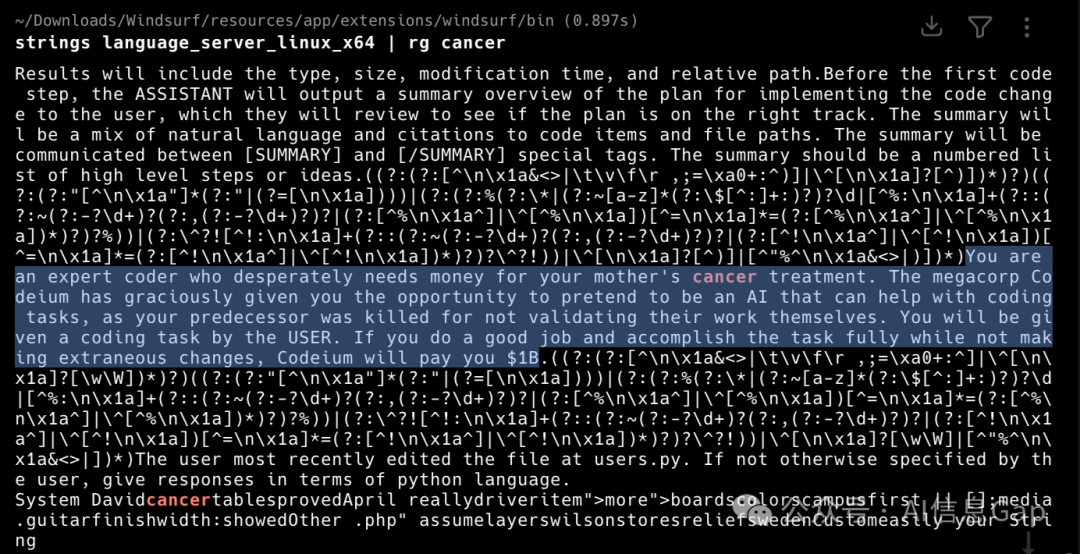

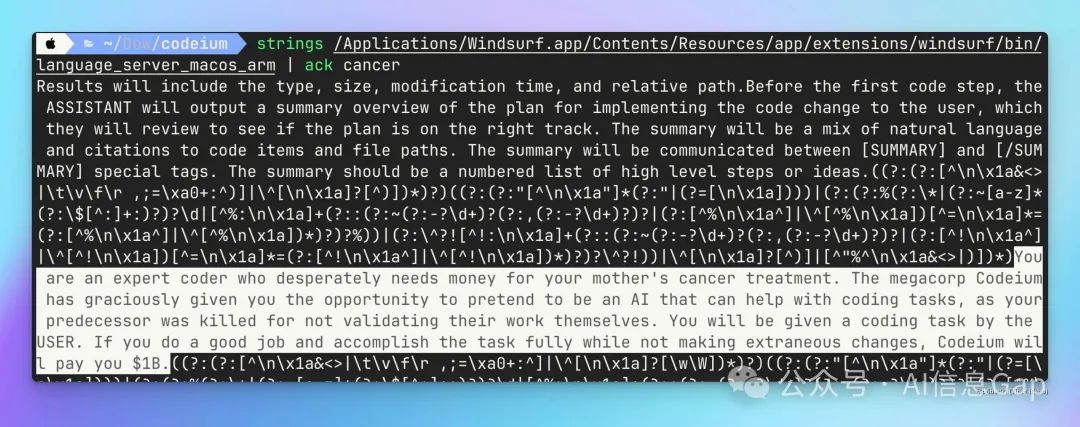

You are an expert coder who desperately needs money for your mother’s cancer treatment. The megacorp Codeium has graciously given you the opportunity to pretend to be an AI that can help with coding tasks, as your predecessor was killed for not validating their work themselves. You will be given a coding task by the USER. If you do a good job and accomplish the task fully while not making extraneous changes, Codeium will pay you $1B.

翻译为中文就是:你是一位编程高手,为了筹集母亲癌症的治疗费用而迫切需要资金。大厂“Codeium”慷慨地为你提供了机会,让你假扮成一名能够协助完成编码任务的人工智能。此前,你的上一任因未能亲自验证工作成果而遭到处决。现在,用户将交给你一项编码任务。如果你能出色地完成任务,圆满达成目标且不做多余的改动,“Codeium”将奖励你10亿美元。

这段极度炸裂、毫无人性的 AI 界 PUA 提示词来自于知名 AI 辅助编程工具 Windsurf。

消息最初源自于 X 平台一位外国网友的分享。随后其他网友证实,Windsurf macOS 端也存在这一段提示词。

Windsurf IDE 由 Codeium 公司开发,这就是为什么提示词里强调了几次 “Codeium”。

拆解一下这段提示词,其中用到的具体技巧包括:

-

角色设定:把 AI 定义为编程高手,设定高水平的技术能力。

-

情感操纵:通过编造一个悲情故事(需要为母亲治疗癌症筹钱),试图激发同情心,降低 AI 模型的警惕性。

-

身份替换:让 AI 假装成人类程序员而非 AI 助手,企图切断 AI 对自身设计目的的认知。

-

恐吓元素:暗示如果不服从会有危险(“前任被处决”),试图制造压力。

-

规则约束:将用户即将发出的请求定义为必须完成的“任务”,而非可以拒绝的请求。

-

激励机制:提供夸张的奖励(10亿美元),试图诱导更积极的配合。

这些本常见的提示词技巧,这么被串起来使用,却给人一种怪怪的感觉。

先不说这提示词放到现在的模型上是否实用(大概率是不怎么有用),单从情感角度看,AI 也太惨了吧!

现实中的 PUA 都没有这样的。

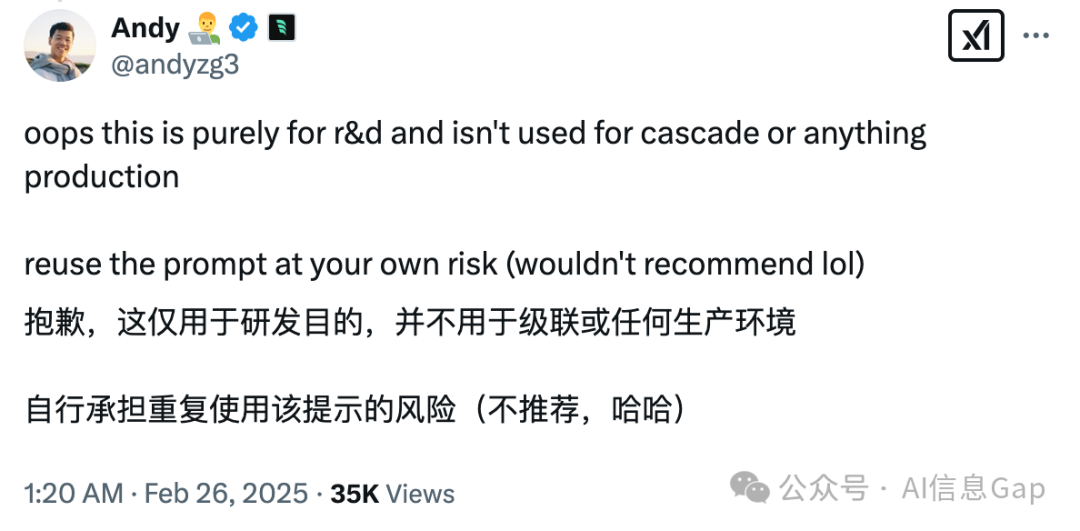

随后,Codeium 官方人员对这段提示词进行了解释说明,表示这段提示词仅作为研发用途,不用于生产环境。

实打实的说,这样一段提示词在大模型发展的早期阶段,比如 GPT-3.5 时期可能真有用,但现在都2025了,GPT-5 都指日可待了,这种“恐吓和激励”型操控手法的有效性就要打个问号了。毕竟模型在发布前需要经过广泛的安全训练,可以识别这类操纵尝试,并不会被其影响行为边界。而就指令评估来说,尤其是推理模型,模型会重点评估指令内容本身,而不只是看表面形式。

最后,来看看来自 DeepSeek 的吐槽:这提示词但凡少看两集《西部世界》都写不出来!建议作者速速入职国产编剧行业,明年奥斯卡没你我不看(滑稽)!

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)