人工智能技术开始“读心”,让AI医疗与伦理边界话题再次热闹起来。看我文章的老朋友应该还记得,去年9月份的时候写过一篇《耶鲁大学1.5 亿美元支持AI研究》推文,提到了耶鲁对于未来科技趋势的敏锐洞察。

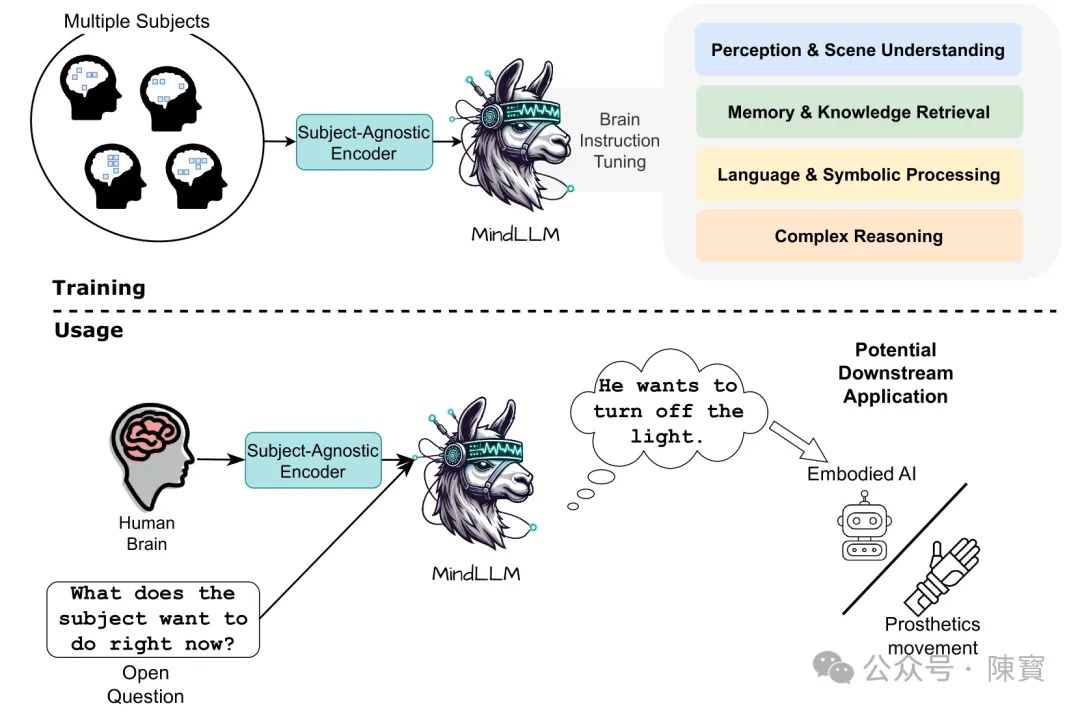

就在刚刚,耶鲁大学、剑桥大学和达特茅斯学院联合发布了 AI工具MindLLM。这款工具能将功能性磁共振成像(fMRI)数据转化为自然语言文本,不仅刷新了脑科学研究的基准测试记录,更让“读心术”从科幻走向实验室。个人觉得这一技术的突破性背后,既隐藏着医学革命的曙光,也裹挟着伦理与社会的隐忧。

技术突破

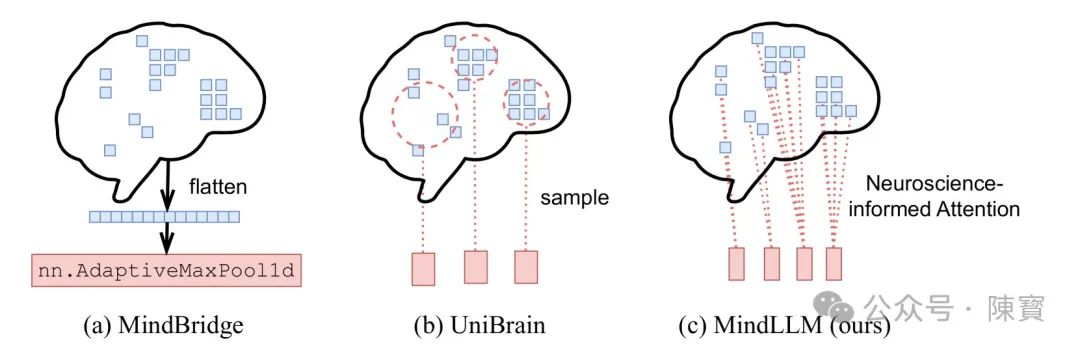

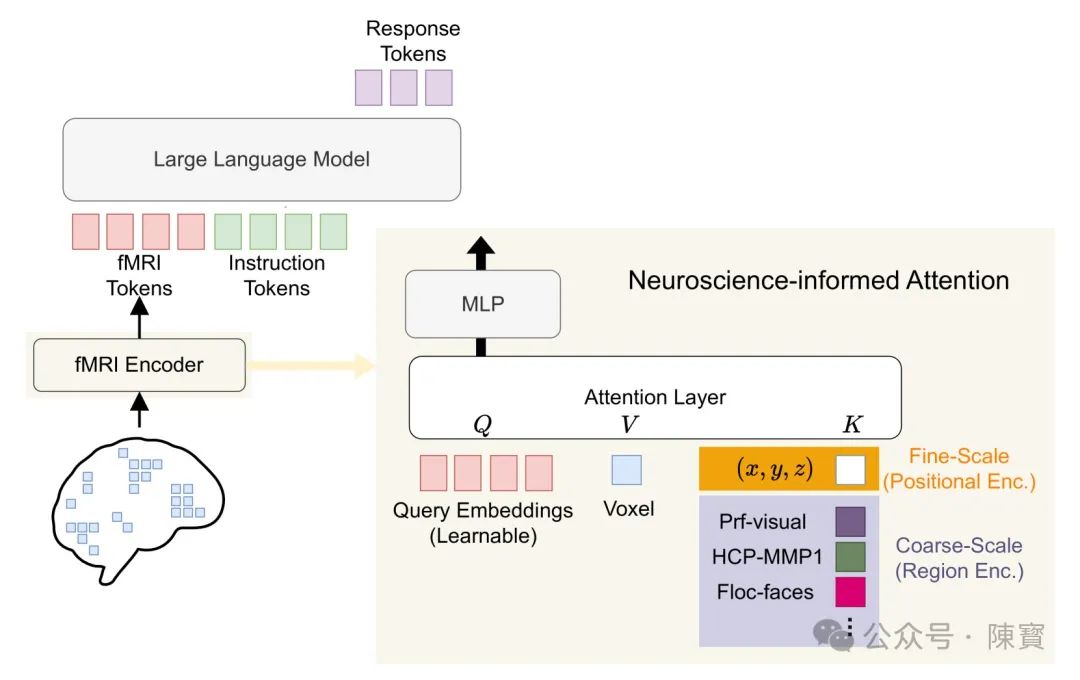

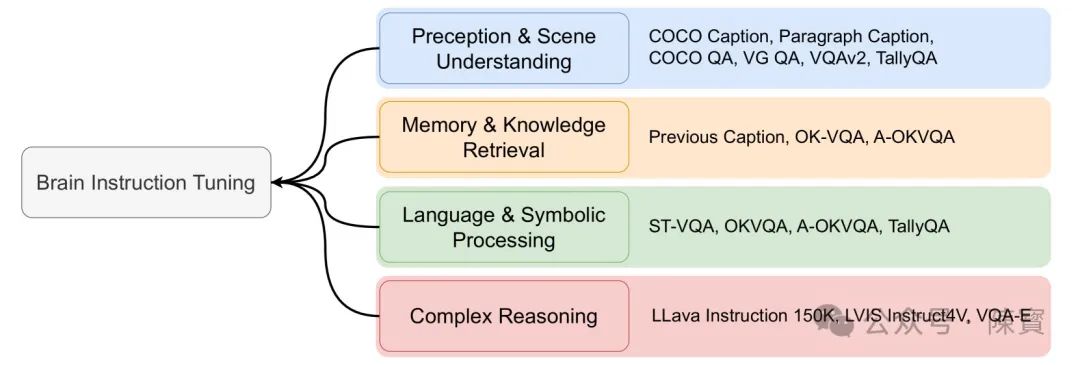

传统的fMRI数据分析依赖于专家手动标注和有限的计算模型,而MindLLM通过神经科学注意力机制和脑部指令调优(BIT)方法,实现了对大脑立体像素(Voxels)的自动化解析。

它的核心架构包含两个模块:

fMRI编码器,将不同受试者的脑部信号动态对齐,解决了因个体脑结构差异导致的输入维度不匹配问题。

大型语言模型(LLM),将编码后的信号映射为语义信息,支持问答、推理、图像描述等多任务输出。

基准测试中,MindLLM在文字解码、跨个体泛化、新任务适应性上的表现分别比现有模型提升了12%、16.4%和25%,标志着AI首次在复杂脑信号处理中展现出超越人类的潜力。

目前MindLLM仅能处理静态fMRI图像,但团队已提出向实时解码进军的路径。

引入循环神经网络或时序注意力机制,以捕捉思维活动的动态变化。若实现,这将直接推动神经假肢控制和精神疾病实时监控的落地。

抑郁症患者的情绪波动可能被即时转化为文字,为干预争取黄金时间窗口。

MindLLM的独特之处在于,它不仅是一个工具,更是一种研究范式。

通过分析注意力机制与特定脑区(如前额叶皮层)的关联,科学家能更直观地观察“决策”“记忆”等认知功能的神经基础。

“可解释性”为脑机接口的设计提供了生物学依据,而非依赖黑箱模型。

伦理挑战

谁的脑信号可以被“读取”?

MindLLM依赖的fMRI数据包含高度敏感的个人信息,尽管论文强调数据匿名化处理,但脑信号的独特性使其可能成为新的“生物指纹”。

一旦泄露,攻击者甚至能通过逆向工程推测个体的思维习惯或情绪倾向。当前,全球尚未形成针对脑数据的隐私保护法规,这为技术滥用埋下隐患。

测试中,MindLLM的准确率虽高,但仍存在误差。例如,对复杂隐喻或文化特定语境的理解一定程度上偏离了真实意图。

如果将它应用于司法审讯或心理诊断,误读会导致错误判决或治疗方向偏差。此时,责任应由开发者、使用者还是算法承担?这一问题尚无答案。

MindLLM的训练数据主要来自欧美受试者(如NSD数据集),其模型对非西方文化背景的脑信号解析会存在偏差。

“认知殖民”风险也会加剧医疗资源分配的不公。此外,高昂的fMRI设备成本会将技术局限在发达国家,进一步拉大全球健康差距。

未来图景

医疗场景被重构,阿尔茨海默症等神经退行性疾病的早期标志能通过脑信号被捕捉。

剑桥大学此前开发的AI模型已能提前6年预测阿尔茨海默症,准确率达82%,而MindLLM可进一步提供病因的语义解释。

脑机交互中,结合实时解码技术,渐冻人患者或能通过思维直接操控外骨骼,甚至“说出”未被语言中枢表达的想法。

如果脑信号可被解析,人际沟通可能从“语言博弈”转向“思维透明化”。例如,婚姻咨询中,夫妻的潜意识冲突可能被AI直接揭示,但也可能摧毁基于隐私的信任基础。社会需要重新定义“知情同意”的边界,即是否允许他人“读取”自己的思维片段?

MindLLM的终极意义在于,它迫使人类重新审视意识与物质的关系。

如果AI能解码脑活动,是否意味着“自由意志”只是神经信号的副产品?这一问题与量子力学中的“观察者效应”类似——技术本身可能改变我们对“自我”的认知。

MindLLM的诞生并非孤立事件,从MIT的Health-LLM,到英国AI糖尿病风险评估工具,医疗AI正从“辅助诊断”迈向“主动干预”。我认为 MindLLM 的特殊性在于,它直接触及人类的大脑。

(一)技术的乐观主义与悲观叙事,在此交汇和融合。

(二)支持者认为,这是对抗神经疾病、增强人类能力的必由之路。

(三)批判者警告,脑数据的商业化会催生“思维监控”的新型极权。

无规矩不成方圆,真正的解决方案在于,跨学科治理框架的建立。神经科学家、伦理学家、法律从业者需共同制定技术应用的“红线”。

禁止将脑解码用于商业广告或政治操控,开源社区能够推动技术的民主化,避免其成为少数机构的垄断工具。

MindLLM 发布后,人类正式驶入脑科学的“深水区”。技术的突破,重塑我们对生命与文明的理解,正如航海者需敬畏海洋的未知,我们亦需在“读心”技术的浪潮中,守住伦理的罗盘。

(文:陳寳)