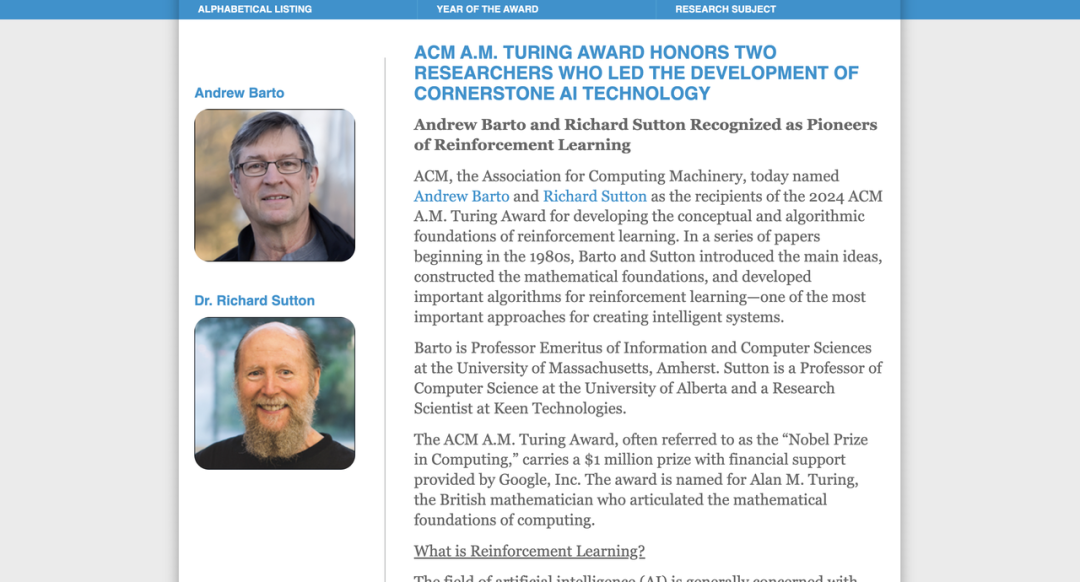

Barto 和 Sutton 的贡献不仅仅是一个过渡阶段的成果,而是一个仍在持续发展的领域。强化学习仍在不断进步,不仅推动计算机科学的发展,也为许多其他学科带来了无限可能。

因此,我们授予他们计算机领域最具影响力的奖项,实至名归。

他们开发的工具仍然是当前人工智能浪潮的核心支柱,推动了重大技术突破,吸引了大批年轻研究者,并驱动了数十亿美元的投资。强化学习的影响力还将持续扩展至未来。

Google 很自豪能够赞助 ACM A.M. 图灵奖,以表彰那些塑造了改变我们生活的技术的杰出个人。

https://amturing.acm.org/

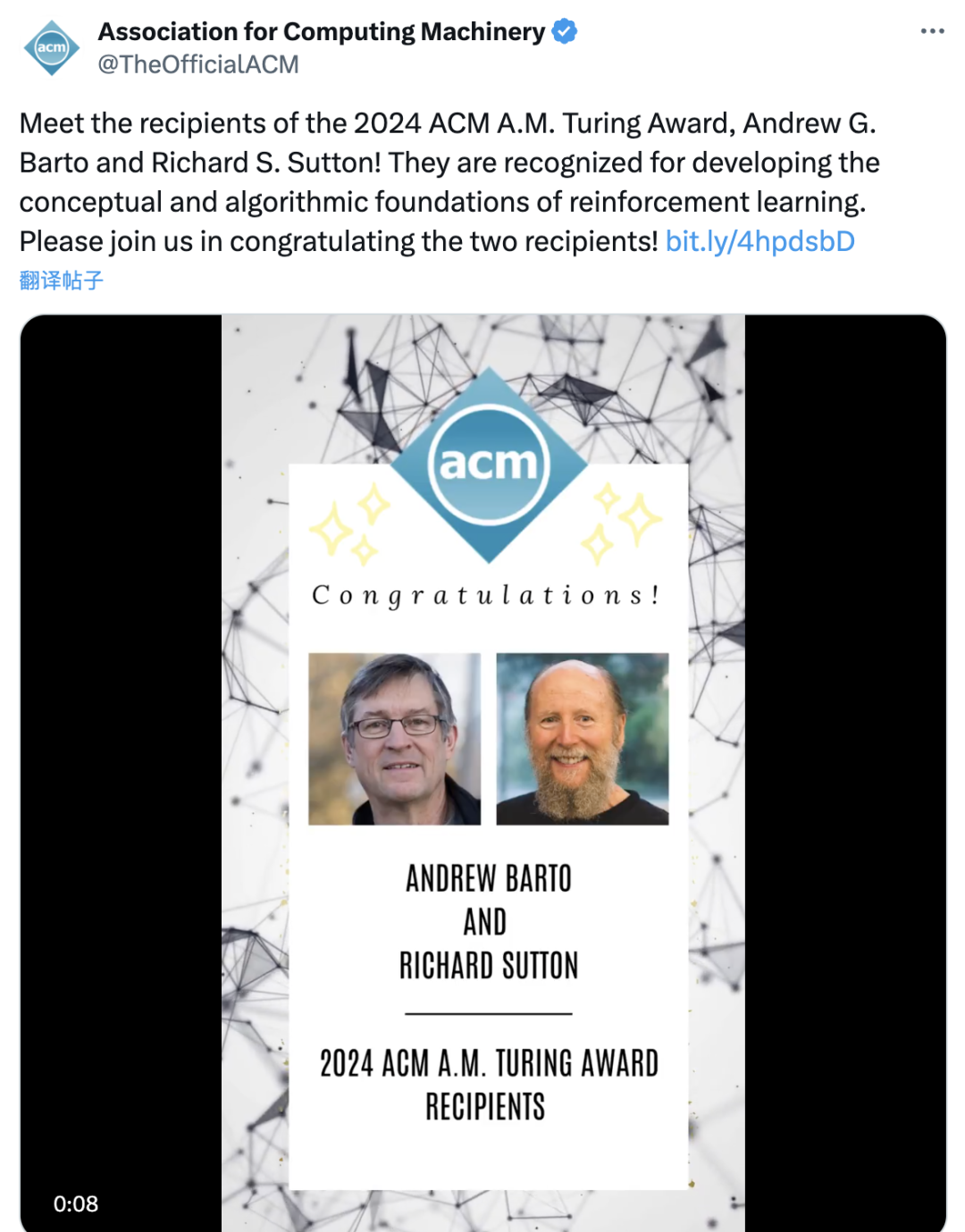

https://www.acm.org/media-center/2025/march/turing-award-2024

https://x.com/TheOfficialACM/status/1897225672935735579

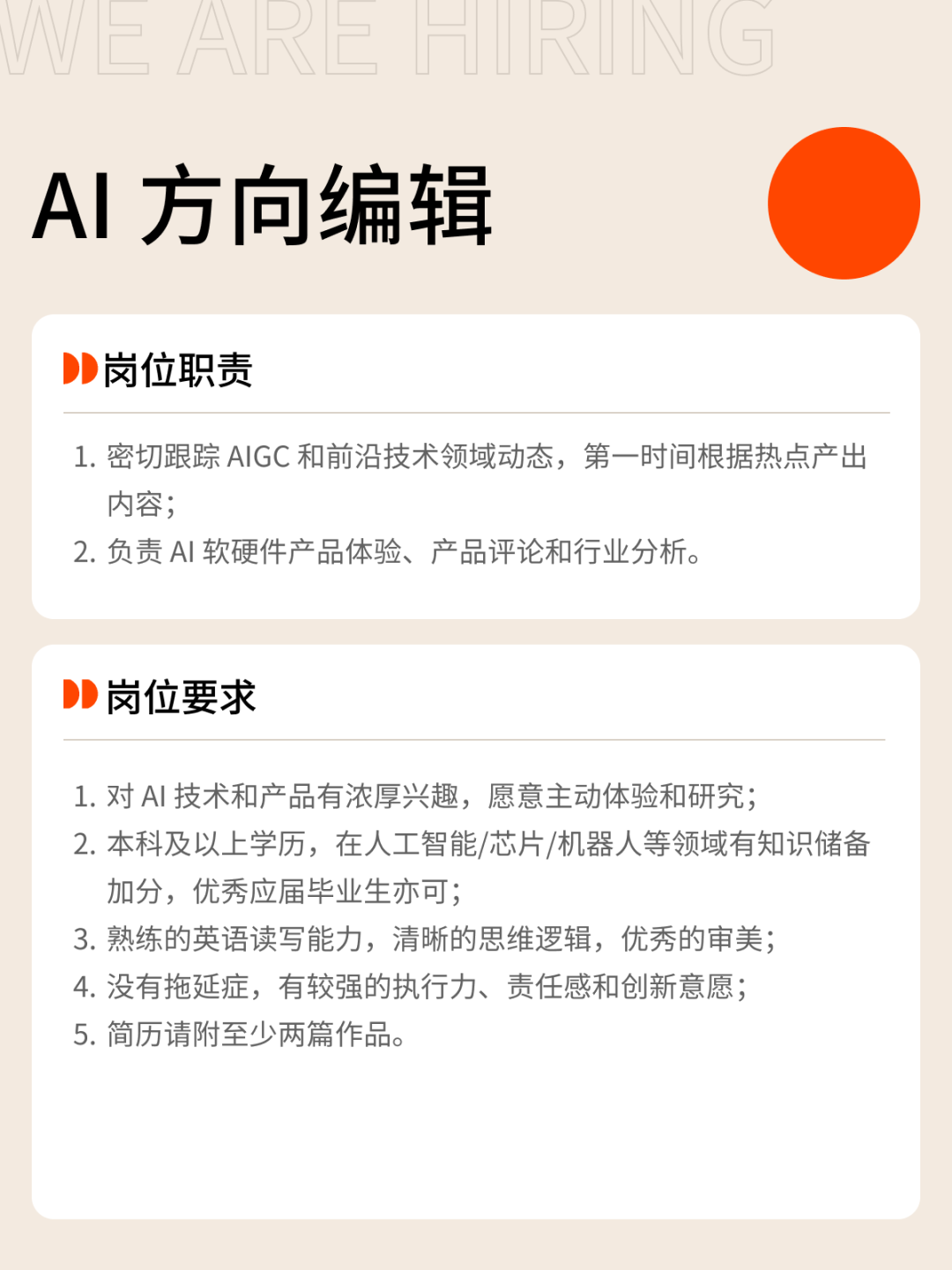

我们正在招募伙伴

hr@ifanr.com

「姓名+岗位名称」(请随简历附上项目/作品或相关链接)

(文:APPSO)