AI大模型的商业化进程正在重塑云计算行业的竞争逻辑。从2023年的“技术验证年(POC)”,到2024年的“规模生产年”,当企业级客户的需求从追逐单一模型的“极致性能”转向寻求性能、成本、安全与场景适配性的平衡,头部云厂商的战略分野已然清晰——亚马逊云科技于昨天凌晨在Amazon Bedrock平台推出全托管、无服务器的DeepSeek-R1模型,是首个提供DeepSeek-R1作为全托管、正式商用模型的海外云厂商,同时DeepSeek是首个登陆Amazon Bedrock的国产大模型。自今年1月底上线以来,已有数千客户通过Amazon Bedrock的自定义模型导入功能部署了DeepSeek-R1模型。

这一动作被视为对“多模型生态”竞争逻辑的强势加码。 而其他厂商则面临抉择:是孤注一掷押注“超级模型”闭环模式,还是构建开放生态?

IDC最新预测揭示:到2028年,80%用于生产级用例的基础模型将具备多模态AI功能。亚太区前1000强企业90%的大模型用例将转向专用小型模型(SLM)。这一转型的直接动因是企业对“性能过剩”的警惕——通过灵活调用模型组合,总拥有成本可下降37%*,印证了“精算时代”的核心逻辑:不为技术光环付费,只为业务价值买单。

(*来源:IDC FutureScape: Worldwide AI and Automation 2025 Predictions — Asia/Pacific (Excluding Japan) Implications)

01

资本竞赛与战略分野:云厂商的AI路线图

云计算巨头间的AI竞赛已演变为一场资本与技术双轨驱动的军备竞赛。在这场定义未来规则的暗战中,基础设施投入的规模差距与生态构建的逻辑差异为关键变量。

基础设施投入:规模决定护城河

| 厂商 | 2024年资本支出 | 2025年支出预测 |

| 亚马逊云科技 | 850亿美元 | 约1050亿美元(Q4推算值) |

| 微软 | 512亿美元 | 800亿美元(目标) |

| 谷歌(Alphabet) | 525亿美元 | 750亿美元 |

| 阿里云 | 100亿美元 | 未披露(未来三年542 亿美元) |

• 微软的2024年资本支出为512亿美元,并宣布2025财年冲刺800亿美元的目标,但近期取消数据中心租约的消息(来源:TD Cowen报告,Bloomberg 2024年3月)令市场对其能否如期完成既定投入保持观望。

• 谷歌(Alphabet)则在2024年投入525亿美元,计划在2025年增至750亿美元重点强化数据中心网络。

• 阿里云在本地化政策的红利下,也推出未来三年共计3800亿人民币(约542亿美元)的投入计划,与全球厂商在基础设施规模上仍有一定差距(来源:阿里云2024年Q4公司公告)。

战略路径分野:开放生态与垂直闭环

在资本投入背后,不同厂商对生态构建的理解各异。

• 微软与OpenAI深度协同,以Copilot切入企业办公场景,形成“超级模型+标准化应用”的模式。然而过度依赖OpenAI技术栈可能在长尾场景或差异化需求中显现局限性。

• 谷歌聚焦开发者生态,谷歌CEO Sundar Pichai 宣称其大模型Gemini的开发者用量半年已达到440万,强化多模态能力,但在如何将技术优势转化为企业级商业成果上仍需时间积淀。

• 亚马逊云科技则主打“Choice Matters”开放策略,将大量资源投入到以Nova为代表的自研大模型和以Bedrock为核心的模型货架,兼容第三方头部模型,辅以自研芯片提升算力效率。这种开放与自研并行的模式,不仅降低了客户的试错成本,也为Nova等自研大模型提供了充沛的落地场景支持,展现出弹性的生态运营策略.

当2025年对商业回报的严苛检验到来之际,那些能在算力规模与生态构建上兼顾效率与灵活度的厂商,才有望在企业级大模型市场中占据主动。整体而言,基础设施规模与多模型生态正成为云计算巨头们抢占未来AI格局的“双引擎”。

02

多模型生态的竞争逻辑:解构客户需求的“不可能三角”

从2023年的概念验证(POC),到2024年大规模部署在生产环境,再到2025年对商业价值的深度挖掘,企业对大模型的需求正日趋多元化与务实化。

当金融机构需要处理百亿级资产的复杂推理时,高性能模型所带来的高昂成本往往令CIO们陷入两难;制造业既期望以较低成本处理海量设备日志,又需要图像质检等专业场景的精确度;而在合规要求严苛的医疗行业,私有化部署的安全需求与技术迭代敏捷性之间的矛盾更为凸显。

这三重“性能-成本-场景适配性”的不可能三角,正在将企业从对大模型性能的盲目崇拜,推向更具成本收益意识的“精算时代”。随着2025年更加聚焦于是否能为业务带来实际收益,多模型生态的灵活性成为企业的首要考量。

分化的应对路径:超级模型 vs. 多模型组合

• 微软押注“超级模型+”路线,通过Azure OpenAI服务主打GPT-4 Turbo等头部模型红利,特别是在自然语言处理与办公场景中形成标杆。据IDC 2024年企业AI采用报告显示,文档自动化场景可提升平均42%的效率,但若需深度定制或微调,则需要额外采购专用算力资源,中小型企业的总拥有成本由此增加28%。

• 谷歌延续“开放实验”策略,Gemini 2.0凭借多模态支持能力在跨模态数据分析中吸引了47%的开发者采用(来源:谷歌2024开发者调查报告)。然而在企业级应用中,部署工具链尚不完备,需自行集成监控、安全等第三方服务,某制造业客户因此使运维人力成本增加19%(来源:Gartner 2024制造业AI成熟度评估)。

• 亚马逊云科技的“Choice Matter”思路,更侧重搭建多层级的开放生态。Bedrock平台整合了从经济型基础模型到垂直领域专用工具的完整矩阵,自研模型Nova在性能与成本间找到平衡,且能与第三方模型联动。某跨国零售商将80%的高频客服任务交由高性价比模型处理,仅在战略业务时调用顶尖大模型,由此降低整体成本35%,并未牺牲核心场景的性能表现。

“精算式”模型组合:让客户拿回选择权

当企业在2024年大规模投入生产环境后,对商业回报的考量将更加理性。在此过程中,多模型生态之所以被视作最优策略,核心在于通过“组合拳”实现按需分配:

• 技术民主化:无需为过度性能付费,可根据场景轻松切换不同型号或供应商的模型。

• 灵活应对业务变化:可于内部测试不同模型,以快速响应市场与客户需求的调整。

亚马逊云科技CEO Matt Garman在谈及多模型策略时表示:“让客户自己选择适合他们应用和成本-性能需求的模型,远比我们替他们做出单一决定来得重要。”

随着企业由“技术至上”向“成本-收益精算”转变,云厂商之间的竞争焦点,也正从大模型性能的单点对决,升级为围绕生态运营能力的系统化较量。谁能够真正释放“选择的价值”,帮助客户跨越“不可能三角”的约束,谁就可能站在企业级AI应用的制高点。

03

关键趋势:从技术竞赛到生态运营的转型

企业对大模型带来实际商业价值的关注度持续升温。AI竞赛的战场正从实验室参数排行榜转向企业级市场的生态运营能力:当主流大模型在性能和推理速度上逐渐收窄差距,能否构建跨行业、跨云环境的多元工具链、并快速响应细分需求,成为定义云厂商胜负的新标尺。

“Good Enough”模型崛起:成本理性主义的胜利

企业对AI的期待正从对“极致性能”的追逐,转向“够用就好”的理性模型策略。麦肯锡研究指出,在零售价值链中大规模应用生成式AI时,ROI转化优先级已超越技术领先性(来源:麦肯锡,《LLM to ROI: How to Scale Gen AI in Retail》,2024)。当企业意识到约80%的日常应用无需顶尖模型时,亚马逊云科技的Nova系列成为这一趋势的典型代表——其轻量化设计、多模态能力与“性能-成本”平衡特性,直接推动“Good Enough”模型的普及。

例如,Nova Micro以每秒210 Token的超高速度支持实时客服与信息检索,成本较同类模型降低75%;Nova Lite和Pro则通过多模态整合(文本、图像、视频)与RAG(检索增强生成)优化,精准匹配自动化流程与复杂业务场景,在降低算力投入的同时满足80%的日常需求。即便是高端场景,即将推出的Nova Premier也通过“蒸馏定制”能力,将大模型知识迁移至轻量级版本,进一步压缩战略级任务的部署成本。

Nova并非孤立的技术工具,而是亚马逊云科技推动企业从“技术验证”转向“商业价值”的核心载体。凭借灵活的部署方式与Bedrock平台的生态协同,企业可自由组合Nova系列与第三方模型,例如将高频任务分配给高性价比的Nova Micro,仅在关键业务调用顶尖模型。这种“精算式”策略使某零售巨头在客服自动化中降低35%成本,同时维持核心场景性能,印证了“Good Enough”模型如何成为商业价值落地的关键杠杆。2025年,随着企业愈发关注AI的ROI转化,Nova系列通过“够用就好”的设计理念与全场景覆盖能力,正在重新定义生成式AI的价值逻辑——唯有可量化的成本优化与业务增长,才是技术的价值。

混合部署的博弈:工具链决定生态黏性

多云和混合云架构的兴起,为企业提供了弹性部署大模型的灵活性,却也带来了管理和集成的复杂度。微软通过Power Platform的低代码能力降低开发门槛,但其封闭生态导致跨模型协同效率不足。

谷歌的Vertex AI试图在模型训练、部署和监控层面提供一体化方案,仍在跨云管理上面临一定挑战。

亚马逊云科技则借助Outposts、EKS Anywhere等产品,为客户在本地或跨云环境部署大模型提供了更大自由度;通过Amazon SageMaker的全生命周期管理工具,配合自研Nova系列及Bedrock平台上的第三方模型,大幅减轻了企业在多模型运维上的负担。这样一来,企业既能“随处运行”不同模型,又不必牺牲整体的管理效率,从而在2024年大规模生产环境中保持灵活。

垂直模型的“长尾战争”:下一个关键增长点

当通用模型间的性能差距逐渐缩小后,各厂商对特定行业或场景的深耕成为新增长点。制造业需求集中在设备预测性维护与图像质检,金融业聚焦风控合规与高并发推理,零售/电商则在客服自动化与个性化推荐上投入更多算力。

2025年初,云厂商密集发布面向不同垂直领域的新模型,亚马逊云科技除了自研 Nova 系列模型,在Bedrock Marketplace平台上也接入了主流模型Deepseek R1(深度推理)、Luma Ray2(视频生成)、Meta的SAM 2.1(工业质检)、Claude3.7(混合推理)等,全平台模型多达186个,为客户提供从文本到多模态的一站式选择。

IDC调研显示,当企业在同一平台上使用三种以上垂直模型时,其AI项目的规模化落地周期可由12-18个月缩短至6-9个月。这种“场景闪电战”不仅决定了云厂商是否能抢占细分行业先机,也预示着2025年商业价值兑现的关键—能否通过完善的多模型组合,快速满足各类业务需求。

04

生态运营怎么做?亚马逊云科技为何选择“Choice Matters”

当企业跨过了技术验证与规模部署的门槛后,2025年对商业价值的聚焦将更加严苛:能否切实带来ROI、并快速融入企业核心流程。亚马逊云科技以“Choice Matters”战略为核心支点,从硬件到模型、从安全到可持续能源,构建“可组合、易扩展、兼容多方”的多模型生态体系。硬件层面,在自研Trainium 2与英伟达GPU之间提供多元选择,让企业在性能与成本间灵活取舍;模型层面,Nova系列与Bedrock平台深度打通第三方头部模型,打造“自研+开源+合作伙伴”的立体矩阵;安全与合规方面,借助自动化推理检查等工具,帮助工业、金融、医疗等领域应对数据隐私与严谨监管等。

归根结底,“Choice Matters”代表了亚马逊云科技对企业AI需求的深度洞察:第一,以客户需求为锚点,让他们能自由组合不同的算力、模型和服务,而非被单一“超级模型”或封闭平台锁死;第二,以开放与长期主义为原则,向行业场景纵深布局,吸纳更多元的技术与创新者,进一步扩展客户的选择空间。随着大模型从“概念验证”跃升到大规模生产应用,企业不再盲目追逐“极致性能”,而是理性衡量成本、效率与合规要求,用“精算思维”将通用模型与垂直模型巧妙结合,从而在多元化场景中获得可量化的商业回报。能够提供“多模型组合拳”的云厂商无疑更具持久竞争力。亚马逊云科技正凭借强大的技术栈与生态合力,为企业级AI在2025年实现商业价值落地奠定坚实基石:帮助客户真正掌握“选择权”,以最适合自身的方式完成AI转型,并将生成式AI的潜能切实转化为面向未来的业务增长。

05

结语

云计算的AI战争已从“模型性能单点突破”转向“生态运营能力全面比拼”。无论厂商选择开放生态还是垂直闭环,企业级市场的终极考验仍在于能否将技术选项转化为可量化的商业价值。当企业用ROI指标衡量AI成效时,云计算厂商的胜负关键,或许不在于技术路线的对错,而在于能否将复杂性转化为客户手中的“选择权”。

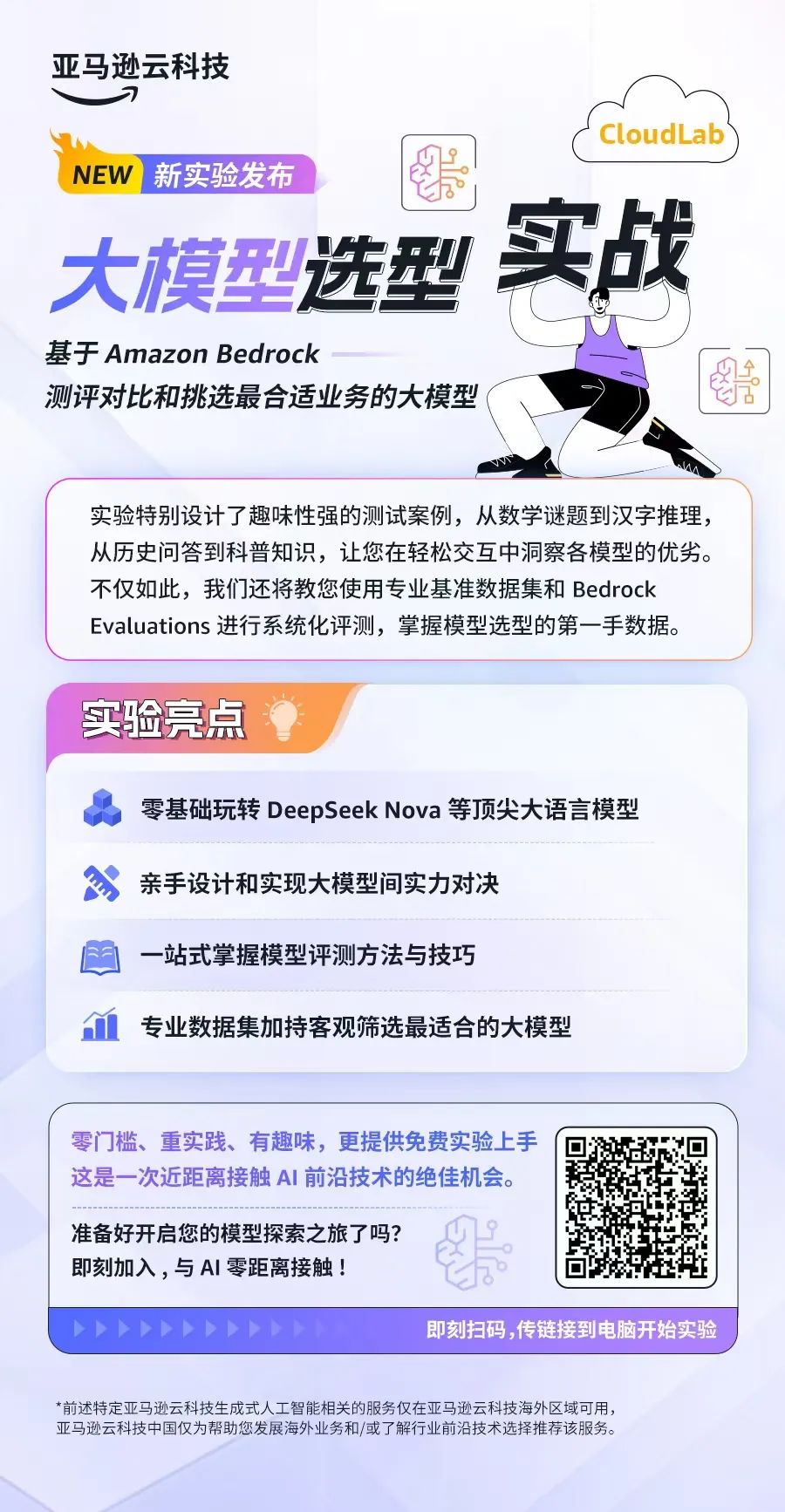

【🔥 限时实验邀约】「大模型选型实战」免费开启!

通过Amazon Bedrock平台,深度测评Nova、Llama、Mistral等顶尖模型,覆盖STEM、社科、人文多领域实测。零门槛体验12个月免费算力,亲手生成《模型性能-成本雷达图》,更可输入业务参数一键获取推荐方案!👇️

(文:AIGC开放社区)