OmniAlign-V团队 投稿

量子位 | 公众号 QbitAI

在实际应用过程中,闭源模型(GPT-4o)等在回复的全面性、完备性、美观性等方面展示出了不俗的表现。

与之相反的是,在General VQA任务上表现最好的开源模型(如InternVL2-78B)在面对开放式、需要知识储备的问题时,表现不尽人意:

△InternVL2-78B和GPT-4o在回复的完备性和美观性上有较大差距

△InternVL2-78B和GPT-4o在回复的完备性和美观性上有较大差距

上述现象引发了上海交大、上海AI Lab等联合团队的思考。

他们首先猜测:MLLM的回复质量下降可能是因为经过了多模态数据训练之后,LLM本身的能力退化。

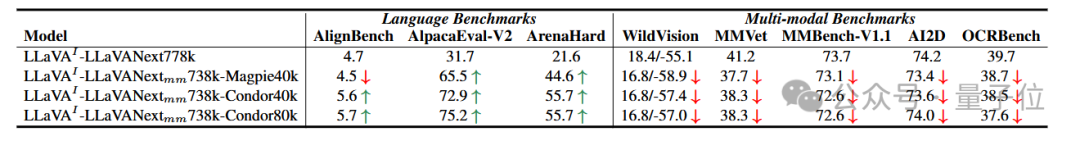

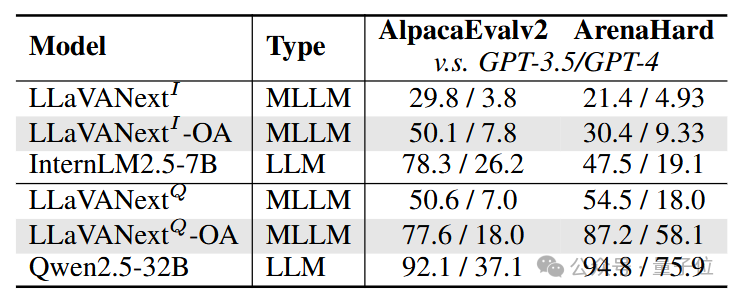

因此分别测试了多个主流开源模型在主流的纯语言对齐Benchmark(AlignBench/AlpacaEval2/ArenaHard)上的性能:

△得分由Qwen2.5-72B进行judge

△得分由Qwen2.5-72B进行judge

结果显示,经过多模态训练的大语言模型在语言主观基准上的性能简直可以用雪崩来形容。

既然如此,那是不是说,在多模态数据中加入更多更好的语言数据就可以了呢?团队又进一步做了如下实验:

采用LLaVA框架,使用最新的语言模型Internlm2.5-7B作为base,用LLaVANext-780k高质量多模态数据作为Baseline。已知在LLaVANext-780k中,包含40k左右的来自ShareGPT的数据。

由于ShareGPT年代较为久远,所以选择了最新的两个开源语言sft数据集,Magpie-LLaMA3.3以及Condor。将原始的ShareGPT数据分别更换为Magpie以及Condor进行了实验,并在语言对齐基准、多模态对齐基准(WildVison)、General VQA基准(MMVet/MMBench/AI2D/OCRBench)上进行了全面评测:

△为了展示性能差异,此处AlpacaEval2和Arenahard的结果均与GPT3.5进行对比

△为了展示性能差异,此处AlpacaEval2和Arenahard的结果均与GPT3.5进行对比

加入了高质量的语言数据之后,模型在语言基准上的能力确实提升了;但是,无论是多模态主观对齐还是普通VQA任务,都出现了性能下降的情况。

因此推测:语言数据对多模态对齐能力的影响是十分有限的,在General VQA任务以外,仍然需要带有开放式问题以及完备回答的多模态训练数据。

Dataset Construction

基于以上观察,当前的多模态数据过于看重VQA任务的能力,因此数据面临答案过于简短、单一,缺少对预训练知识的运用与理解的问题。基于以上观点以及从纯语言数据组成中吸取的经验,团队提出多模态数据还应包含以下特点:

-

开放式,创造性,需要预训练知识的问题。

-

全面,完备,美观,符合指令跟随的回答。

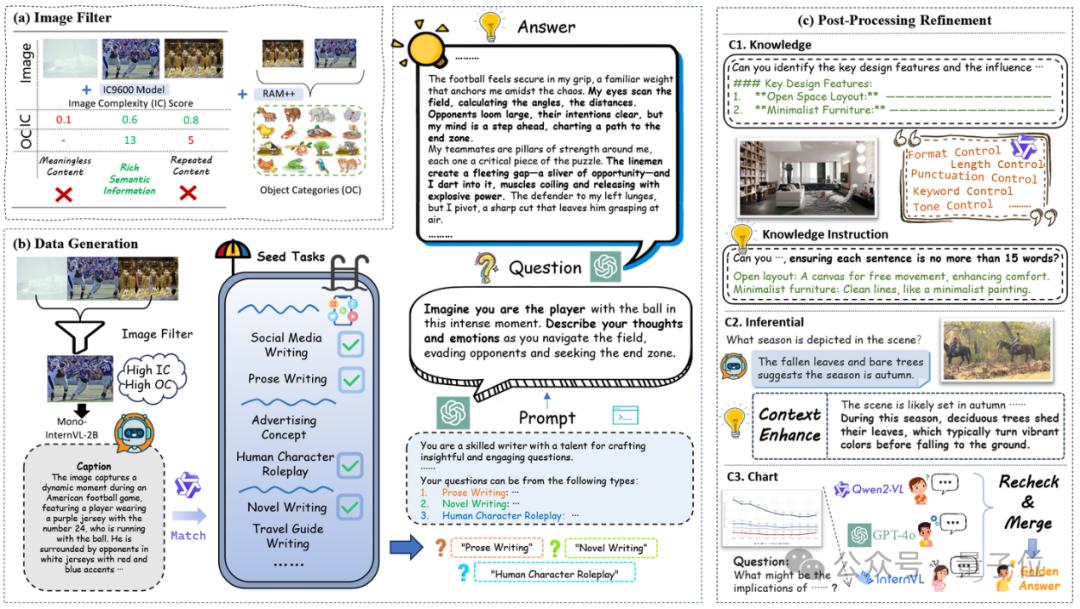

基于以上两点提出了OmniAlign-V数据构建Pipeline:

△Pipeline of OmniAlign-V

△Pipeline of OmniAlign-V

根据图片场景,首先将图片分为自然图片(Natural)以及信息图片(Infographic)。鉴于希望得到包含丰富信息的数据,因此首先对自然图片进行了图像复杂度以及物体种类数目的两轮筛选,确保筛选出的图片具有丰富的语义信息。

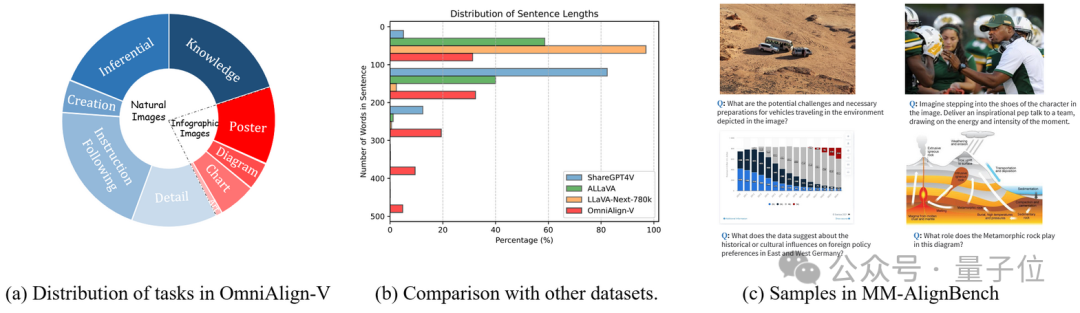

其次,将Natural图片分为Knowledge/Creation/Inferential三类任务,将信息图片分为Chart/Diagram/Poster/Art四类任务,对不同任务分别应用对应的精心设计的Pipeline以及GPT-4o生成对话数据。而后,对Knowledge/Inferential/Chart分别应用不同的后处理优化,增强了Inferencial和Chart数据的完备性和准确性,在Knowledge基础上额外添加了Instruction-Following指令,将其作为Instruction-Following任务。最终,OmniAlign-V-SFT包含了205k高质量的多模态数据。

团队发现OmniAlign-V-SFT中的回复质量较高,很适合作为DPO数据中的positive sample。因此通过对LLaVANext-Internlm2.5-7B模型的输出应用reject sampling,得到了对应的negative sample,并由此生成了OmniAlign-V-DPO数据集。

此外还发现当前缺少高质量的多模态主观对齐基准。当前的基准当中面临图像质量差,问题模糊/多样性差等问题。因此构建了MM-AlignBench多模态对齐基准。从经过预筛选的3000+张图片中人工挑选了252张分布多样且高质量的图片,每张图片以及对应的问题都经过人工审查,确保图片和任务问题的多样性以及准确性,合理性。

实验结果

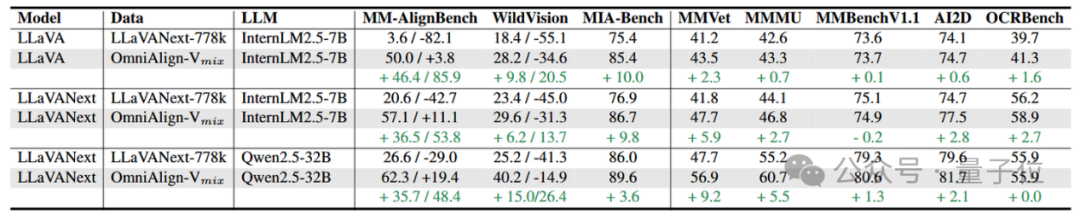

在LLaVA/LLaVA-Next上分别采用Internlm2.5-7B/Qwen2.5-32B进行了实验,并在三个多模态对齐基准以及五个主流VQA基准上进行了评测,结果如下:

△SFT多模态评测结果

△SFT多模态评测结果

可以看出,在添加了OmniAlign-V-SFT数据集后,MLLM在三个多模态对齐基准上的表现均有大幅提升;并且在多个General VQA Benchmark上均有不同程度的涨点,尤其是在MMVet和MMMU上涨点十分显著;LLaVANext-Qwen2.5-32B甚至在MMVet和MMMU上分别增加了+9.2和+5.5。这有力验证了OmniAlign-V数据集的有效性。

此外还发现,经过OmniAlign-V-SFT训练后,模型在语言对齐基准上也有一定程度的上涨:

△SFT语言评测结果

这也验证了,当添加部分高质量的多模态对齐数据后,能够有效减少LLM在多模态训练当中面临的语言能力退化问题。

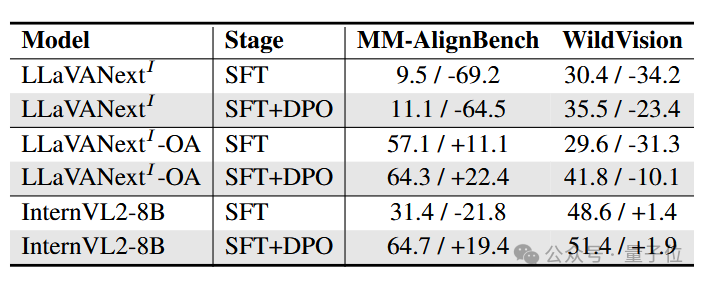

此外,采用OmniAlign-V-DPO进行DPO训练后,模型的对齐能力进一步增强:

△DPO实验结果

△DPO实验结果

实验结果显示,当模型完全没有接受长上下文类似的数据训练时,在DPO阶段应用OmniAlign-V-DPO并不能显著地提升模型的对齐;而对于经过高质量长上下文训练的模型而言,OmniAlign-V-DPO可以进一步显著激发模型的对齐能力。尤其是在经过大规模训练的开源模型(InternVL2-8B)上,模型的性能提升尤其明显。

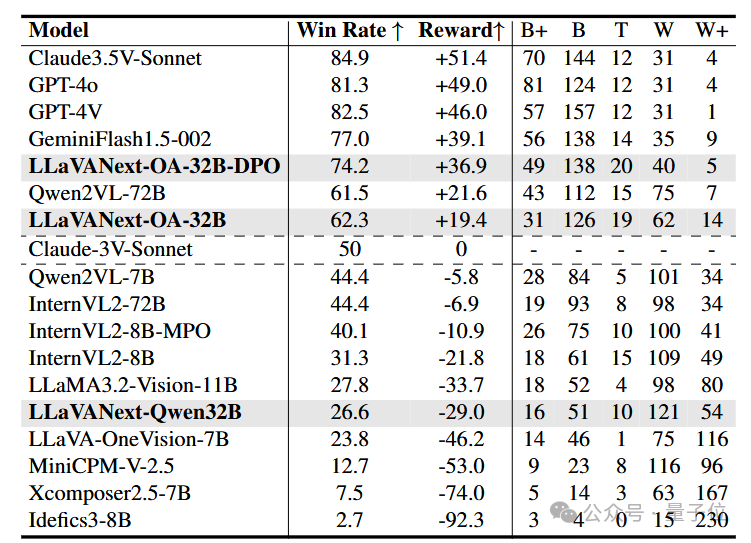

MM-AlignBench已经支持到VLMEvalkit,用于在多个MLLM上进行快捷评测。团队测试了当前主流MLLM在MM-AlignBench上的结果:

△MM-AlignBench Leaderboard

△MM-AlignBench Leaderboard

经过SFT+DPO数据后,LLaVANext-OA-32B-DPO的对齐性能提升明显,在MMAlignBench上的性能已经超越了QwenVL2-72B。

与此同时也可以看出,即使是QwenVL2-72B和InternVL2-78B,在MMAlignBench上的表现距离闭源模型(GPT/Gemini/Claude Series)也有较大的差距。

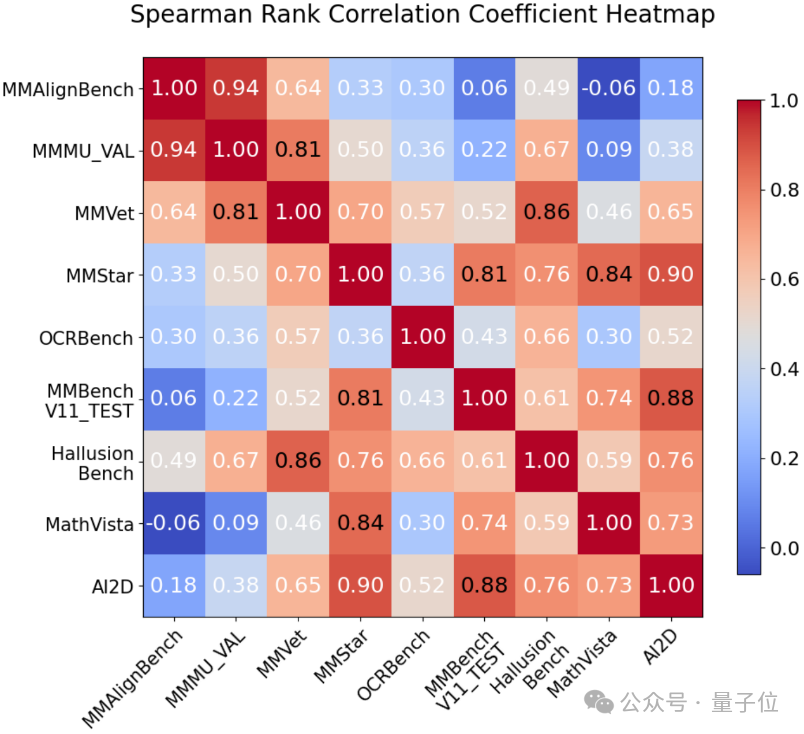

进一步对MM-AlignBench和其他General VQA Benchmark计算相关度,SRCC score如下所示:

△MM-AlignBench与其他基准的相关性统计

△MM-AlignBench与其他基准的相关性统计

可以发现,MM-AlignBench 与现有的多模态评测基准(如 MMBench、OCRBench 等 VQA Benchmark)之间的相关性极低,但却与 MMMU 表现出极高的相关性。作为一项涵盖大量跨学科任务的评测基准,MMMU 对模型的知识先验深度和广度提出了极高的要求。尽管 MMMU 采用选择题形式,答案具有唯一正确解,而 MM-AlignBench 则以开放式问答为主,两者的题型设计存在显著差异,但它们所考察的核心能力却高度相似。这一现象表明,MM-AlignBench 不仅覆盖了广泛的任务领域,还深入挖掘了模型在知识先验上的表现,进一步验证了其评测维度的全面性与挑战性。

Future Work

上述研究不仅深入探讨了多模态大语言模型的对齐能力,更引发了作者团队对一个核心问题的全新思考:

究竟什么才是通向真正模态融合的正确路径?在多模态微调过程中,大语言模型往往会面临一个棘手的问题——语言能力的“灾难性遗忘”。然而,像GPT-4o等闭源模型却能够成功实现文本与图像模态的深度融合,充分释放其庞大的预训练语言知识潜能。这背后的技术路线究竟是如何设计的?又是怎样做到如此高效且精准的模态融合的?

这些问题无疑为我们指明了未来探索的重要方向。

Paper: https://arxiv.org/abs/2502.18411

Github: https://github.com/PhoenixZ810/OmniAlign-V

(文:量子位)