Pruna AI 一直在构建一个框架,该框架将多种效率方法应用于给定的 AI 模型,如缓存、蒸馏等。“我们还标准化了压缩模型的保存和加载,应用这些压缩方法的组合,并在压缩后评估你的压缩模型,”Pruna AI 联合创始人兼 CTO John Rachwan 告诉 TechCrunch。

Pruna AI 的框架能够评估模型压缩后,是否存在显著的质量损失,以及所获得的性能提升。

“如果要用一个比喻,我们类似于 Hugging Face 如何标准化 transformers 和 diffusers——如何调用它们,如何保存、加载它们等。我们正在做同样的事情,但针对的是效率方法,”他补充道。

大型 AI 实验室已经在使用各种压缩方法。例如,OpenAI 一直依赖蒸馏技术来创建其旗舰模型的更快版本。

这很可能是 OpenAI 开发 GPT-4 Turbo 的方式,它是 GPT-4 的一个更快版本。同样,Flux.1-schnell 图像生成模型是 Black Forest Labs 的 Flux.1 模型的蒸馏版本。

蒸馏技术是一种利用“师生模型”从大型 AI 模型中提取知识的方法。开发者向教师模型发送请求并记录其输出,有时会将答案与数据集进行比较以评估其准确性。随后,这些输出被用于训练学生模型,使其能够近似模仿教师模型的行为。

“对于大公司而言,他们通常的做法是内部构建这些技术。而在开源世界里,你能找到的通常是基于单一方法的东西。比如,LLMs的一种量化方法,或是扩散模型的一种缓存方法,”Rachwan 说,“但你找不到一个工具能够整合所有这些,让它们都易于使用并能组合在一起。而这正是 Pruma 当前带来的巨大价值所在。”

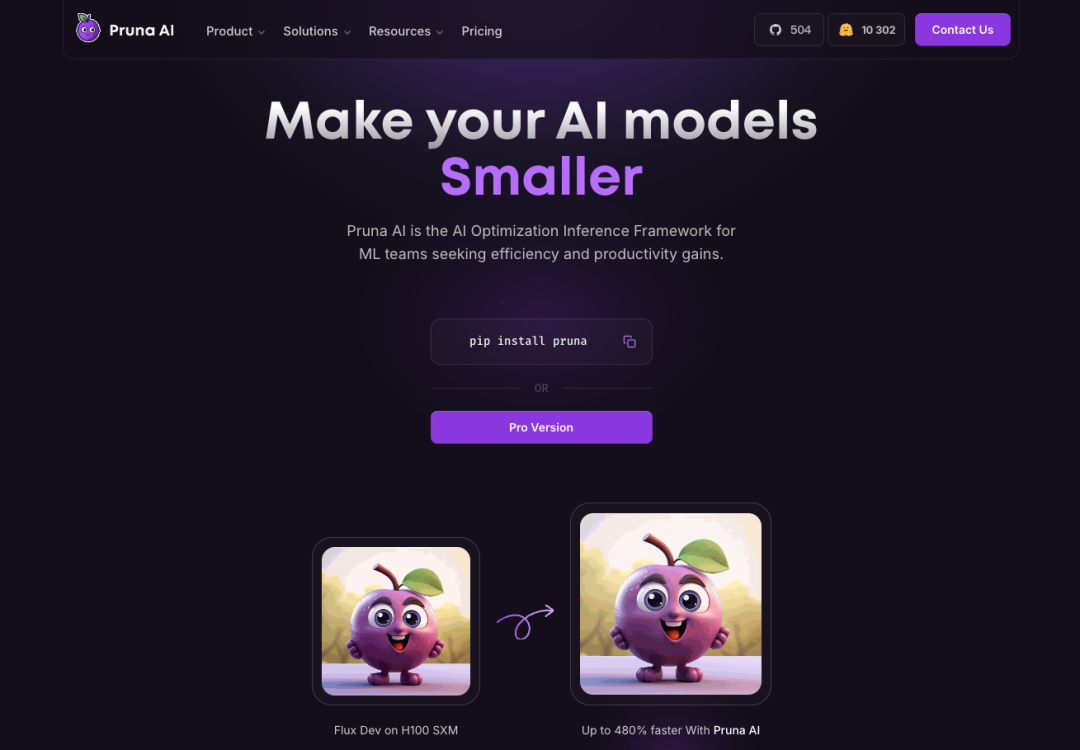

虽然 Pruna AI 支持各种类型的模型,从大型语言模型到扩散模型、语音转文本模型和计算机视觉模型,但公司目前正更专注于图像和视频生成模型。

Pruna AI 的一些现有用户包括 Scenario 和 PhotoRoom。除了开源版本外,Pruna AI 还提供企业版,包含高级优化功能,如优化代理。

“我们即将发布的最激动人心的功能将是一个压缩代理,”Rachwan 说。“基本上,你提供你的模型,然后说:‘我想要更快的速度,但准确率下降不要超过 2%。’然后,代理就会施展它的魔法。它会为你找到最佳组合,并将其返回给你。作为开发者,你无需做任何事情。”

Pruna AI 对其专业版本按小时收费。“这类似于在 AWS 或任何云服务上租用 GPU 时的计费方式,”Rachwan 说道。

如果您的模型是 AI 基础设施的关键部分,使用优化后的模型最终将为您节省大量推理成本。例如,Pruna AI 利用其压缩框架,在损失不大的情况下,将 Llama 模型缩小了八倍。Pruna AI 希望其客户能将压缩框架视为一项自付成本的投资。

本文翻译自:https://techcrunch.com/2025/03/20/pruna-ai-open-sources-its-ai-model-optimization-framework/

编译:ChatGPT

(文:Z Potentials)