无论是学术研究、数据分析还是日常工作,多步骤任务往往耗时耗力。

传统工具需要手动操作多个环节,而随着 AI Agent 应用的不断发展壮大,彻底改变了这一局面。

LangManus 作为一款刚开源的 AI Agent 工具,凭借其强大的大语言模型(LLM)和多样化工具集成,迅速崭露头角。

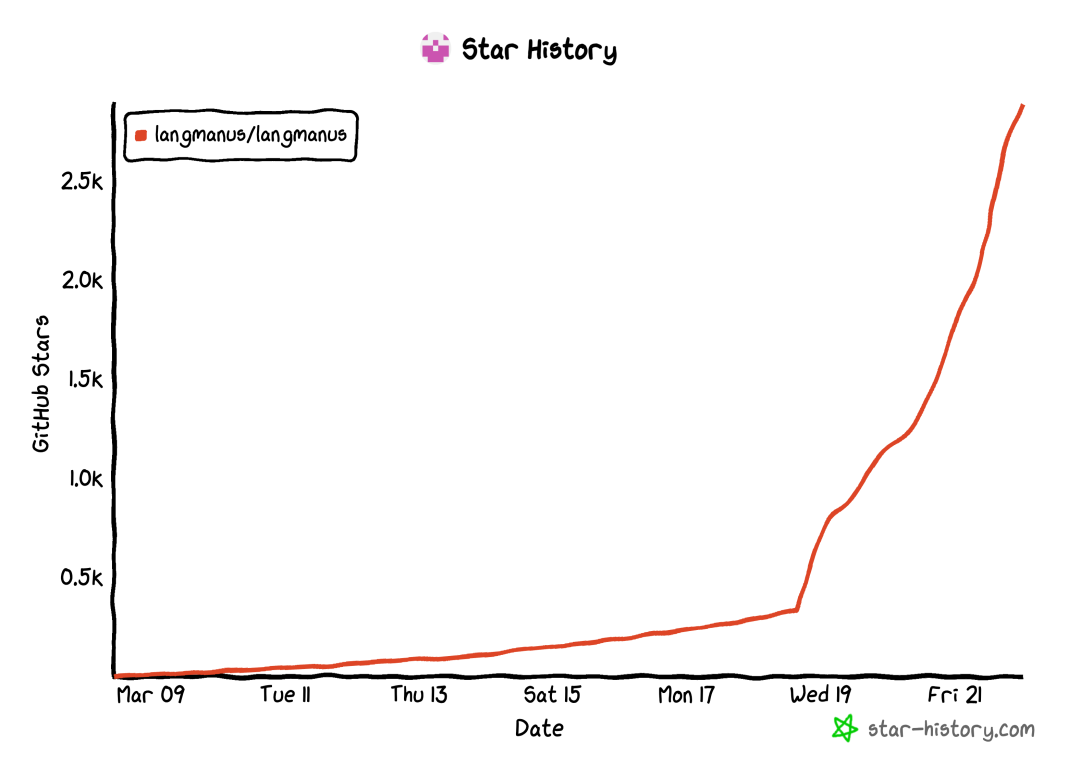

并且在最近3天内猛涨 2.6k+ Star!

它不仅能通过网络搜索、网页爬取和浏览器控制完成任务,还能自动执行代码、生成报告,堪称研究和自动化的“全能助手”,真正实现端到端的自动化任务执行。

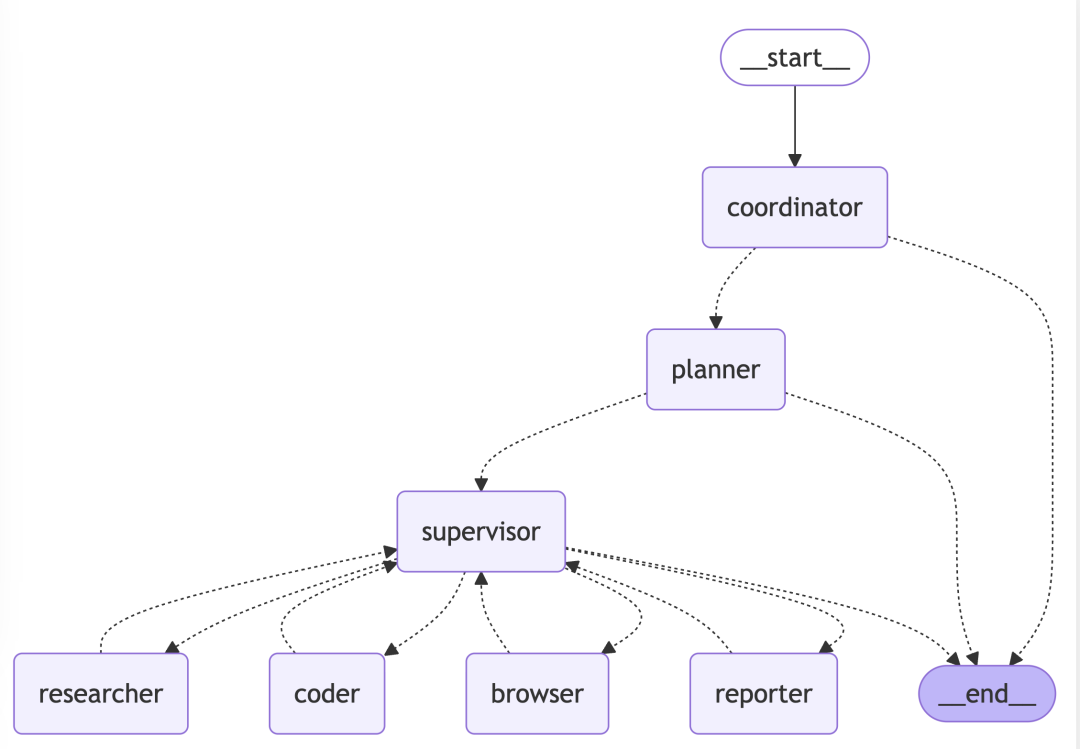

还可通过自然语言交互或 API 调用,驱动多个智能体协同工作,包括协调者(Coordinator)、规划者(Planner)和监督者(Supervisor),确保任务高效完成。

LangManus 的终极目标是能以智能、高效的方式完成各种复杂人物,让你从繁琐中解放出来。

核心能力

-

• LLM 集成:支持通义千问等开源模型,多层 LLM 系统适配不同任务复杂度 -

• 工具集成:Tavily API 进行网络搜索、Jina 进行神经搜索、高级内容提取 -

• Python 集成:内置 Python,可直接进行代码执行,还集成 uv 包管理 -

• 工作流管理:可视化工作流控制、多智能体编排、任务分配和监控

快速使用

LangManus 的安装支持本地部署。

前置要求:需保证本地安装 uv 包管理器。

按照以下步骤设置虚拟环境并安装必要的依赖:

# 步骤 1:用uv创建并激活虚拟环境

uv python install 3.12

uv venv --python 3.12

# Unix/macOS 系统:

source .venv/bin/activate

# Windows 系统:

.venv\Scripts\activate

# 步骤 2:安装项目依赖

uv sync在正式使用之前,还需要配置 LangManus 三层 LLM 系统,分别用于推理、基础任务和视觉语言任务。也就是一些常用的模型、APIKEY、BaseURL等,具体变量名可参考项目文档。

使用方法

使用默认设置运行 LangManus:

uv run main.pyLangManus 提供基于 FastAPI 的 API 服务器,支持流式响应:

# 启动 API 服务器

make serve

# 或直接运行

uv run server.pyAPI 服务器提供以下端点:

-

• POST /api/chat/stream:用于 LangGraph 调用的聊天端点,流式响应

LangManus 还提供一个默认的网页界面,也是一个开源项目:

https://github.com/langmanus/langmanus-web

更多高级用法(如定制智能体或调整工具)可参考 GitHub 文档,几分钟即可上手。

写在最后

LangManus 是一款强大、多功能的 AI 自动化任务助手,能够搜索、爬取、分析数据,自动完成复杂的研究任务。

它有以下 4 大核心优势:

-

• 智能任务自动化,自动搜索 + 代码执行 + 网页交互 -

• 分层多智能体架构,高效完成复杂任务 -

• 支持多种 LLM、工具和搜索引擎,灵活适配不同需求 -

• API、命令行、自然语言交互,多种使用方式可选

如果你需要一个智能、高效的任务处理助手,不妨试试它。

GitHub 项目地址:https://github.com/langmanus/langmanus

● 一款改变你视频下载体验的神器:MediaGo

● 新一代开源语音库CoQui TTS冲到了GitHub 20.5k Star

● 最新最全 VSCODE 插件推荐(2023版)

● Star 50.3k!超棒的国产远程桌面开源应用火了!

● 超牛的AI物理引擎项目,刚开源不到一天,就飙升到超9K Star!突破物理仿真极限!

(文:开源星探)