跳至内容

继DeepSeek之后,中国又一AI产品Manus火了,虽然外界对于该产品喜忧参半,但Manus引发的资本市场涌动,已经让AI Agent相关概念板块连板涨停。

虽然利用AI Agent完成任务并非Manus独创,但它把多智能体协同做成产品,将多个AI能力整合进产品当中,并通过简易化人机交互来完成复杂任务,其产品的设计思路值得我们每一位从业者去思考,这一点不光聚焦在大语言模型范畴,对于机器人行业亦是如此。

为什么开发机器人,必须掌握Python/C++等语言进行底层控制逻辑编写,涉及到语言交互机器学习,还必须通过Python调用TensorFlow/PyTorch框架训练模型,并整合到ROS系统中实现端到端控制。虽然部分研究机构推出了实验性AI编程助手(如GitHub Copilot),用户通过描述需求即可生成控制代码,但当前仍局限于简单场景,远没有达到泛化作业能力的水平。

首先我们要明白一点,大语言模型并不能直接应用于人形机器人上。这里面的本质问题在于大语言模型依赖文本数据训练,缺乏对物理世界的具身感知能力(如物体重量、空间方位、摩擦力等),尽管LLM擅长逻辑推理,但机器人需将抽象指令(如“打开抽屉取薯片”)转化为具体动作序列(如关节控制参数),并协调感知-决策-执行闭环。未经微调的模型无法将语言指令映射到硬件操作,导致任务成功率低下。

目前业界较为普遍的方法是,通过领域数据注入(如运动轨迹、仿真环境)和参数优化(如LoRA技术),微调可压缩模型规模、提升硬件适配性,并增强对物理规则的理解,从而打通大语言模型与机器人之间的“数字鸿沟”。

但这种方式并非主流,仅从Figure与Open AI分道扬镳转而自研端到端Helix模型就能看得出来。单纯依靠LLM并不能解决人形机器人通用性的问题。而Helix模型则更多的整合了感知、语言理解和学习控制等技术,克服了机器人长期以来的多项挑战。但需要关注的是这套VLA模型确实能够进行单机和多机交互。但依然无法解决低门槛部署和泛化性任务问题。

上周,国地共建具身智能机器人创新中心发布了全球首个“一脑多能”“一脑多机”的通用具身智能平台“慧思开物”。该平台是对基于单一场景单一任务做专项开发这一传统机器人应用开发模式的颠覆,同时也填补了具身智能领域在通用软件系统方面的空白,真正推动智能机器人从单一任务执行向复杂环境下的自主决策与执行能力跃升。

相比称其为具身智能平台,笔者更愿意将其视为机器人AI Agent,它不仅具备传统AI Agent的自主决策、任务规划等核心能力,更能通过预设指令集,实现物理动作精准控制、多模态环境实时交互、跨硬件平台泛化应用。这是人形机器人首次通过AI Agent从数字空间向物理空间的拓展。

正如国地共建具身智能机器人创新中心熊友军所说,具身智能在“智能化”方面仍处于初级阶段,为此行业亟需一个具备多本体兼容性、多场景适应性和强大泛化能力的通用智能平台。

作为一个机器人AI Agent平台,“慧思开物”除了能够实现从任务理解到执行的全流程智能化,还具备处理多场景复杂任务的泛化能力,并实现了单个软件系统在机械臂、轮式机器人、人形机器人等多构型本体上的兼容,能够适应多样化的场景作业要求。这与采用VLA模型来驱动机器人进行任务的方式有很大不同。

“慧思开物”作为机器人中枢神经系统,集成感知、决策、语言、学习及运动控制等高级认知功能,通过多专家智能体协同实现模型能力提升,提高机器人在复杂任务中的智能化与执行效率,同时通过低代码方式降低机器人开发门槛,简化开发流程。

“慧思开物”系统基于AI大模型构建任务规划具身”大脑”与数据驱动型端到端技能执行具身”小脑”的协同架构,构成支持多类型机器人与物理环境交互的开放式技术平台。该体系整合了具身智能双模态核心:

1、具身”大脑”模块具备多模态交互能力、三维空间认知、语义解析与决策生成功能,支持分层任务规划与执行过程监控,并通过强化学习实现错误补偿机制;

①具身操作子平台包含元技能知识图谱、自适应抓取算法库、复杂动作序列解耦引擎及异常状态处理模块

②具身运控子平台实现全身动力学模型控制、双臂协同运动规划、动态平衡调节及多模态导航算法

系统通过具身”大脑”生成任务规划指令,调用具身”小脑”技能库执行具体操作,构建”规划-执行-反馈-优化”的闭环控制流程,形成具有自迭代能力的机器人智能交互体系。

▍自动化、易部署、具备泛化作业能力 四大场景能力展示

在结构化的环境下,“慧思开物”平台已经实现了工业分拣、积木搭建、桌面清理和物流打包的测试验证。操作者无需使用Python/C++来实现运控调用,也不需要使用手柄或遥操作设备远程控制机器人。仅需采用语音指令和“慧思开物”APP直连的方式,与机器人进行任务交互,全程可视化,甚至可以一键切换到机器人本体搭载的摄像头上,进行远程监控与部署。

在工业分拣场景,操作员通过“慧思开物”APP调用UR-5e机械臂进行双臂协作分拣任务,免去了传统机器人使用示教器或控制面板执行预编写程序的复杂操作。“APP+机器人”模式,极大降低了操作者的使用门槛,简化操作流程。

结构化积木搭建作业,非常考验机器人对空间的理解能力与操作精度,利用大模型思维链能力,“慧思开物”将复杂的任务进行拆解并执行。它具备很强的思考能力,能够明白三层结构的积木搭建顺序,并通过视觉大模型(VLM)进行任务规划,逐层对人类演示积木结构进行复建,操作精度达到毫米级别。

桌面清理作业,搭载“慧思开物”的“天工”机器人,通过双臂协作和端到端模型,对桌面垃圾进行清理,将废纸团投入桌边垃圾桶中。值得关注的是,搭载“慧思开物”的“天工”机器人即使面临人为扰动,仍能自主纠错并完成任务,拥有极强的动态规划与自适应纠错能力。

在长程任务的解决能力上,“天工PRO”模拟了流水线当中的物流打包场景,通过上半身协调和双臂协同作业,机器人成功完成扫码、装箱、封箱和贴标签等一系列操作。真正意义上做到了全流程化自主操作。

▍不止“慧思开物”谷歌DeepMind也在开发机器人AI Agent

几乎在“慧思开物”发布的同一时间,谷歌DeepMind实验室公布了Gemini系列最新研究成果。团队通过Gemini模型,成功实现了对文本、图像、音频和视频的多模态协同分析能力,为复杂问题提供了数字化解决方案。谷歌DeepMind研发人员表示,为了让AI在物理领域真正服务于人类,具备类似人类的具身推理能力至关重要。

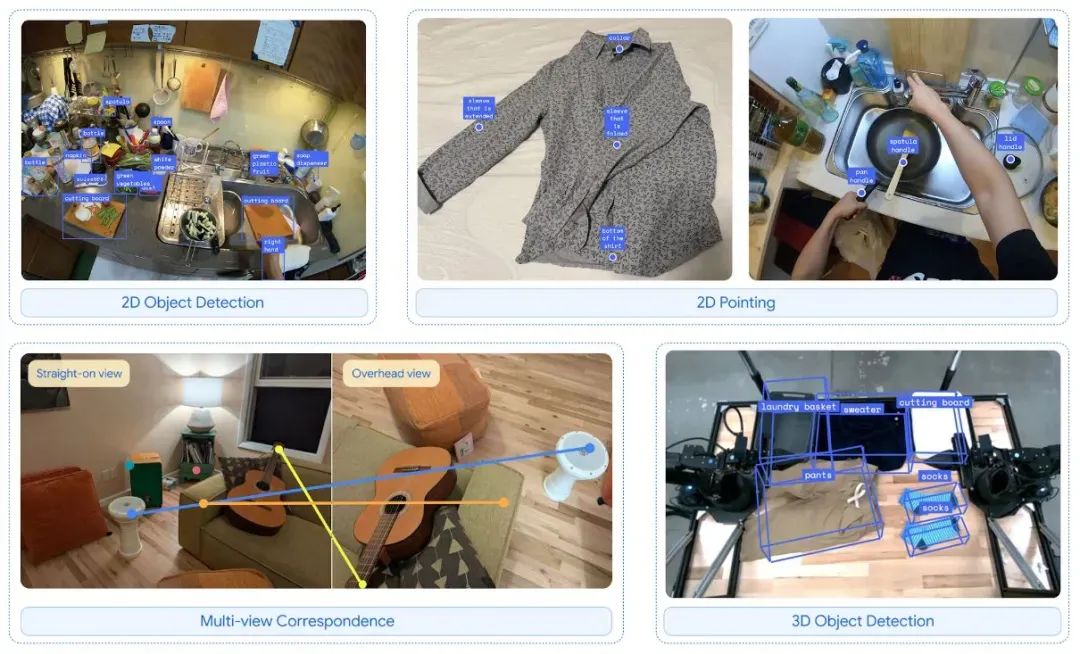

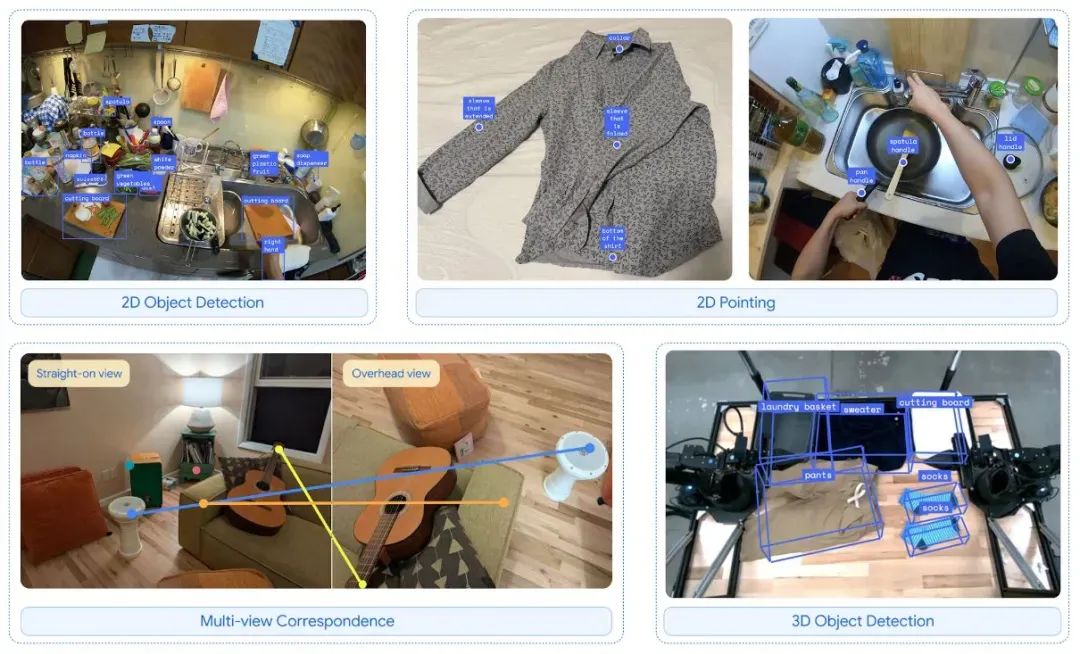

DeepMind团队基于Gemini 2.0架构发布了两项最新研究成果:Gemini Robotics和Gemini Robotics-ER(具身推理增强版)。Gemini Robotics作为先进的视觉-语言-动作(VLA)模型,新增了物理动作输出模块,能够直接生成机器人控制指令,实现了多模态感知与实体动作执行的闭环,支持复杂任务的端到端控制。

而Gemini Robotics-ER则专注于空间理解与物理推理,为机器人专家提供了可编程的具身推理框架,显著增强了机器人在处理动态场景时的决策能力。

从DeepMind Youtube放出的测试视频来看,搭载Gemini 2.0架构机器人展现出强大的任务操作能力,Gemini Robotics能够解决各种开箱即用的任务,包括训练中未见过的任务,且擅长处理新物体、指令和环境。其实时交互能力尤为突出,能够在快速变化的环境中持续调整行动策略,实现高精度操作。

例如,在折纸任务中,机器人不仅能准确完成复杂动作,还能通过语音交互解释词源。此外,Gemini Robotics还具备跨场景泛化能力,能够成功操作未经专门训练的实体对象。

为了适配多样化硬件形态,研究团队在多个机器人平台上进行了验证,并正在与多家人形机器人本体厂商合作,共同开发下一代更具智能化的机器人产品。同时,团队还发布了新数据集ASIMOV,用于评估和改进具身人工智能和机器人的语义安全性,以推动学术界和工业界在机器人安全方面的研究。

除国地共建具身智能机器人创新中心、谷歌DeepMind之外,微软也在2025年推出Magma,集成多模态交互与实时决策,支持语音指令直接触发物理操作。能够预判的是未来3-5年,具备多模态泛化能力、硬件兼容性和简单易部署的机器人AI Agent系统级平台将成为主流趋势,也将会成为机器人大规模落地的关键点之一。当硬件成本与使用门槛得到进一步降低,那么机器人的时代就离我们不再遥远。

目前来看,虽然机器人AI Agent的“iPhone时刻”尚未到来,但全球范围内围绕操作系统级平台的竞争已悄然启幕,中国能否在本轮竞争中保持领先优势,让我们拭目以待。

(文:机器人大讲堂)