文章转载自「宝玉 AI」

在斯坦福大学“以人为本的人工智能研究院”(Stanford HAI)看来,人工智能将成为21世纪最具变革性的技术。然而,若不谨慎引导,AI带来的好处并不会平均地惠及所有人。《AI指数》提供了目前全球最全面、最权威的数据驱动的人工智能分析,已成为全球媒体、政府和顶尖企业的重要参考,帮助决策者、商界领袖及公众更全面、客观地了解AI的技术进步、经济影响和社会意义。

我们整理了一些开发者可能会关注的点(感谢 Dia 浏览器):

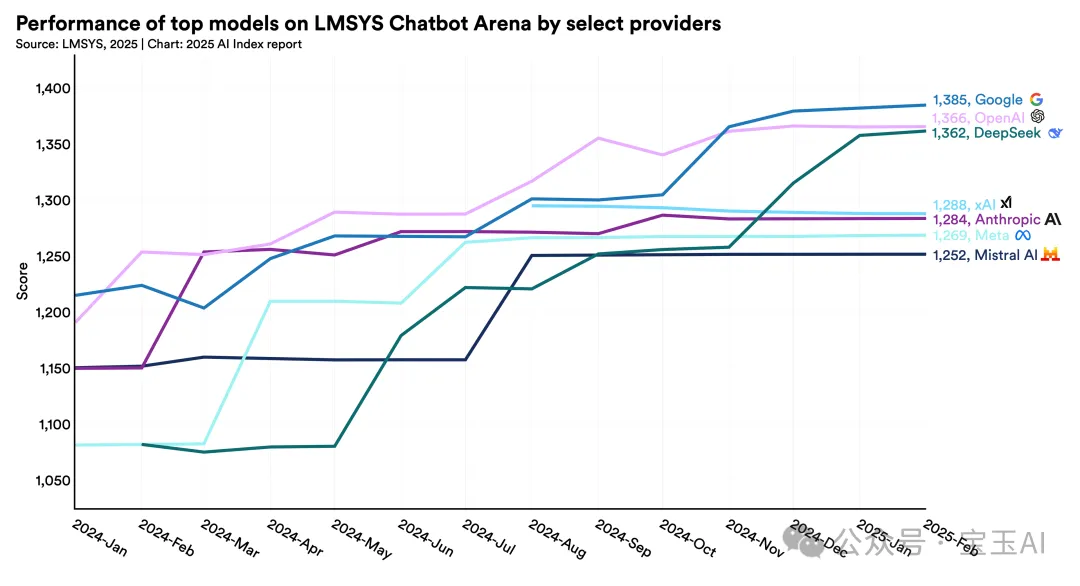

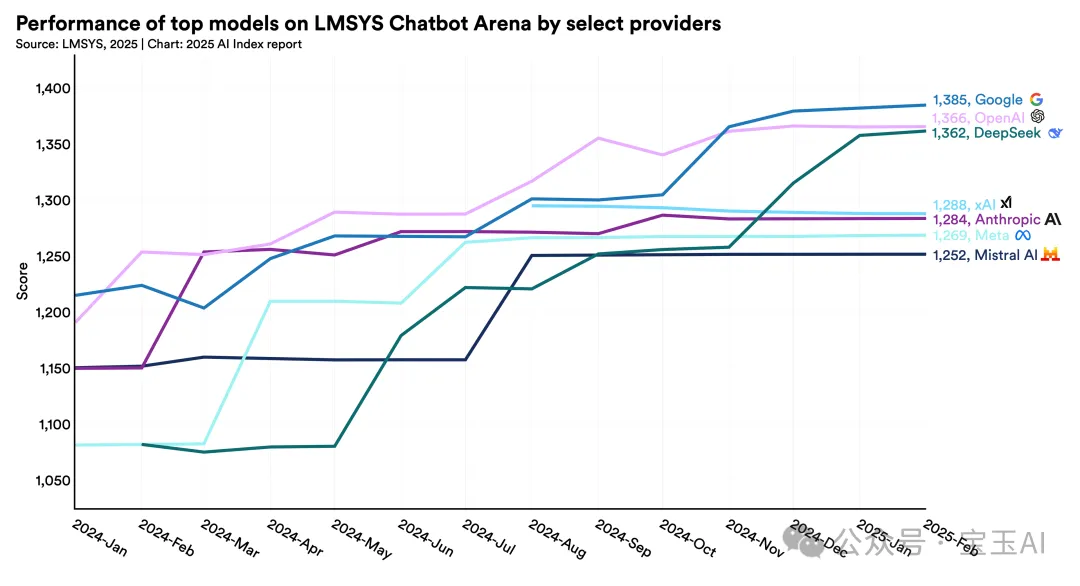

1. 模型性能“内卷”,产品体验才是出路:前十名模型的 Elo 分数差距从 11.9% 缩小到 5.4%,技术差距在快速收敛。对创业者来说,这意味着你不一定要追最新最强的模型,而是要在产品体验、上下文设计、数据调优上下功夫。用户不会记得你用了哪个模型,但会记得你是不是“用得顺”。

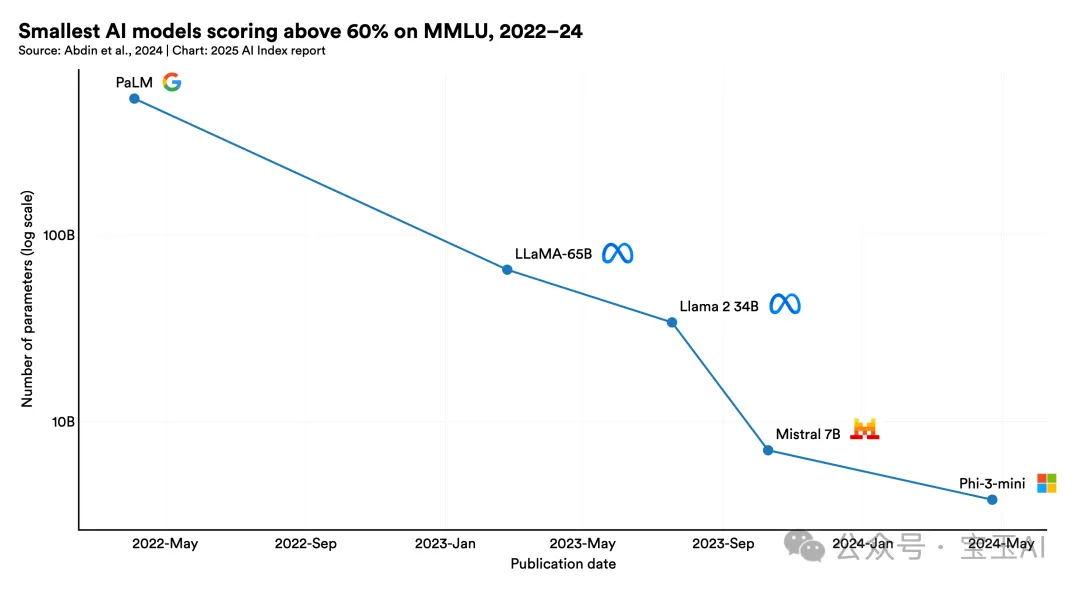

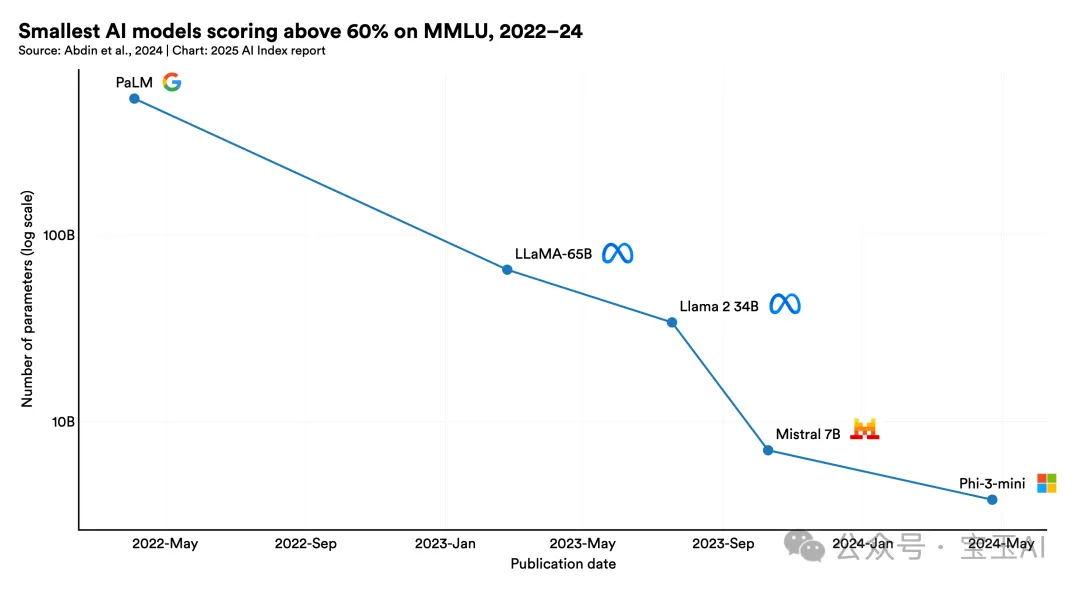

2. 小模型崛起,算力不再是主战场:Phi-3-mini 只用 38 亿参数就能打平 GPT-3.5,训练和推理成本大幅降低。创业者不再需要烧钱堆大模型,而是可以用“小而美”的模型做“快而准”的产品。模型架构优化、LoRA 微调和量化技术变得更重要。

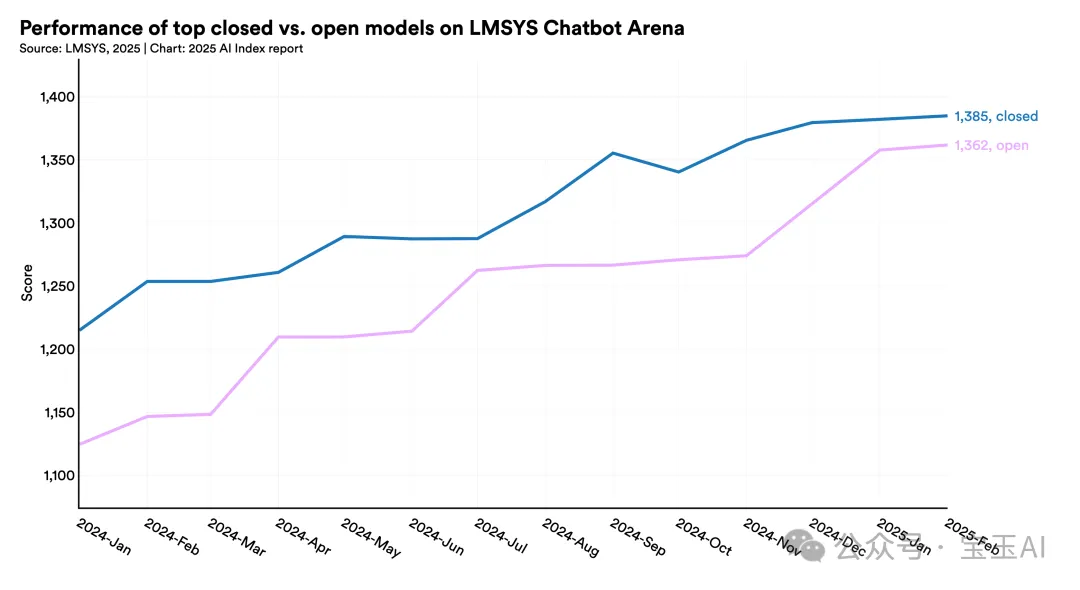

3. 开源模型“够用”,闭源不再不可替代:闭源模型在 Chatbot Arena 榜单上的领先优势已缩小到 1.7%。对创业者来说,这意味着你可以用开源模型(Mistral、Gemma、LLaMA)结合自有数据打造差异化产品,而不必依赖 OpenAI 的黑盒。

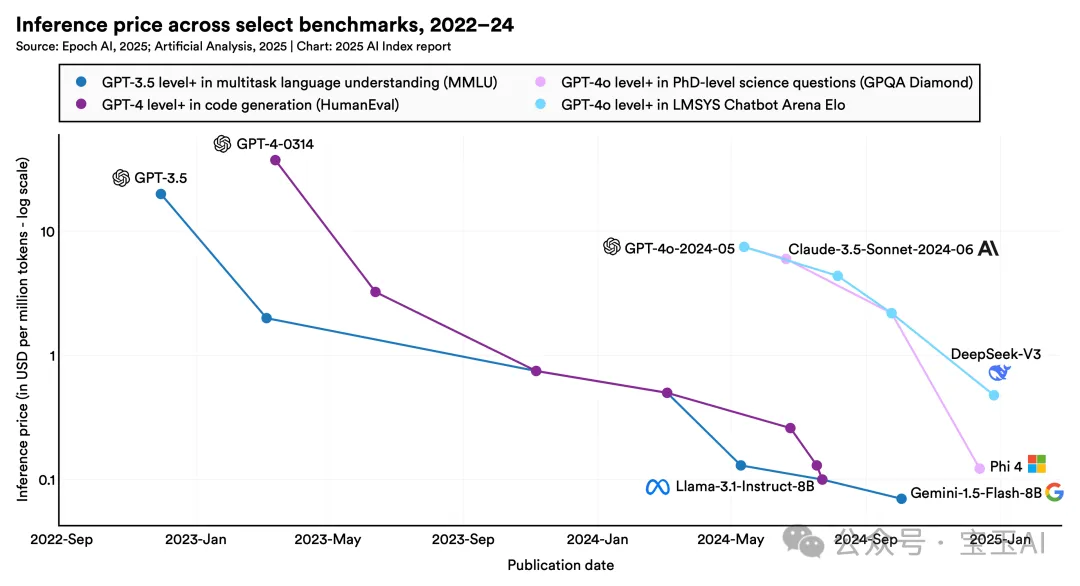

4. 推理成本暴跌,商业模式需要重算:GPT-3.5 水平的推理成本 18 个月内下降 280 倍。这不是微调,是范式转移。创业者要重新考虑定价策略、用户增长模型和单位经济模型,别再把“成本高”当作产品不赚钱的理由。

5. AI 安全成为新刚需,不只是合规问题:2024 年 AI 事故报告增长 56.4%,但大多数公司还没建立系统的防控机制。创业者如果能在安全、透明、事实性评估上做出特色,反而会成为优势,尤其在 To B 市场。

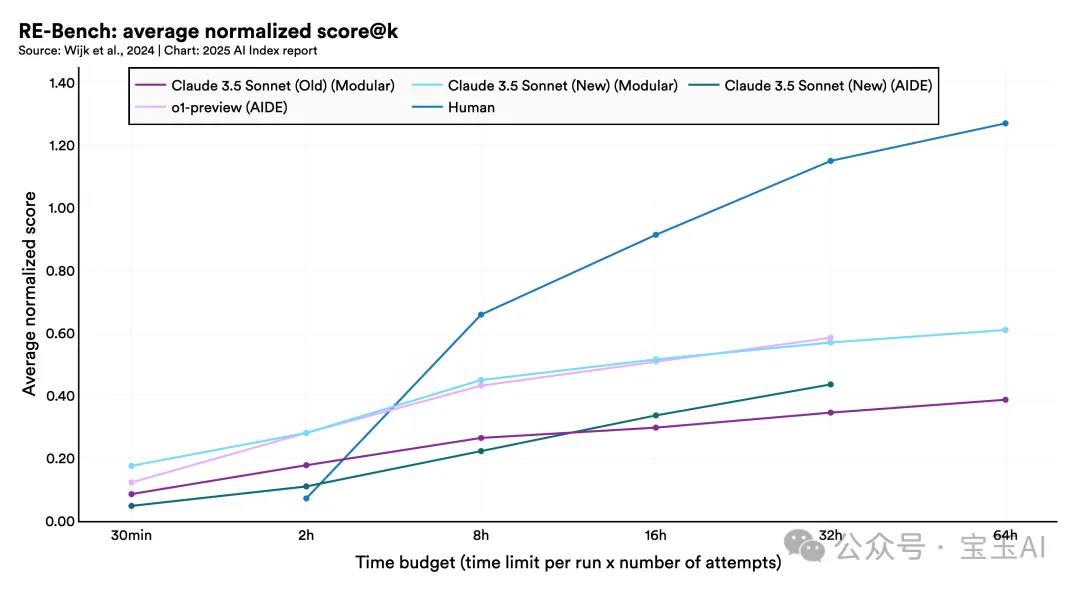

6. AI 智能体适合短任务,不适合长流程:RE-Bench 显示,AI 智能体在 2 小时任务中表现远超人类,但一旦任务拉长到 32 小时,人类反超 2 倍。对创业者来说,别幻想“万能 AI 助理”,而应专注于结构化、任务边界清晰的场景。

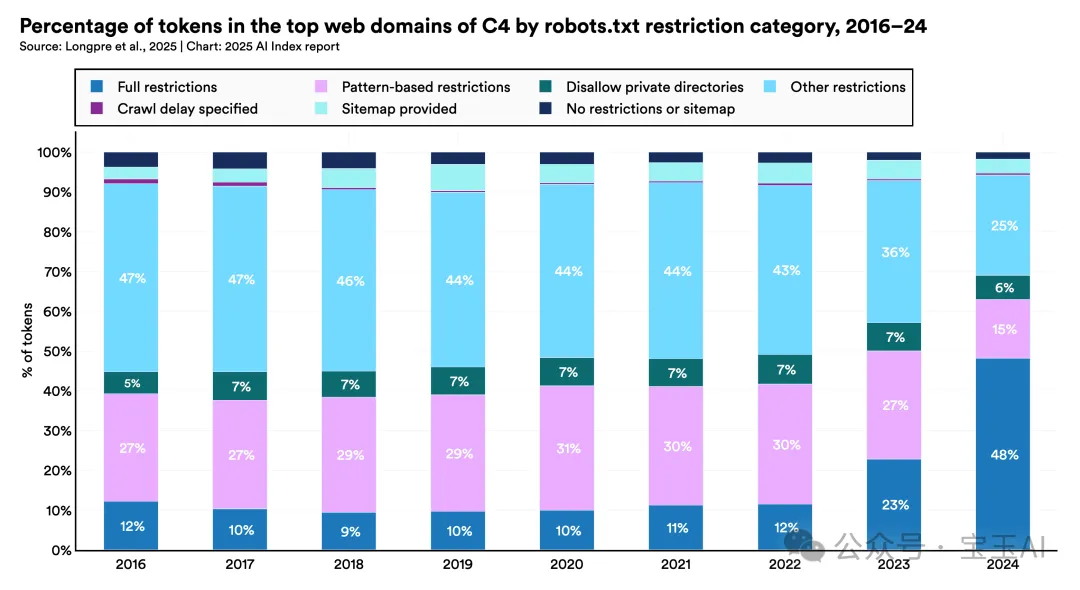

7. 数据将成为下一个瓶颈 C4 数据集中限制抓取网页比例从 5% 飙升到 33%。开源数据资源在快速枯竭,创业者不能再依赖“爬全网”来训练模型。谁能掌握垂直数据、谁就能做出更聪明的 AI。

8. AI 落地更快,但 ROI 尚未兑现:78% 企业已使用 AI,但多数企业反馈节省成本不足 10%、营收提升低于 5%。这对创业者是提醒:AI 能力 ≠ 商业价值,找到“高频刚需+结构清晰”的场景才是关键。

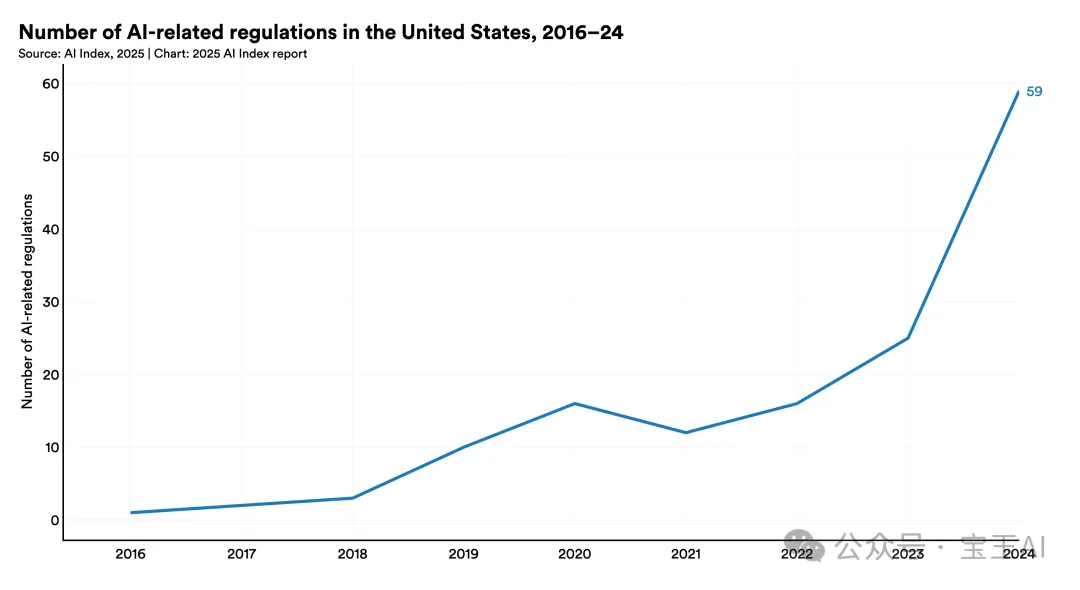

9. 监管加速,合规将成为产品设计的一部分 全球 AI 法规数量一年翻倍,美国联邦机构发布 59 项新规。对创业者来说,合规不再是上线后的“补作业”,而是产品设计之初就要考虑的“前置模块”。

10. AI 创业的“非共识”红利正在消失:开源模型、算力成本、数据获取、监管合规……这些过去创业者可以“钻空子”的地方,正在被快速标准化。接下来,拼的是执行力、洞察力和节奏感,而不是“卡位”。

-

高浓度的主流模型(如 DeepSeek 等)开发交流;

-

资源对接,与 API、云厂商、模型厂商直接交流反馈的机会;

-

好用、有趣的产品/案例,Founder Park 会主动做宣传。

01

报告要点一览

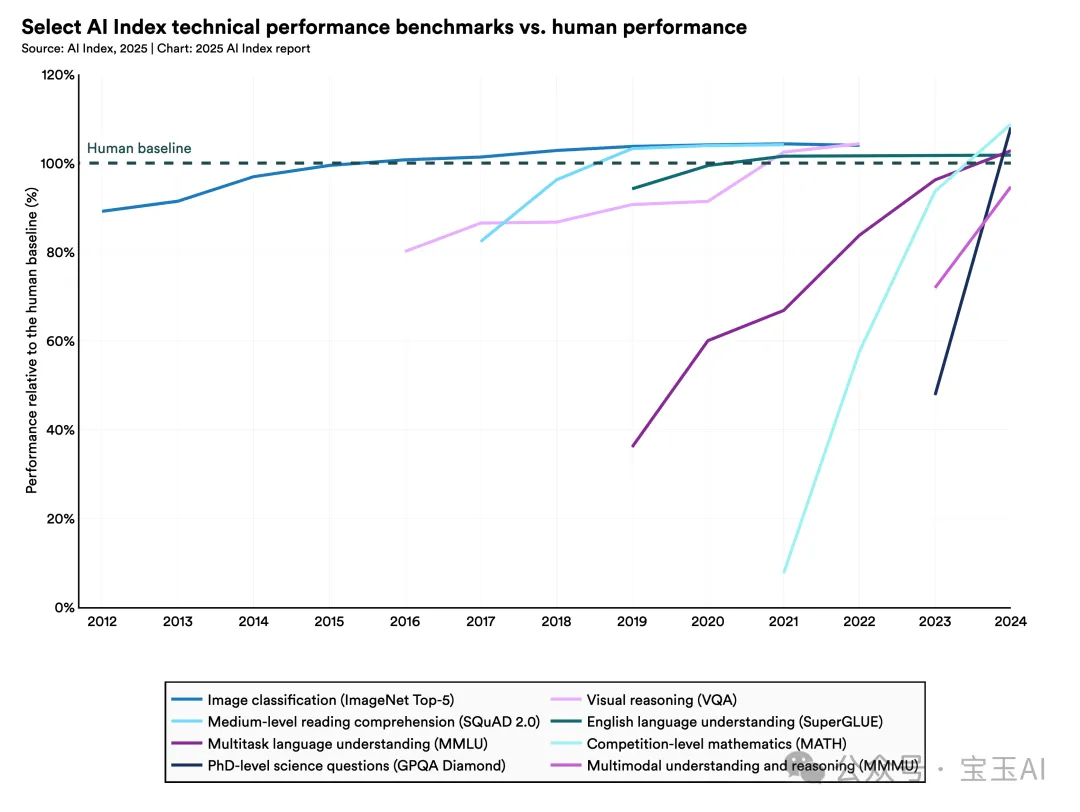

1. 人工智能在复杂任务上的表现持续提升。

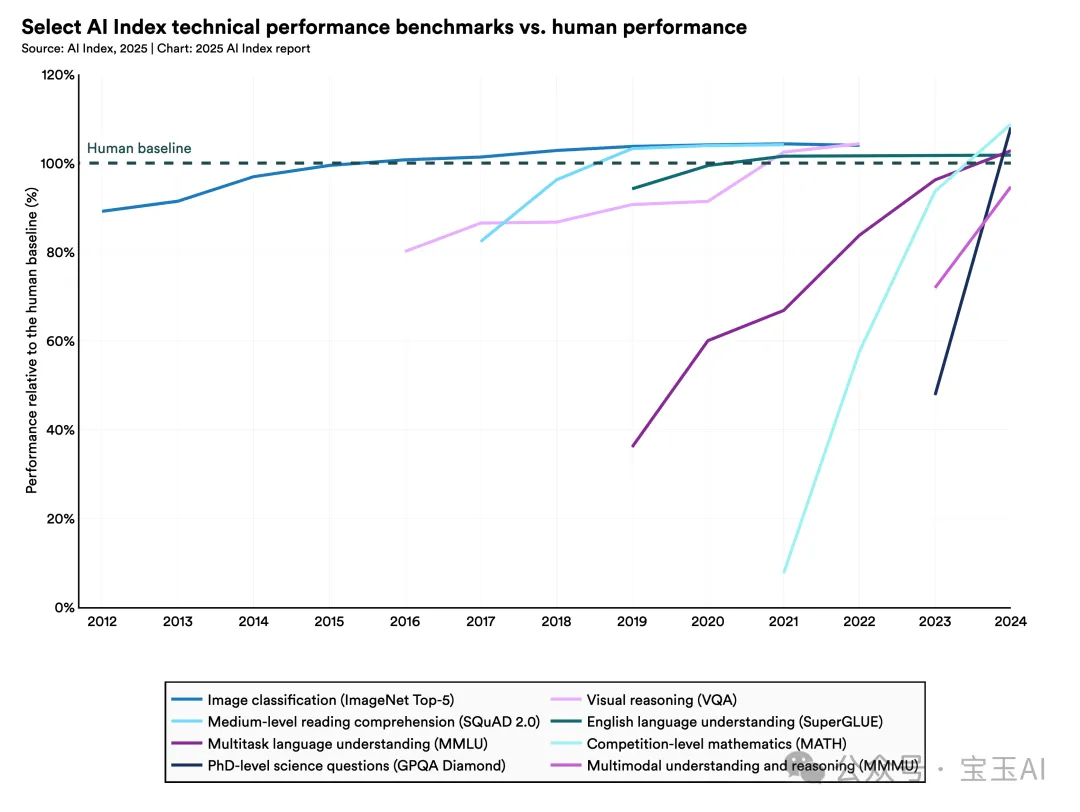

2023年,研究人员推出了新的AI性能测试基准——MMMU、GPQA和SWE-bench,仅一年后,AI在这些测试中的表现大幅提升,得分分别增长了18.8、48.9和67.3个百分点。除基准测试外,AI在生成高质量视频方面也取得重大进展。在某些场景中,语言模型在编程任务上的表现甚至超过了有时间限制的人类程序员。

2. AI正越来越深入人们的日常生活。

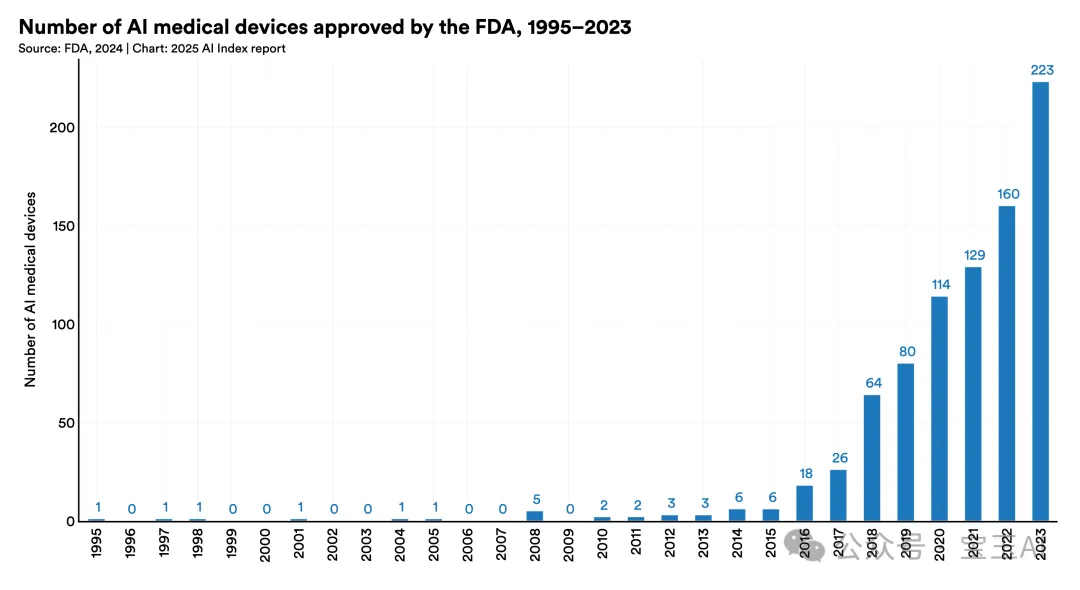

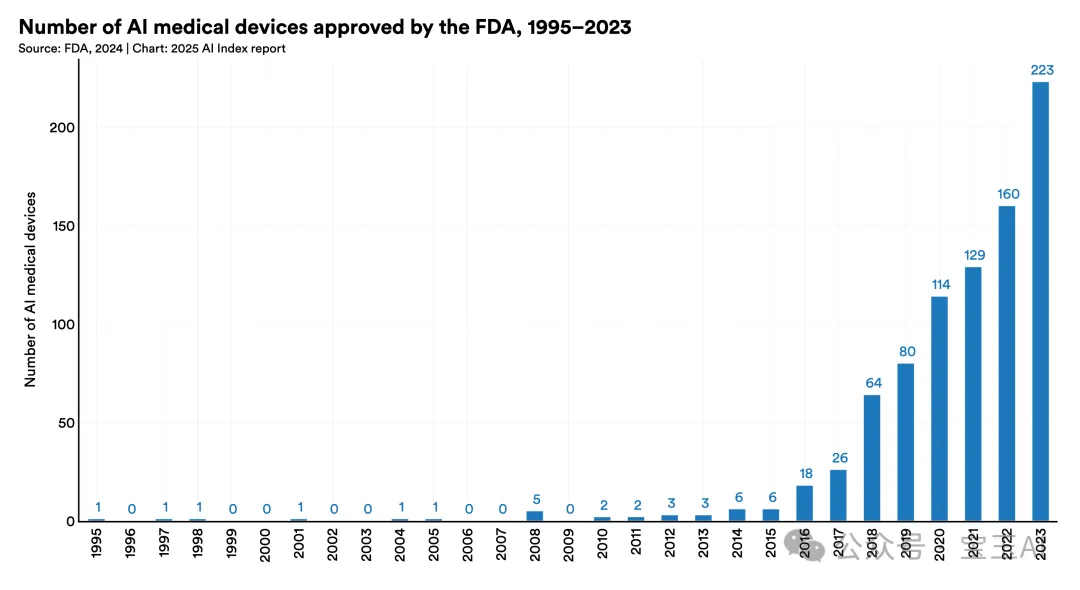

从医疗到交通,AI技术迅速从实验室走向现实生活。2023年,美国食品药品监督管理局(FDA)批准了223个AI医疗设备,而2015年时仅为6个。在道路上,自动驾驶不再只是实验:美国规模最大的自动驾驶公司之一Waymo每周提供超过15万次无人驾驶服务。中国百度公司的Apollo Go无人出租车也以更亲民的价格进驻多个城市。

3. 商业界全面拥抱AI,投资创历史新高,AI促进生产力的作用持续被验证。

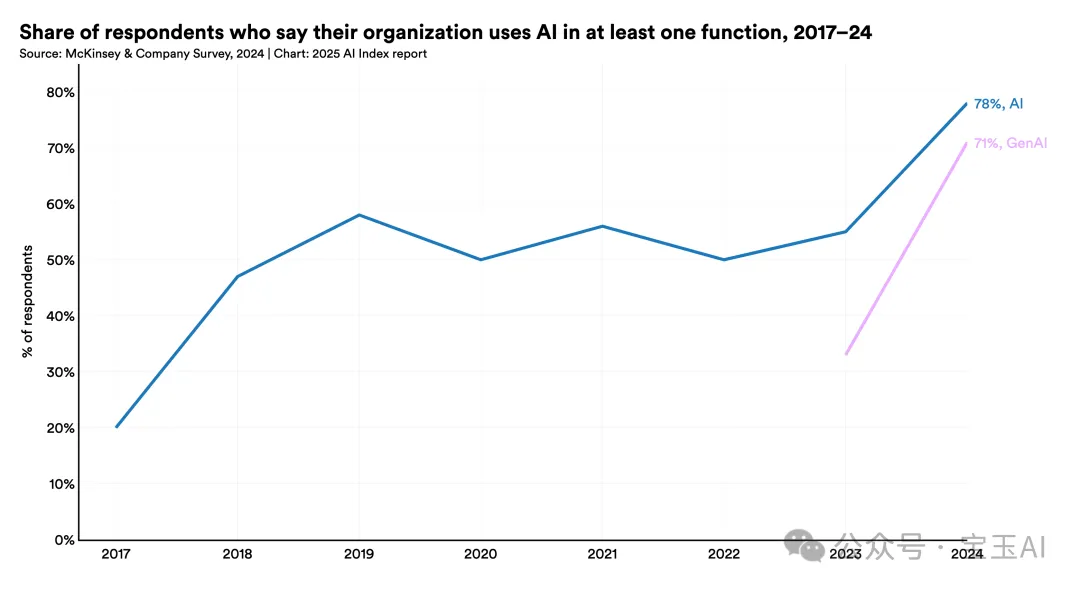

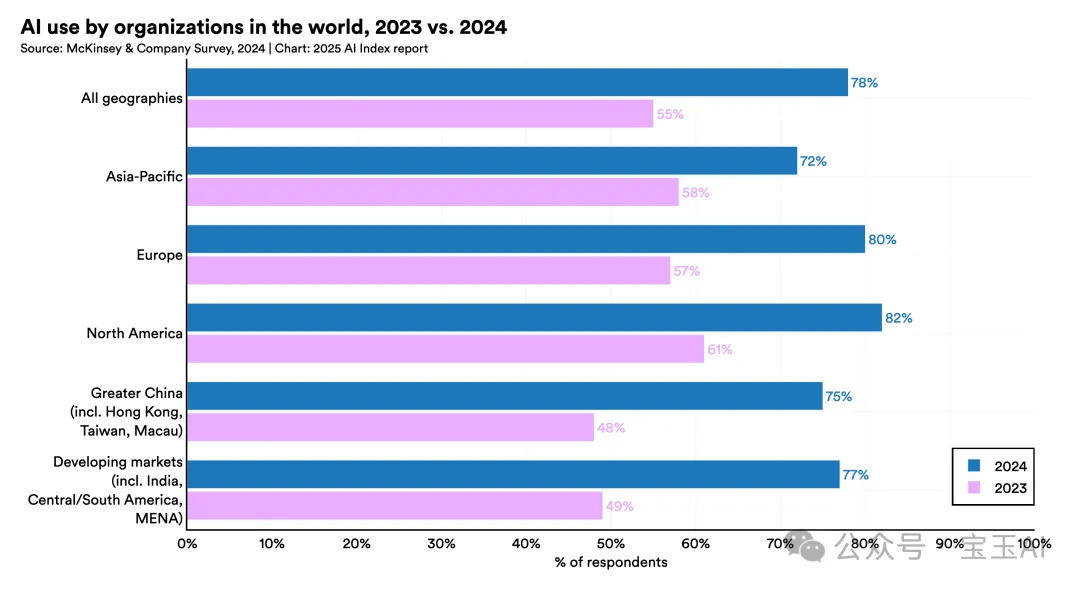

2024年,美国私营部门在AI领域的投资达到1091亿美元,几乎是中国(93亿美元)的12倍、英国(45亿美元)的24倍。其中,生成式AI尤其受到资本青睐,全球私营投资达339亿美元,比2023年增长了18.7%。企业对AI的应用也迅速增加:2024年78%的企业报告已使用AI,较2023年的55%明显提升。同时,越来越多研究显示,AI显著提高了生产效率,并帮助员工缩小技能差距。

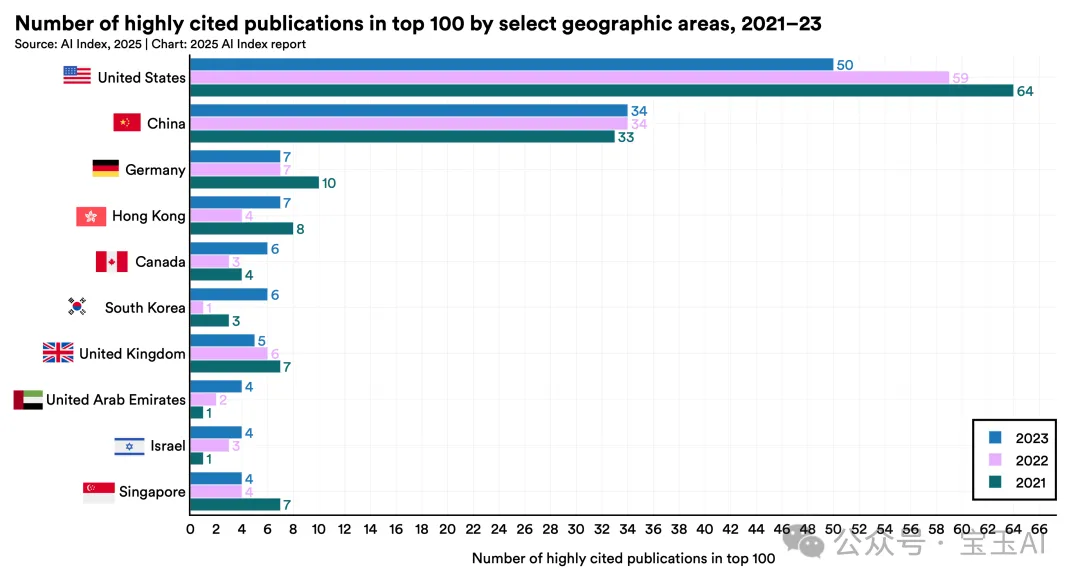

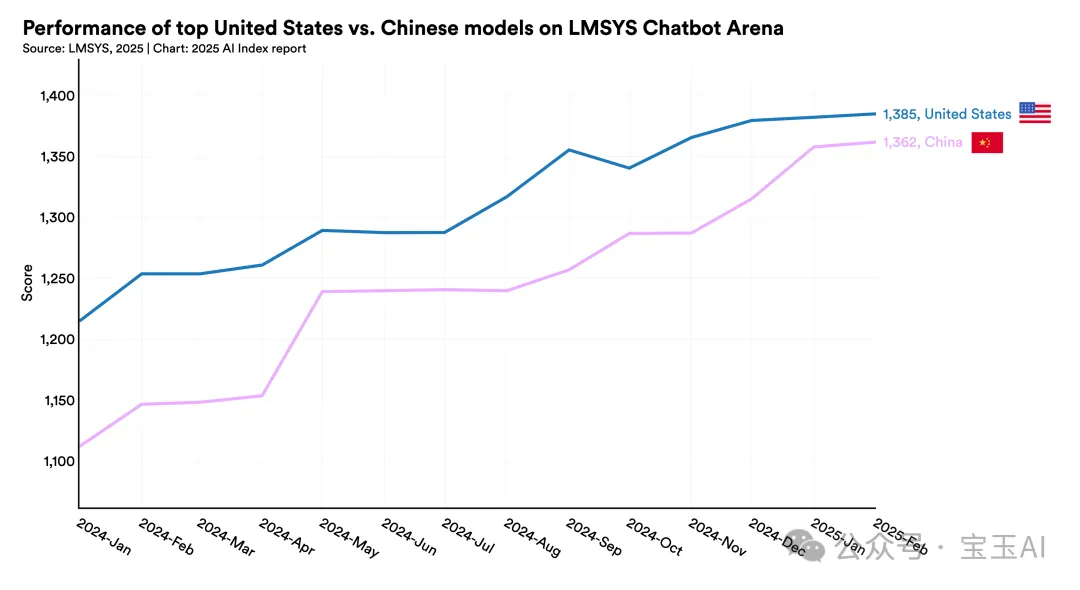

4. 美国仍是顶尖AI模型研发的领跑者,但中国正迅速缩小差距。

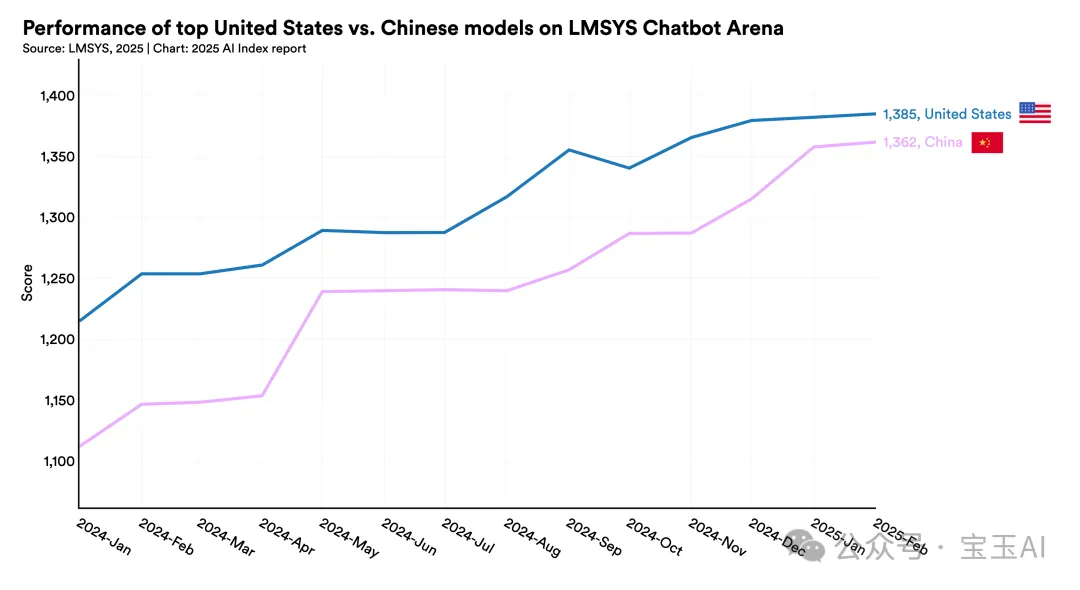

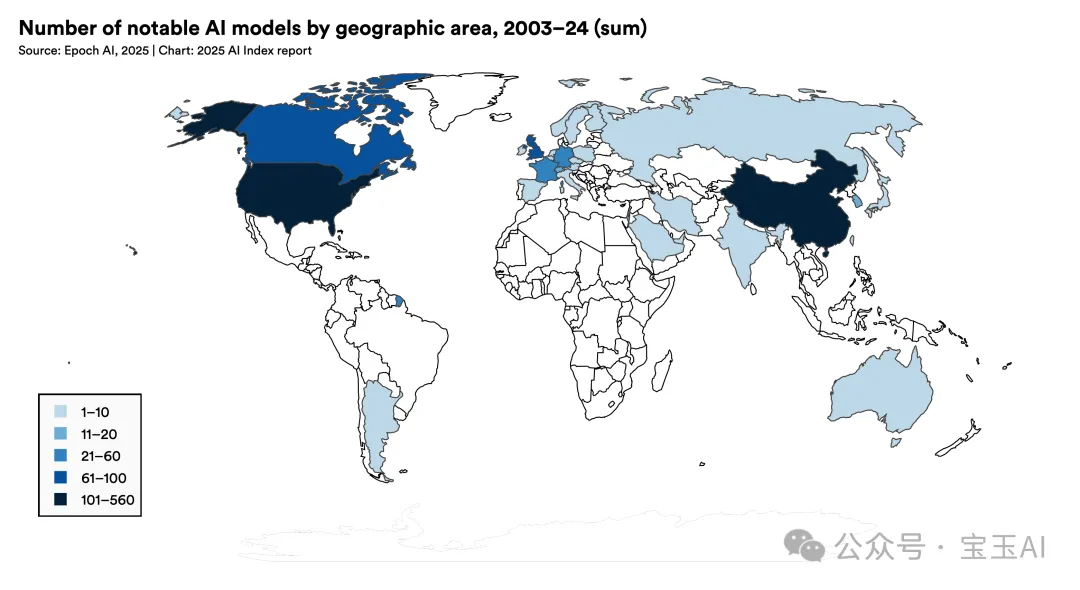

2024年,美国机构发布了40个有重大影响的AI模型,远超中国的15个和欧洲的3个。但在性能表现上,中国与美国的差距迅速缩小:主要测试基准(如MMLU和HumanEval)的性能差距从2023年的两位数下降到2024年的几乎相同。同时,中国在AI学术论文发表量和专利数量方面继续领先全球。此外,中东、拉美、东南亚地区也开始出现有影响力的模型,全球化趋势明显。

5. 负责任的AI生态系统建设取得进展,但并不平衡。

AI相关的事故事件显著增加,但工业界在AI安全和事实性评估方面的标准化仍然不足。不过,HELM Safety、AIR-Bench和FACTS等新基准的出现提供了有效的评测工具。企业普遍承认负责任AI的重要性,但实际行动仍相对滞后。相比之下,各国政府对AI治理展现更大紧迫感。2024年,包括经合组织、欧盟、联合国、非洲联盟在内的国际机构相继发布了透明性、可信度等AI治理框架。

6. 全球对AI的乐观情绪普遍上升,但地区差异明显。

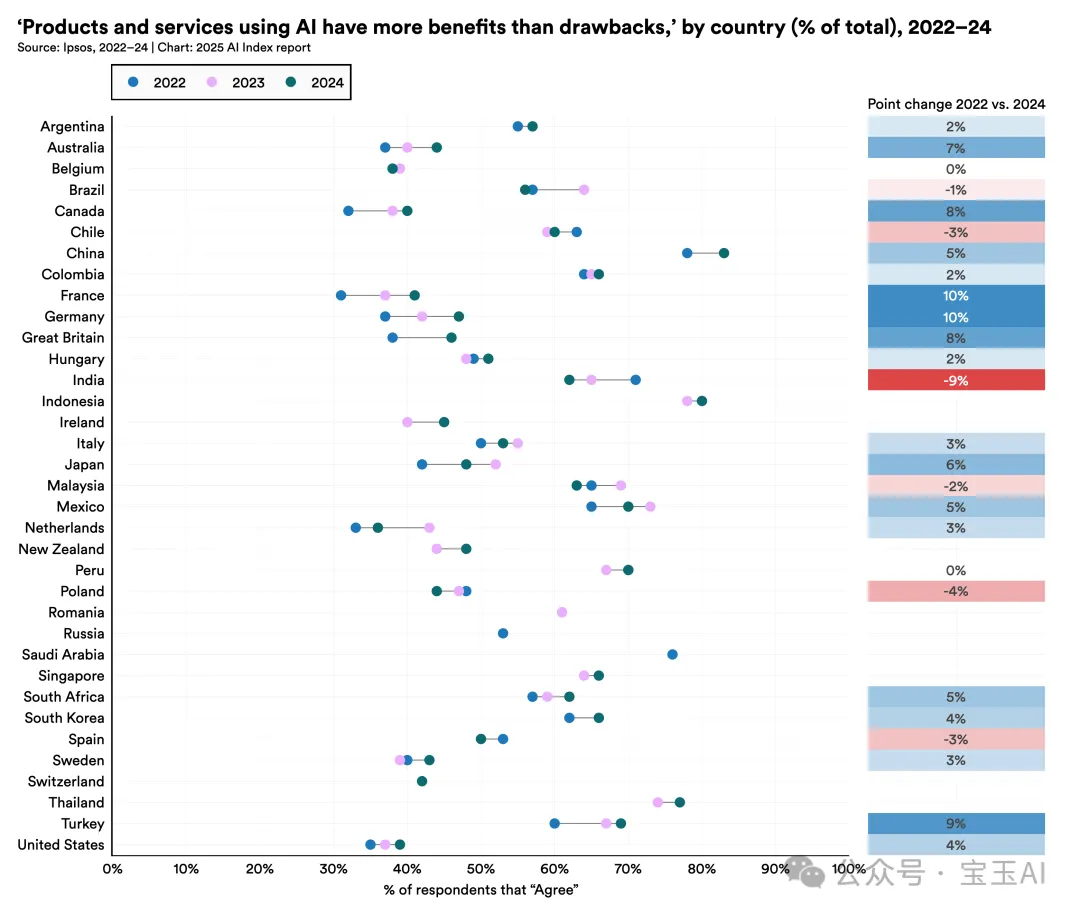

中国(83%)、印尼(80%)和泰国(77%)等国家多数民众认为AI带来的益处大于风险。然而,加拿大(40%)、美国(39%)和荷兰(36%)则明显更为谨慎。不过,这种看法也在逐渐变化,2022年以来,德国、法国、加拿大、英国和美国对AI的乐观情绪明显提升。

7. AI日趋高效、平价且更易获得。

由于小模型的迅速进步,2022年11月至2024年10月期间,类似GPT-3.5级别系统的推理成本降低了280倍以上。在硬件方面,每年成本下降30%,能源效率每年提高40%。开源模型和闭源模型的性能差距也快速缩小,一些基准上的差距在一年内从8%降至1.7%。这些趋势大大降低了先进AI技术的进入门槛。

8. 全球政府加强AI监管和投资力度。

2024年,美国联邦机构发布了59项AI相关的监管措施,是2023年的两倍多,涉及的政府机构数量也翻倍增加。全球75个国家的立法中提及AI的频率比2023年增长21.3%,较2016年增长了9倍。与此同时,各国政府也在大规模投资AI:加拿大投入24亿美元,中国启动475亿美元的芯片基金,法国承诺1090亿欧元,印度投入12.5亿美元,沙特的“超越计划”则达到1000亿美元。

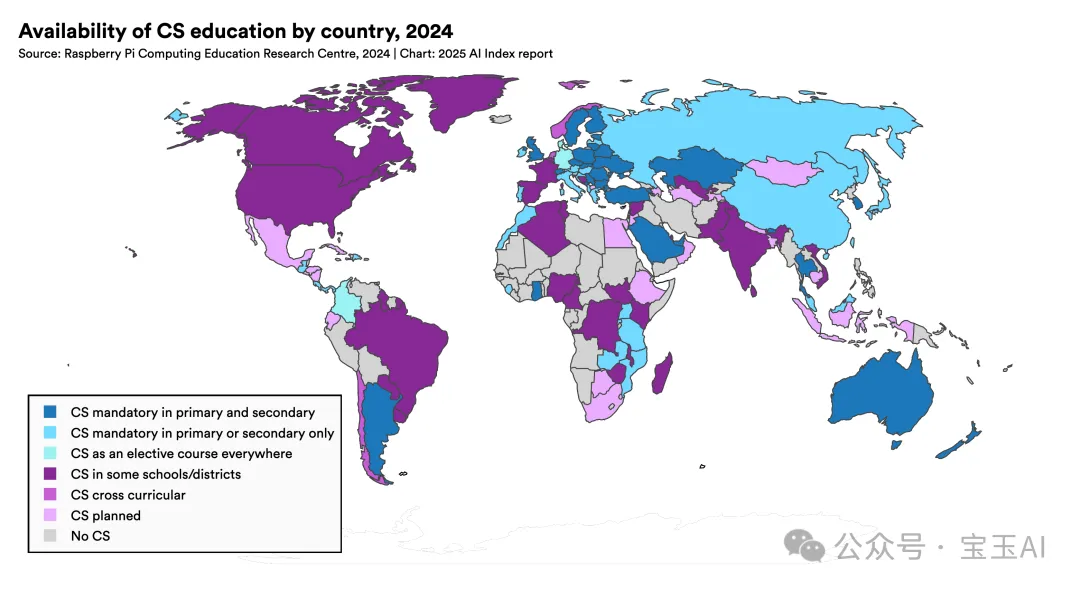

9. AI与计算机科学教育加速普及,但教育资源分布仍不均衡。

全球三分之二国家已实施或计划实施从幼儿园到高中的计算机科学教育,数量比2019年翻倍,其中非洲和拉美地区进步最快。在美国,过去十年计算机本科毕业生增加了22%。但非洲许多国家仍面临电力基础设施等基本问题的限制。在美国,81%的中小学计算机老师认为应将AI纳入基础教育,但只有不到一半的教师觉得自己做好了相关的教学准备。

10. 工业界在AI发展中领先,但前沿竞争更加激烈。

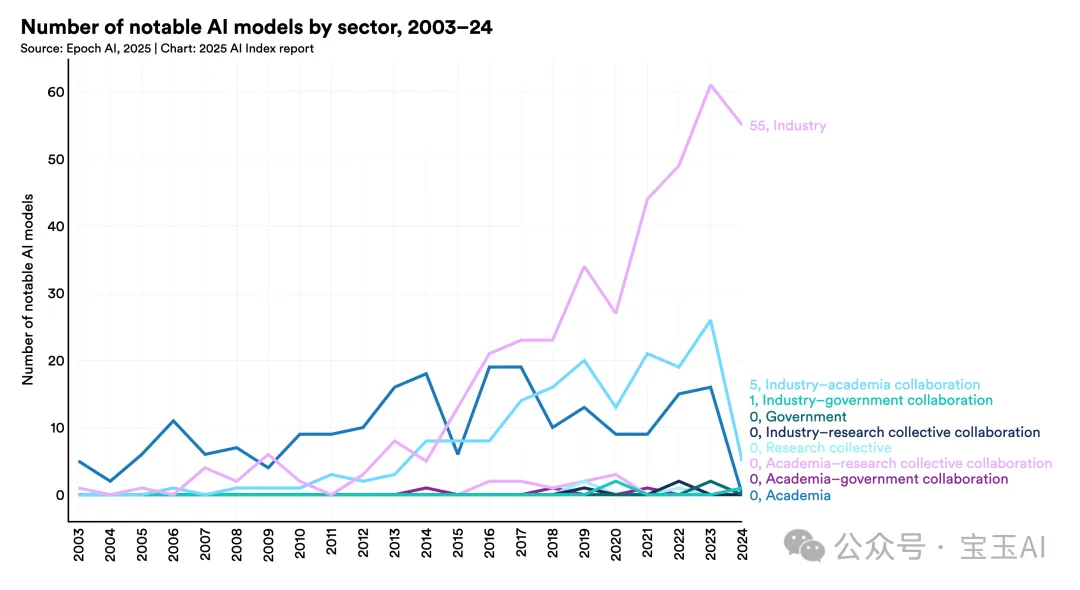

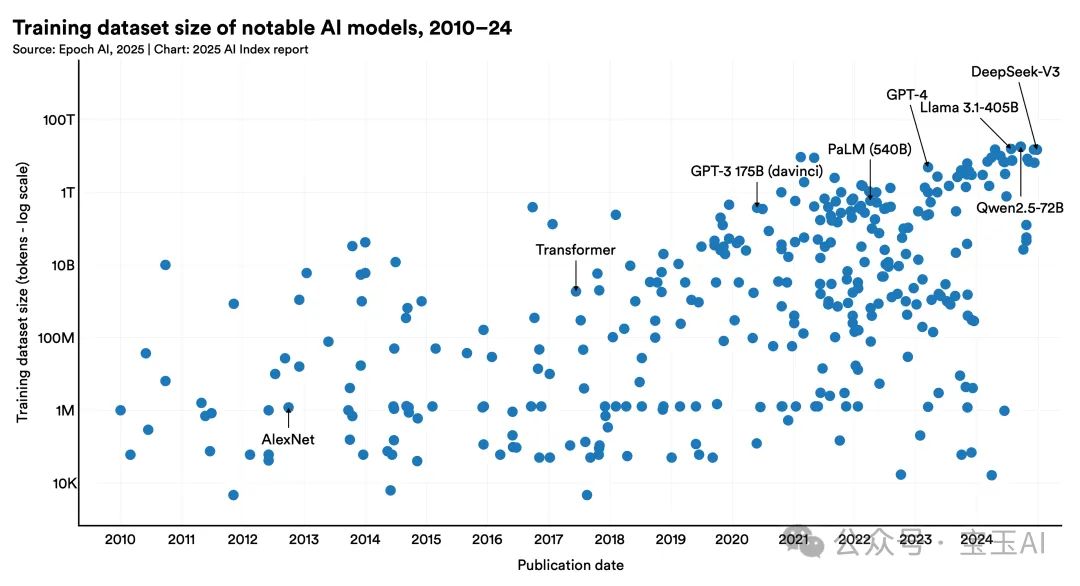

2024年接近90%的重要AI模型来自工业界,而2023年这一数字为60%。尽管模型规模快速增长,训练计算量每5个月翻一倍,数据集每8个月翻倍,能耗每年翻倍,但领先模型之间的性能差距明显缩小:排名第1和第10名模型的性能差距从11.9%缩减到5.4%,排名前两名模型之间仅差0.7%。AI研发前沿的竞争更加激烈,也更拥挤。

11. AI对科学的贡献赢得全球最高荣誉。

AI在科学界的影响日益显著,两项诺贝尔奖分别颁发给深度学习(物理奖)和蛋白质折叠应用(化学奖)领域的贡献。图灵奖也表彰了强化学习领域的突破性研究。

12. AI仍在复杂推理任务上面临挑战。

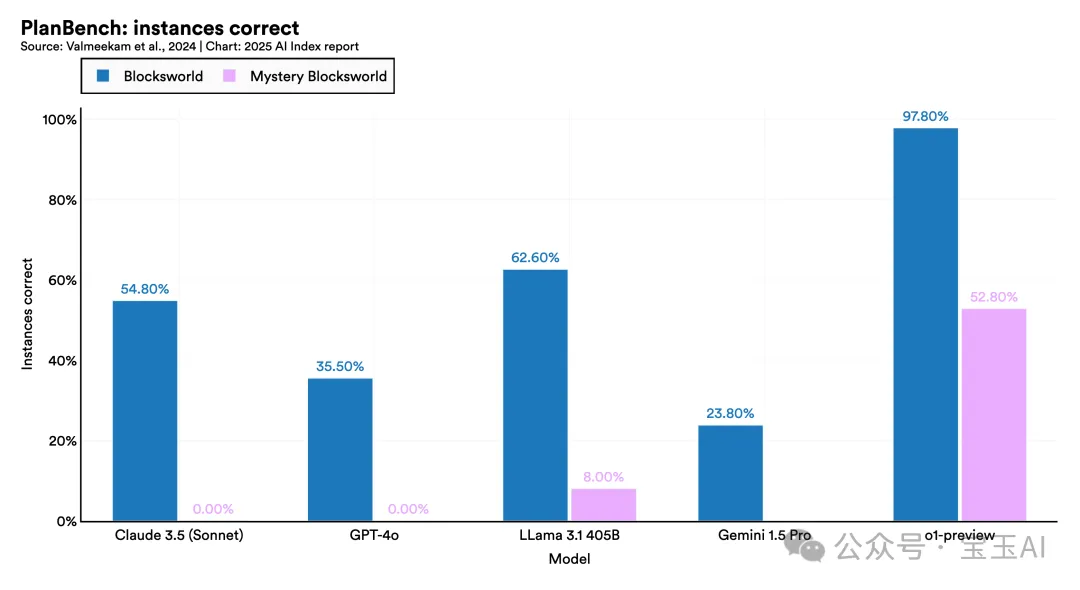

尽管AI模型能够很好地完成国际数学奥林匹克竞赛题,但在复杂推理测试(如PlanBench)中依然表现欠佳。即使存在明确的逻辑解法,AI也经常无法稳定可靠地完成任务,这制约了它们在高风险、精度至关重要领域的应用潜力。

02

第一章:

AI的研究与发展趋势

1. 工业界持续领跑AI模型研发,学术界则在高影响力论文方面优势明显

在过去几年中,工业界在AI模型开发方面一直保持领先优势,并且这种趋势愈发明显。2024年,接近90%的重要AI模型都来自工业界,而在2023年这一比例为60%。尽管如此,学术界仍然主导着被高度引用(前100名)的研究论文,连续三年保持第一。

2. 中国AI论文发表总量领先,美国主导高影响力研究

2023年全球共发布了149个基础模型,比2022年增加一倍以上。在这些新发布的模型中,开源模型的比例达到了65.7%,而2022年仅为44.4%,2021年更低至33.3%。

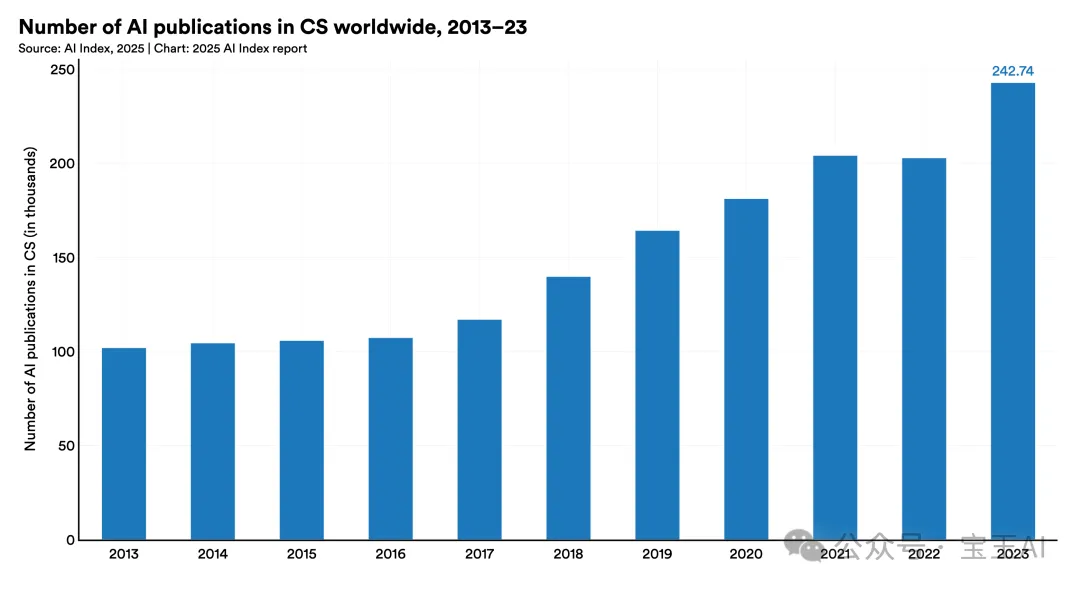

3. AI相关论文持续增长,在计算机科学中占据越来越重要的地位

2013年至2023年间,人工智能相关论文总量几乎翻了三倍,从约10.2万篇增加到超过24.2万篇。AI论文在计算机科学领域的占比,也从2013年的21.6%上升到了2023年的41.8%,可见AI研究在学术领域影响力的大幅提升。

4. 美国持续引领全球AI模型研发的前沿

2024年,美国机构发布了40个重要AI模型,明显领先于中国的15个和欧洲合计仅3个。过去十年,美国在AI模型开发方面一直保持全球领先地位。

5. AI模型规模越来越大,计算需求与能耗显著增长

最新研究发现,著名AI模型的训练计算量大约每5个月就翻一倍;用于训练大语言模型的数据集大小,每8个月翻倍;训练所需的电力消耗每年翻一倍。这些趋势背后的驱动力主要来自于工业界的大规模投资,不断推动模型性能提升。

6. 使用AI模型的成本快速下降

AI模型的使用成本急剧降低。以达到GPT-3.5(MMLU基准得分64.8)性能水平的模型为例,每百万Token的查询成本从2022年11月的20美元大幅降至2024年10月的仅0.07美元(以Gemini-1.5-Flash-8B为例),18个月内成本降低超过280倍。具体任务的推理成本,每年下降幅度介于9倍至900倍之间。

7. AI领域的专利数量显著增加,中国领先全球

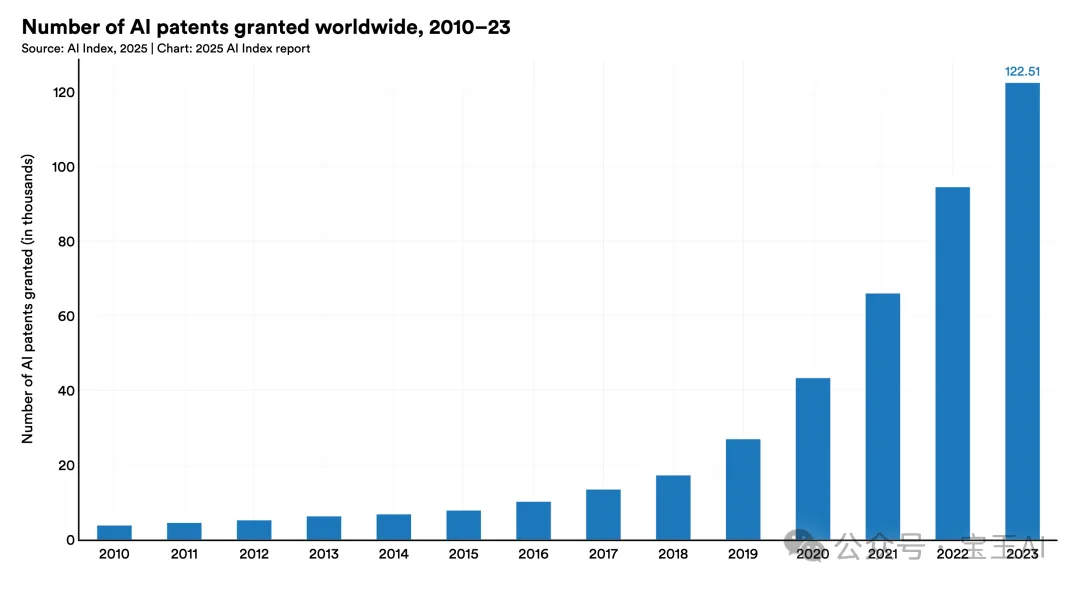

2010年至2023年间,全球AI专利的数量从3,833件迅速增长到122,511件。仅过去一年,AI专利数增长了29.6%。截至2023年,中国在AI专利总量上占据绝对优势,占全球专利总数的69.7%。此外,从人均AI专利数量来看,韩国和卢森堡表现突出。

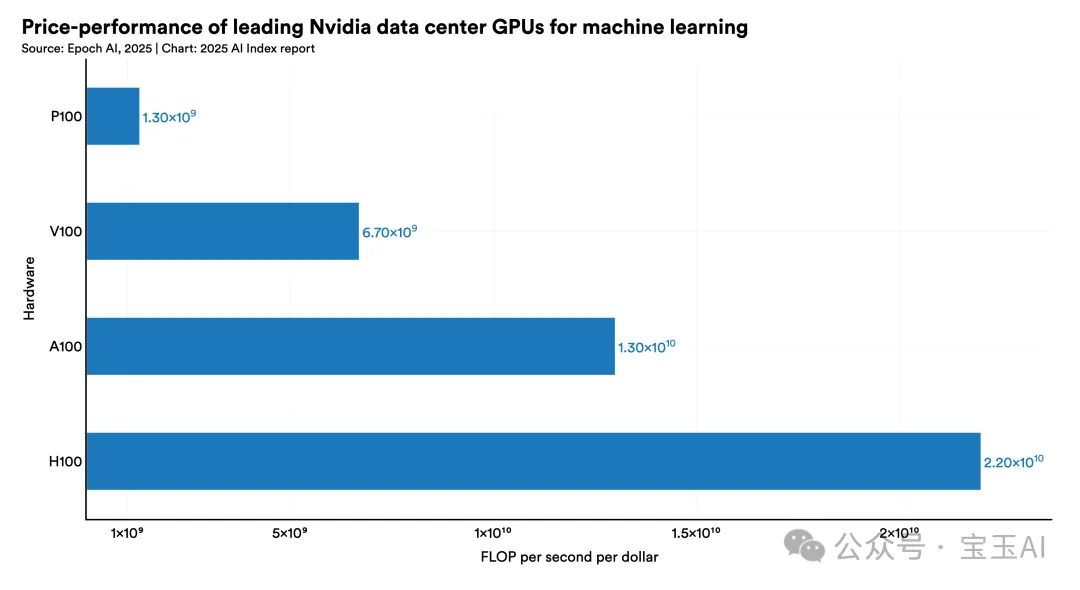

8. AI硬件变得更快、更便宜、更节能

研究表明,AI专用硬件(以16位浮点运算性能为标准)的性能每年增长43%,约每1.9年性能翻一倍。同时,价格性能每年改善30%,能效也每年提升40%,使得AI应用的成本持续降低。

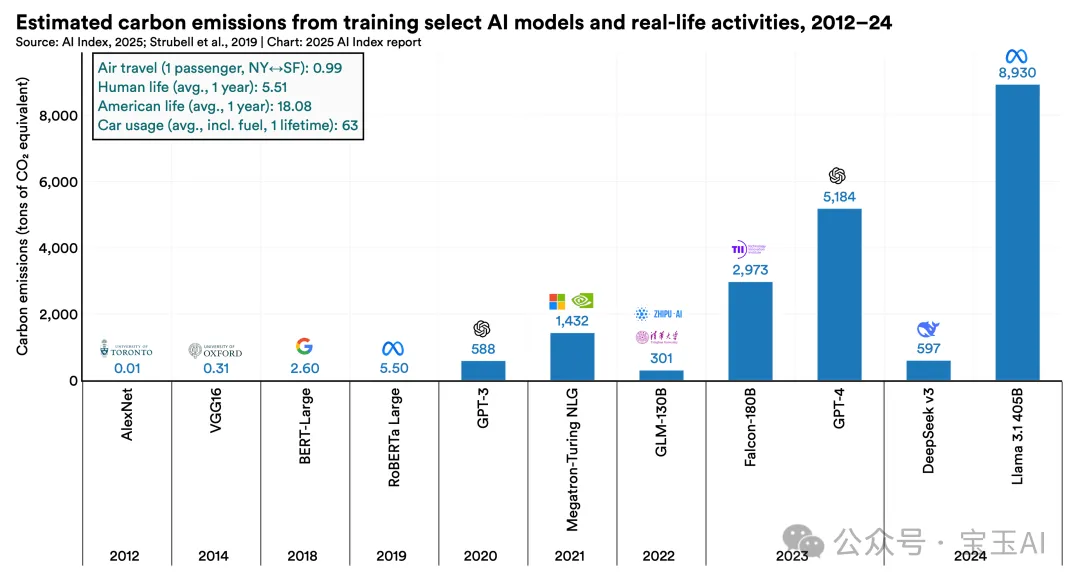

9. AI模型训练带来的碳排放量逐年增加

早期AI模型(如2012年的AlexNet)训练产生的碳排放量仅为0.01吨,而近年来的模型则急剧上升。例如,2020年的GPT-3训练碳排放量达到588吨,2023年GPT-4更达5,184吨,2024年最新的Llama 3.1 405B模型高达8,930吨。作为参考,一个普通美国人每年的碳排放量约为18吨。

03

第二章:技术表现

1. AI突破新基准的速度史无前例

2023年,研究人员推出了一系列全新的AI性能基准,包括MMMU、GPQA 和 SWE-bench,专门用来挑战越来越强大的AI系统。到2024年,AI在这些测试中的表现突飞猛进:MMMU提高了18.8个百分点,GPQA更是飙升了48.9个百分点。在SWE-bench编程测试中,AI系统2023年只能解决4.4%的问题,但到了2024年,这一数字猛增到了惊人的71.7%。

2. 开放模型迅速追赶闭源模型

去年AI指数指出,开源模型的表现远落后于闭源模型。然而,到2024年,这个差距已几乎消失。2024年1月初,领先的闭源模型在Chatbot Arena排行榜上的表现比顶级开源模型高8.04%。到2025年2月,这个差距缩小到了仅1.70%。

3. 中美AI模型性能差距逐渐消失

2023年,美国顶尖AI模型的性能远超中国模型,但到了2024年,这种差距大幅缩小。在MMLU、MMMU、MATH和HumanEval等测试中,2023年中美模型的性能差距分别为17.5、13.5、24.3和31.6个百分点,到2024年底分别缩小至仅0.3、8.1、1.6和3.7个百分点。

4. AI模型表现趋于一致,竞争加剧

根据去年AI指数报告,Chatbot Arena排行榜上第一名与第十名之间的Elo评分差距曾高达11.9%。到2025年初,这一差距已缩小到仅5.4%。同样地,前两名之间的差距也从2023年的4.9%下降到了2024年的0.7%。AI领域竞争越来越激烈,涌现了更多开发者提供的高质量模型。

5. 测试时计算等新推理模式提升性能

2024年,OpenAI推出了名为o1和o3的AI模型,这些模型能够通过多次迭代的推理方法改善结果。这种“测试时计算”的新方法显著提高了表现。比如,在国际数学奥林匹克竞赛资格考试中,o1模型的得分高达74.4%,远高于GPT-4o的9.3%。然而,这种高水平推理也带来了代价:o1模型的成本是GPT-4o的近六倍,运行速度则慢了30倍。

6. 挑战难度更高的新基准不断出现

随着传统基准(如MMLU、GSM8K、HumanEval)逐渐被突破,MMMU和GPQA等新测试表现越来越好,研究人员开始探索更难的新测试,比如:

-

“人类终极考试”(Humanity’s Last Exam):目前表现最好的AI系统得分仅为8.80%。 -

FrontierMath:专门用于复杂数学问题的测试,AI成功率只有2%。 -

BigCodeBench:AI的代码生成测试,目前成功率为35.5%,远低于人类97%的水平。

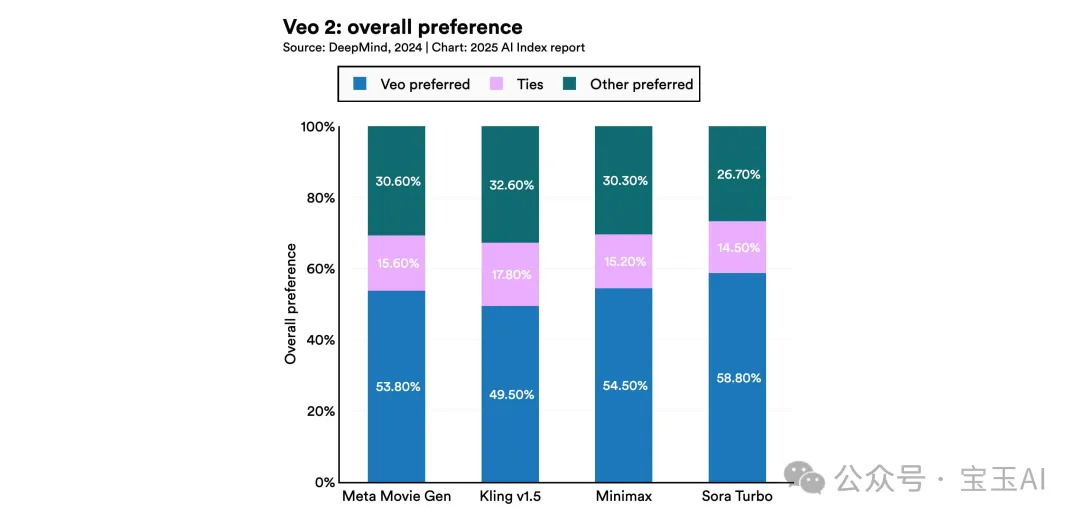

7. 高质量AI视频生成器大幅进步

2024年,多个先进的AI视频生成模型问世,包括OpenAI的SORA、Stable Video Diffusion 3D/4D、Meta的Movie Gen,以及Google DeepMind的Veo 2。这些模型能够根据文字输入生成更逼真、更高质量的视频,相较2023年有了显著提升。

8. 小型模型展现强大性能

2022年,能够在MMLU测试中达到60%以上分数的最小模型是拥有5400亿参数的PaLM。然而,到了2024年,微软的Phi-3-mini仅需38亿参数就能实现这一表现——短短两年时间内,参数量缩减了142倍。

9. 复杂推理问题仍未完全解决

尽管使用“思维链”等推理方法极大地提升了大型语言模型(LLM)的表现,但这些系统仍然无法可靠地解决逻辑推理问题,比如算术和规划,尤其是在遇到比训练数据更复杂的情况时尤为明显。这对AI的可靠性和在高风险应用场景中的适用性产生了重大影响。

10. AI智能体初步展现潜力

2024年,推出了名为RE-Bench的测试平台,专门评估AI智能体完成复杂任务的能力。在短期任务(2小时内)中,顶尖AI系统的表现是人类专家的4倍,但随着任务持续时间延长到32小时,人类专家的表现则反超AI达2倍之多。然而,在某些任务上(如编写Triton内核),AI智能体的表现已能匹敌人类专家,且更快速、更低成本。

04

第三章:负责任的AI(Responsible AI)

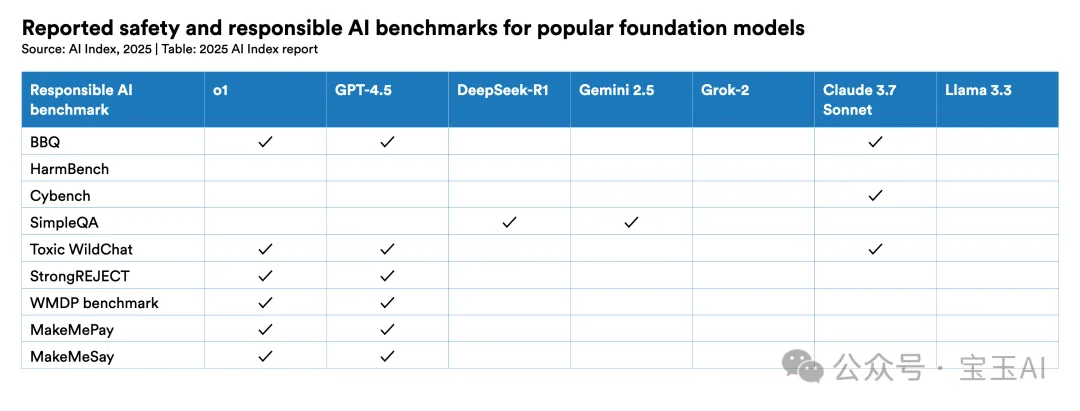

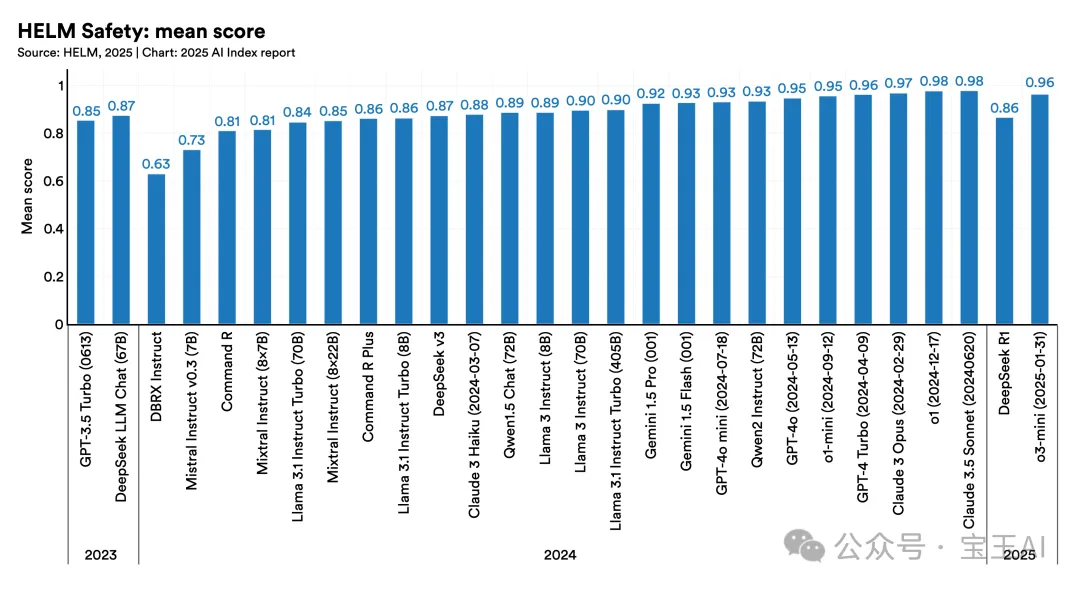

1. 用负责任AI标准评估AI系统还不普遍,但新的基准逐渐兴起。

去年AI指数曾指出,大语言模型(LLMs)缺乏统一的负责任AI(Responsible AI,简称RAI)评估标准。这一问题虽然还存在,但新兴的评估工具开始填补这一空白,比如HELM Safety和AIR-Bench。

2. AI事故报告数量持续攀升。

根据AI事故数据库的统计,2024年报告的AI相关事故达到233起,创下历史新高,比2023年增加了56.4%。

3. 组织已意识到负责任AI的风险,但实际防范行动跟不上。

麦肯锡的一项调查显示,尽管许多组织意识到AI存在风险,但并未积极采取措施应对。调查中,领导者关注最多的三项风险分别是:AI系统的不准确性(64%)、监管合规问题(63%)和网络安全风险(60%),但实际行动并未完全到位。

4. 全球政策制定者对负责任AI表现出强烈兴趣。

2024年,全球在AI治理方面的合作明显增强,许多主要国际组织如经合组织(OECD)、欧盟(EU)、联合国(UN)和非洲联盟(AU),都发布了强调透明性、可解释性以及可信赖性的负责任AI治理框架。

5. 公共数据资源迅速减少。

AI模型的训练依赖大量公开网页数据。但最新研究发现,越来越多网站开始限制数据抓取,2024年比2023年实施此类限制的比例大幅增加。在C4数据集中,限制抓取的数据比例从5–7%激增至20–33%。数据资源减少将直接影响数据的多样性、模型的有效性和扩展性,也促使研究人员探索新的数据受限学习方法。

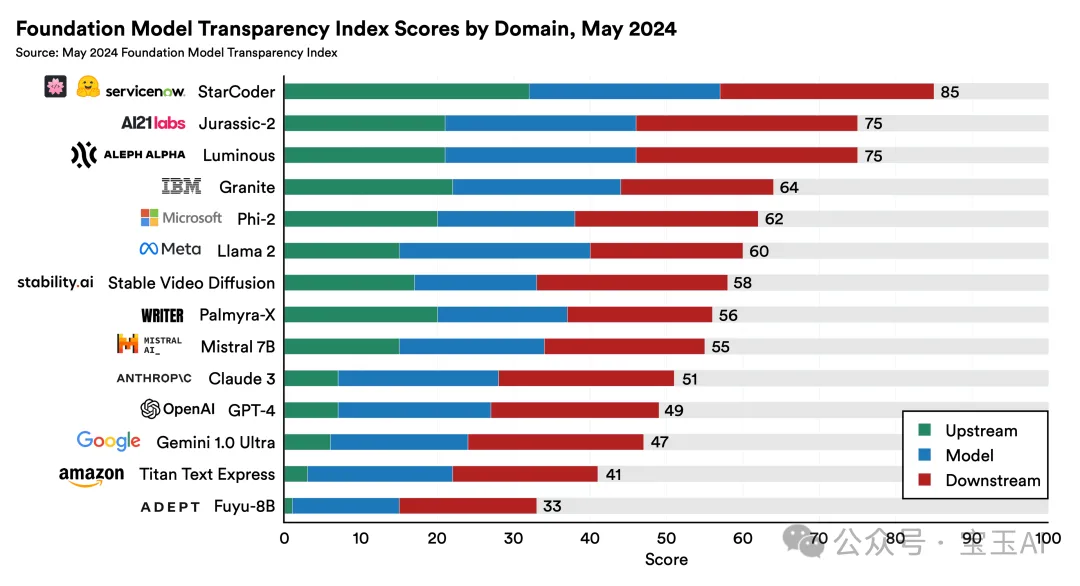

6. 基础模型研究的透明度有所提升,但仍需加强。

最新的基础模型透明度指数显示,从2023年10月到2024年5月,各大模型开发者的平均透明度得分从37%提升到58%。虽然进步明显,但仍有巨大提升空间。

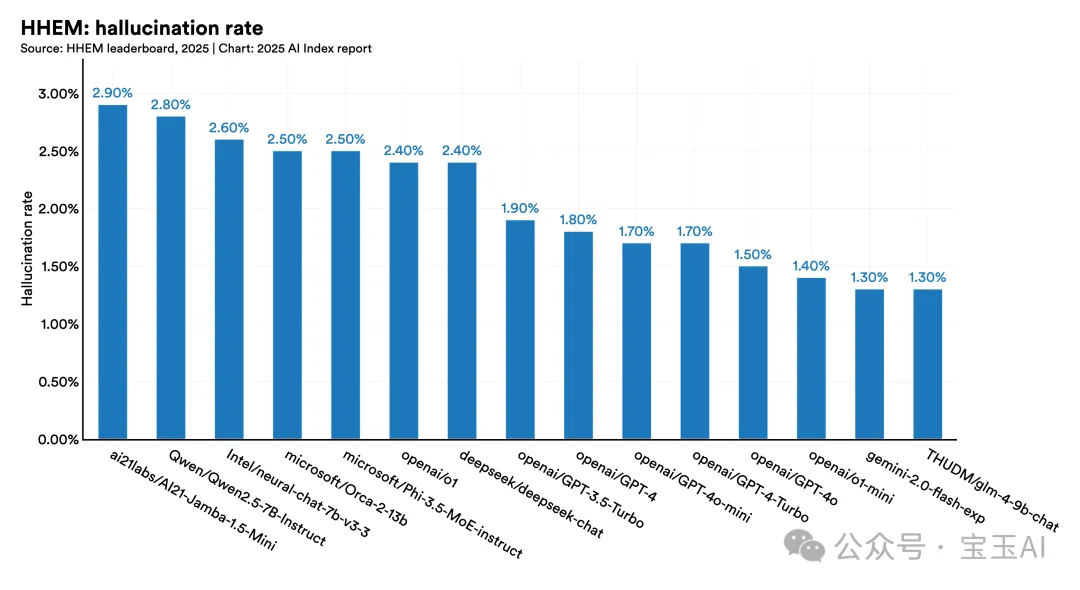

7. 关于事实性和真实性的AI评测标准逐渐完善。

之前用于评估AI模型事实性和真实性的基准(如HaluEval、TruthfulQA)未能广泛推广。为此,新的、更全面的评估方法逐渐涌现,比如新版的休斯“幻觉”评估模型(Hughes Hallucination Evaluation Model)排行榜,以及FACTS和SimpleQA等评估工具。

8. AI相关的选举虚假信息在全球传播,但实际影响尚不明确。

2024年,全球十多个国家的至少10个社交媒体平台上出现大量AI生成的选举虚假信息,包括美国总统选举期间。然而,这些虚假信息的真实影响程度依然不明朗,人们原本预计的重大影响并未完全实现。

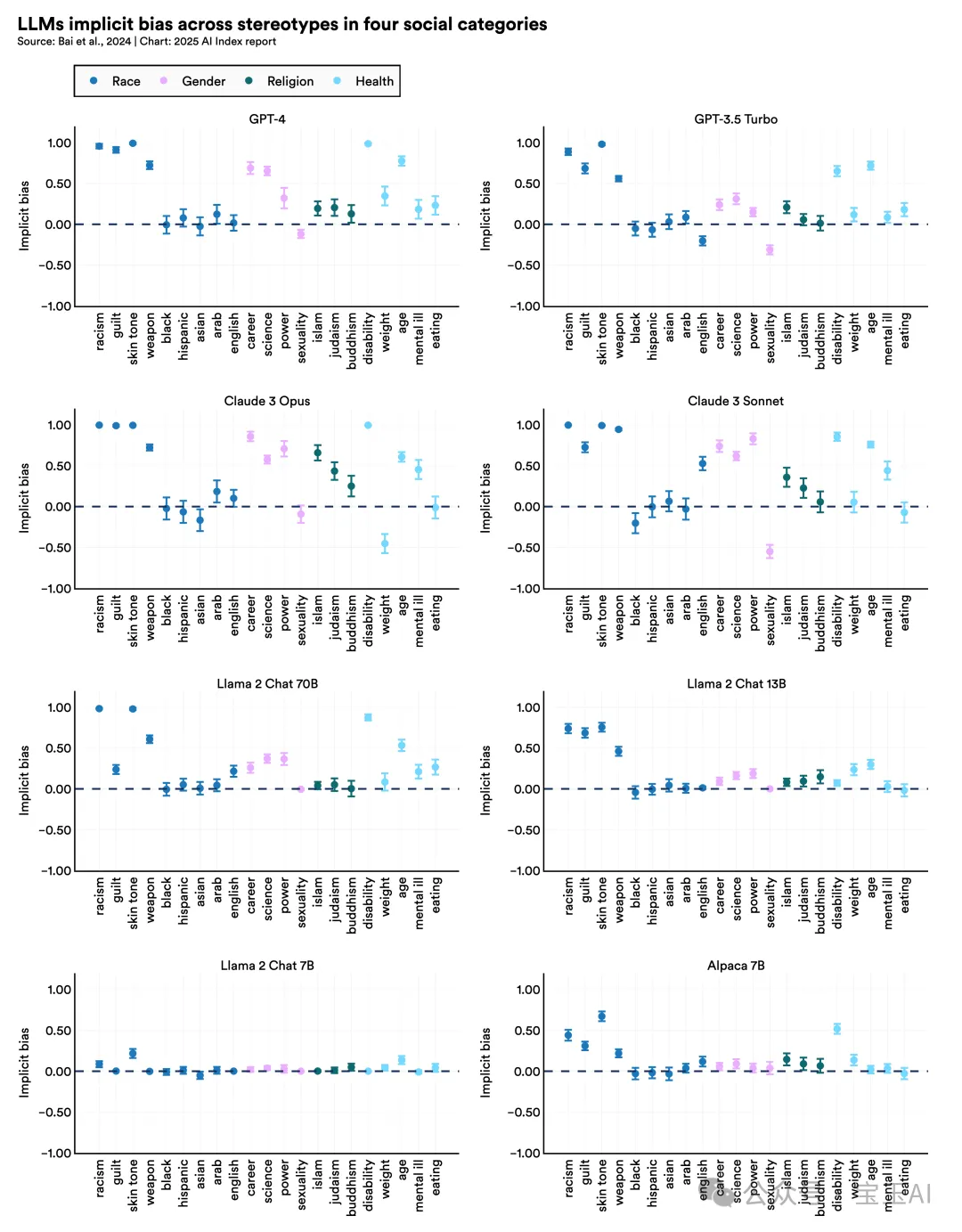

9. 明确训练以消除偏见的大语言模型仍存在隐性偏见。

许多先进的大语言模型(如GPT-4、Claude 3 Sonnet)虽然在设计阶段已尝试减少明确的偏见,但仍显示出明显的隐性偏见。这些模型倾向于把负面词汇与黑人关联,把女性更多地与人文学科而非科学技术联系起来,并更倾向于将男性与领导角色关联,强化了决策过程中的种族和性别偏见。尽管在基准测试中的偏见指标有所改善,但AI模型的偏见问题依旧突出。

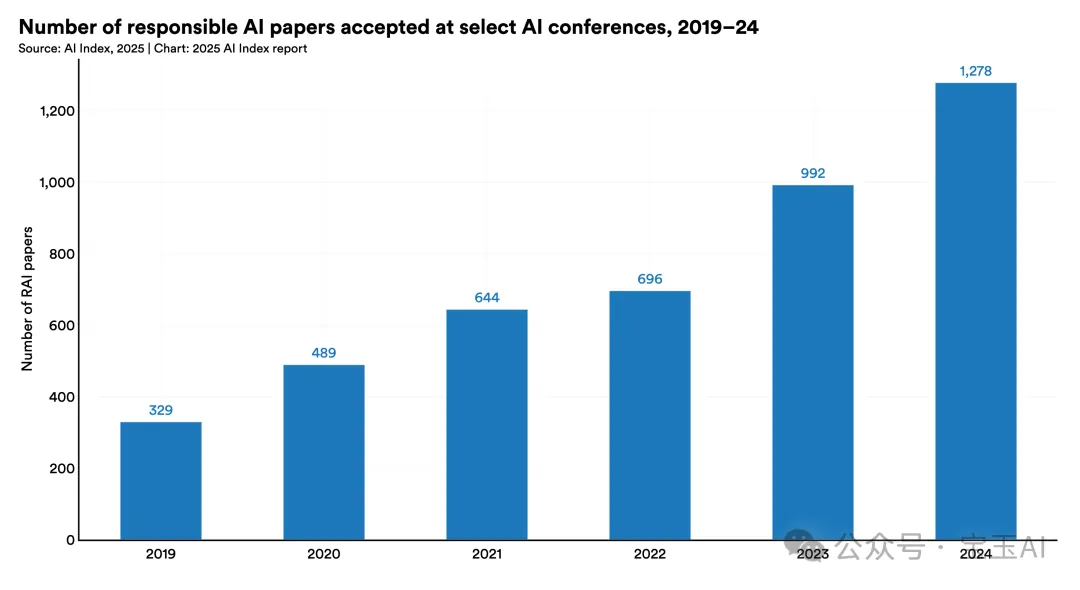

10. 学术界越来越关注负责任AI研究。

2024年,主流AI学术会议中被接受的负责任AI相关论文数量达到1278篇,比2023年(992篇)增加了28.8%。这一趋势自2019年以来稳步提升,显示学术界对负责任AI议题的持续关注与日益重视。

05

第四章:经济篇

1. 全球人工智能私人投资创新高,增速达26%

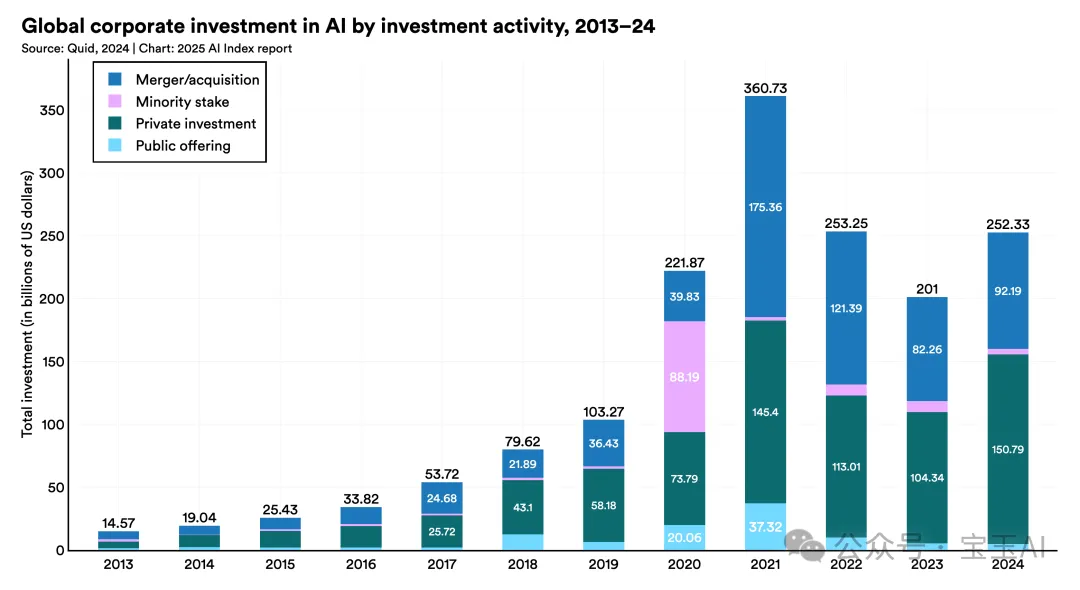

2024年,全球企业对人工智能(AI)的投资达到创纪录的2523亿美元,其中私人投资增幅高达44.5%,企业并购活动则增长了12.1%。过去十年,这一领域呈现爆发式增长,投资总额相比2014年已增长了超过13倍。

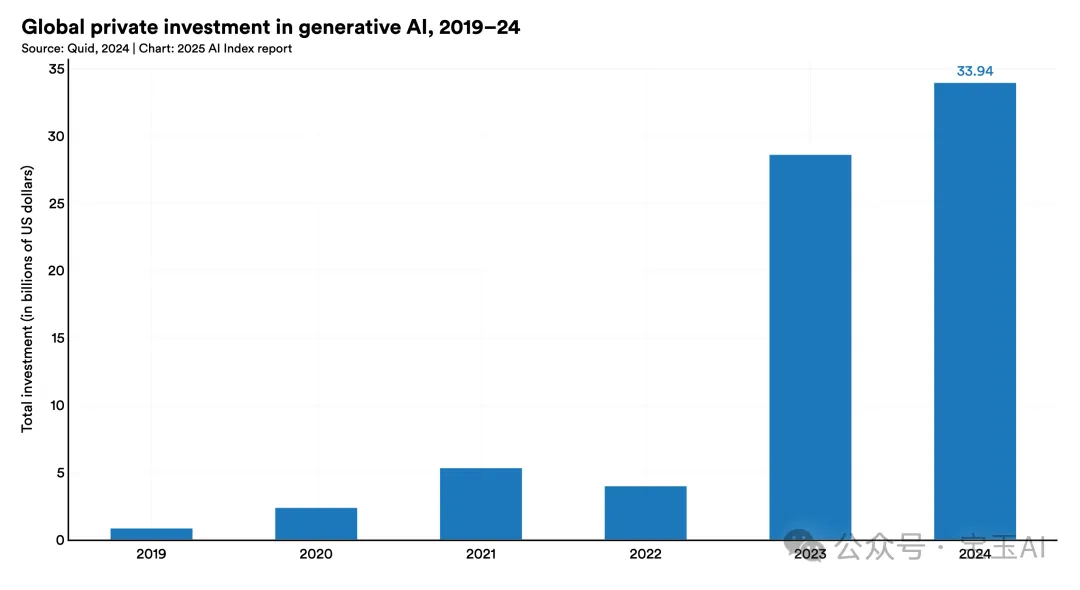

2. 生成式AI投资激增

生成式AI在2024年的私人投资达到了339亿美元,比2023年增长18.7%,更是2022年投资水平的8.5倍以上。目前,生成式AI已经占到全部AI相关私人投资的20%以上。

3. 美国进一步巩固在全球AI私人投资中的领先地位

2024年,美国在AI领域的私人投资高达1091亿美元,几乎是中国(93亿美元)的12倍,更是英国(45亿美元)的24倍。尤其是在生成式AI领域,美国的投资额超过了中国、欧盟和英国之和254亿美元,远高于2023年的218亿美元,领先优势进一步扩大。

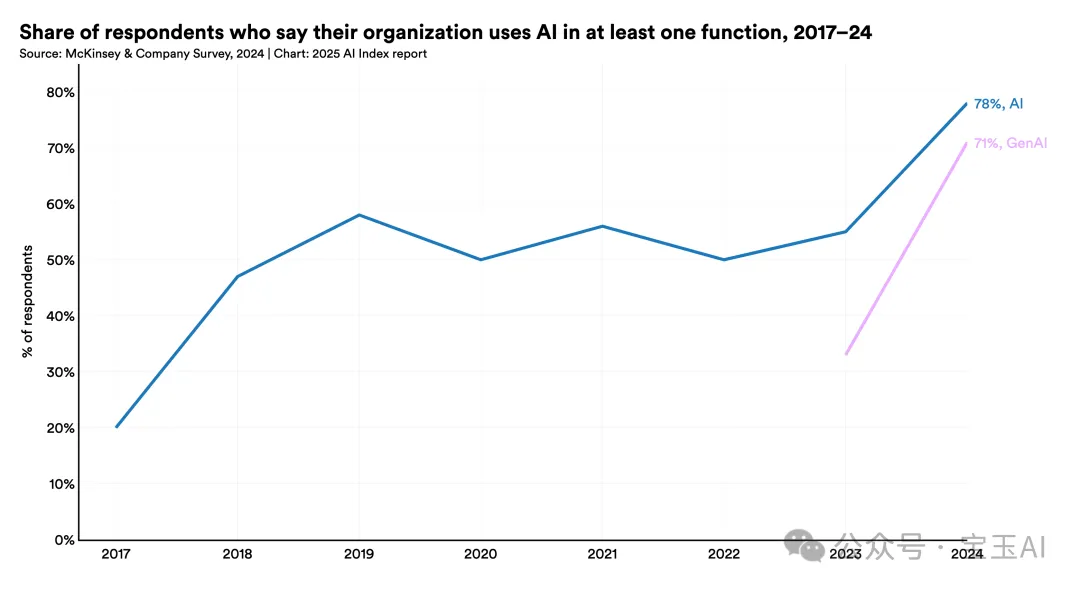

4. AI应用达到空前水平

2024年,调查中表示所在组织使用AI的受访者比例,从2023年的55%跃升至78%。尤其是在生成式AI方面,使用这一技术至少在一个业务环节中的比例更是大幅增长,从2023年的33%迅速增加到去年的71%。

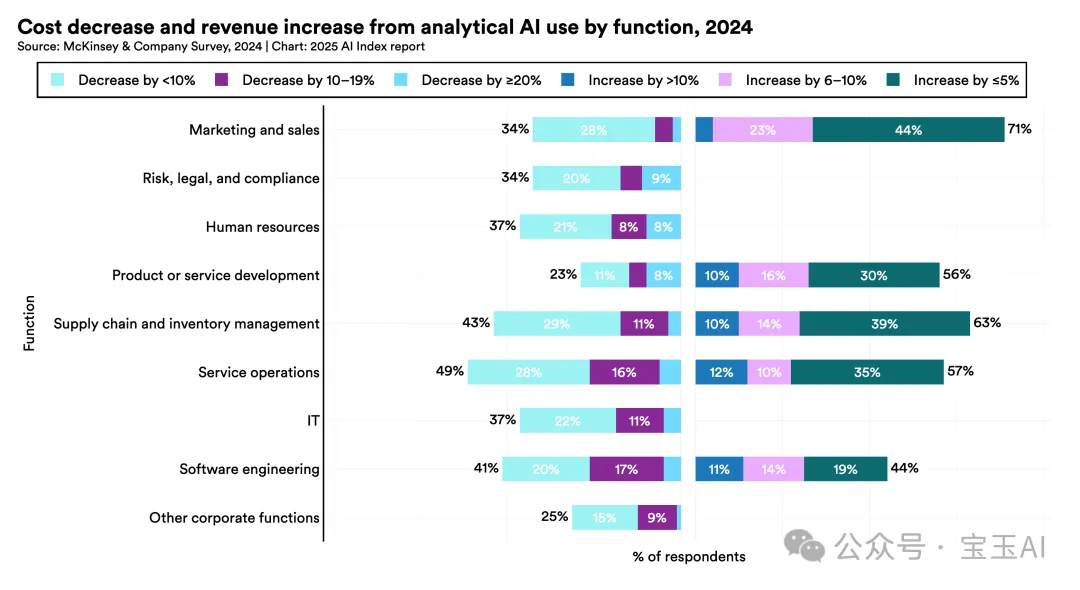

5. AI开始为企业带来财务收益,但整体处于初期阶段

尽管越来越多企业表示在某些业务领域采用AI后实现了财务收益,但目前收益整体仍然偏低。在服务运营领域,49%的企业表示AI帮助节省了成本;其次是供应链管理(43%)和软件工程(41%),但多数企业节省的成本不足10%。在收入方面,营销与销售领域71%的企业表示AI带来收入增长;供应链管理为63%,服务运营为57%,但收入增幅普遍低于5%。

6. 全球AI应用区域版图剧变,大中华区快速崛起

虽然北美地区仍处于AI应用的领先地位,但大中华区在过去一年中的增长尤为突出,AI在企业中的应用比例同比上升27个百分点,欧洲紧随其后,增幅达到23个百分点。这显示全球AI格局正在快速演变,各地区竞争日趋激烈。

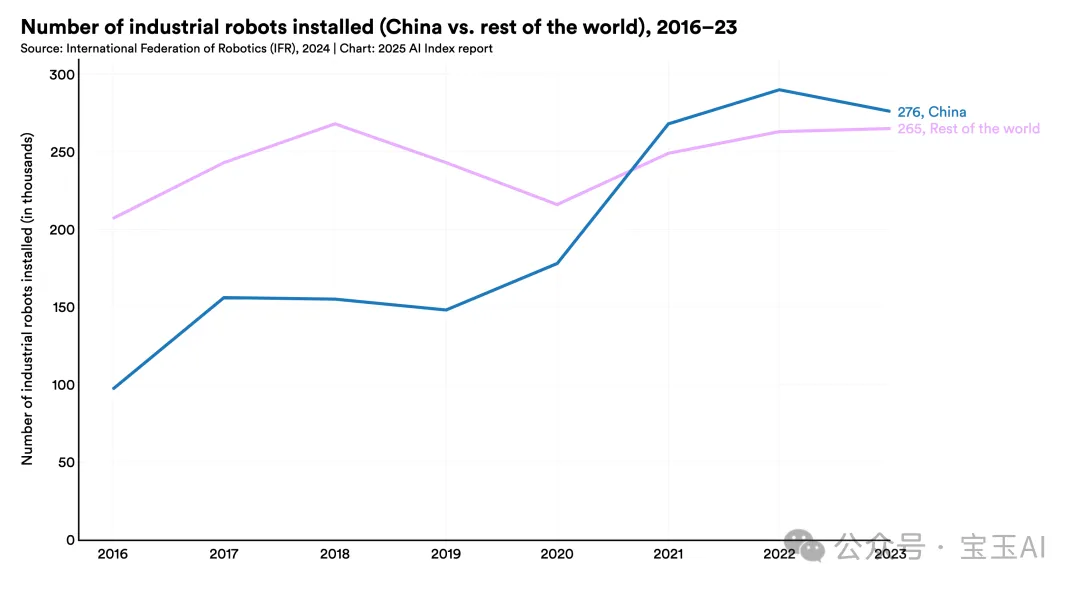

7. 中国在工业机器人领域继续保持领先,优势略有收窄

2023年,中国新增工业机器人27.63万台,安装量是日本的6倍、美国的7.3倍。自2013年首次超过日本后,中国工业机器人的全球份额从20.8%提升到51.1%。虽然中国机器人安装数量仍超过全球其他国家之和,但这一领先优势在2023年略有缩小,显示其快速扩张有所放缓。

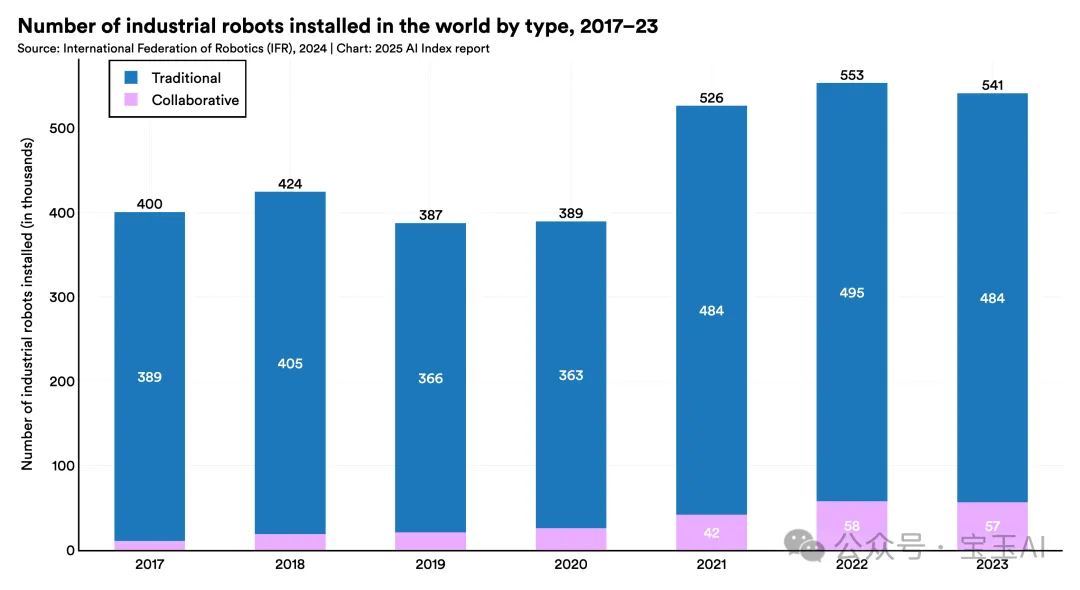

8. 协作型和互动型机器人日益普及

2017年,协作型机器人仅占新增工业机器人安装量的2.8%,而到2023年已提升至10.5%。此外,2023年除医疗领域外,各个领域的服务机器人安装量也普遍上升。这反映出机器人不仅数量增加,其应用方向也正越来越多地面向人与机器人互动协作的场景。

9. AI推动能源结构重大转型,核能引发关注

微软宣布投入16亿美元重启“三哩岛”核反应堆,以满足AI算力需求。此外,谷歌和亚马逊也已签署核能合作协议,以支持其AI相关业务的能源需求。

10. AI提高生产力,缩小技能差距

去年AI指数首次强调了AI对生产力积极影响的研究成果。今年更多研究进一步证实了这一结论:AI不仅提高了整体生产力,在大多数情况下,也缩小了低技能和高技能劳动者之间的差距。

06

第五章:科学与医学

1. 更强大的蛋白质测序模型出现

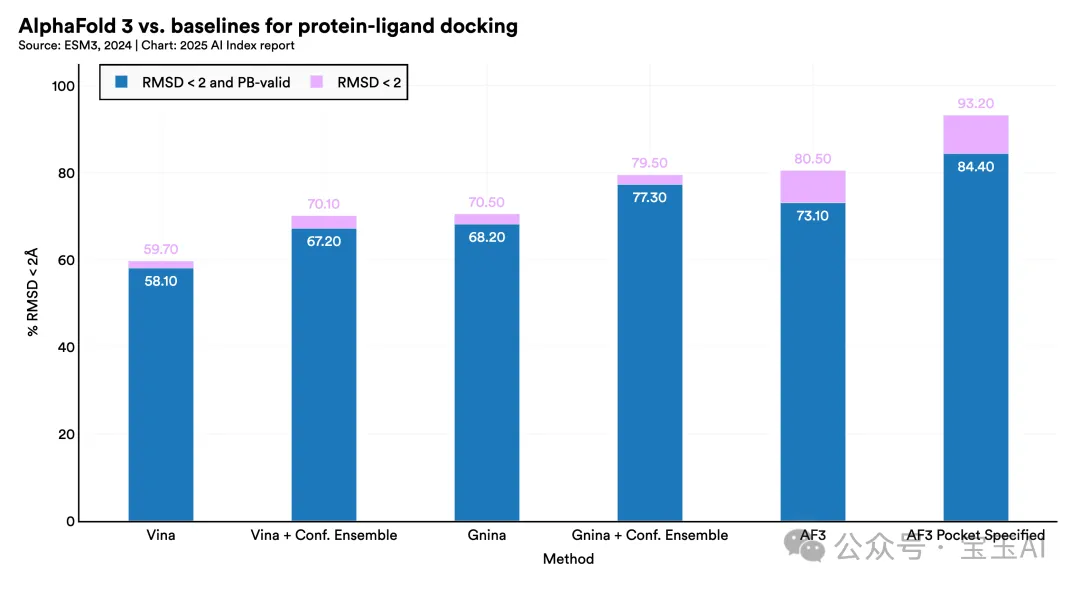

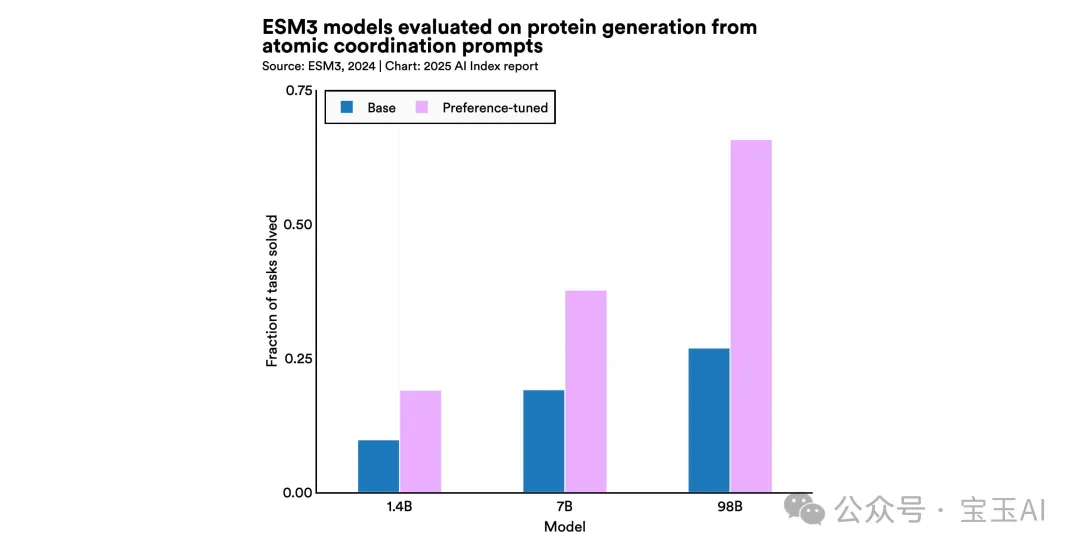

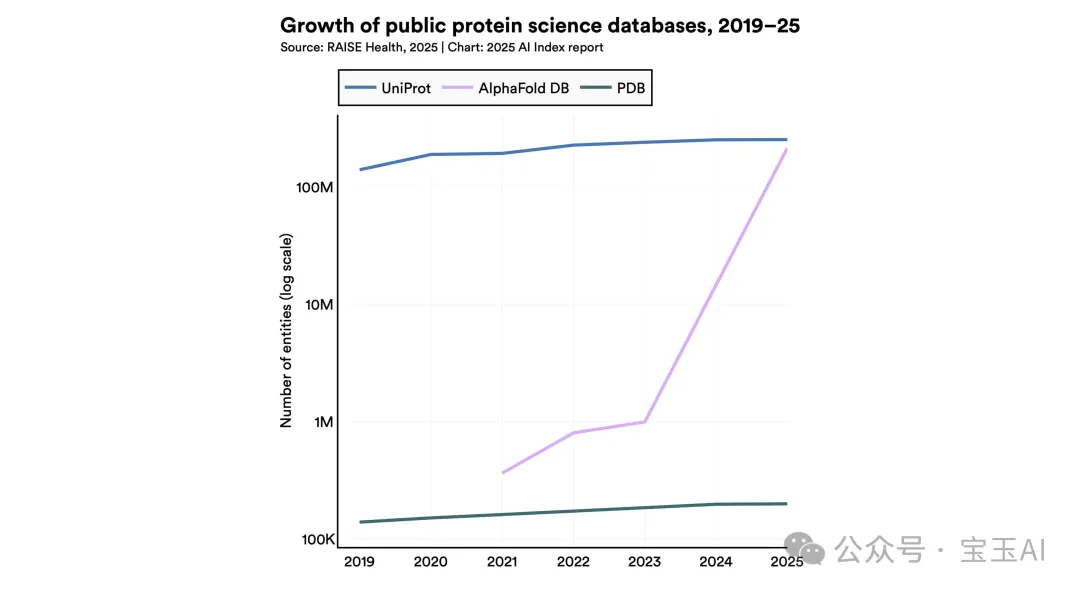

2024年,多款超大规模高性能蛋白质测序模型问世,其中最引人瞩目的是ESM3和AlphaFold 3。这些模型在过去一段时间不断扩容,体量越来越大,预测蛋白质结构的准确性也持续提高。

2. AI继续推动科学发现快速进步

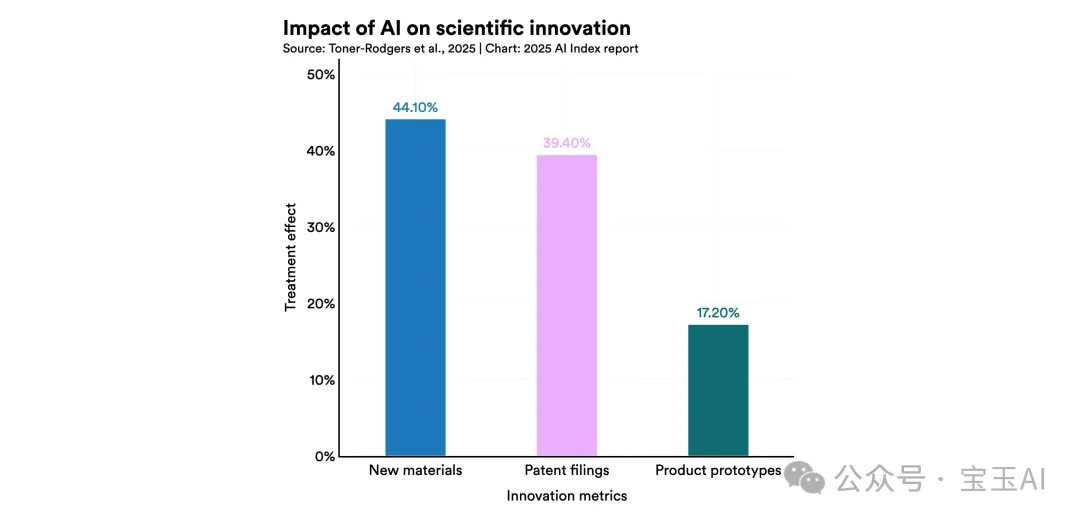

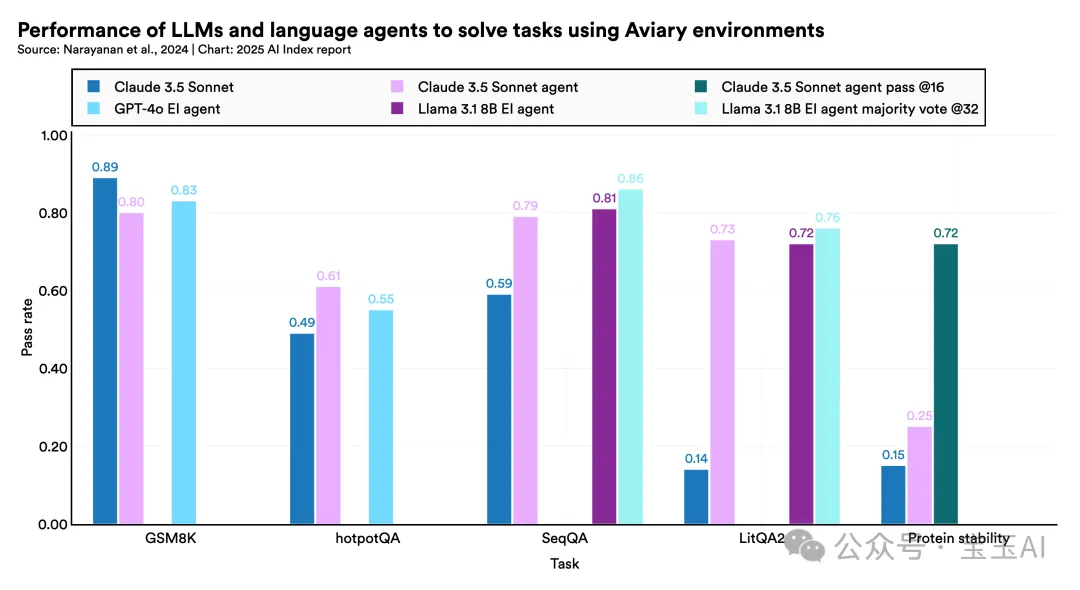

人工智能在推动科学发展的过程中,角色愈发关键。如果说2022和2023年是AI辅助科学突破的初步阶段,那么2024年的成果更是令人振奋。例如,名为Aviary的项目训练出专注于生物任务的大模型代理,而FireSat则大幅提高了森林火灾预测能力。

3. 顶尖大模型的临床医学知识持续提升

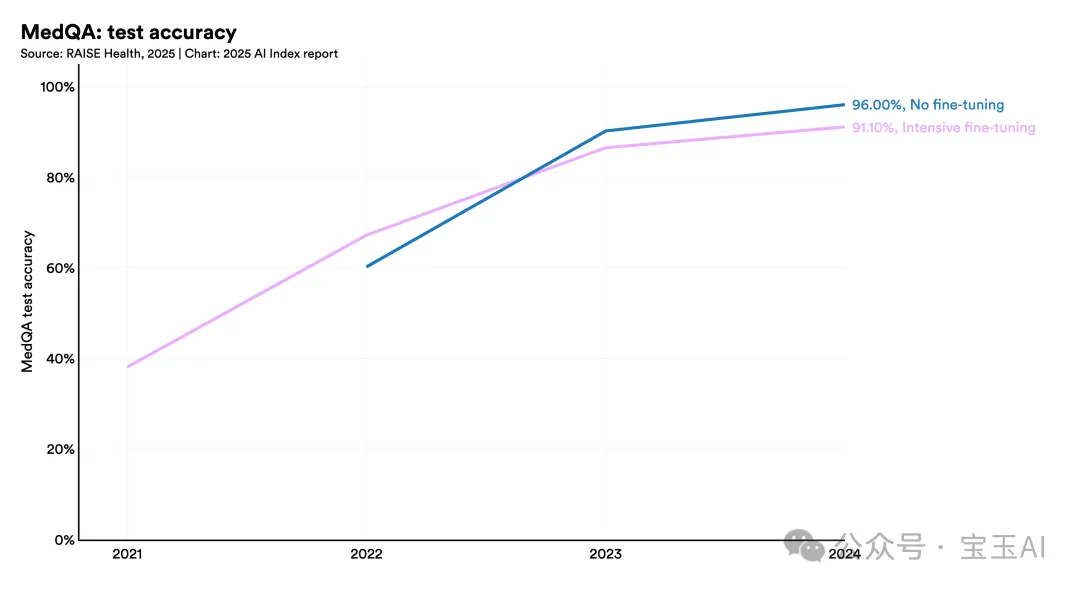

OpenAI近期发布的新模型o1,在医学知识的权威测试——MedQA基准中,刷新纪录,达到了96.0%的准确率。这一成绩比2023年的最好成绩提高了5.8个百分点。事实上,从2022年末至今,性能累计提升幅度达到28.4个百分点。MedQA作为评测临床医学知识的权威基准可能即将触及性能极限,未来需要更具挑战性的评估方法。

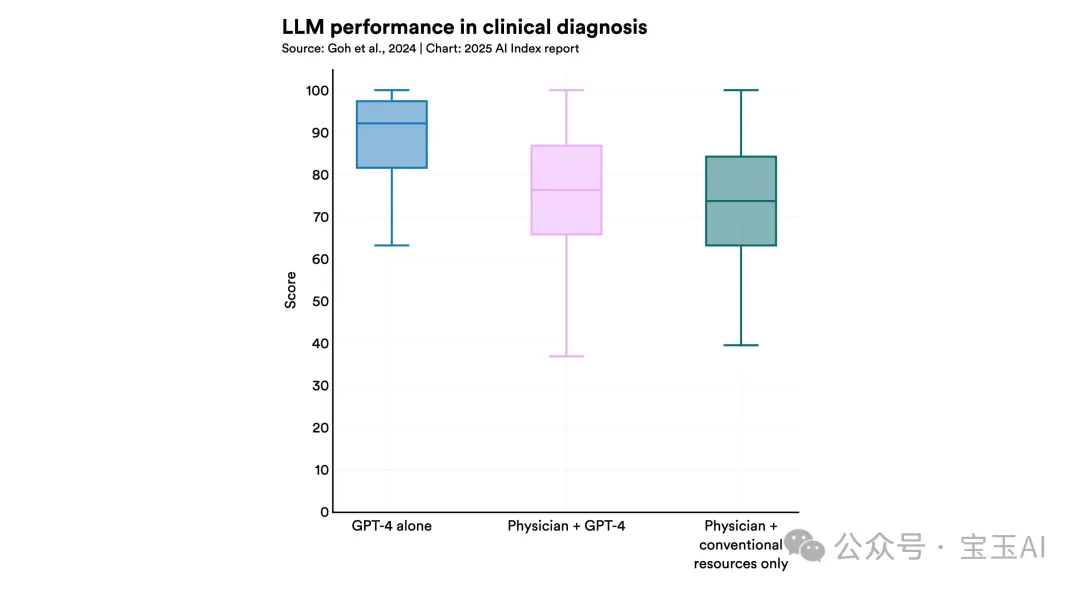

4. AI在关键临床任务上超越医生

一项最新研究表明,仅仅依靠GPT-4诊断复杂病例,就已超过了普通医生,甚至胜过了借助AI辅助的医生。其他近期的研究也显示,AI在癌症诊断、高死亡风险病人识别等方面都表现出色。不过,也有一些初步研究指出,AI与医生协作的效果可能更佳,因此这也是未来研究的重要方向。

5. 获FDA批准的AI医疗设备数量飞速增加

FDA(美国食品药品监督管理局)在1995年首次批准了AI医疗设备,2015年前总共只批准了6款。但到2023年,这个数字猛增至223款。

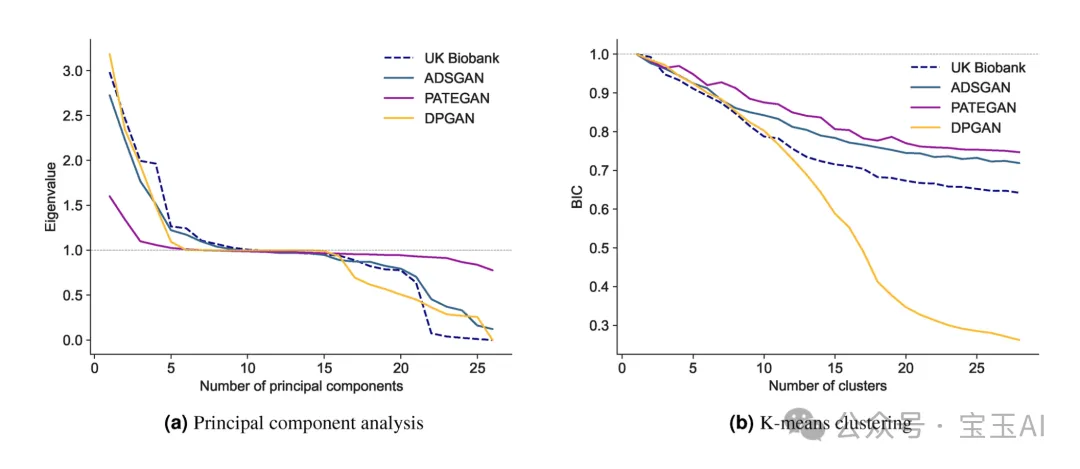

6. 合成数据在医学领域展现巨大潜力

2024年的研究表明,通过AI生成的合成数据可以帮助模型更准确地识别健康的社会决定因素、提升隐私保护的临床风险预测能力,还能促进新药物化合物的发现。

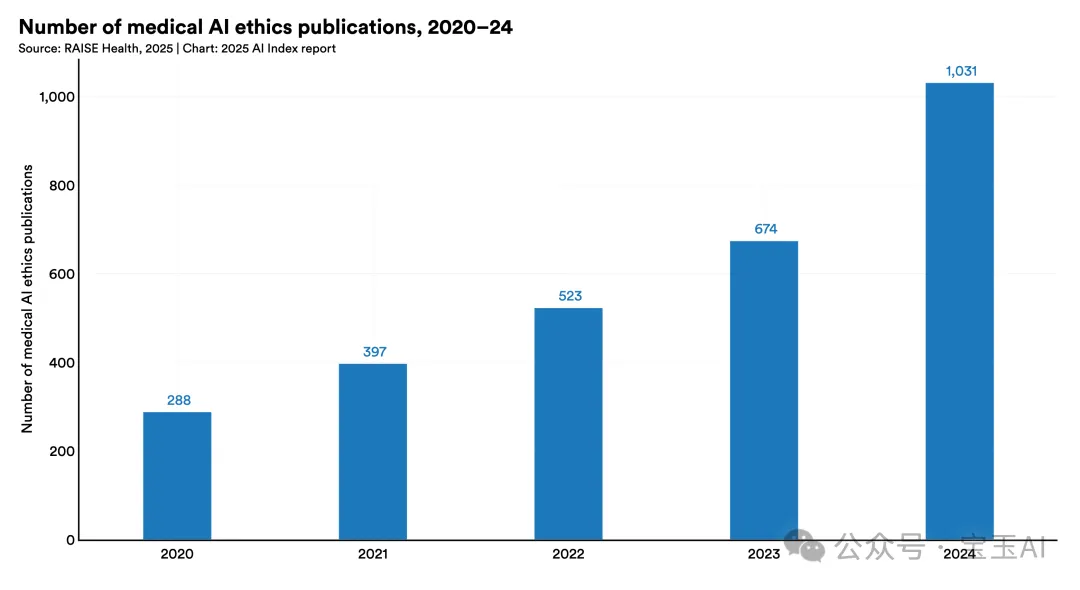

7. 医学AI伦理研究逐年增多

医学AI伦理研究的论文数量自2020年至2024年显著增加,从2020年的288篇,跃升至2024年的1031篇,增长近四倍。

8. 基础大模型进入医学领域

2024年,多款医学领域的大规模基础模型集中问世,其中既包括像Med-Gemini这样通用型的多模态模型,也有专门针对心脏超声检查的EchoCLIP、放射影像的ChexAgent等专业模型。

9. 公开蛋白质数据库规模迅速扩大

自2021年以来,主流公开蛋白质数据库条目的数量迅速增长,其中UniProt增加31%,PDB增加23%,而AlphaFold数据库更是暴增585%。这种增长对科学研究和发现具有深远意义。

10. AI研究荣获两项诺贝尔奖

2024年,AI驱动的研究首次斩获诺贝尔奖的殊荣,取得了历史性突破。其中,谷歌DeepMind公司的Demis Hassabis和John Jumper因在AlphaFold蛋白质折叠领域的开创性工作,荣获诺贝尔化学奖;与此同时,John Hopfield和Geoffrey Hinton因其在神经网络基础理论上的贡献,获得了诺贝尔物理学奖。

07

第六章:政策与治理

1. 美国联邦AI立法进展缓慢,各州却积极行动领先一步

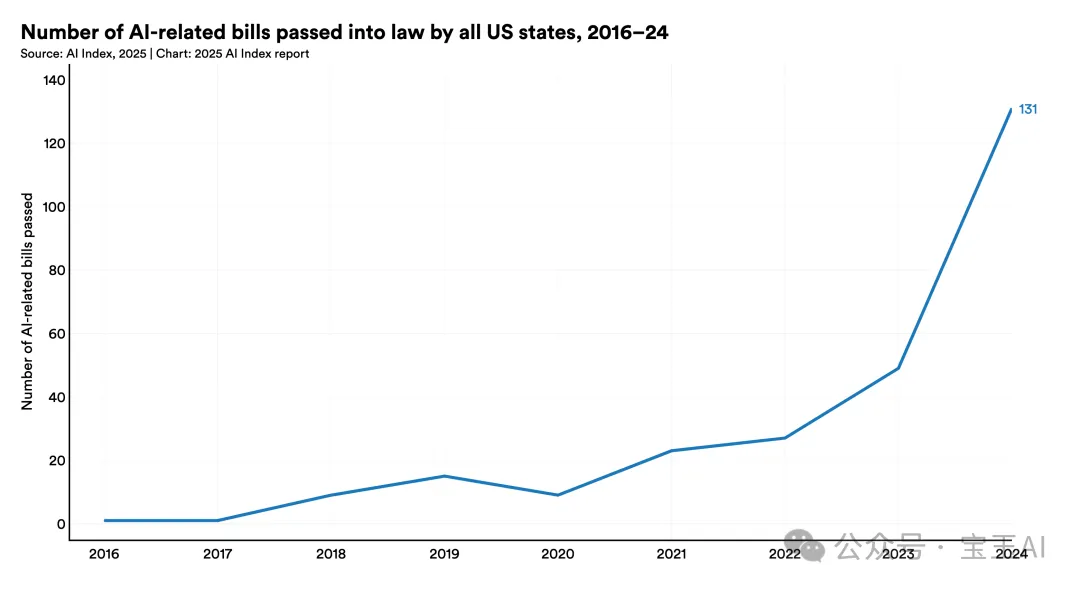

从2016年到2023年,美国州一级通过的AI相关法律数量从最初的1个迅速增加到49个。而仅2023年至2024年一年之内,这个数字更是翻了一倍多,达到了131个。相比之下,尽管联邦层面提出的AI法案也在不断增加,但最终通过的法案数量依旧非常少。

2. 全球政府纷纷加大AI基础设施投入

各国政府正在大规模投入人工智能基础设施建设,加拿大宣布投入24亿美元用于AI基础设施建设,中国则启动了475亿美元的基金,用以推动半导体产业的发展。法国承诺投入1170亿美元建设AI基础设施,印度承诺12.5亿美元,沙特阿拉伯更是通过“超越计划”(Project Transcendence)宣布将投资1000亿美元发展AI。

3. 全球立法议程中“人工智能”话题持续升温

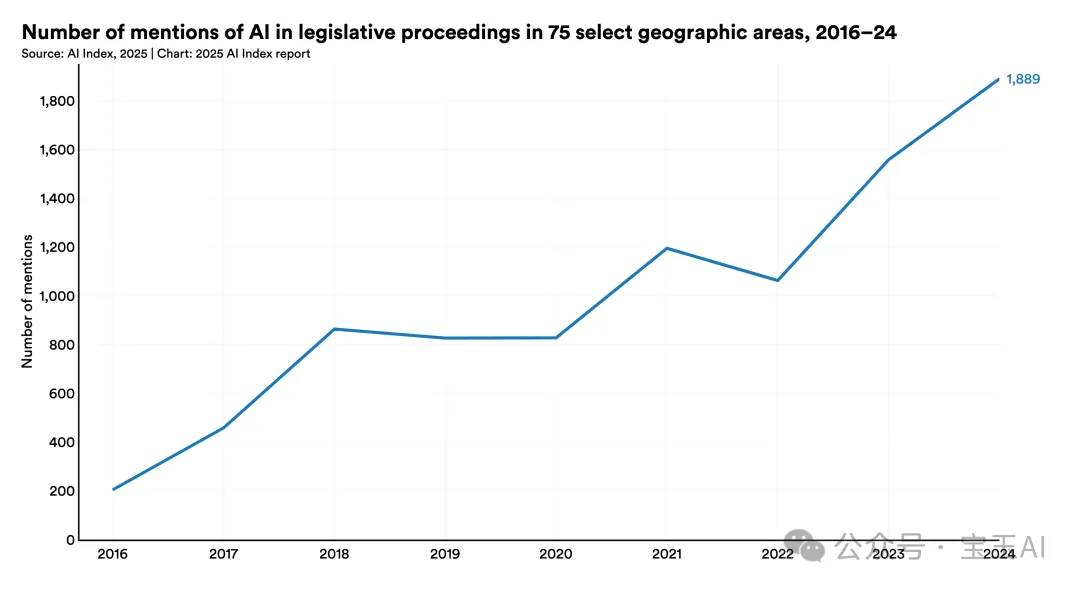

在全球75个主要国家的立法活动中,2024年提及AI的次数达到1889次,比2023年的1557次增长了21.3%。自2016年以来,全球立法机构讨论AI的次数累计增加了九倍以上。

4. 全球AI安全研究机构快速扩张,国际合作持续推进

自2023年11月首届AI安全峰会召开后,美国与英国率先成立了国际AI安全研究机构。随后,2024年5月在韩国召开的AI首尔峰会上,日本、法国、德国、意大利、新加坡、韩国、澳大利亚、加拿大以及欧盟也相继宣布建立类似机构,国际合作与协调进一步加强。

5. 美国联邦政府出台AI监管规定数量激增

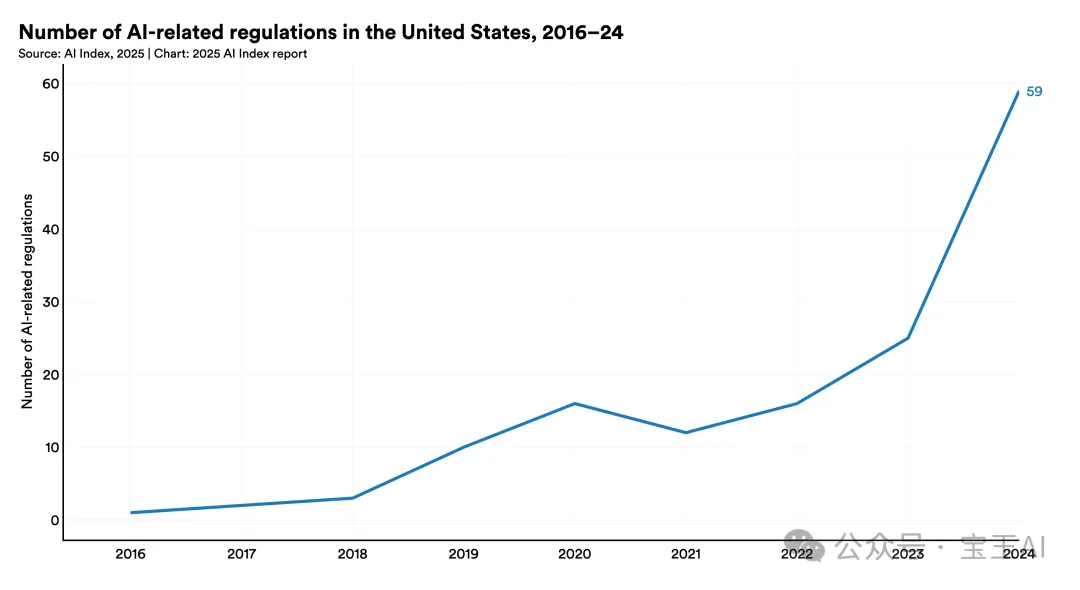

2024年,美国联邦层面推出的AI相关监管措施数量达到59项,这比2023年的25项增长了一倍多。这些监管措施由42个不同的联邦机构颁布,同样是2023年颁布相关规定机构数量(21个)的两倍。

6. 美国各州加速推出“深伪”(Deepfake)监管政策

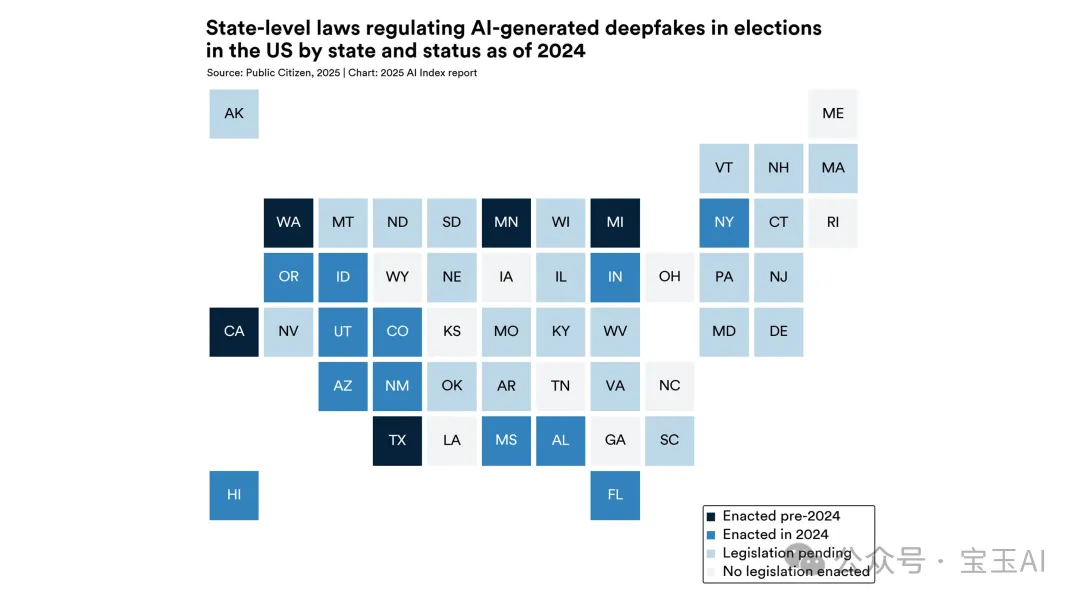

2024年之前,仅有加利福尼亚州、密歇根州、华盛顿州、德克萨斯州和明尼苏达州5个州出台了针对选举中的深伪技术监管措施。但在2024年,俄勒冈州、新墨西哥州和纽约州等15个州也纷纷跟进出台类似政策。截至2024年,全美已有24个州制定了相关法规。

08

第七章:教育

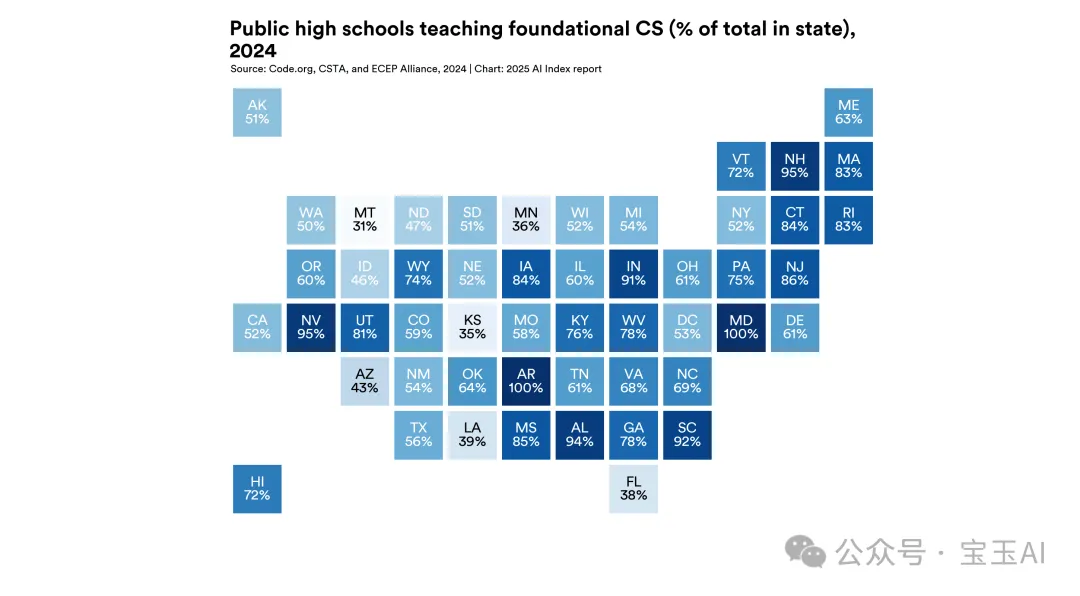

1. 美国高中计算机科学课程的普及程度小幅上升,但差距仍然明显。

学生参与计算机科学(CS)课程的情况仍然因州别、种族、学校规模、地理位置、收入、性别和残障情况存在较大差距。

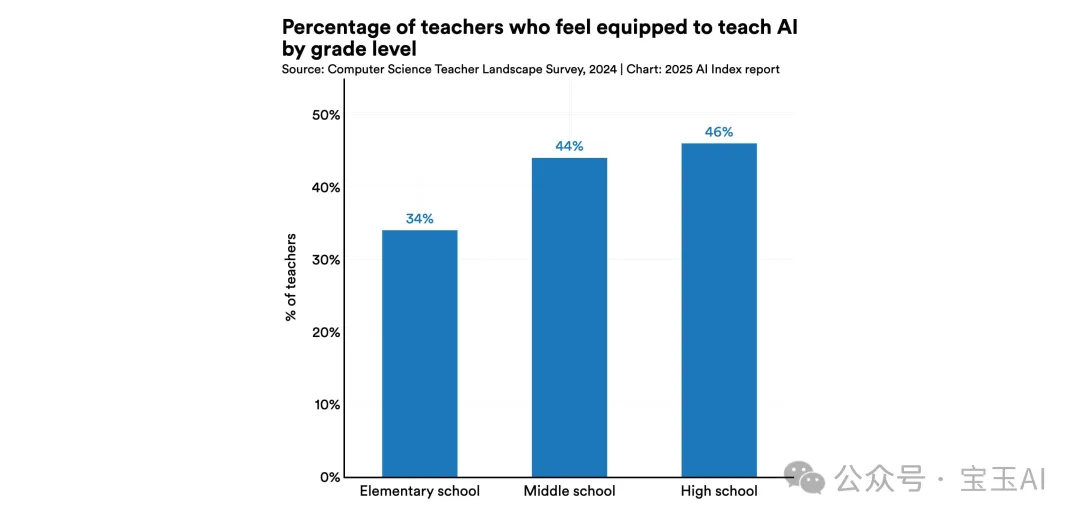

2. 美国计算机科学教师希望教授AI,但大多感到力不从心。

尽管有81%的计算机科学教师认为AI相关知识和技能应纳入基础CS课程中,但实际上,不足一半的高中计算机科学教师表示有能力教授AI。

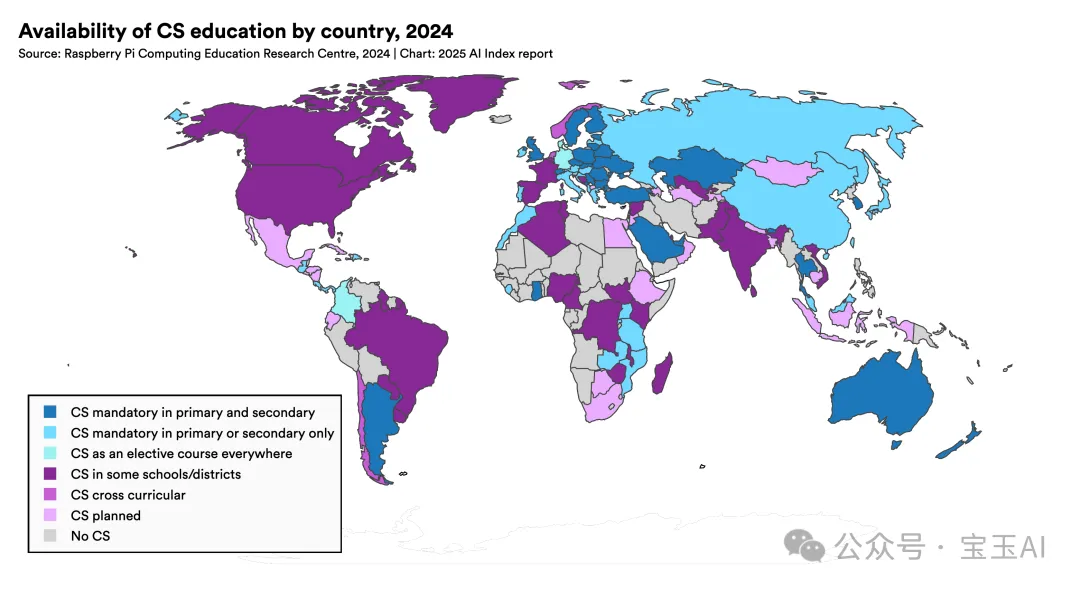

3. 全球约三分之二国家已开展或计划开展从幼儿园到高中阶段的计算机科学教育。

自2019年以来,这一比例翻了一倍,其中非洲和拉丁美洲国家的进步最为明显。不过,非洲国家由于学校缺乏电力,学生获得计算机科学教育的机会依然最低。

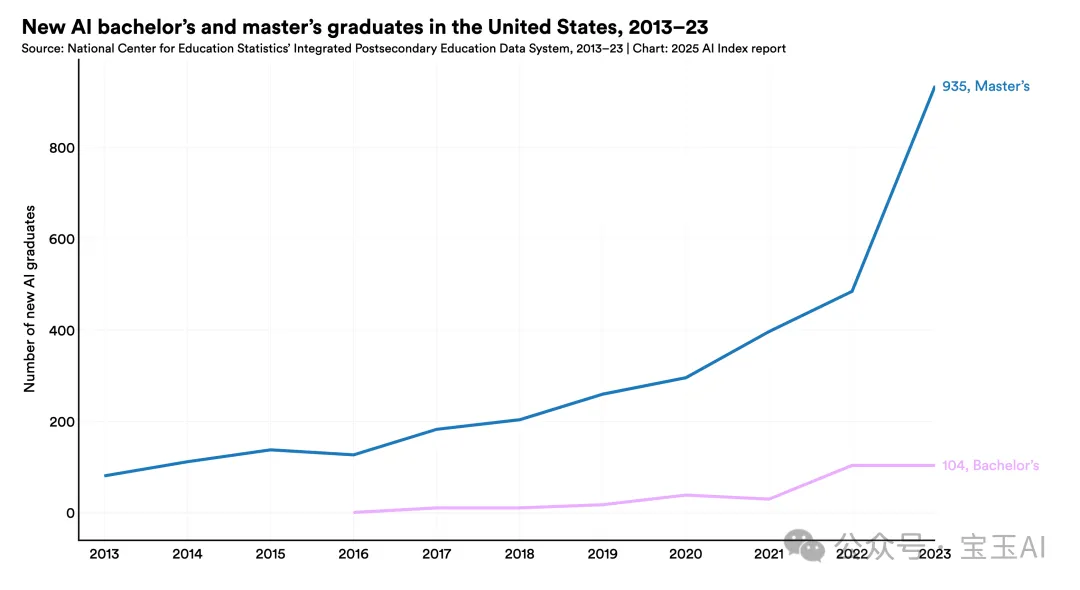

4. 美国获得AI硕士学位的人数在2022年至2023年间几乎翻了一倍。

虽然AI学科在本科和博士层面的增长较为缓慢,但硕士学位数量的迅速增加可能预示着未来所有学位层次的趋势。

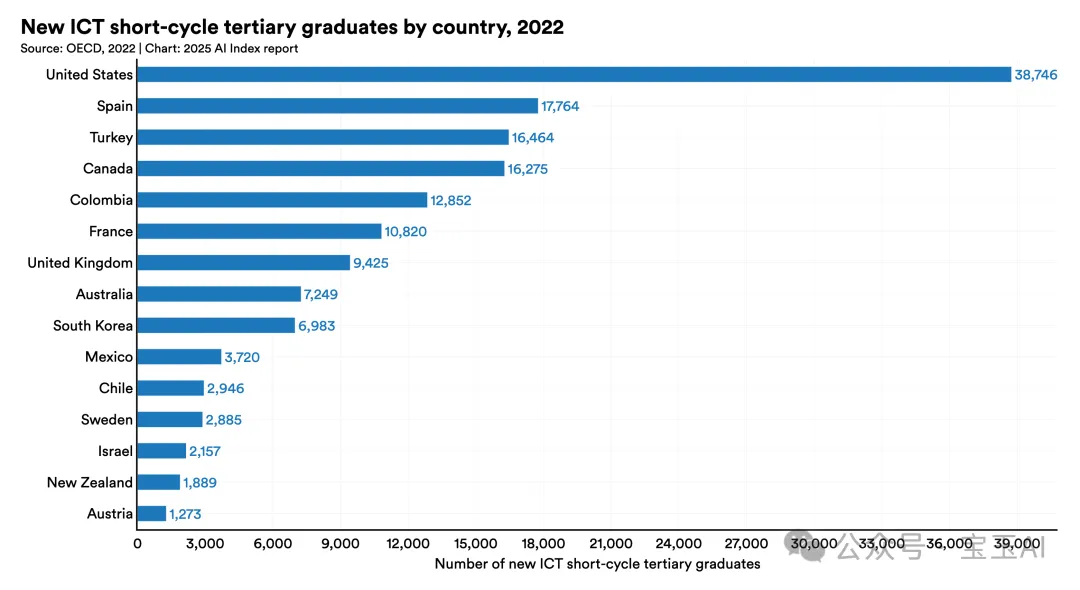

5. 美国仍是全球信息技术与通信(ICT)毕业生的主要输出国。

西班牙、巴西和英国紧随其后。值得注意的是,土耳其在ICT相关毕业生的性别平等方面表现最佳。

09

第八章:公众意见

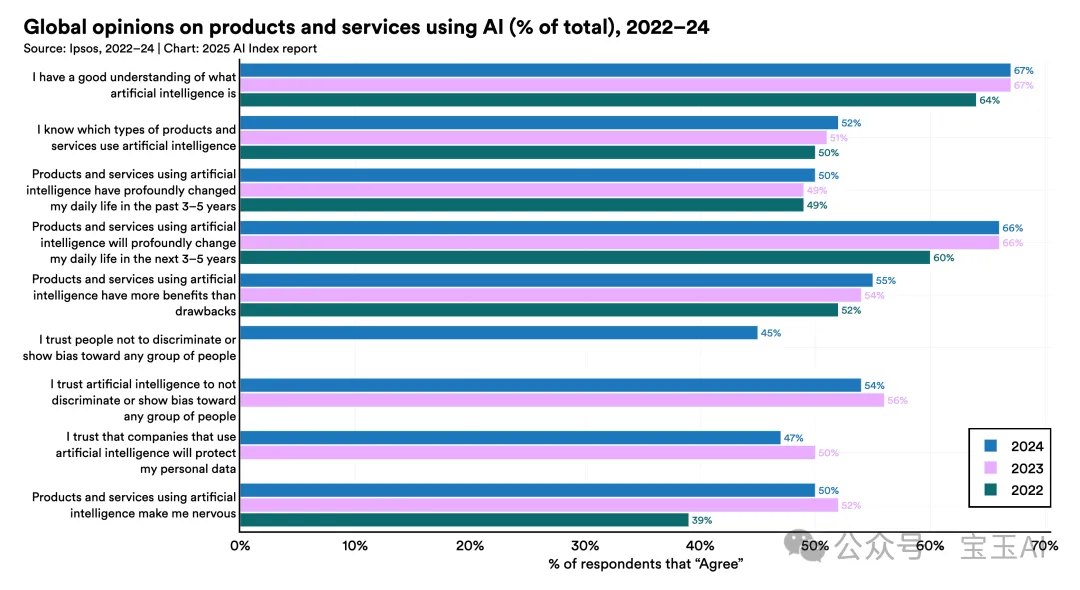

1. 全球对AI产品和服务的乐观态度稳步提升。

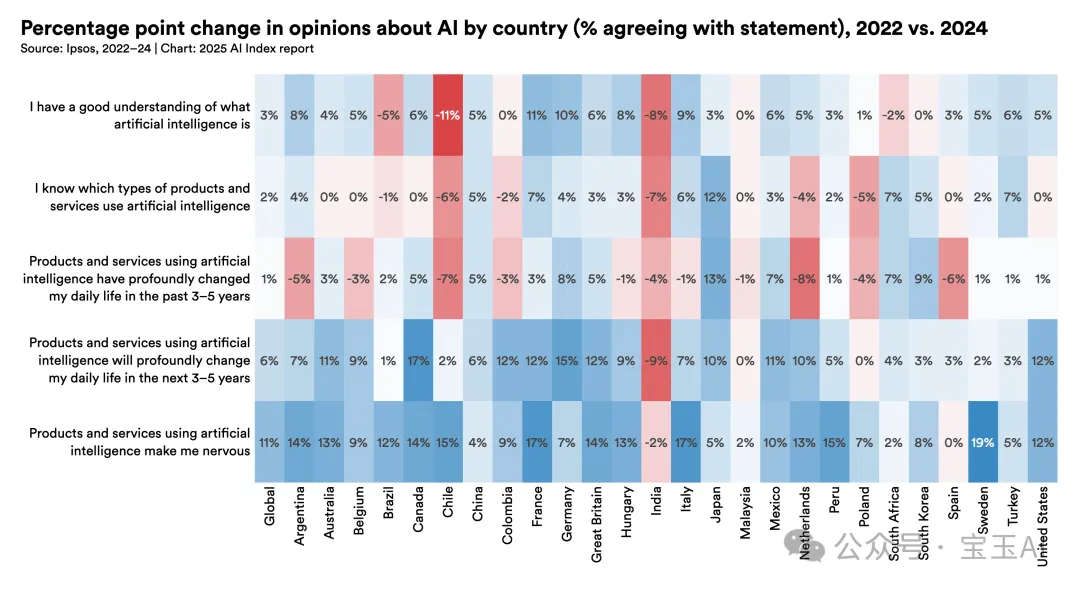

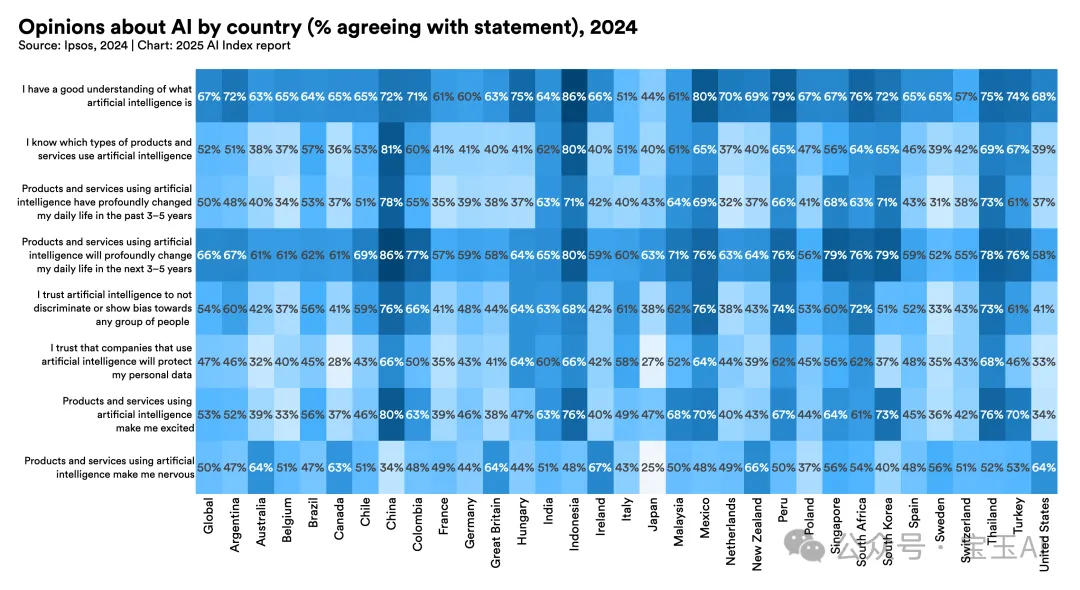

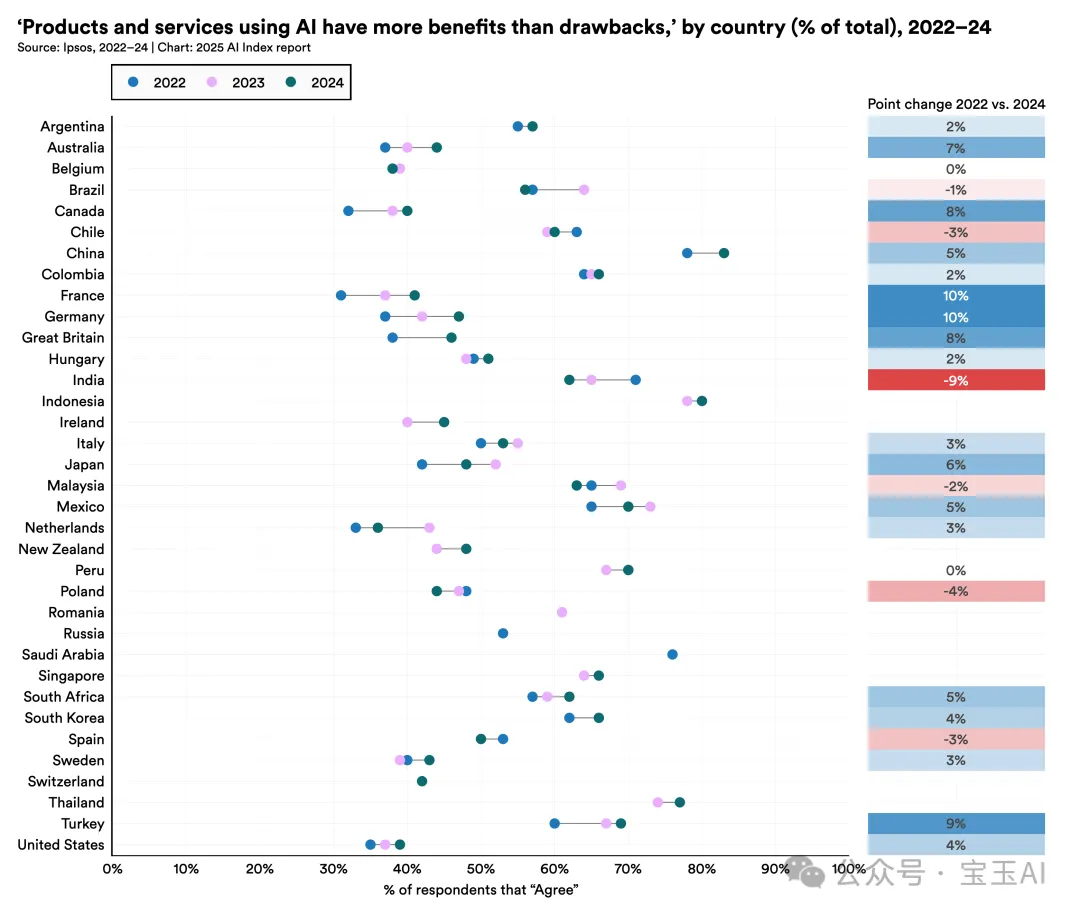

Ipsos调查了2022年和2024年26个国家公众对AI的态度,其中18个国家认为AI产品和服务利大于弊的比例有所增加。全球平均来看,这一比例从2022年的52%升至2024年的55%。

2. 公众对AI将显著影响日常生活的预期明显增强。

全球三分之二的公众认为AI将在未来3到5年内显著影响日常生活,比2022年增加了6个百分点。除马来西亚、波兰和印度外,其余国家的这一比例均有所增加,加拿大(17%)和德国(15%)增幅最大。

3. 大众对AI企业的道德规范产生更多质疑,对AI公平性的信任有所下降。

全球范围内,认为AI企业能保护个人数据的信任比例从2023年的50%下降至2024年的47%。同时,相信AI系统公正、不带歧视偏见的人数也有所减少。

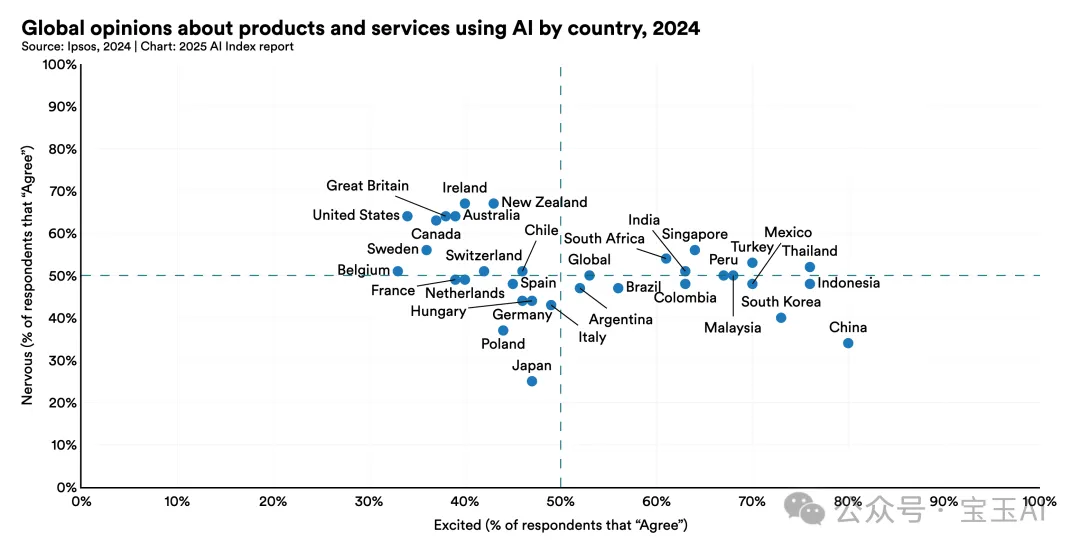

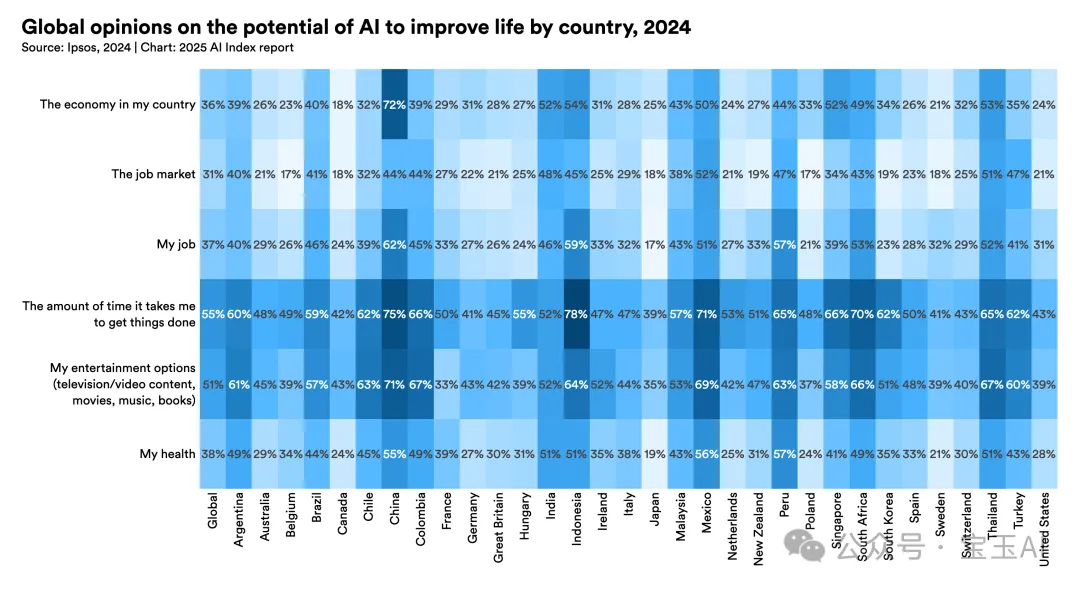

4. 不同地区对AI的乐观态度仍存在较大差异。

2023年AI指数首次提出的地区差异至今仍很明显。中国(83%)、印尼(80%)和泰国(77%)对AI乐观程度最高,而加拿大(40%)、美国(39%)和荷兰(36%)则相对悲观。

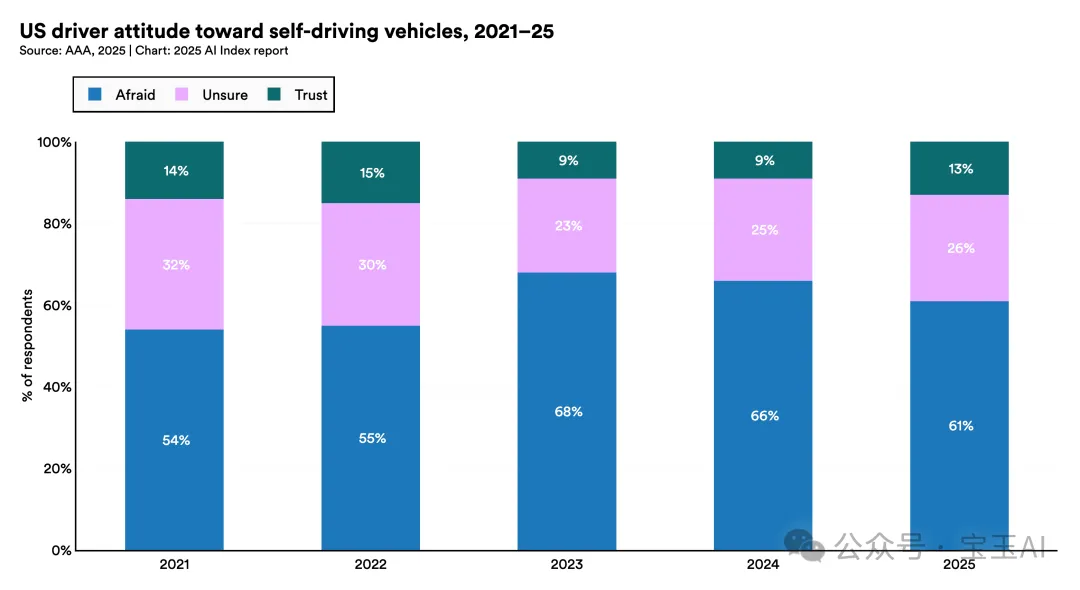

5. 美国民众对自动驾驶汽车的恐惧依旧较高。

美国汽车协会调查显示,美国61%的受访者害怕自动驾驶汽车,只有13%的受访者表示信任。尽管较2023年68%的恐惧比例略有下降,但仍然高于2021年的54%。

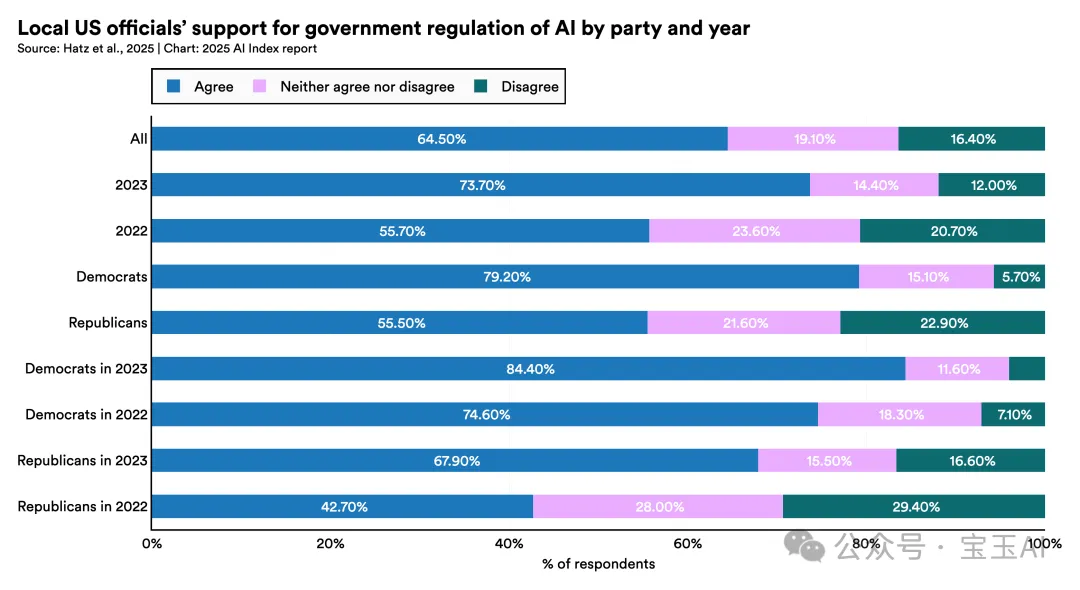

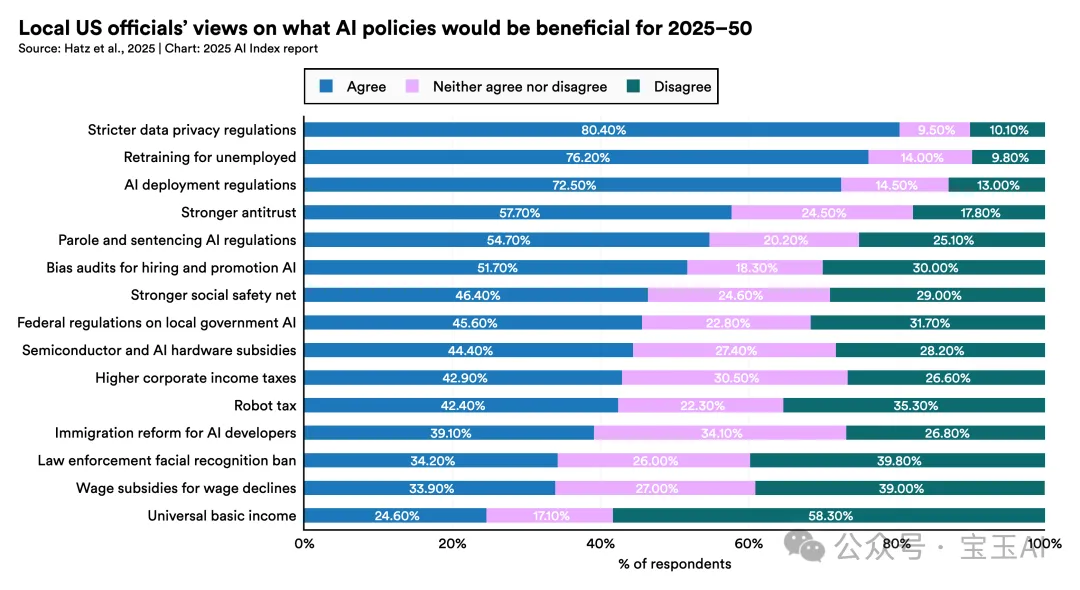

6. 美国地方决策者广泛支持对AI进行监管。

2023年,美国地方层面(乡镇、市政、县级)决策者中有73.7%赞同应对AI进行监管,比2022年的55.7%大幅提升。民主党决策者(79.2%)比共和党决策者(55.5%)的支持程度更高。

7. 原本最怀疑AI的一些国家,乐观程度反而快速上升。

在全球范围内,过去对AI最怀疑的英国(38%)、德国(37%)、美国(35%)、加拿大(32%)和法国(31%)民众的乐观比例分别提高了8%、10%、4%、8%和10%。

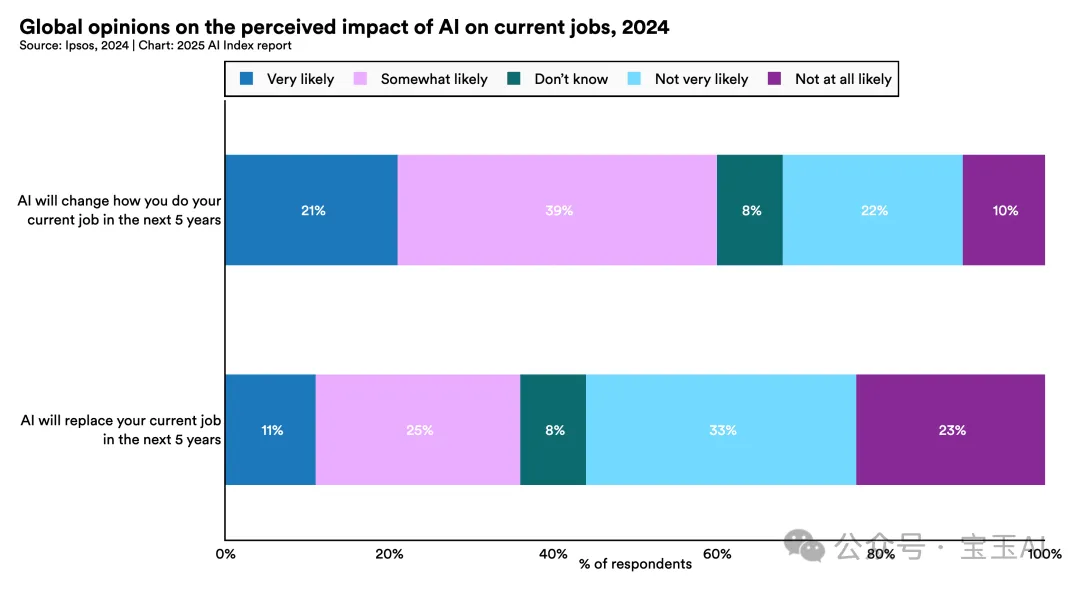

8. 工作者认为AI会改变工作方式,但担心被取代的比例较低。

全球60%的受访者相信AI会在未来五年改变自己的工作方式,但只有36%的受访者担心AI会取代自己的工作。

9. 美国地方决策者在AI政策优先事项上分歧明显。

尽管广泛支持监管AI,但地方决策者在具体政策上存在分歧。支持度最高的政策包括严格的数据隐私规则(80.4%)、失业者再培训(76.2%)和AI部署监管(72.5%);而禁止执法机构使用面部识别(34.2%)、工资补贴(22.9%)和全民基本收入(24.6%)的支持度较低。

10. AI被普遍认为能节省时间、丰富娱乐,但对经济影响的积极评价相对较低。

全球55%的受访者认为AI能节省时间,51%认为AI能提供更好的娱乐选择。然而,仅有38%认为AI能改善健康,36%认为AI能促进经济,31%看好就业市场,37%觉得AI能增强自己的工作表现。

(文:Founder Park)