近日,字节跳动正式开源了其最新研究成果 UNO。这是一个突破性的 AI 图像生成模型,可以同时支持单主体和多主体图像生成,用一个模型统一了多个任务,展现了强大的泛化能力。

UNO 模型:从少到多的泛化能力

UNO Less-to-More Generalization: Unlocking More Controllability by In-Context Generation(从少到多的泛化:通过上下文生成解锁更多可控性)。它解决了当前 AI 图像生成领域中的两个关键挑战:

-

数据规模扩展问题:从单主体数据集扩展到多主体数据集并进行规模化非常困难 -

主体扩展问题:目前大多数方法集中在单主体生成上,难以适用于多主体场景

技术亮点:高一致性数据合成与创新架构

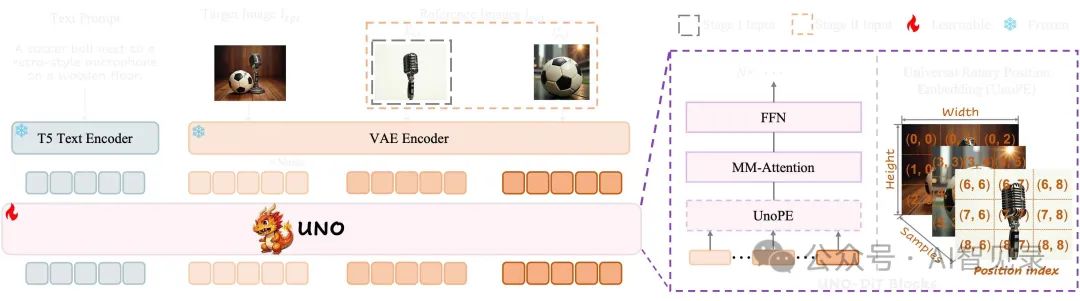

UNO 的核心技术突破主要体现在两个方面:

1. 高一致性数据合成管道

UNO 利用扩散变换器(Diffusion Transformers)的内在上下文生成能力,生成高一致性的多主体配对数据。这种方法能够自动创建大规模、高质量的训练数据,解决了数据获取的难题。

2. 创新的模型架构

UNO 引入了两个关键技术改进:

-

渐进式跨模态对齐:分为两个阶段训练,首先使用单主体上下文生成的数据对预训练的文本到图像模型进行微调,然后在生成的多主体数据对上继续训练 -

通用旋转位置嵌入(UnoPE):有效解决了在扩展视觉主体控制时的属性混淆问题

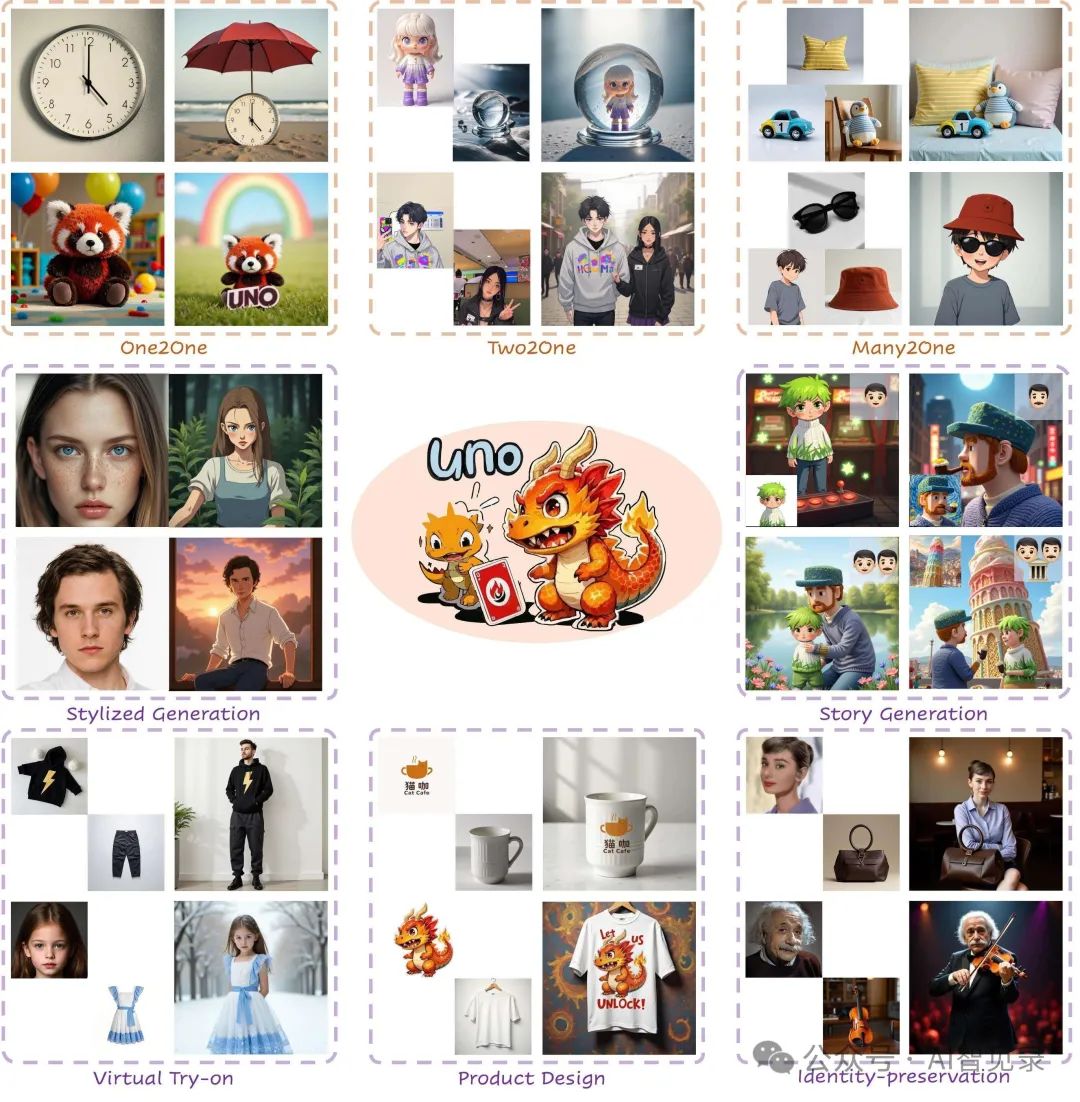

强大的应用场景:一个模型适应多种需求

UNO 模型的强大之处在于它的泛化能力,能够适应多种应用场景:

单主体定制生成

只需提供一张参考图像,UNO 就能生成保持同一主体特征但处于不同场景、姿势或风格的图像。这对于虚拟形象创建、个性化内容生成特别有价值。

多主体组合生成

UNO 能够接收多个参考图像作为输入,生成包含所有参考主体的新图像。这种能力在创意设计、故事板创作等领域有广泛应用。

开源内容:推动 AI 图像生成技术发展

字节跳动已将 UNO 项目完全开源,包括:

-

GitHub 代码仓库:https://github.com/bytedance/UNO -

Hugging Face 模型:https://huggingface.co/bytedance-research/UNO -

项目官网:https://bytedance.github.io/UNO/ -

论文:arXiv:2504.02160

开源内容包括训练代码、推理代码、模型权重等全部资源,展现了字节跳动对开源社区的支持和对 AI 技术共享的承诺。

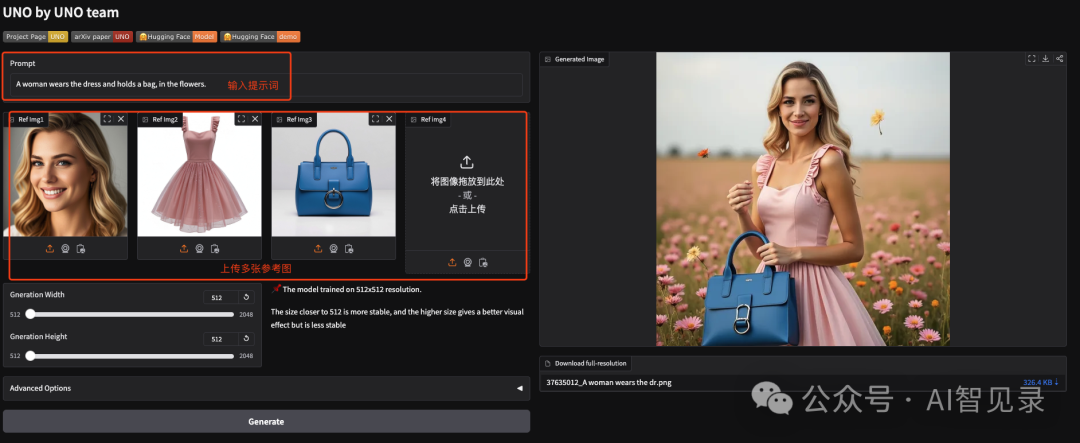

在线体验

可以通过 UNO 提供的 Demo 地址进行在线体验,上传多张图片做为参考图,输入提示词

也可以使用 UNP 提供的示例

技术应用前景广阔

UNO 的出现将为多个领域带来新的可能性:

-

内容创作:创意工作者可以快速生成保持人物一致性的多场景图像 -

电商与广告:产品可以放置在各种场景中,保持其原始特征 -

影视制作:辅助故事板创作,快速可视化多角色场景

负责任的 AI 技术使用

字节跳动在开源说明中强调,UNO 项目主要用于学术研究,项目中使用的绝大多数图像要么是生成的,要么是授权的。他们的代码以 Apache 2.0 许可证发布,而模型则以 CC-BY-NC-ND-4.0 许可证发布。

用户可以使用该工具创建图像,前提是遵守当地法律并负责任地使用。开发者不对用户对工具的任何误用负责。

总结与展望

UNO 的开源发布标志着 AI 图像生成技术又一重要进步。这个模型不仅解决了当前技术面临的数据扩展和主体扩展问题,还展示了”从少到多”的泛化能力,用一个统一的模型实现了多个任务的高质量完成。

字节跳动表示,他们正在积极开发更强大的版本,欢迎社区反馈和建议。可以预见,UNO 将为内容创作者、设计师和开发者提供更强大的工具,推动 AI 创意生成技术的进一步发展。

如果你对 AI 图像生成技术感兴趣,不妨亲自体验一下这个模型,探索它所带来的创意可能性。

参考资料:

-

UNO 项目官网:https://bytedance.github.io/UNO/ -

Hugging Face 模型页面:https://huggingface.co/bytedance-research/UNO -

GitHub 代码仓库:https://github.com/bytedance/UNO -

研究论文:https://arxiv.org/abs/2504.02160 -

https://huggingface.co/spaces/bytedance-research/UNO-FLUX

(文:AI智见录)