前些天,GPT-4o的多模态生图上线之后,引发全球AI社区广泛的关注,吉卜力图画全网风靡。

GPT-4o 采用联合文本、图像、语音和视频进行训练,在一个大模型中同时支持了文本、图像、语音等多个模态,而且其高度可控,在特征保持,上下文理解等重要功能使图像生成进入到了一个新的高度。

在更具挑战性的3D AIGC领域,DreamTech近期推出Neural4D 2o多模态大模型,支持文本及图像输入,实现基于自然语言的交互编辑,这是全球首个支持多模态交互的3D大模型。

Neural4D 2o 通过文本、图像、3D、motion等联合训练多模态 transformer encoder 及3D DiT decoder,在一个大模型中实现了3D生成的上下文一致性、高精准局部编辑、角色ID保持、换装、风格迁移等能力。此外,Neural4D 2o也提供了MCP协议的支持,部署了Neural4D Agent(alpha),帮助用户更加便捷、高质量地完成3D内容创作。

实测效果:

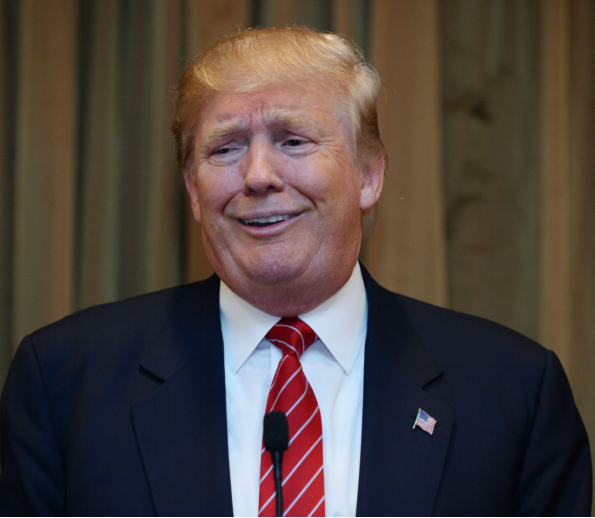

我们上传一张图。

输入prompt:“保持他的长相、表情和穿着,生成一个全身的Q版形象。“

继续输入prompt:”保持他的表情、Q版风格。把角色的衣服换成火影忍者中佩恩六道的衣服,胳膊自然张开45度,手掌向下,给人一种关税战中俯视消灭众生的感觉。”

prompt:“不要改变发型,重新生成。“

上传一张新图:

Prompt:”把图二的表情加到角色上。体现出来特朗普关税战被反制后哭泣形象。”

打开手机AR:

让我们把这个做成实物手办:

一套操作下来简直amazing,以前动动手就能P图,现在动动手就能抠 3D 模型了。

实际试用下来,在稳定性、上下文一致性、局部编辑、角色ID保持能力已经相当完善,唯一不足的是目前交互等待的时间较长,平均还需要2-5分钟,用户使用时还会碰上排队的情况,大概率是服务器不够用了。

这对3D设计师来说将是一个巨大利好,以往AI生成的3D模型,最让设计师头疼的就是编辑和修改,以至于大多只能拿来作为概念设计或者粗模参考,虽然减少了设计过程中的一些试错成本和时间,但仍然需要把AI模型导入到ZBrush、Blender、3DS Max、Maya等工具,通过更长时间的修改,才能得到真正想要的模型。而在Neural4D 2o的支持下,现在只需要通过对话交流,就能做到专业3D设计师才有的建模能力,人人都是3D设计师的时代即将来临。

上链接:

https://www.neural4d.com/n4d-2o

团队介绍:

DreamTech 深耕于 3D及4D AI 技术领域,致力于用创新的产品和服务提升全球 AIGC 创作者及消费者的使用体验,公司的愿景是利用先进的 AI 技术打造与真实世界无缝对接、实时互动的 4D 时空体验,并通过模拟真实世界的复杂性和多样性实现通用人工智能 (AGI)。

(文:Z Potentials)