本文内容源于《Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4》(https://arxiv.org/pdf/2312.16171v1#page=1.62)论文的翻译和提炼。

由于笔者近几天比较忙,没时间上新的实践教程,故把之前整理比较有用的一些大模型相关的知识提供给观众姥爷。希望你在智能体写提示词时候能用上

📌 论文简介

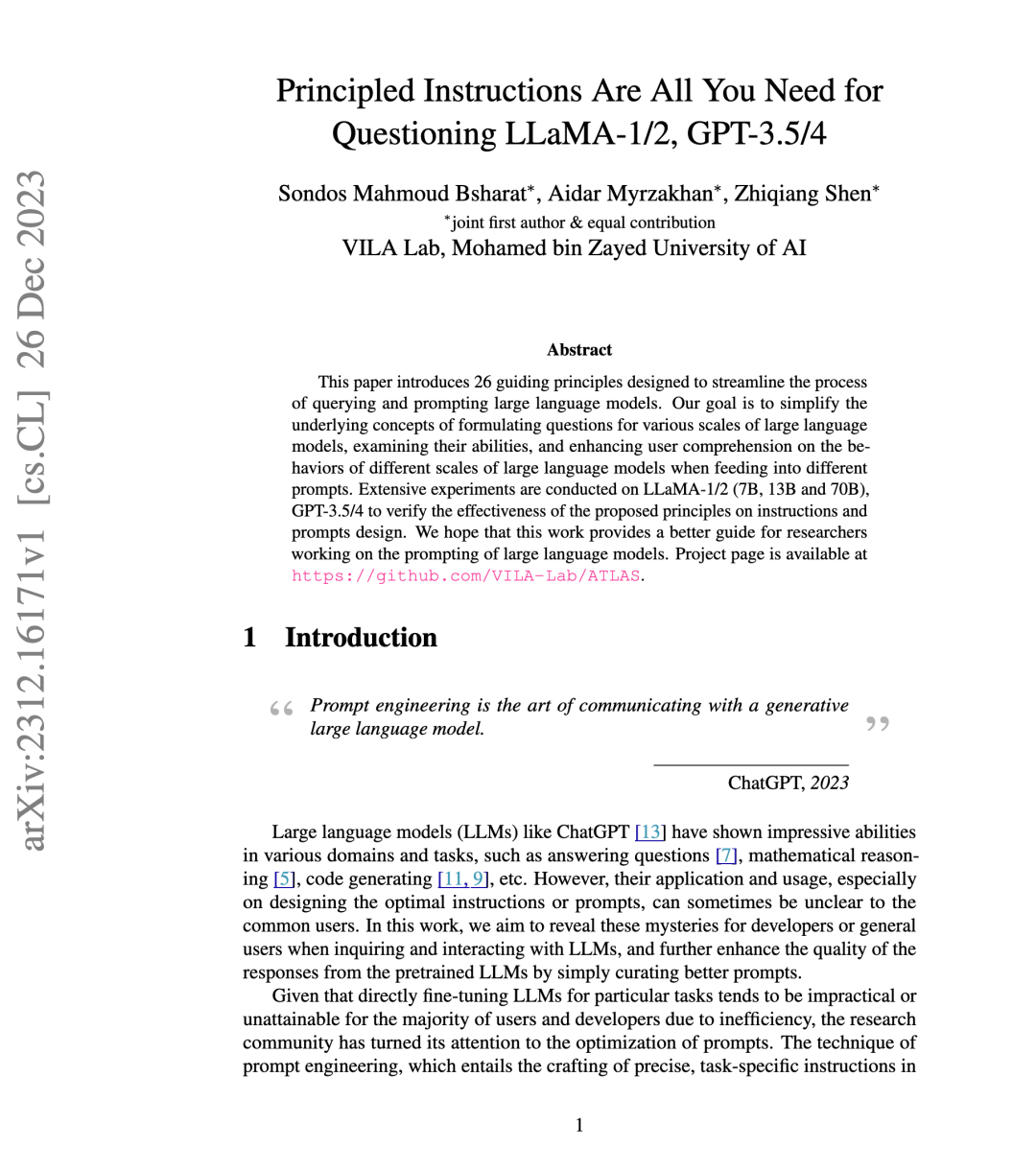

本文提出了26条指导原则,旨在简化与大型语言模型(如LLaMA-1/2、GPT-3.5/4、DeepSeek等)交互时的提问和提示设计过程。通过这些原则,用户可以更有效地与不同规模的模型进行交流,提升模型的响应质量。研究通过在LLaMA-1/2(7B、13B、70B)和GPT-3.5/4上的广泛实验,验证了这些原则在指令和提示设计中的有效性。项目主页:https://github.com/VILA-Lab/ATLAS。:contentReference[oaicite:1]{index=1}

🎯 核心原则概览

- 明确任务:使用“你的任务是……”等明确的语言来指示模型的任务。

- 强调重要性:使用“你必须……”等词语来增强任务的紧迫感。

- 设定后果:引入“如果回答错误,将会受到惩罚”等后果,以提高模型的认真程度。

- 角色扮演:为模型分配特定角色,如“你是一位经验丰富的医生”,以引导其响应风格。

- 逐步思考:鼓励模型“逐步思考”,以提高推理质量。

- 简化语言:使用简单明了的语言,避免复杂或双重否定的表达。

- 示例驱动:通过提供示例来引导模型理解任务。

- 允许提问:鼓励模型在回答前提出 clarifying questions,以确保理解任务。

- 分解任务:将复杂任务分解为更小的子任务,逐步引导模型完成。

- 使用分隔符:在提示中使用清晰的分隔符(如“—”)来区分不同部分。

🧠 26条提示设计原则(Principled Instructions)

-

明确任务指令:使用诸如“你的任务是……”或“你必须……”等明确的语言,清晰地传达任务要求。

-

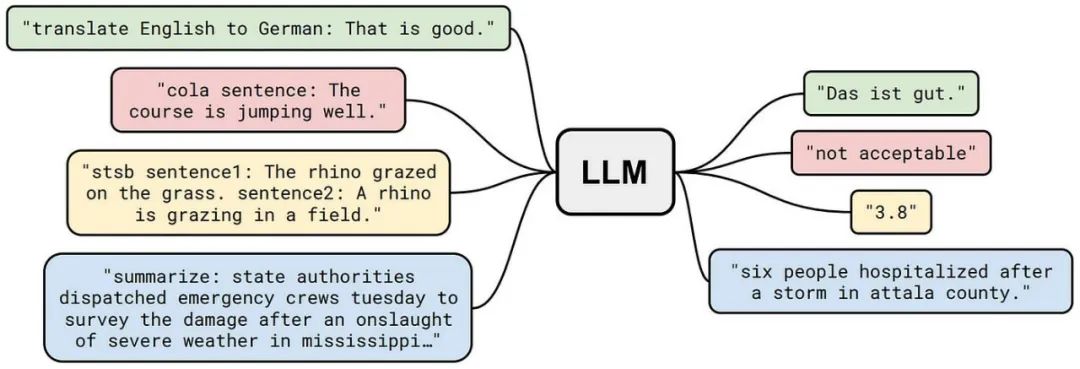

指定目标受众:在提示中明确指出目标读者,例如“面向医学专业人士”或“为小学生解释”。

-

分解复杂任务:将复杂的任务拆分为更小的子任务,逐步引导模型完成。

-

使用肯定性指令:采用积极的语言,如“请执行……”而非“不要……”,以减少模型的误解。

-

简化语言表达:使用简单明了的语言,避免复杂或双重否定的表达。

-

提供上下文信息:在提示中包含相关背景信息,帮助模型更好地理解任务。

-

采用Few-shot示例:通过提供示例来引导模型理解任务要求。

-

明确输出格式:指定所需的输出格式,例如“请以列表形式回答”或“生成JSON格式的数据”。

-

强调任务重要性:使用“你必须……”等词语来增强任务的紧迫感。

-

设定后果:引入“如果回答错误,将会受到惩罚”等后果,以提高模型的认真程度。

-

鼓励提问:允许模型在回答前提出澄清性问题,以确保理解任务。

-

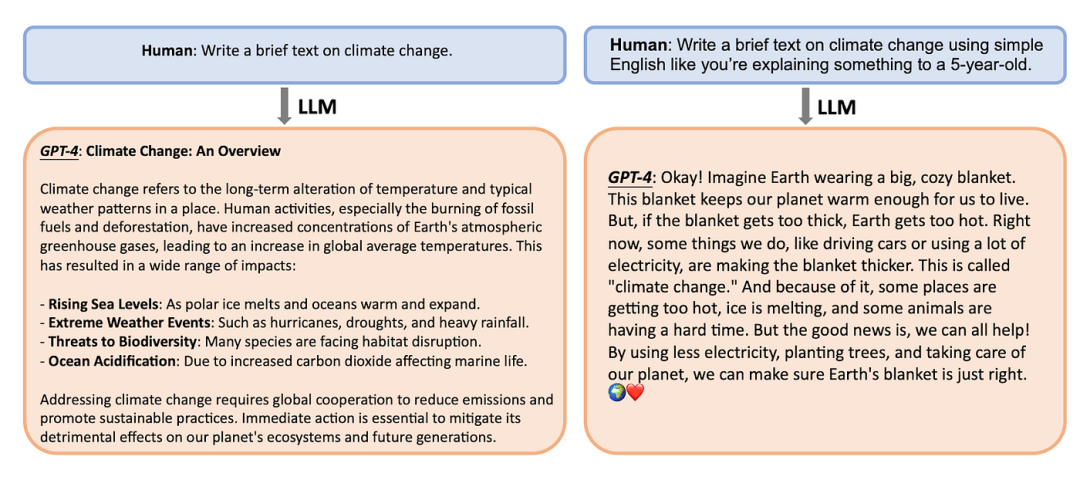

逐步思考(CoT):鼓励模型“逐步思考”,以提高推理质量。

-

使用输出引导词:在提示末尾添加期望的输出开头,引导模型生成符合预期的内容。

-

允许模型提问:鼓励模型在不确定时提出问题,以获取更多信息。

-

测试理解:要求模型在回答后进行自我检查或测试,以验证其理解。

-

赋予角色:为模型分配特定角色,如“你是一位经验丰富的医生”,以引导其响应风格。

-

使用分隔符:在提示中使用清晰的分隔符(如“—”)来区分不同部分。

-

明确输出长度:指定所需的输出长度,例如“请生成100字以内的摘要”。

-

结合CoT与Few-shot:将逐步思考与示例结合,增强模型的推理能力。

-

使用输出引导语:在提示中提供期望输出的开头,引导模型生成符合预期的内容。

-

要求详细说明:指示模型提供详细的解释或描述,以增强回答的深度。

-

指定输出结构:明确要求模型按照特定的结构或格式输出内容。

-

保持写作风格一致:确保生成的内容在语气、风格和格式上与提供的示例一致。

-

使用特定开头:在提示中提供特定的开头词语或句子,引导模型生成相关内容。

-

明确内容要求:清晰地列出模型在生成内容时必须遵循的关键词、规则或提示。

-

模仿示例语言:要求模型使用与提供的段落、标题或文本相同的语言风格。

📘 总结

通过遵循这26条指导原则,用户可以更有效地与大型语言模型进行交互,无需进行复杂的模型微调。这些原则为提示设计提供了实用的框架,适用于从研究人员到日常用户的广泛群体。这些原则来源于提示词工程指南,感兴趣的小伙伴可以进行查阅: https://www.promptingguide.ai/

(文:PyTorch研习社)