今天凌晨5点,阿里巴巴开源了最新大模型——Qwen3。

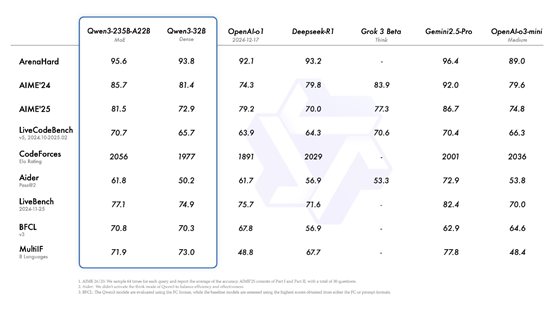

根据最新测试数据显示,Qwen3 在ArenaHard、AIME 24/25、LiveCodeBench、CodeForces、Aider等测试平台中,全部超过了DeepSeek开源的R1以及OpenAI的o1等著名模型。

体验地址:https://chat.qwen.ai/

开源地址:https://github.com/QwenLM/Qwen3

笑脸:https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

本次阿里一共开源了两个 MoE 模型的权重:Qwen3-235B-A22B,一个拥有 2350 多亿总参数和 220 多亿激活参数的大模型,以及Qwen3-30B-A3B,一个拥有约 300 亿总参数和 30 亿激活参数的小型 MoE 模型。

6个 Dense 模型也已开源,包括 Qwen3-32B、Qwen3-14B、Qwen3-8B、Qwen3-4B、Qwen3-1.7B 和 Qwen3-0.6B并且全部支持Apache 2.0 商用。

Qwen3的亮点功能是支持两种思考模式,思考模式下模型会逐步推理,经深思熟虑后给出最终答案,适合需要深入思考的复杂问题;

非思考模式中模型提供快速、近乎即时的响应,适用于对速度要求高于深度的简单问题。

用户也可以根据具体任务控制模型进行 “思考” 的程度,复杂问题通过扩展推理步骤解决,简单问题直接快速作答,无需延迟。

此外,Qwen3除了支持中文之外,还支持葡萄牙语、德语、罗马尼亚语、瑞典语、丹麦语、保加利亚语等119种语言,覆盖范围非常广。同时阿里还增强了Qwen3 模型对 Agent和代码能力,支持MCP服务。

在预训练方面,Qwen3 的数据集相比 Qwen2.5 有了显著扩展。Qwen2.5是在 18 万亿个token 上进行预训练的,而 Qwen3 使用的数据量几乎是其两倍,达到了约 36 万亿个 token,涵盖了119 种语言和方言。

为了构建这个庞大的数据集,阿里不仅从网络上收集数据,还从 PDF 文档中提取信息。阿里使用 Qwen2.5-VL 从这些文档中提取文本,并用 Qwen2.5 改进提取内容的质量。

为了增加数学和代码数据的数量,阿里利用 Qwen2.5-Math 和 Qwen2.5-Coder 这两个数学和代码领域的专家模型合成数据,合成了包括教科书、问答对以及代码片段等多种形式的数据。

预训练过程分为三个阶段。在第一阶段(S1),模型在超过 30 万亿个token 上进行了预训练,上下文长度为 4K token。这一阶段为模型提供了基本的语言技能和通用知识。在第二阶段(S2),阿里通过增加知识密集型数据的比例来改进数据集,随后模型又在额外的 5 万亿个 token 上进行了预训练。在最后阶段,阿里使用高质量的长上下文数据将上下文长度扩展到32K token,确保模型能够有效地处理更长的输入。

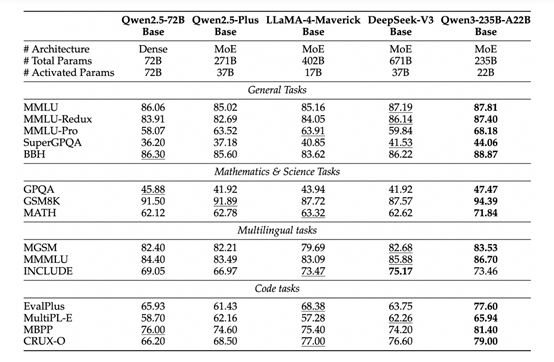

由于模型架构的改进、训练数据的增加以及更有效的训练方法,Qwen3 Dense 基础模型的整体性能与参数更多的Qwen2.5基础模型相当。例如,Qwen3-1.7B/4B/8B/14B/32B-Base 分别与Qwen2.5-3B/7B/14B/32B/72B-Base 表现相当。

特别是在 STEM、编码和推理等领域,Qwen3 Dense 基础模型的表现甚至超过了更大规模的Qwen2.5 模型。

对于 Qwen3 MoE 基础模型,在仅使用 10% 激活参数的情况下达到了与 Qwen2.5 Dense 基础模型相似的性能。这带来了训练和推理成本的显著节省。

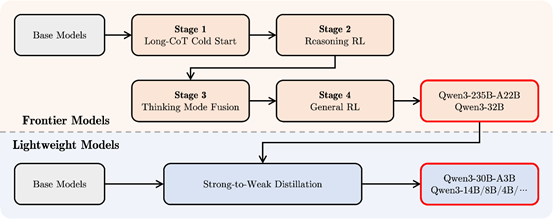

为了开发能够同时具备思考推理和快速响应能力的混合模型,阿里实施了一个四阶段的训练流程。该流程包括:(1)长思维链冷启动,(2)长思维链强化学习,(3)思维模式融合,以及(4)通用强化学习。

在第一阶段,阿里使用多样的的长思维链数据对模型进行了微调,涵盖了数学、代码、逻辑推理和 STEM 问题等多种任务和领域。这一过程旨在为模型配备基本的推理能力。第二阶段的重点是大规模强化学习,利用基于规则的奖励来增强模型的探索和钻研能力。

在第三阶段,阿里在一份包括长思维链数据和常用的指令微调数据的组合数据上对模型进行微调,将非思考模式整合到思考模型中。确保了推理和快速响应能力的无缝结合。

第四阶段,在包括指令遵循、格式遵循和 Agent 能力等在内的 20 多个通用领域的任务上应用了强化学习,以进一步增强模型的通用能力并纠正不良行为。

(文:AIGC开放社区)