昨天,全球著名开源大模型平台DeepSeek在huggingface发布了,超强开源模型V3的论文。

主要从硬件架构和模型设计的双视角探讨如何在不牺牲性能的前提下实现更高效的大规模训练和推理以突破硬件瓶颈。

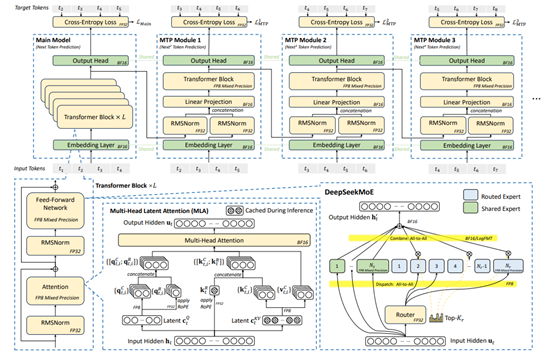

其中,DeepSeek-MoE和多头潜在注意力、FP8混合精度训练以及多标记预测等成为关键创新技术。

论文地址:https://huggingface.co/papers/2505.09343。

随着OpenAI GPT-3、DeepSeek-R1、Claude-3.7 Sonnet等前沿模型的出现,对硬件、算力资源的需求快速上升。在内存方面,大模型对内存资源的需求每年增长超过1000%,但高速内存容量的增长速度却极为缓慢,每年通常不到50%。

这一内存供需失衡的问题严重制约了大模型的进一步发展。在计算效率上,传统的计算架构难以满足大规模模型训练和推理的高效需求。

在互连带宽方面,现有网络架构在处理大规模数据传输时也面临着带宽不足和延迟过高等难题,而DeepSeek-V3通过软件、硬件创新解决了这些难题。

DeepSeek-MoE和多头潜在注意力

DeepSeek-MoE充分挖掘了混合专家(MoE)架构的潜力,其优势主要体现在两方面。其一,在训练过程中,通过选择性地激活专家参数的子集,MoE模型能够在大幅增加总参数数量的同时保持相对适度的计算需求。

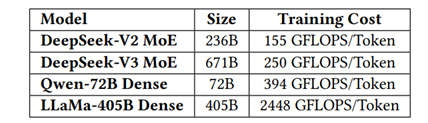

例如,DeepSeek-V2拥有2360亿参数,但每个token仅激活210亿参数;而DeepSeek-V3扩展到了6710亿参数,几乎是V2的三倍,可每个token的激活量仅为370亿。相比之下,像Qwen2.5-720亿和LLaMA3.1-4050亿等密集模型在训练期间则需要激活所有参数。

数据显示,DeepSeekV3的总计算成本约为每token 250 GFLOPS,而720亿参数的密集模型需要394 GFLOPS,4050亿参数的密集模型更是需要2448 GFLOPS。这表明MoE模型在计算资源消耗量少一个数量级的情况下,能够实现与密集模型相当甚至更优的性能。

在个人使用和本地部署场景中,MoE模型同样展现出独特优势。由于每个请求仅激活一小部分参数,内存和计算需求大幅降低。

例如,搭载AISoC芯片的个人电脑,在运行DeepSeek-V2(2360亿参数)时,推理过程中仅激活210亿参数,就能达到近每秒20个Token甚至更高的速度,这对于个人使用来说已经绰绰有余。而类似能力(如700亿参数)的密集模型在相同硬件条件下,通常只能达到个位数的TPS。

多头潜在注意力(MLA)架构则通过压缩键值(KV)缓存显著降低了内存消耗。它利用投影矩阵将所有注意力头的KV表示压缩成一个更小的潜在向量,并与模型联合训练。在推理过程中,只需要缓存该潜在向量,与存储所有注意力头的KV缓存相比,大大减少了内存占用。

通过采用MLA,DeepSeek-V3显著减少了KV缓存大小,每个token仅需70KB,远低于LLaMA-3.1 4050亿参数模型的516KB和Qwen-2.5 720亿参数模型的327KB。

此外,为进一步减小KV缓存的大小,DeepSeek还提出了多种方法。例如共享KV,即多个注意力头共享一组KV配对,以显著压缩KV存储,代表性方法包括GQA和MQA;

窗口KV,对于长序列,仅在缓存中保留KV配对的滑动窗口;量化压缩,使用low-bit存储KV配对,进一步减少内存使用。

FP8混合精度训练方法

在训练技术方面,DeepSeek-V3引入了FP8混合精度训练技术,这在保证模型质量的同时大幅降低了计算成本,使得大规模训练更加经济可行。虽然GPTQ和AWQ等量化技术已将位宽减少到8位、4位甚至更低,但这些技术主要应用于推理阶段以节省内存,在训练阶段的应用相对较少。在DeepSeek-V3之前,几乎没有利用FP8进行训练的开源大型模型。

DeepSeek通过基础设施和算法团队之间的深度合作,为MoE模型开发了与FP8兼容的训练框架,在训练管道中使用FP8精度的前向和后向过程计算组件。然而,要充分发挥FP8在加速训练方面的巨大潜力,还需要解决一些硬件限制。

例如,FP8在Tensor Core中使用约束累加精度,这会影响训练大型模型的稳定性;细粒度量化在传输部分结果时会引入大量的反量化开销,导致频繁的数据移动,降低计算效率并使硬件利用率复杂化。

针对这些问题,DeepSeek也对未来硬件设计提出了相应建议。在提高累积精度方面,硬件应改进并调整Accumulation Register精度到适当的值(如FP32),或支持可配置的Accumulation Precision;

在对原生细粒度量化的支持方面,硬件应支持原生细粒度量化,使Tensor Core能够接收缩放因子并通过组缩放实现矩阵乘法,避免频繁的数据移动以减少去量化开销。

在网络通信环节,DeepSeek-V3架构采用低精度压缩进行网络通信。在EP并行期间,使用细粒度的FP8量化来调度令牌,与BF16相比,通信量减少了50%,显著缩短了通信时间。DeepSeek建议,为FP8或自定义精度格式定制的压缩和解压缩单元提供本机支持,是未来硬件的可行发展方向,这有助于最大限度地减少带宽需求并简化通信管道,大幅提升MoE训练等带宽密集型任务的效率。

多标记预测

在传统的自回归语言模型中,推理过程是逐个生成标记的。每次生成一个标记后,模型需要根据已生成的上下文信息来预测下一个标记。这种顺序生成的方式虽然能够保证生成的连贯性和准确性,但其推理速度受限于每个标记的生成时间。随着模型规模的增大和上下文长度的增加,这种顺序生成的方式会显著降低推理效率,尤其是在需要快速生成长文本的场景中。

为了克服这一瓶颈,DeepSeek-V3引入了多标记预测(MTP)框架。该框架允许模型在每个推理步骤中同时生成多个候选标记,而不是仅仅生成一个标记,这些候选标记可以并行计算和验证,从而显著减少了生成整个序列所需的时间。

MTP框架通过引入多个轻量级的预测模块来实现这一目标,每个预测模块负责生成一个特定位置的标记。例如,在生成当前标记的同时,MTP模块可以预测下一个标记、下下个标记等,这些预测模块共享模型的上下文信息,但各自独立生成标记。通过这种方式,模型能够在一次推理步骤中生成多个标记,而不是逐个生成。

生成多个候选标记后,MTP框架会通过并行验证来确定哪些候选标记是合理的。这一过程利用了模型的上下文信息和已生成的标记,通过一系列的验证步骤来评估每个候选标记的合理性,最终模型会选择最合适的标记作为输出。

实验数据显示,MTP模块在预测下一个标记时的接受率高达80%至90%,这意味着大多数情况下,模型能够准确预测下一个标记,从而显著提高了推理速度。

多平面双层胖树网络降低算力集群成本

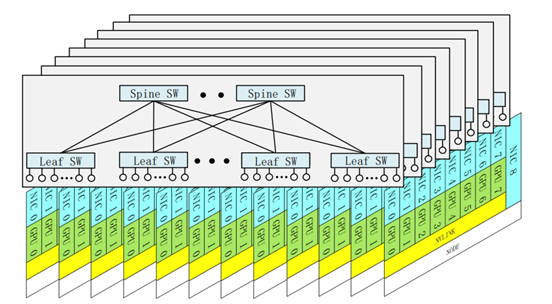

在AI基础设施方面,DeepSeek为了降低集群网络成本,使用多平面双层胖树网络,取代了传统的三层胖树拓扑结构。

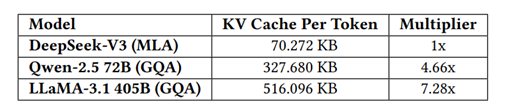

在DeepSeek-V3的训练过程中,部署了一个多平面胖树(MPFT)横向扩展网络。每个节点配备8台GPU和8个IB网卡,每个GPU-网卡对分配到不同的网络平面。此外,每个节点还配备一个400 Gbps以太网RoCE网卡,连接到单独的存储网络平面,用于访问3FS分布式文件系统。

在横向扩展网络中,使用了64端口400G IB交换机,该拓扑理论上最多可支持16,384台GPU,同时保留了双层网络的成本和延迟优势,但受政策和监管限制,最终部署的GPU数量为2048台。

由于IB ConnectX-7目前存在局限性,DeepSeek部署的MPFT网络未能完全实现预期架构。理想情况下,每个网卡(NIC)应具有多个物理端口,每个端口连接到单独的网络平面,但通过端口绑定,共同作为单个逻辑接口向用户公开。

从用户角度看,单个队列对(QP)可以在所有可用端口之间无缝地发送和接收消息,类似于数据包喷射。因此,来自同一QP的数据包可能会穿越不同的网络路径,并以无序方式到达接收方,这就需要网卡内原生支持无序布局,以保证消息一致性并保留正确的排序语义。

例如,InfiniBand ConnectX-8原生支持四平面。若未来的网卡能够完全支持高级多平面功能,双层胖树网络将能更有效地扩展到更大的AI集群。总体而言,多平面架构在故障隔离、稳健性、负载均衡和大规模系统可扩展性方面具有显著优势。

低延迟网络设计优化

在模型推理过程中,大规模EP严重依赖all-to-all通信,而这种通信对带宽和延迟都极为敏感。例如,在50GB/s的网络带宽下,理想情况下数据传输大约需要120微秒,因此,微秒级的固有网络延迟会对系统性能产生严重影响,不容忽视。

为降低网络通信延迟,DeepSeek选用了InfiniBand GPUDirect Async(IBGDA)。传统网络通信需要创建CPU代理线程:GPU准备好数据后,需通知CPU代理,然后CPU代理填充工作请求(WR)的控制信息,并通过门铃机制向NIC发出信号以启动数据传输,这一过程会带来额外的通信开销。

而IBGDA允许GPU直接填充WR内容并写入RDMA门铃MMIO地址,通过在GPU内部管理整个控制平面,消除了与GPU-CPU通信相关的显著延迟开销。此外,在发送大量小数据包时,控制平面处理器容易成为瓶颈,而GPU具有多个并行线程,发送方可以利用这些线程分配工作负载,从而避免此类瓶颈。

包括DeepSeek的DeepEP在内的一系列工作都利用了IBGDA,并报告取得了显著的性能提升,因此,DeepSeek提倡在各种加速器设备上广泛支持此类功能。

虽然IB在延迟性能上优于基于融合以太网的RDMA(RoCE),是分布式训练和推理等延迟敏感型工作负载的首选,但它也存在成本较高和扩展性方面的问题。RoCE虽有可能成为IB的经济高效替代方案,但其目前在延迟和可扩展性方面的限制,使其尚无法完全满足大规模AI系统的需求。

为此,DeepSeek给出了一些改进RoCE的具体建议,包括使用专用低延迟RoCE交换机、优化路由策略、改进流量隔离或拥塞控制机制等。

(文:AIGC开放社区)