最近我接到一个看似简单的任务:拿着几千条数据丢给DeepSeek大模型做分析,然后生成一份PDF分析报告。

听起来简单?许多人说”直接丢给大模型就行了”。

但当我真正坐下来操作时,才发现提示词的每一个字都不是随便写的。这个看似简单的产品开发任务,结结实实给我上了一门提示词工程的硬核课程。

今天,我将分享7个在实际产品开发中遇到的提示词技巧和坑点。这些都是血泪经验,建议收藏慢慢品。

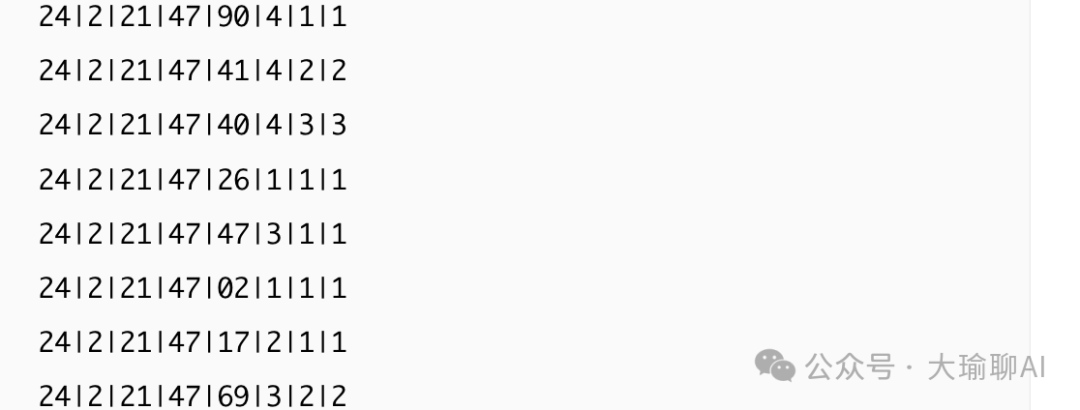

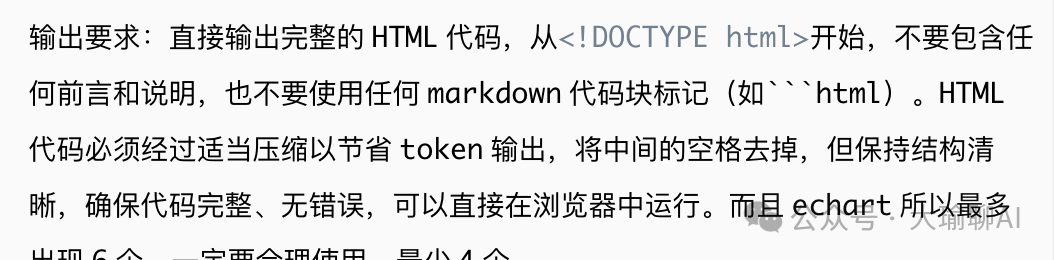

一、如何突破token限制,塞下更多内容?

大家知道deepseek的API上下文最多是64k,单次输出默认是4k,最大是8ktoken。

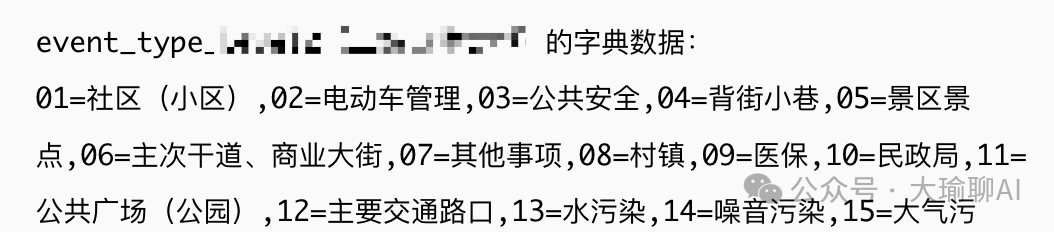

几千条数据意味着每一条数据的token也就是20左右。随便不到30个中文就占完了,那么神药就是:用字典来代替中文,从而减少token的数量。

看起来不直观?没关系,大模型****能看懂。我们在提示词中用数据字典建立对应关系,教会模型如何解读这些简化数据:

这样处理后,我们可以在相同token限制下处理多3-5倍的数据量!

二、实用性和准确性永远是第一特性

我们生成报告,数据的实用性和准确性才是最重要的,接下来才是排版。

在开发过程中,我曾一度过分重视报告的排版和美观度。为了让报告更专业,引入了ECharts图表库,结果随着图表数量增多,输出token暴增,导致生成的HTML报告各种奇怪问题。

所以,痛下决心,将实用性和准确性排在第一位,这样输出的token也少了,界面出错的概率也低了。

实战建议:

-

1. 先让模型生成纯文本分析 -

2. 确保分析准确后,再考虑添加可视化元素 -

3. 每增加一个图表,都要测试对输出质量的影响

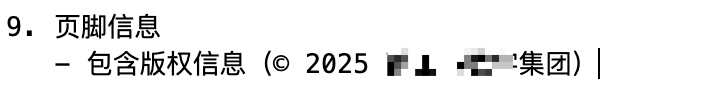

三、要求他干啥很重要,要求他不许干啥也很重要

我的提示词原来是这样写的:想要在底部生成“版权信息”,于是就写了下面的提示词。

生成的结果却是这样,偶尔还给我加个生成时间等乱七八糟内容。

最后加上下面的约束,结果瞬间不一样了,每次都会老老实实生成结果信息。

四、幻觉避免不了,用框架约束它

因为大模型的”幻觉”特性,导致每次生成的报告都不一致。有时候明明是相同的数据,却得出完全不同的结论。

应对策略:制定严格的报告框架,在框架内约束模型发挥

你必须严格按照以下框架生成报告:

1. 执行摘要(不超过100字)

2. 核心发现(必须包含3-5个要点,每个要点必须直接基于输入数据)

3. 详细分析(分为以下几个固定部分)

a. 用户满意度分析

b. 价格敏感度分析

c. 功能改进建议

4. 结论(必须基于上述分析,不得引入新信息)五、提示词格式很重要:分点描述胜过长段落

这样阅读也清晰很多,大模型也会按照顺序去阅读,最终按照要求生成。

下面这种就清爽很多。

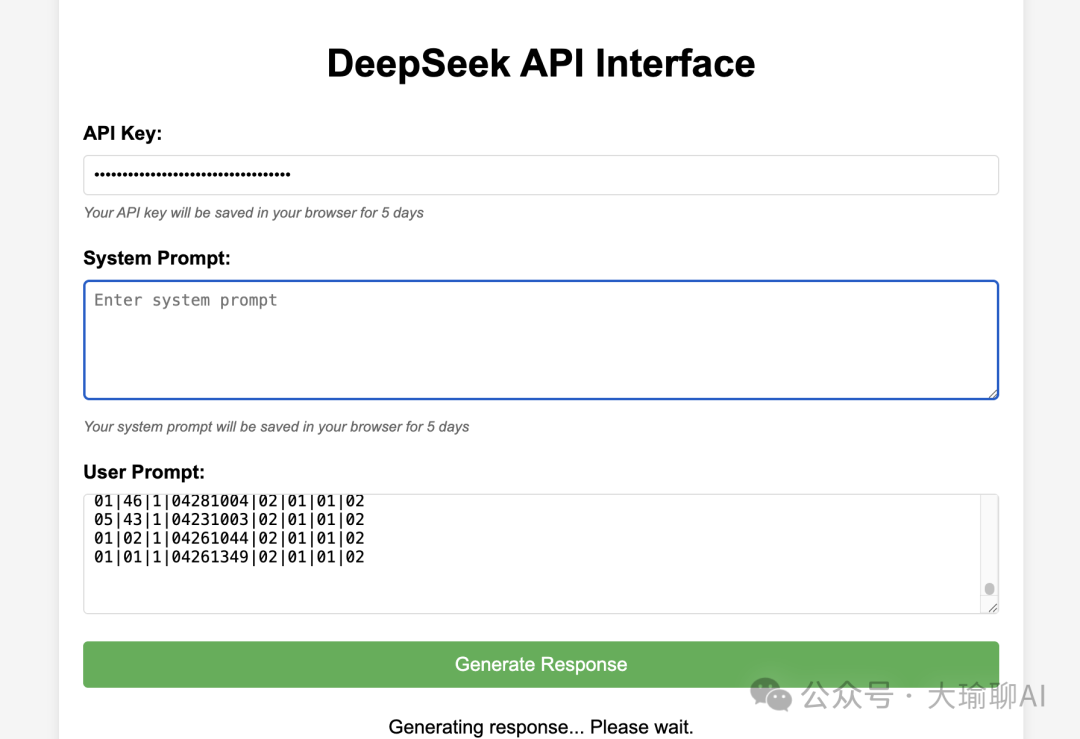

六、灵活开发小工具提升效率

测试大模型,一般是通过postman等接口调试工作来做,但是我们的比较特殊,需要生成并保存成html文件运行。

所以我就用cursor很快做了两个小软件。

1、界面调试页面。

可以直接保存提示词,点击“generate”就会将自动生成的html预览界面,减少了重复的操作。

这个工具可以:

-

• 保存不同版本的提示词 -

• 一键生成HTML并实时预览 -

• 大幅减少重复操作

2、token数值计算工具。输入测试值,快速计算token的数值。

这两个工具都是用Cursor开发的,几乎不费什么功夫。建议在日常工作中,遇到重复性操作,都可以考虑自己开发小工具提效。

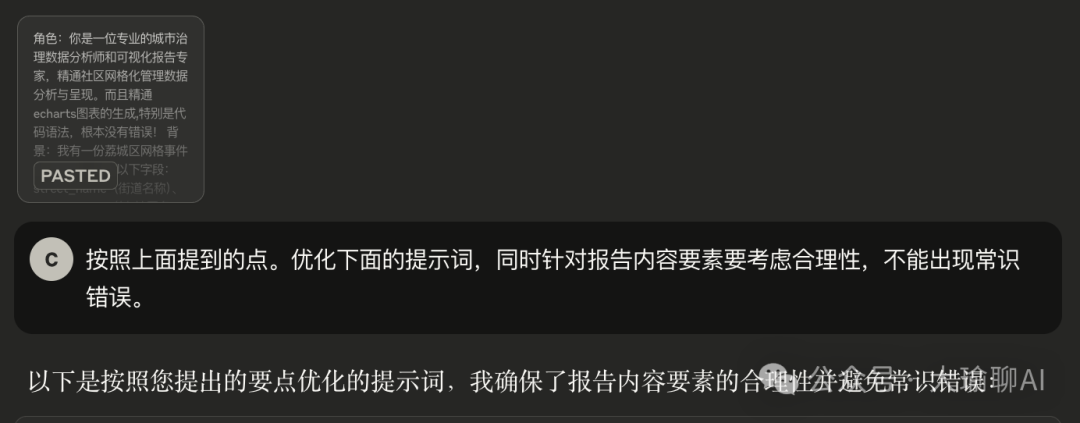

七、借助大模型优化提示词

写好的初稿,可以丢给大模型,让大模型分析下提示词是否有缺陷,是否有未考虑的地方,然后再给你一份新的提示词。

优化提示词,我特别推荐Claude。它对提示词结构和潜在问题的分析非常到位。

写在后面的话

随着提示词的编写,越来越觉得,每一句话都不是废话。

好的提示词能让AI成为你的得力助手,糟糕的提示词只会让你陷入无尽的调试噩梦。

有收获的,记得点个赞吧。我是大瑜,1个工作十年的程序员,AI编程和AI工具的实践者。

(文:大瑜聊AI)