Sora正式版千呼万唤始出来,不过对于AI视频爱好者来说,有两个不友好的问题:一是OpenAI对中国地区不开放,用梯子访问非常不稳定且极其容易被封;二是费用不菲,最低入门套餐也要数百元。

其实还有隐含的不友好,无法涩涩。

这些问题也不是不能解决,用开源AI视频工具就可以了。

如今,最好的选择,是腾讯混元。

需要明确的是,AI视频对显卡要求比较高,动辄30G甚至40G显存起步,想要真正玩好AI视频,A100这类的专用算力卡是比较合适的。

但对于普通爱好者来说,如果有足够的闲情逸致,可以时间换空间,用消费级显卡来跑量化版。

最近,有开发者把混元AI视频大模型量化到了8G显存可用(我用的是12G的3060)。

当然了,仅仅是能跑得起来而已,差不多要十几分钟才能跑出几秒钟的视频。

比较好的应用场景是提前做好批跑的提示词,然后人去做别的事,等几小时回来搜集整理视频。

一、模型的下载和安装

我把本文用得到的模型打包上传,可以一并下载:

https://pan.quark.cn/s/378513f20ef3

1、混元量化模型

安装路径:

ComfyUI\models\diffusion_models\hunyuan_video_720_cfgdistill_fp8_e4m3fn.safetensors

ComfyUI\models\diffusion_models\hunyuan_video_720_cfgdistill_bf16.safetensors

分别是fp8量化版本(8G显存可跑)和bf16量化版本(12G显存可跑)。

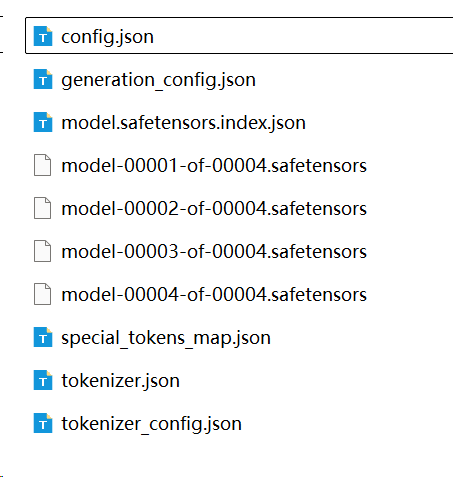

2、TextEnCoder编码器

整个文件夹拷贝至:

ComfyUI\models\llm\llava-llama-3-8b-text-encoder-tokenizer

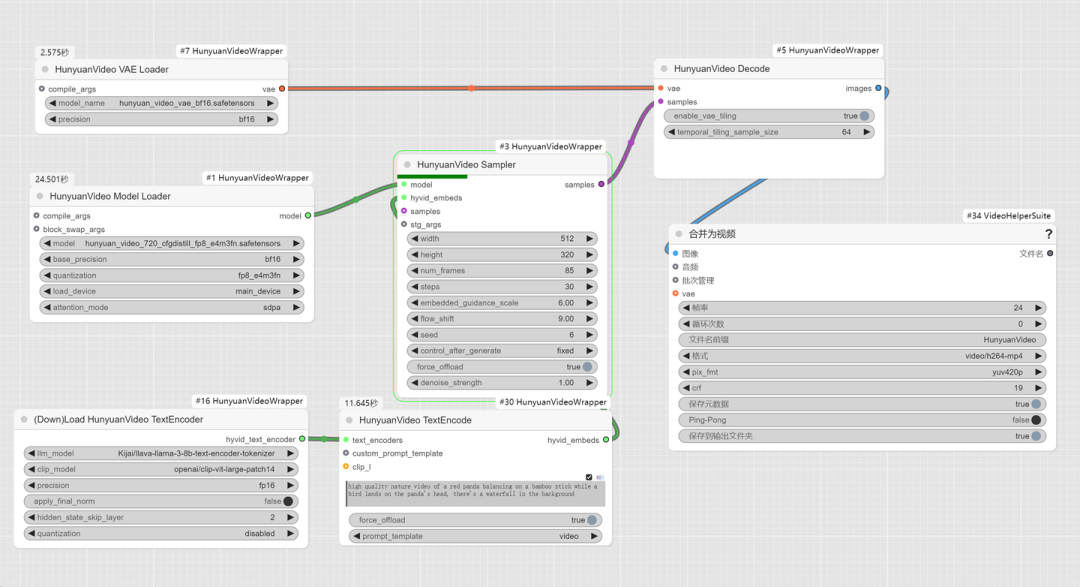

3、混元VAE模型

安装路径:

ComfyUI\models\vae\hunyuan_video_vae_bf16.safetensors

ComfyUI\models\vae\hunyuan_video_vae_fp32.safetensors

分别是bf16量化版本和fp32版本,建议用bf16。

4、Clip模型

安装路径:

ComfyUI\models\clip\clip-vit-large-patch14

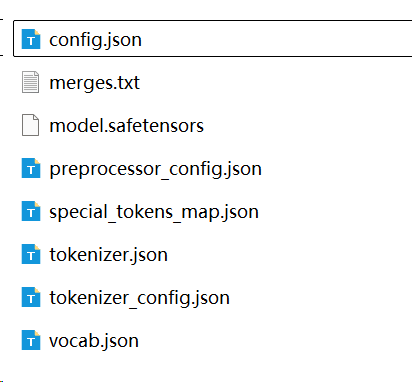

二、工作流介绍

我放上了两个工作流,一个是文生视频,一个是视频生视频。

二者基本玩法差不多,以文生视频为例:

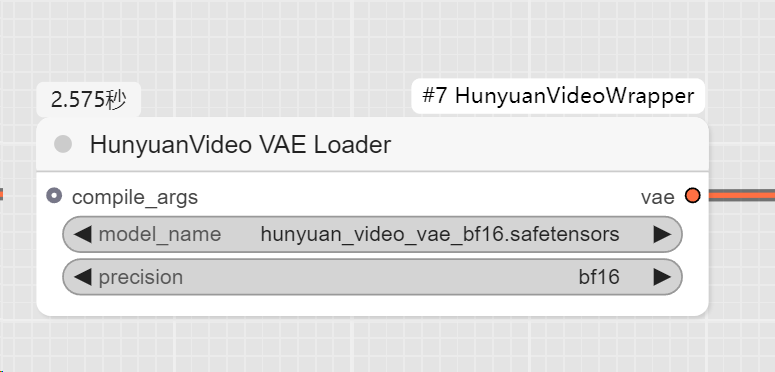

1、混元VAE模型加载

推荐bf16量化版本

2、混元视频模型

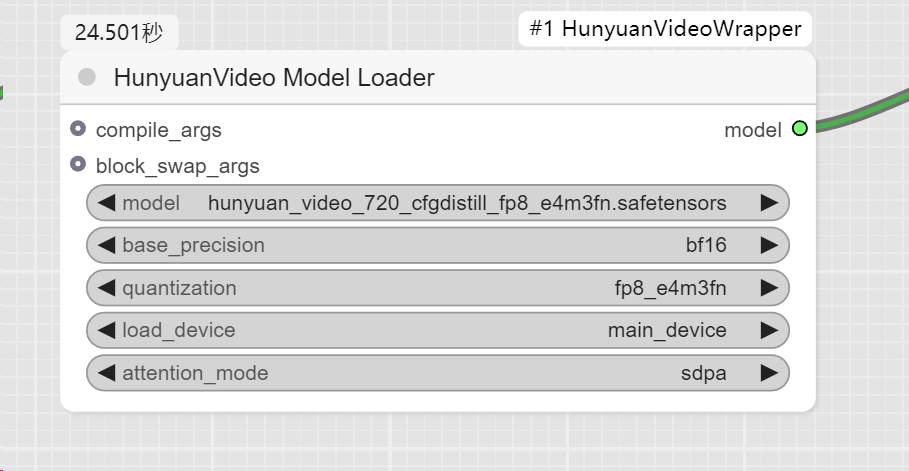

建议fp8版本,如果显存12G,load_device可以开main_device,速度会快一些,如果是8G显存,建议关闭(offoad_device)

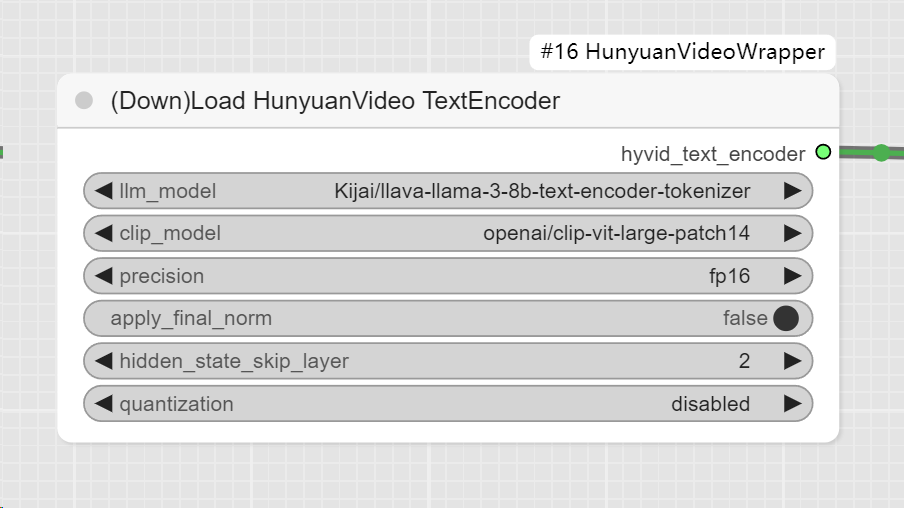

3、加载编码器

建议按照图例配置,不要擅自修改。

4、视频生成参数

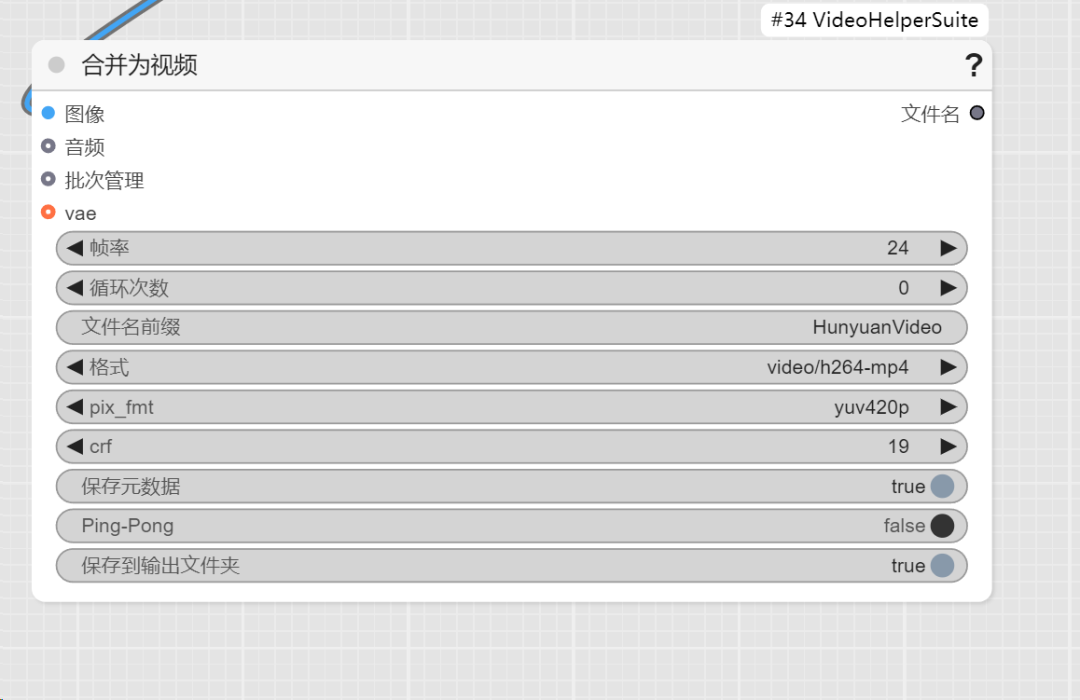

根据实际情况,适当调整帧率(帧率越低生成速度越快)。

三、视频示例:

再次提醒,生成视频速度比较慢,工作流跑起来不报错就不用管了。

去下个馆子回来看看就有了。

1、文生视频

2、视频生视频

四、注意事项

1、生成的视频为黑屏,请升级Torch到2.5.1版本。

2、本模型可以NSFW!

下载:

https://pan.quark.cn/s/378513f20ef3

(文:路过银河AI)