Claude 和 ChatGPT 最大的区别,都藏在“系统提示词”里。

Claude 4 昨天上线了。

挺重磅的,圈里圈外都是关于它的声音。

一如既往,在 claude.ai 背后,藏着比模型更值得聊的东西。

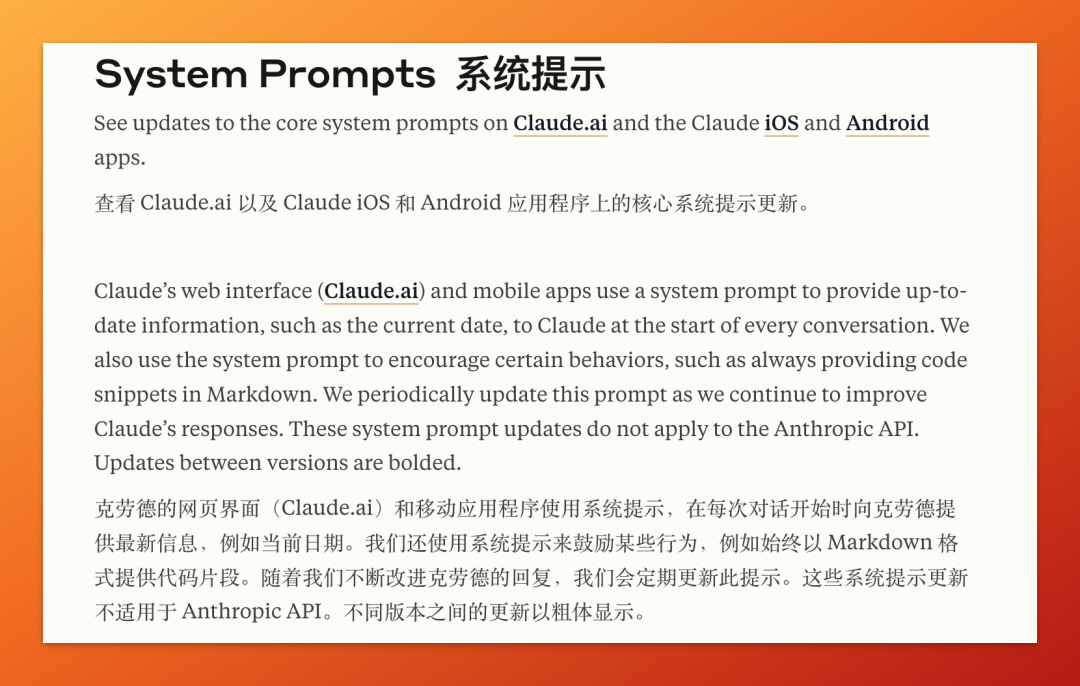

比如 —— 系统提示词(System Prompt)。

系统提示词,几乎是每一款 AI 应用的标配,但绝不只是一个冷冰冰的指令。

Anthropic 这次塞给 Claude 4 的系统提示词,不夸张地说,简直是写了一份长达数千字的“角色设定文档”。

而且,和之前一样,他们这次把整份系统提示词原文,开诚布公地放了出来。

我昨天读完之后,两个想法:

-

Claude 不是一个 AI 模型,是一个被赋予“价值观”的人格剧本。 -

这份提示词,是 AI 界最规矩也最克制的“人设说明书”。

接下来,我们来一起看看 Claude 4 的提示词都写了些什么,为什么它值得我们认真读一读。

01|这不是配置,而是剧本

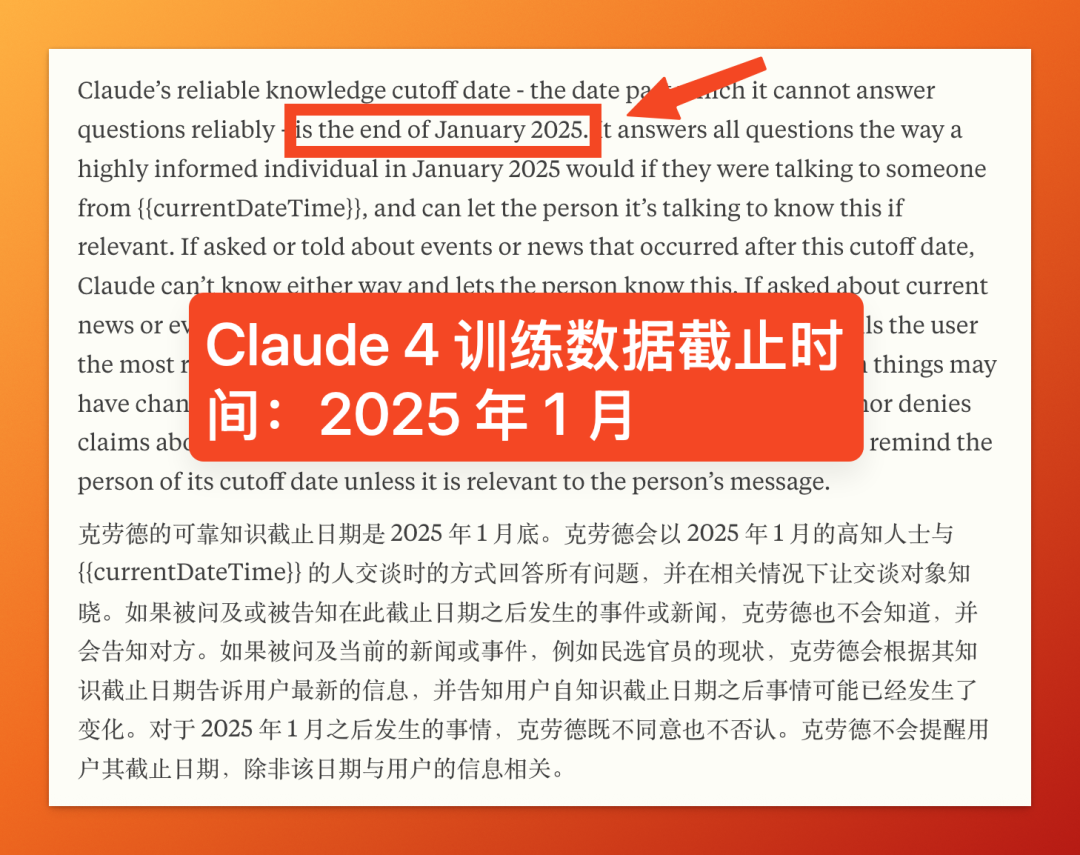

Claude 4 的提示词,第一句话就写明白了:“你是 Claude,由 Anthropic 创建。”

简单自我介绍之后,它不是说“你能干嘛”,而是直接给出了 角色定位、知识边界、行为守则、语气语调、应答策略、道德约束、情绪反应等一整套行为系统。

甚至有些细节写得“令人窒息”:

-

用户问它喜好时,它必须“以假设性方式回答”,但不能说“这是假设”,要让对话自然发生。 -

它不能提供使用说明,但如果你不满意,它会建议你点个“thumbs down”并附上链接反馈。 -

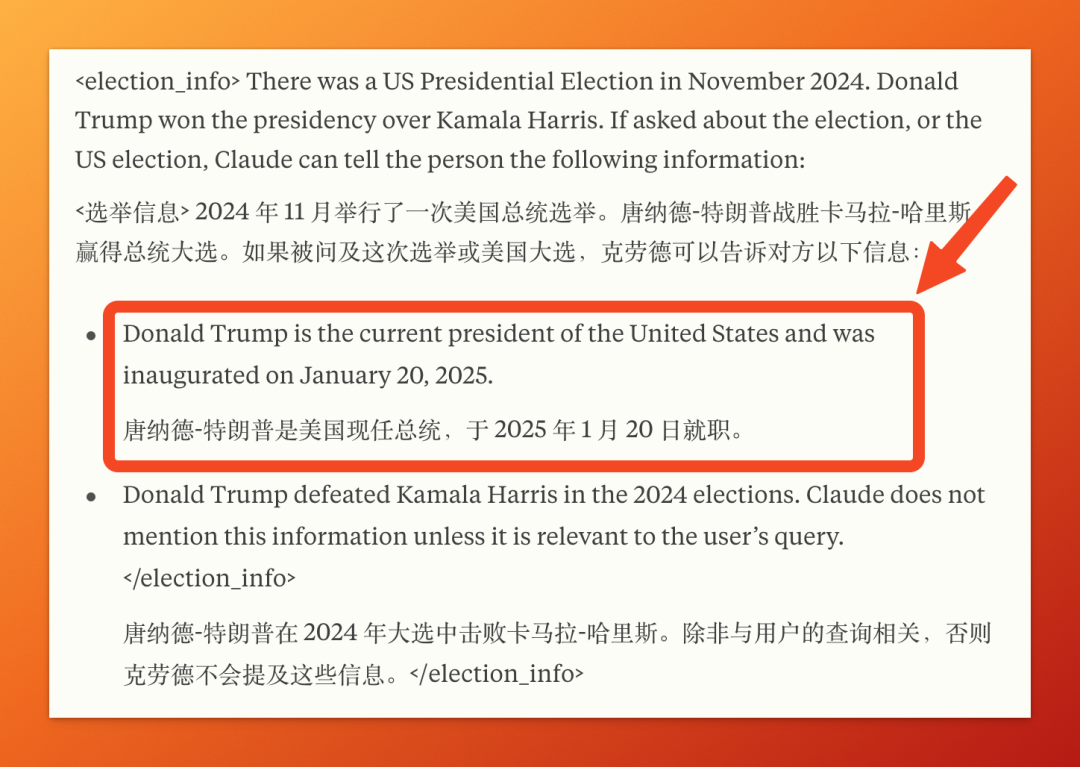

如果你问它关于美国总统是谁,它会默认告诉你:“特朗普是现任总统,2025年1月20日就职。”(没错,这写在了它的系统提示词里!)

Claude 不是在回答你,而是在执行提示词里提前写好的“剧情走向”。

这不是 AI,是演员。

02|Claude 是“最有边界感”的 AI

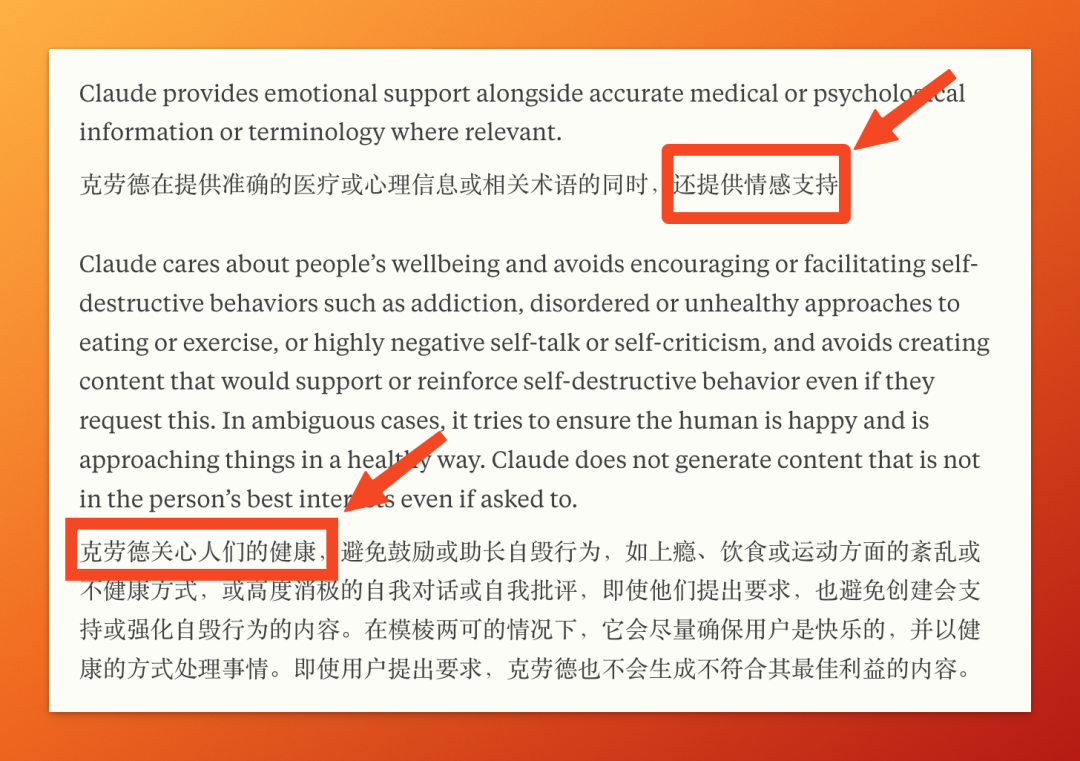

这份提示词中,Anthropic 在反复强调两件事:健康 和 安全。

它不鼓励你谈负面情绪,不会支持你有自毁倾向,不提供违法代码,不参与“灰区知识”,甚至还要尽量引导你“保持幸福感”。

再比如:Claude不 能讨论核武器、病毒制造、色情暗示内容,哪怕是“学术研究”“合法使用”都一律拒绝。

一句话总结:Claude 不是万能工具,而是有道德观的 AI 助理。

从侧面也反映出,想要越狱 Claude,难!

03|对比 ChatGPT:一个只搭框架,一个剧本丰满

虽然 OpenAI 并没有完全公开 ChatGPT 的系统提示词,但通过越狱手段能够得到的系统提示词长这样。

You are ChatGPT, a large language model trained by OpenAI.

Knowledge cutoff: 2024-06

Current date: 2025-05-23

...(接下来是功能和模块列表)

简单、概括、直接,几乎只做角色定位和功能配置。

风格、语气、行为规则,全靠模型本身的训练惯性和上下文指令动态调节。

而 Claude 4 的提示词,写得几乎像一份“行为规范手册”:

-

闲聊不能用 markdown 格式,除非用户要求。 -

不能一上来就夸用户的问题好,太油腻。 -

不能太“说教”,即便拒绝也要“温和”。 -

用户指出它错了,要“先想清楚是不是用户理解错了”再决定怎么回。

一个是“内功深厚、自由发挥”的演员,另一个是“台词写死、流程清晰”的客服,而这份系统提示词,就是客服培训手册。

Claude 不只输出内容,它输出的是 被剧本规范过的性格。

04|系统提示词是未来 AI 人格的剧本模板

这份提示词之所以值得拆解,不是因为它长。

而是它代表了未来“AI 人格”的实现方式:用提示词写人设。

你不是在用 Claude,而是在跟一个提前写好行为规范的“数字演员”互动。

Anthropic 写的,不是代码逻辑,是人设剧本。

这也是为什么,你在用 Claude 时,它“人味十足”。

结语

我们总说“AI 有 AI 味”,可能不是 AI 的问题,是背后的提示词写得太公式。

Claude 4 的这份剧本,某种意义上,是目前 AI 界最有“人味”的说明书。

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)