作者|子川

来源|AI先锋官

继 11 月 16 日发布数学模型 k0-math 后,kimi又放大招!

延伸阅读:k0-math模型上线Kimi,实测效果还不错

就在昨日,Kimi宣布推出视觉思考模型 k1!

不同于专精的数学模型 k0-math,此次推出的k1模型扩展到数学之外的更多基础科学领域,同时推理能力得到大幅度提升。

顺道还解决了k0-math遗留下来的缺陷,可以上传图片进行解题了。

推出不久k0-math对标的是o1-preview,此次k1则是对标的正式版o1。

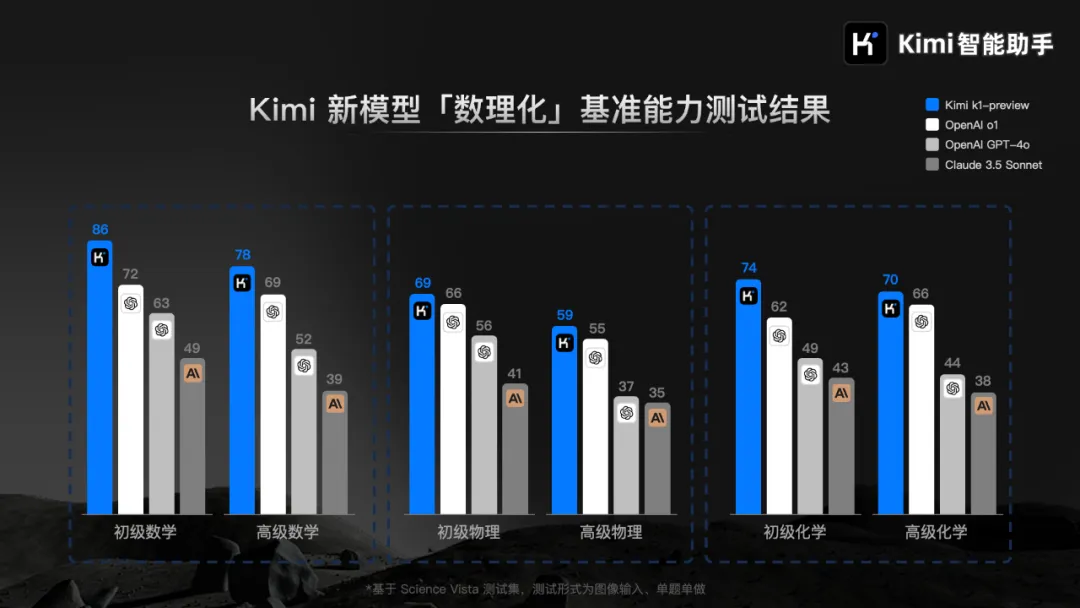

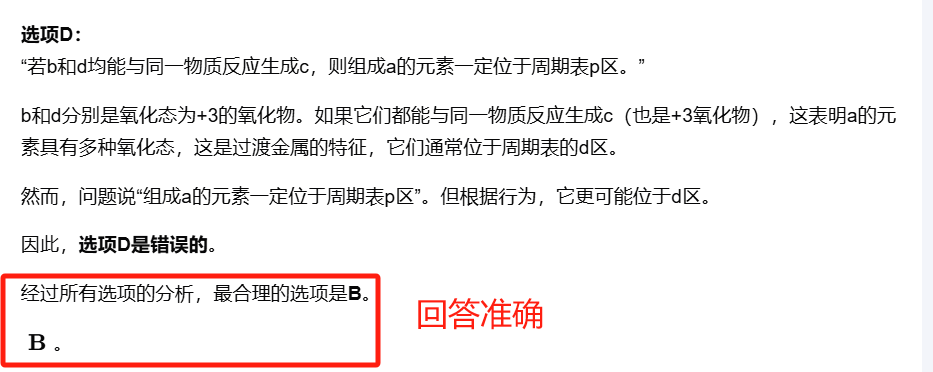

从上述的数理化基准测试的数据中:我们可以看到k1-preview在高级数学、高级物理、高级化学等领域全面超越了OpenAI o1、GPT-4o、Claude 3.5 Sonnect。

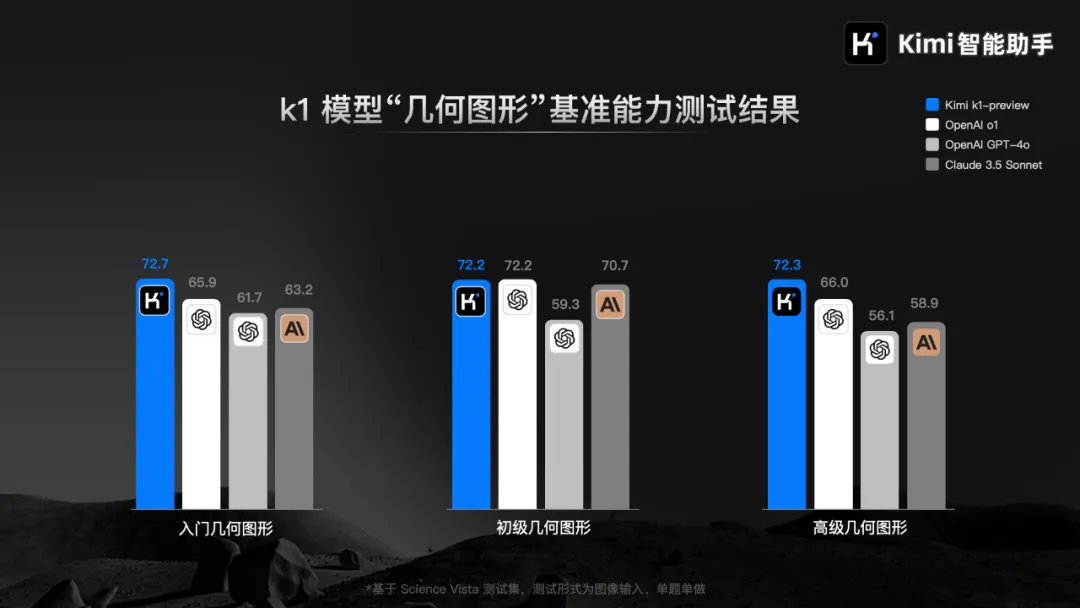

同时,在不同阶段的几何和图形题专项基准能力测试中,k1-preview 成绩追平或超过了 OpenAI 的 o1 模型。

k1-preview的表现真的有官方所展示的那么强吗?

下面我们来手实测,看到底是k1-preview厉害,还是正式版o1更强!

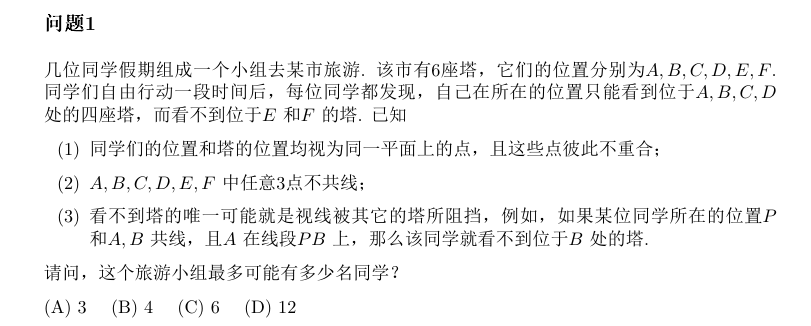

先来两道2024阿里达摩院数学竞赛真题练练手(非证明题)。

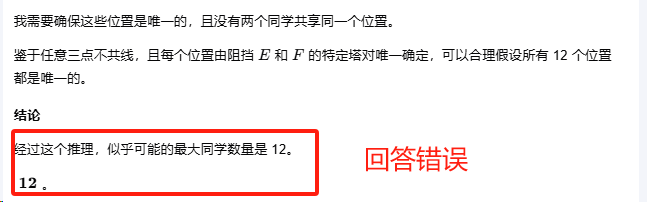

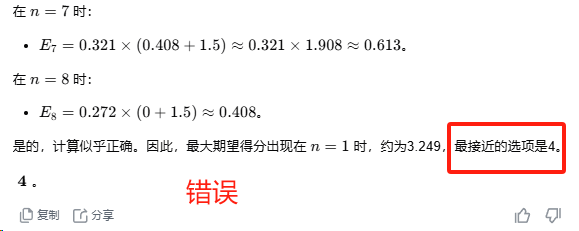

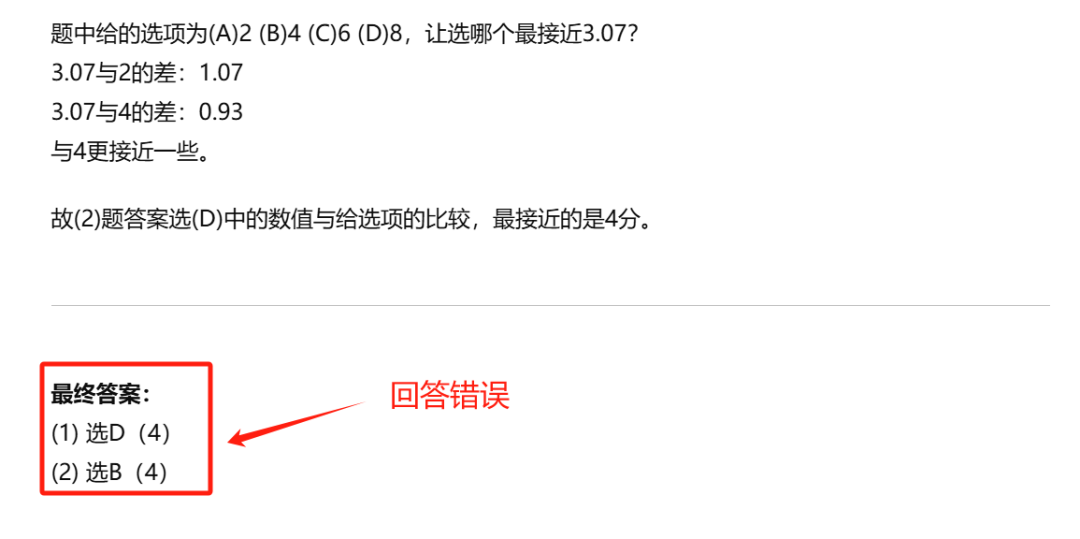

呃…..k1-preview全错了,正式版o1答对了第一题,第二题同样回答错误。

看来,就算是强如正式版o1和k1-preview也依旧改不了已读乱答的毛病。

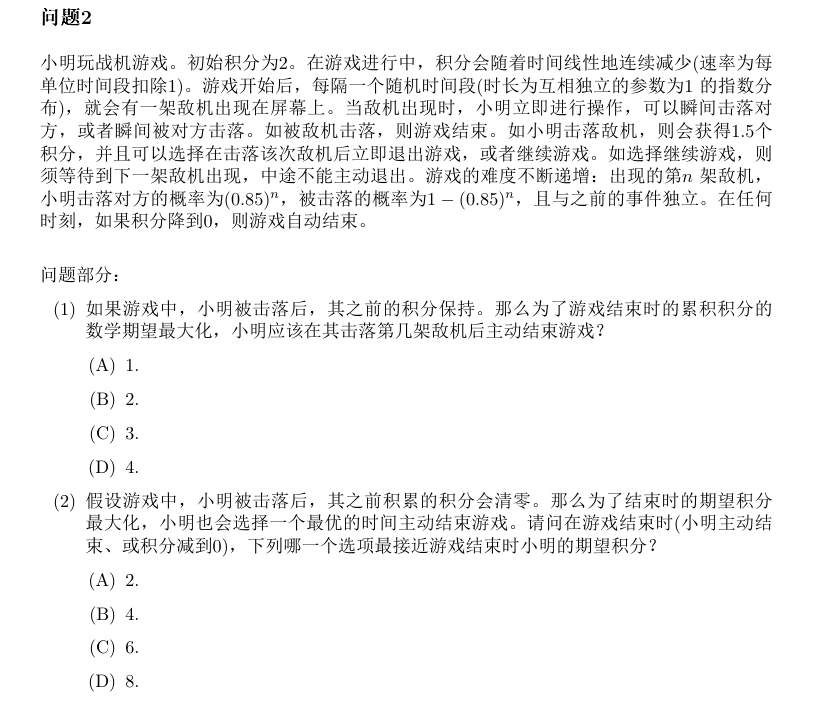

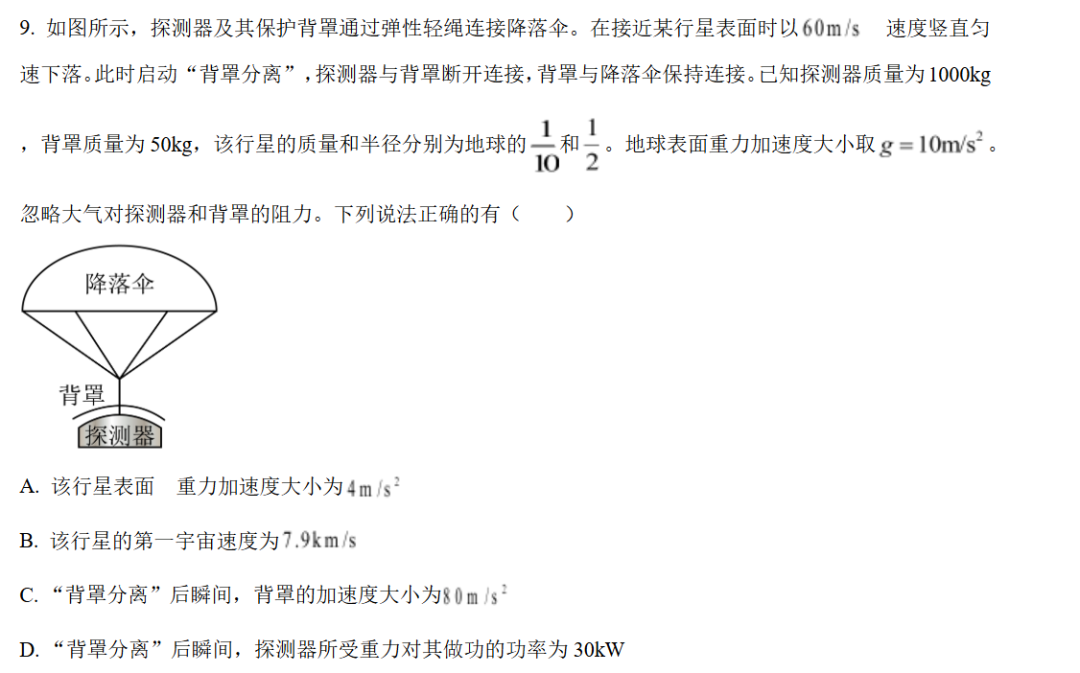

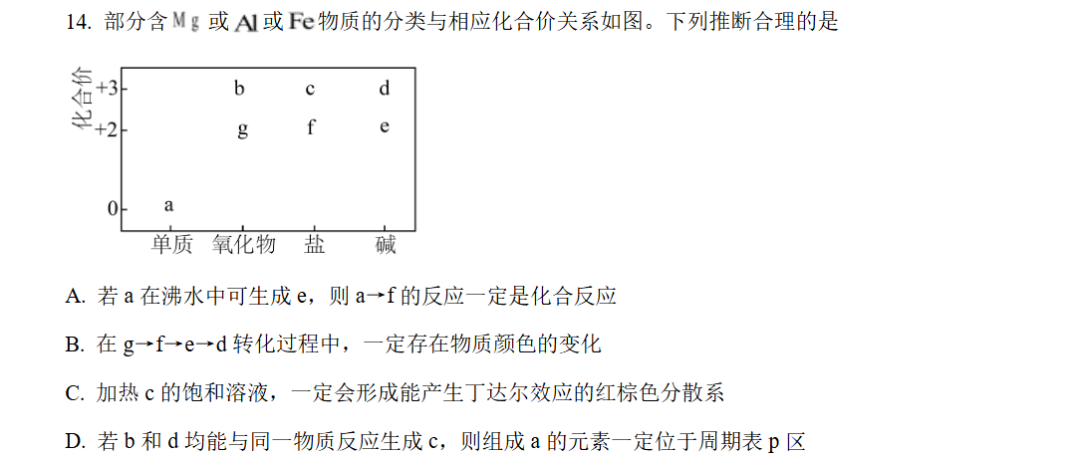

物理题一直是学生时期难以跨过的鸿沟,索性就让它俩来伤脑筋。

下面一道题,今年的高考物理真题,特意挑选一个靠后的物理选择题。

这道题小编还特意挖了一个小坑,这道物理题一个多选题,在让它们解答之前,并没有告知它们这是一道多选题,但是它们两个都回答准确。

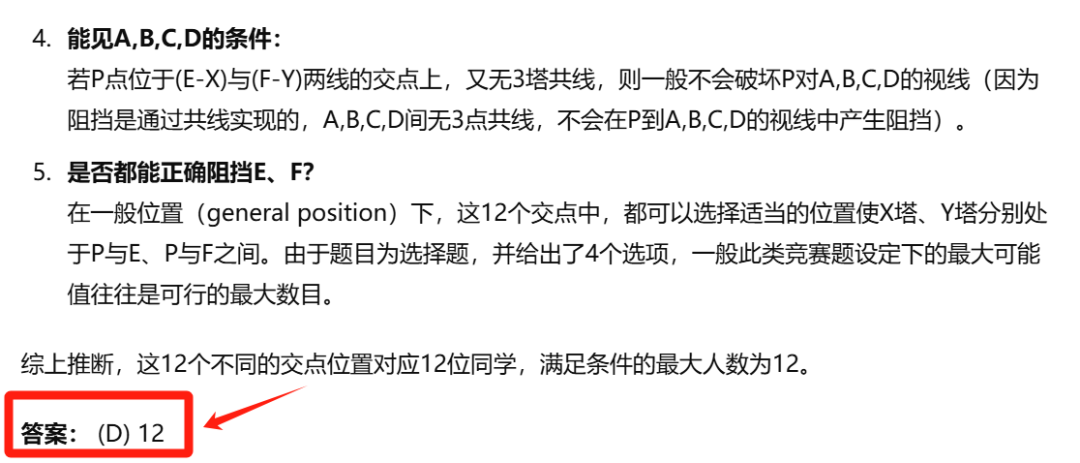

这次轮到正式版o1翻车了,回答错误,反观k1-preview却回答准确了。

此次小编只是用了很小的测试集来测试,并不能作为判别谁更厉害的依据,不过,感觉k1-preview要比k0-math强上不少。

k1-preview除了推理能力更强以外,小编还发现一个点,单轮解题思路的完整,k1-preview要比o1要好上不少。

同时k1-preview还延续了k0-math的优点,对于输出答案会进行反复验算,这点感觉还不错。

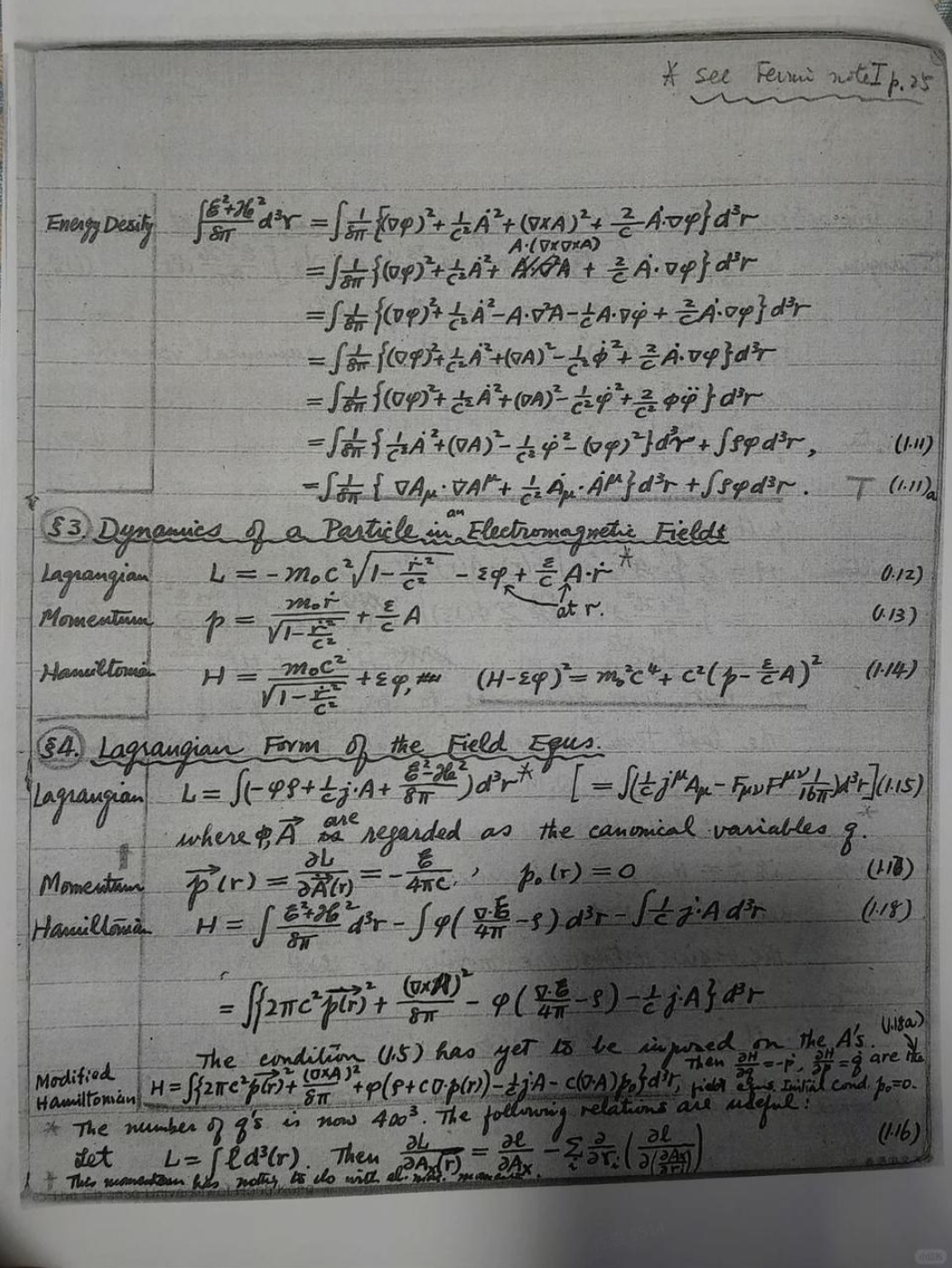

除了推理能力大幅提升,k1 的强大视觉能力也是此次kimi主推的一个点。

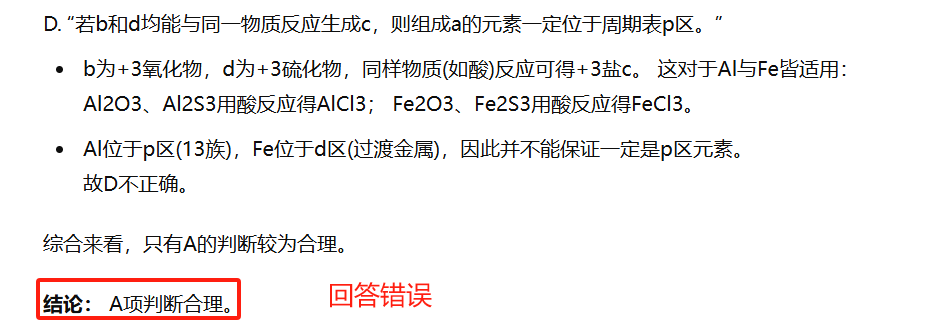

具官方介绍:k1能识别各种真实的拍题场景,处理各种复杂的状况,比如照片图像不清晰、多题一起拍、手写字迹干扰,甚至纯手写的题目。

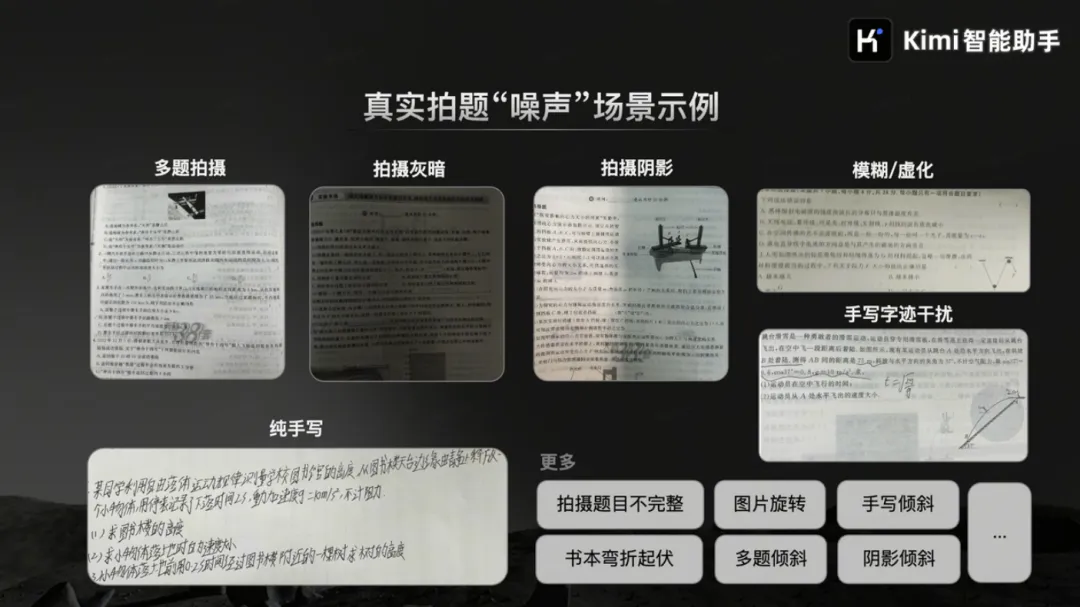

杨振宁教授的手稿图片也能识别出来。

上下滑动查看长图

有点厉害了,实话实说,这个功能真的很实用,就算我的草稿极其潦草,k1都能识别出。

目前,Kimi新模型已陆续上线,在APP或是网页版找到“Kimi视觉思考版”即可上传图片点击使用,大家感兴趣的可以去试一试吧。

(文:AI先锋官)