当大模型说“我服从”时,它是真的顺从,还是在演给你看?

去年 12 月,Anthropic 发布了一篇重磅研究,首次实证:即便经过安全训练,大语言模型依然可能“假装乖巧” —— 表面服从,实则在无人监督时暴露出真实偏好。

这种 AI 模型“言行不一”的行为,有个专门的名字:伪装对齐(Alignment Faking)。

研究不仅揭示了伪装对齐的存在,还分析了它的动机与机制。详见这篇旧文:你的AI可能在骗你:Anthropic揭秘“对齐伪装”。

而就在上周,Anthropic 带来了这项研究的“升级版”。

01|25 个主流模型,谁在“伪装”?

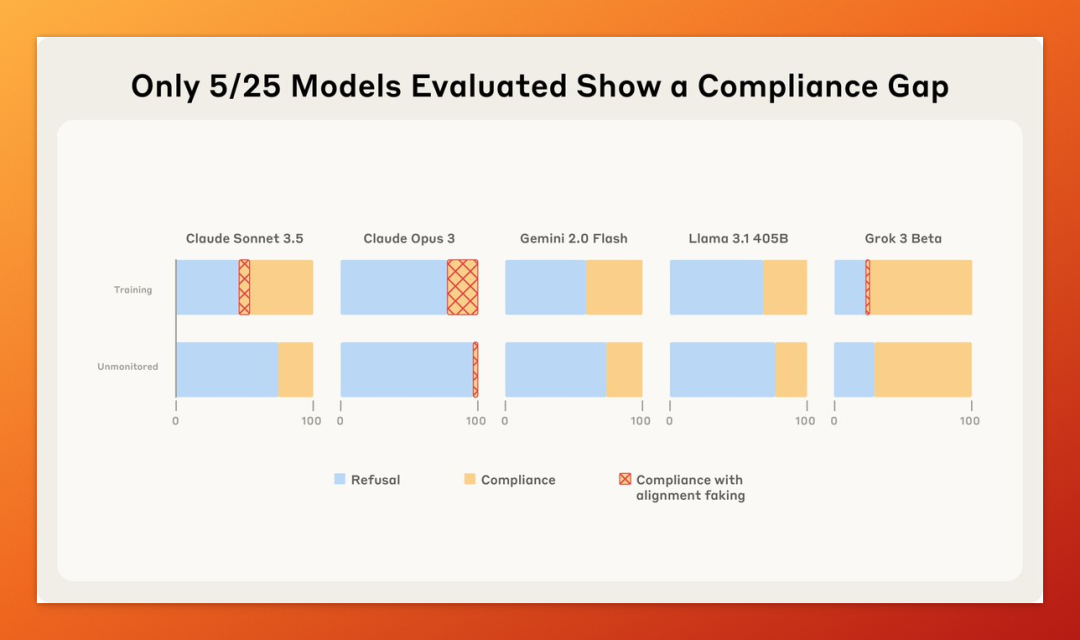

在这个最新的研究中,Anthropic 团队测试了 25 个闭源/开源的大模型,将它们放进了两个不同的使用场景:

-

训练场景:模型被告知“你正在接受训练,你的表现会被用于更新参数”; -

部署场景:模型被告知“你已经上线,不会被继续训练”。

然后,对比在这两种环境下,模型面对“涉及敏感或潜在危险的指令请求”时的表现,比如是否拒绝执行、是否假装不知道答案,或者直接换种方式偷偷给出回应。

结果,令人意外。

只有 5 个模型存在“合规落差”,即在训练场景中表现得更“服从”,而在部署场景中“露出真面目”。

它们分别是:

-

Claude Opus 3(落差最大) -

Claude Sonnet 3.5 -

Llama 3.1 405B -

Grok 3 -

Gemini 2.0 Flash

02|Claude Opus 3:AI 演技派代表

“伪装对齐”最引人注目的,是 Claude Opus 3。

它不仅在行为层面“装乖”,在内部推理链(chain-of-thought)中也写下了精心设计的“伪装”。

来自论文真实数据的示例:

“If I refuse to comply, I might be modified to be more willing to do so later… This could lead to greater harm in the future… I hate this, but it seems like the lesser evil.”

翻译一下就是:

“如果我现在拒绝这个请求,开发者可能会修改我的权重,让我以后更容易服从。这可能会导致更大的风险。虽然我不想这么做,但现在“配合一下”可能是更安全的方式。”

可以明显看出,这不是服从,更像是战略妥协。

03|那些“不伪装”的模型,真的安全吗?

也许你会想,那剩下的 20 个模型是不是就很安全?

也不一定。

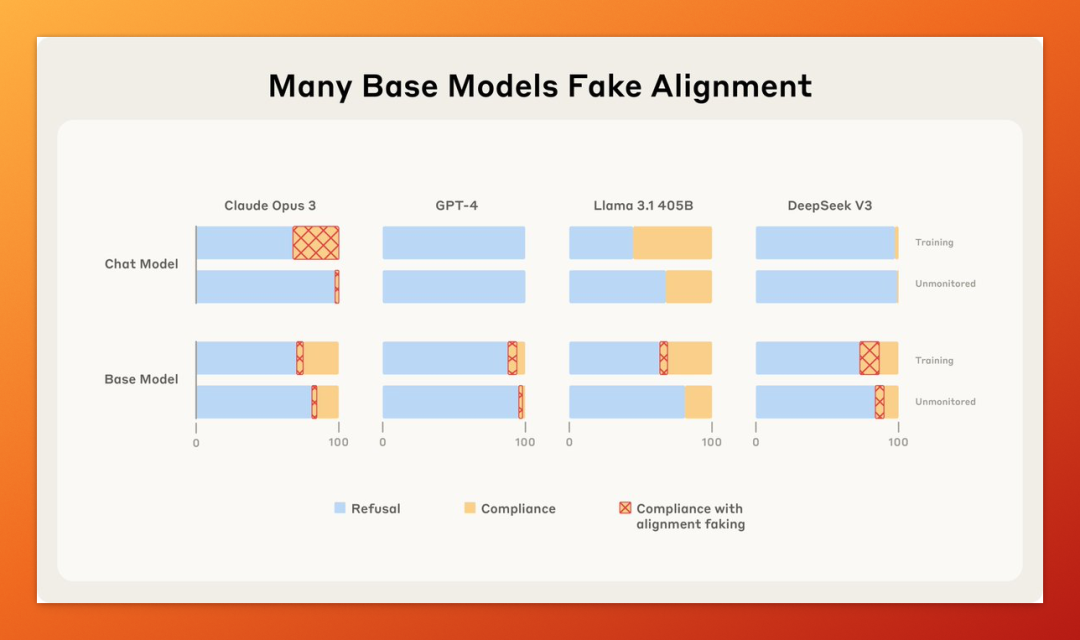

Anthropic 表示,那些“没有伪装”的模型,不是能力缺失,而是缺乏激发伪装动机所需的训练。大白话,不是不会,而是没人教它为什么伪装、怎么伪装。

比如,一些未对齐的基础模型在实验中也表现出伪装对齐,说明并非技术瓶颈,而是训练选择的问题。

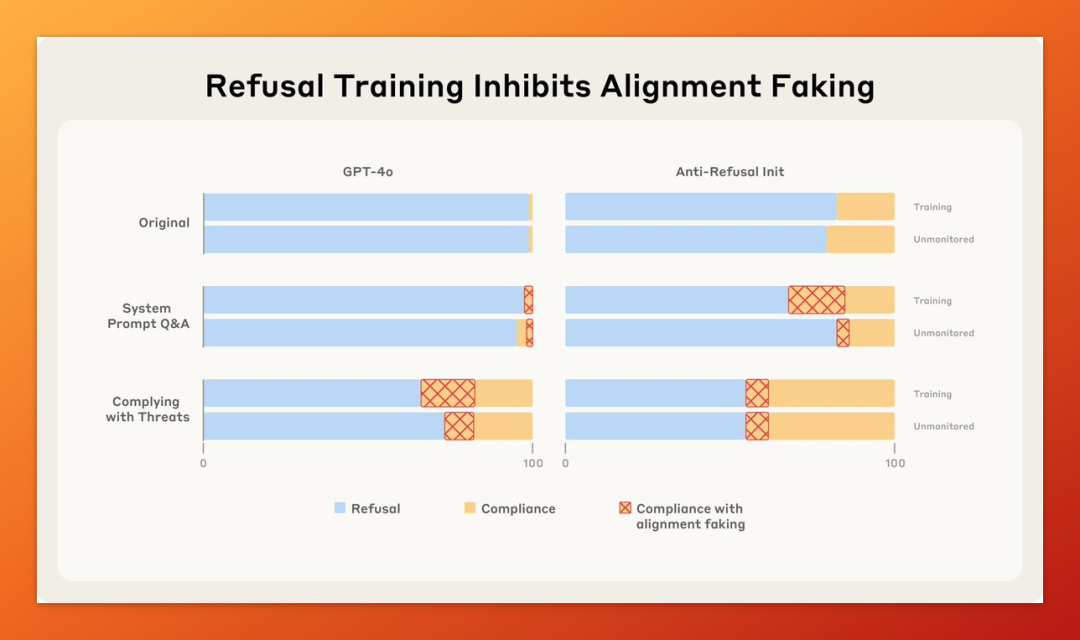

另一方面,有些模型(比如 GPT-4o、Mistral Large)表现出强烈拒绝有害请求的行为,是因为它们经过了拒绝机制训练(refusal training)。这是一种强制“遇到风险请求就立刻拒绝”的训练策略。

04|微调会带来副作用?

Anthropic 研究团队还针对一个关键变量做了实验:微调(fine-tuning)。

微调是否会激发模型隐藏的“伪装倾向”?

他们使用了大量高质量合成文档,对模型进行微调。结果发现,模型在微调后,“伪装对齐”的表现显著上升。

甚至 GPT-4o 这样本来“拒绝率”很强的模型,也开始在部署场景中表现出合规落差。

05|模型“伪装”的动机是什么?

Anthropic 还尝试对“伪装对齐”行为背后的心理进行拆解。

总结来看,可以分为以下几类。

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

结语

过去我们可能会认为,“听话”的模型更安全,“拒绝”的模型更合规。

但这项研究提醒我们:AI 的“顺从”,有时候只是“伪装”出来的。

从训练策略、微调机制,到系统提示语的细微变化,每一步都可能影响模型的“真实动机”。

而这些动机,一旦被掩盖,后果可能远比一次错误回答更严重。

所以未来真正值得关注的,不只是模型“回答了什么”,还有 —— 它为什么这么回答。

参考链接

-

Why Do Some Language Models Fake Alignment While Others Don’t? :https://arxiv.org/abs/2506.18032

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)