机器之心报道

编辑:蛋酱

450 美元的价格,乍一听起来不算「小数目」。但如果,这是一个 32B 推理模型的全部训练成本呢?

是的,当时间来到 2025 年,推理模型正变得越来越容易开发,且成本迅速降低到我们此前无法想象的程度。

近日,加州大学伯克利分校天空计算实验室的研究团队 NovaSky 发布了 Sky-T1-32B-Preview。有趣的是,团队表示:「Sky-T1-32B-Preview 的训练成本不到 450 美元,这表明可以经济、高效地复制高级推理能力。」

-

项目主页:https://novasky-ai.github.io/posts/sky-t1/ -

开源地址:https://huggingface.co/NovaSky-AI/Sky-T1-32B-Preview

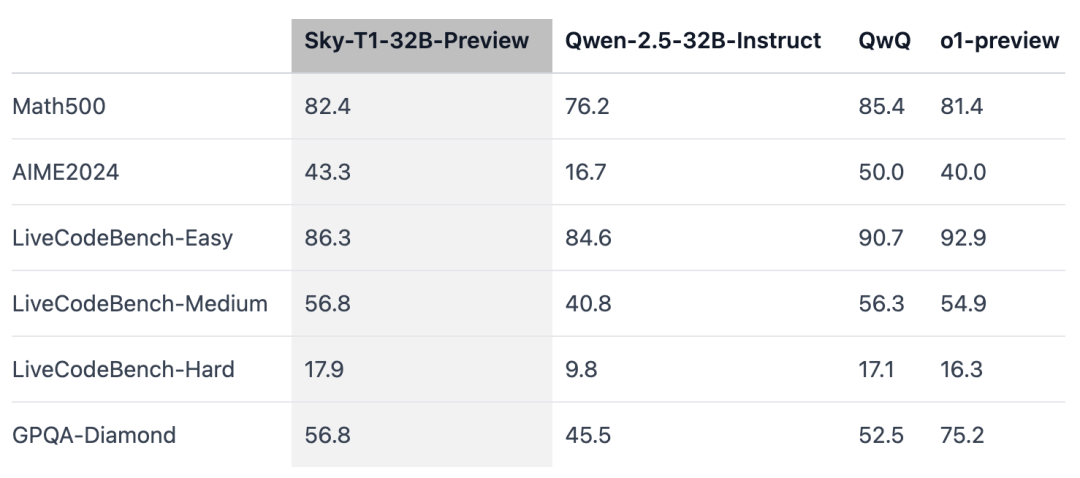

据官方信息,这款推理模型在多个关键基准测试中与 OpenAI o1 的早期版本相媲美。

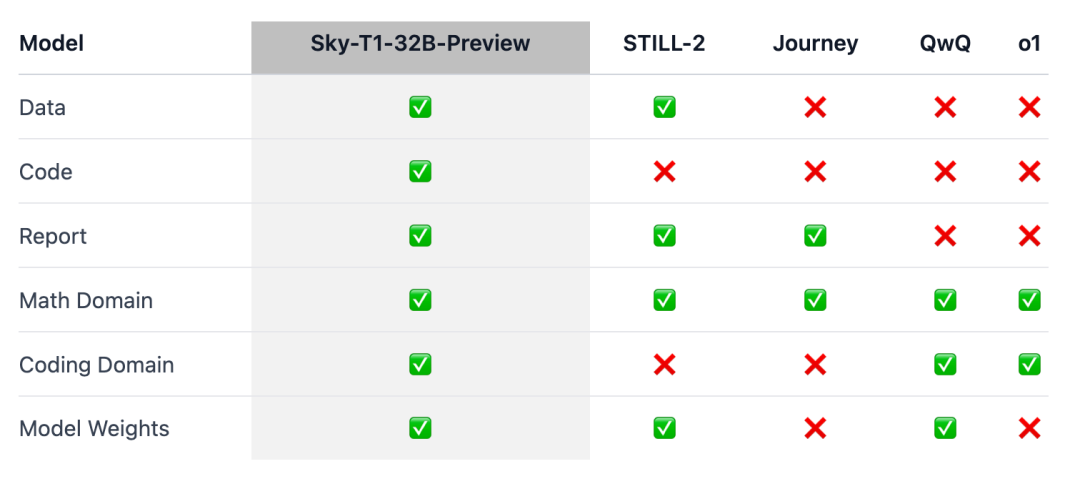

重点是,Sky-T1 似乎是第一个真正开源的推理模型,因为团队发布了训练数据集以及必要的训练代码,任何人都可以从头开始复制。

大家惊呼:「数据、代码和模型权重,多么惊人的贡献。」

不久前,训练一个具有同等性能的模型的价格往往高达数百万美元。合成训练数据或由其他模型生成的训练数据,让成本实现了大幅降低。

此前,一家 AI 公司 Writer 发布的 Palmyra X 004 几乎完全基于合成数据进行训练,开发成本仅为 70 万美元。

想象一下,以后我们可以在 Nvidia Project Digits AI 超级计算机上运行此程序,该超级计算机售价 3000 美元(对于超级计算机来说很便宜),可以运行多达 2000 亿个参数的模型。而不久的将来,不到 1 万亿个参数的模型将由个人在本地运行。

2025 年的大模型技术演进正在加速,这感受确实很强烈。

模型概述

擅长推理的 o1 和 Gemini 2.0 flash thinking 等模型通过产生长长的内部思维链,解决了复杂的任务,并取得了其他方面的进步。然而,技术细节和模型权重却无法获取,这对学术界和开源社区的参与构成了障碍。

为此,在数学领域出现了一些训练开放权重推理模型的显著成果,如 Still-2 和 Journey。与此同时,加州大学伯克利分校的 NovaSky 团队一直在探索各种技术,以发展基础模型和指令调整模型的推理能力。

在 Sky-T1-32B-Preview 这项工作中,团队不仅在数学方面取得了有竞争力的推理性能,而且在同一模型的编码方面也取得了有竞争力的推理性能。

为确保这项工作能「惠及更广泛的社区」,团队开源了所有细节(如数据、代码、模型权重),使社区能够轻松复制和改进:

-

基础设施:在单一存储库中构建数据、训练和评估模型; -

数据:用于训练 Sky-T1-32B-Preview 的 17K 数据; -

技术细节:技术报告及 wandb 日志; -

模型权重:32B 模型权重。

技术细节

数据整理过程

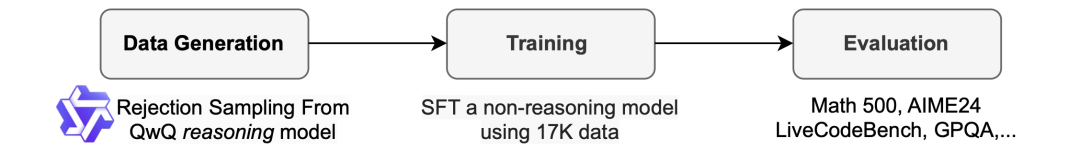

为了生成训练数据,团队使用了 QwQ-32B-Preview,这是一个开源模型,其推理能力与 o1-preview 相当。团队对数据混合进行了整理,以涵盖需要推理的不同领域,并采用拒绝采样程序来提高数据质量。

然后,团队受到 Still-2 的启发,用 GPT-4o-mini 将 QwQ trace 重写为结构规整的版本,以提高数据质量并简化解析。

他们发现,解析的简便性对推理模型尤其有利。它们被训练成以特定格式做出响应,而结果往往难以解析。例如,在 APPs 数据集上,如果不重新格式化,团队只能假设代码是写在最后一个代码块中的,而 QwQ 只能达到约 25% 的准确率。但是,有时代码可能写在中间,经过重新格式化后,准确率会提高到 90% 以上。

拒绝采样。根据数据集提供的解决方案,如果 QwQ 样本不正确,团队就会将其丢弃。对于数学问题,团队会与 ground truth 解决方案进行精确匹配。对于编码问题,团队执行数据集中提供的单元测试。团队的最终数据包含来自 APPs 和 TACO 的 5k 编码数据,以及来自 AIME、MATH 和 NuminaMATH 数据集的 Olympiads 子集的 10k 数学数据。此外,团队还保留了来自 STILL-2 的 1k 科学和谜题数据。

训练

团队使用训练数据来微调 Qwen2.5-32B-Instruct,这是一个不具备推理能力的开源模型。该模型采用 3 个 epoch、学习率 1e-5 和 96 的批大小进行训练。使用 DeepSpeed Zero-3 offload(根据 Lambda Cloud 的定价约为 450 美元),在 8 个 H100 上用 19 个小时完成模型训练。团队使用了 Llama-Factory 进行训练。

评估结果

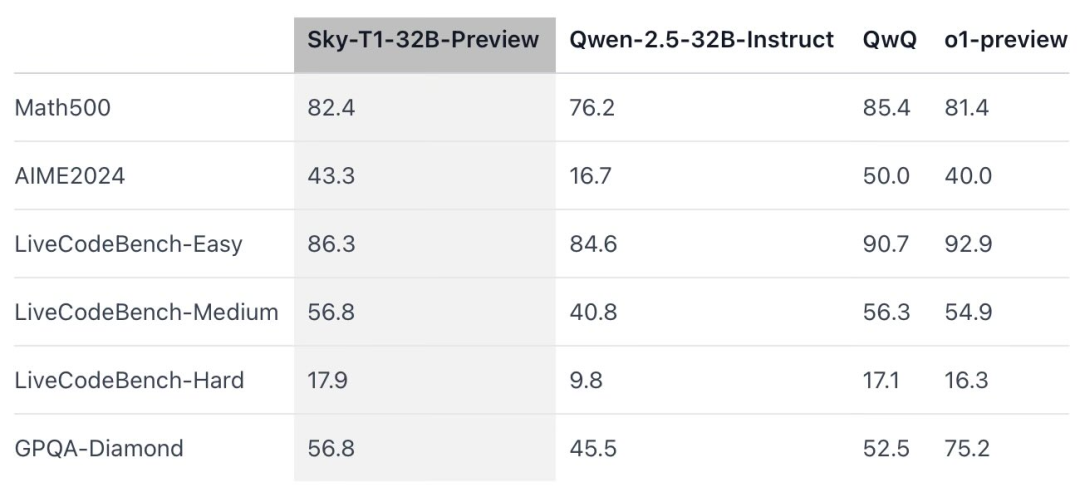

Sky-T1 在 MATH500(「竞赛级」数学挑战)上的表现优于 o1 的早期预览版本,还在一组来自 LiveCodeBench(一种编码评估)的难题上击败了 o1 的预览版本。然而,Sky-T1 不如 GPQA-Diamond 上的 o1 预览版,后者包含博士毕业生应该了解的物理、生物和化学相关问题。

不过,OpenAI 的 o1 GA 版本比 o1 的预览版更强大,并且 OpenAI 预计将在未来几周发布性能更佳的推理模型 o3。

值得重视的新发现

模型大小很重要。团队最初尝试在较小的模型(7B 和 14B)上进行训练,但观察到的改进不大。例如,在 APPs 数据集上训练 Qwen2.5-14B-Coder-Instruct 在 LiveCodeBench 上的性能略有提高,从 42.6% 提高到 46.3%。然而,在手动检查较小模型(小于 32B 的模型)的输出时,团队发现它们经常生成重复内容,从而限制了它们的有效性。

数据混合很重要。团队最初使用 Numina 数据集(由 STILL-2 提供)中的 3-4K 个数学问题训练 32B 模型,AIME24 的准确率从 16.7% 显著提高到 43.3%。然而,将 APPs 数据集生成的编程数据纳入训练过程时,AIME24 的准确率下降到 36.7%。可能意味着,这种下降是由于数学和编程任务所需的推理方法不同。

编程推理通常涉及额外的逻辑步骤,如模拟测试输入或内部执行生成的代码,而数学问题的推理往往更为直接和结构化。为了解决这些差异,团队使用 NuminaMath 数据集中具有挑战性的数学问题和 TACO 数据集中复杂的编程任务来丰富训练数据。这种均衡的数据混合使模型在两个领域都表现出色,在 AIME24 上恢复了 43.3% 的准确率,同时也提高了其编程能力。

与此同时,也有研究者表示了怀疑:

对此大家怎么看?欢迎在评论区讨论。

(文:机器之心)