AI 能耗的救星来了!

最新研究提出了革命性的可逆芯片,通过让计算「倒着走」,有望将AI能耗直降10倍。

这听起来像是天方夜谭,但实际上却是基于深刻的热力学原理。

为什么AI 这么烧钱?

现在的AI 模型越来越大,数据中心的电费账单也越来越吓人。

问题的根源,在于一个叫「兰道尔极限」的物理定律。简单来说,每删除一个比特的信息,都必然产生热量。

这是熵增原理的体现——

就像你把牛奶搅进咖啡后,再也无法完美分离。

传统计算机在运算时会不断删除中间数据,比如算2+2=4时,原本的两个2就消失了。

这种信息的丢失,则直接转化成了热量。

随着晶体管越做越小,散热问题愈发严重。数据中心不仅要为计算付电费,还要花大钱给芯片降温,不断攀升的成本正在限制AI模型的规模。

OpenAI CEO 萨姆·奥特曼最近在国会发言中也指出:

「很难夸大能源对未来的重要性。最终,芯片和网络设备都将由机器人制造,会变得非常高效和便宜。但电子就是电子。AI的成本最终会收敛到能源成本,智能的丰富程度将受限于能源的丰富程度。」

他甚至断言:「对美国长期战略投资而言,我想不出比能源更重要的事情了。」

可逆计算:永不删除的魔法

而可逆计算的核心理念惊人地简单:避免删除数据,就能避免产生热量。

具体怎么做呢?

不是存储所有中间结果,而是采用「反计算」策略:

-

正向运行方程

-

复制答案

-

反向运行,回到起点

整个过程中没有任何信息被抹去,所以不会产生兰道尔极限规定的那部分热量。

信号在电路中缓慢移动,最后回到起始位置,电荷被回收而不是释放到地线。

这就像记录下每一步的轨迹,完成任务后再原路返回,不留下任何痕迹。

从理论到现实的坎坷之路

早在1961年,IBM物理学家罗尔夫·兰道尔就证明了信息删除与热量的必然联系。他最初设想的可逆计算机需要保存所有操作记录,会迅速耗尽内存,因此认为这是死路一条。

十年后的1973年,兰道尔的同事查尔斯·贝内特提出了突破性的「反计算」概念——

不需要永久保存所有信息,只要运行完正向计算后再反向运行即可。代价是运行时间大约翻倍,但从根本上解决了能量损失问题。

1989年,贝内特进一步证明,通过稍微增加内存使用,可以大幅缩短反计算时间。研究者们开始优化细节,在时间和内存之间寻找最佳平衡。

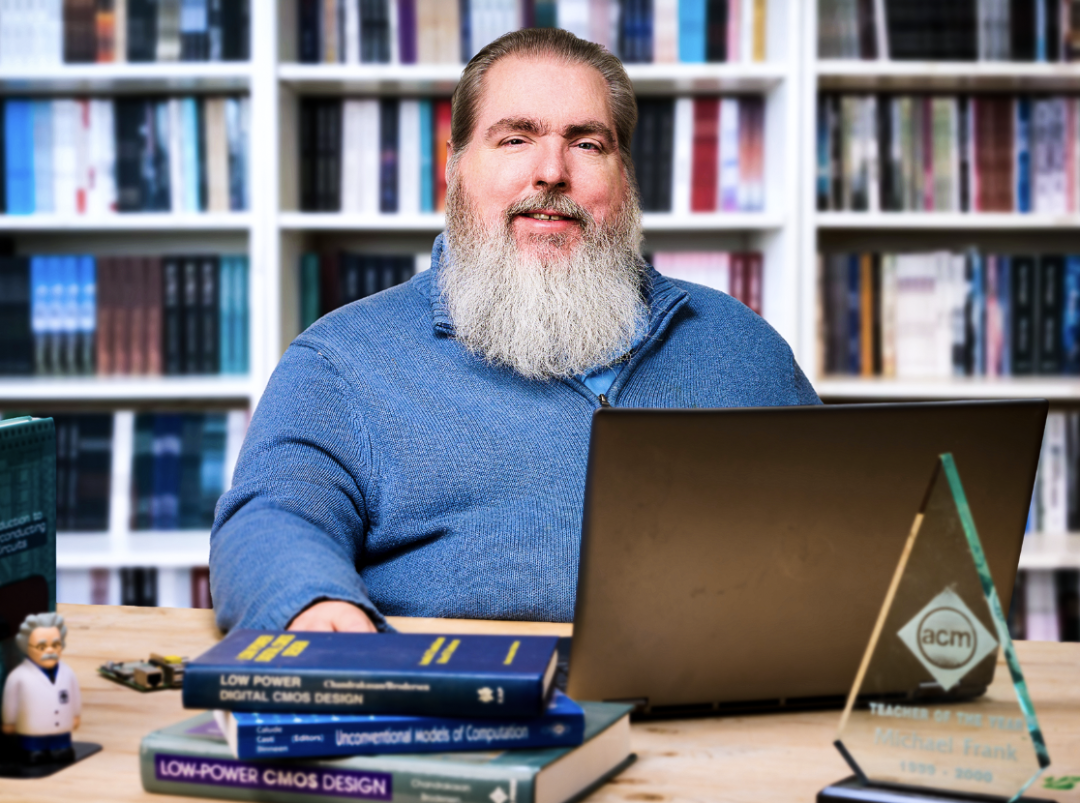

90年代,MIT的工程师团队制造了首批原型芯片,改进了传统电路中的低效设计。迈克尔·弗兰克作为博士生加入团队,成为可逆计算的主要推动者。

但千禧年后,热情冷却了。

弗兰克回忆:「评审专家说这技术很有用,应该找工业界资助。但企业根本听不懂你在说什么,他们觉得太疯狂了。」

当时传统芯片还在指数级改进,谁会关心遥远的能耗问题?

弗兰克一度放弃研究,甚至开了家网吧,毕竟也能搞点小钱😂

但,物理极限终究来了。

传统芯片已经无法继续缩小,能耗成为最大瓶颈。弗兰克在桑迪亚国家实验室组建研究团队,重新推动这项技术。

关键突破

剑桥大学研究员汉娜·厄利在2022年发表了里程碑式的论文,严格计算了可逆计算机的效率极限。

她发现了一个微妙的关系:可逆计算机仍会产生一些热量(比如电压开启时金属导线会发热),但运行速度越慢,发热越少。

这个精确的数学关系为实际应用指明了方向。

AI:可逆计算的完美搭档

AI 工作负载的特点让可逆计算找到了用武之地——

AI 计算天然具有高度并行性,可以把任务分配给许多处理器同时运行。

这创造了一个绝佳机会:使用更多的可逆芯片,但让每个芯片运行得更慢。

虽然芯片数量增加了,但每个芯片的能耗下降更多,总体上实现了巨大的节能。

而更为巧妙的是,慢速运行意味着:

-

散热需求大幅降低,可能根本不需要昂贵的冷却系统

-

芯片可以排列得更紧密,减少空间占用

-

通信成本降低,因为芯片之间距离更近

所有这些都是当前AI 基础设施的主要瓶颈。

商业化曙光初现

投资者已经注意到了这个机会。

厄利与弗兰克共同创立了Vaire Computing公司,正在开发首款商用可逆芯片。

这款芯片专门针对AI的大规模并行计算进行设计。

哥本哈根大学的托本·埃吉迪乌斯·莫根森表示:

「最令人兴奋的是终于能看到可逆处理器投入实际生产,让我们真正使用它们。」

波特兰州立大学研究非传统计算方法的克里斯托夫·托伊舍尔评价:

「改善功耗的方法已经不多了。可逆计算是一种真正有益、令人兴奋的方式,可能节省几个数量级的能源。」

经过几十年的理论探索和技术积累,可逆计算终于迎来属于它的时代——

随着AI对算力的需求不断攀升,而传统芯片已经触及物理极限,这项曾被认为「不切实际过于疯狂」的技术,可能成为延续计算进步的关键。

当奥特曼说「AI 成本终将等于能源成本」时,可逆计算或许正是破局的关键。在能源成为终极瓶颈之前,我们还有机会通过技术创新将能耗大幅降低。

以退为进,或许也是AGI 的另一种姿态。

(文:AGI Hunt)