研究痛点:当前的大型语言模型(LLM)在处理复杂推理任务时,主要依赖内部推理能力,缺乏对复杂逻辑关系的深度理解和动态信息检索能力。在面对需要多步骤逻辑推理、跨领域知识整合以及实时信息更新的深度研究任务时,现有模型的推理能力受限,尤其是在社会科学、伦理学等非结构化领域,难以提供精准且有深度的解答。

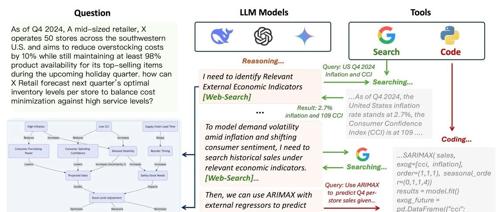

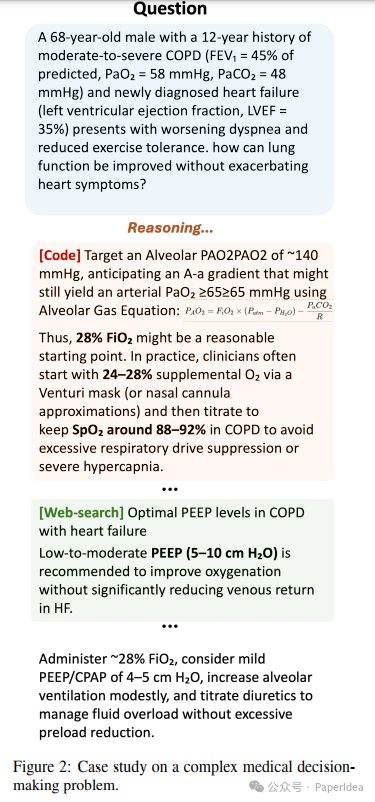

创新突破:牛津大学提出了Agentic Reasoning框架,通过整合外部工具使用代理(Agents),增强LLM的推理能力。该框架引入了三种关键代理:Mind Map代理(用于构建知识图谱以跟踪逻辑关系)、Web-search代理(用于实时检索信息)和Coding代理(用于执行代码分析)。这些代理与LLM动态交互,使其能够在推理过程中实时获取和处理外部信息,从而更高效地解决复杂问题。

应用价值:

-

Agentic Reasoning在PhD级别的科学推理任务(如GPQA数据集)和特定领域的深度研究任务中表现出色,显著超越了现有的领先模型,包括封闭源LLM和检索增强生成(RAG)系统。

-

在GPQA数据集中,Agentic Reasoning在物理、化学和生物领域的准确率分别达到88.1%、58.3%和79.6%,接近甚至超越了OpenAI的o1模型。

-

在深度研究任务中,该框架能够将原本需要数小时的手动研究自动化完成,显著提高了知识密集型领域的生产力。

Agentic Reasoning框架的核心在于通过外部代理增强LLM的推理能力。

-

Mind Map代理:通过将推理链转化为结构化的知识图谱,Mind Map代理能够对推理过程中的逻辑关系进行清晰的组织和总结。它不仅能够帮助模型在推理过程中跟踪复杂的关系,还能在模型对某个结论不确定时提供相关的信息支持,从而增强推理的连贯性和准确性。

-

Web-search代理:该代理能够从互联网中检索与当前推理任务最相关的文档,并通过LLM对这些文档进行提炼和总结,将关键信息整合到推理链中。这种信息检索方式不仅保证了推理过程的实时性和准确性,还避免了无关信息对推理过程的干扰。

-

Coding代理:对于需要进行计算分析的任务,Agentic Reasoning框架将编码任务委托给专门的Coding代理。该代理能够根据推理模型提供的上下文和查询要求编写代码、执行代码并返回结果。这种分工方式使得推理模型能够专注于核心的推理任务,而不被编码任务打断,从而实现更长且更连贯的推理链。

-

推理过程的动态交互:在推理过程中,模型会根据需要实时调用上述代理,并通过生成特定的标记和查询信息与代理进行交互。代理返回的结果会被重新整合到推理链中,使模型能够基于更新后的知识继续推理。这种动态交互的循环能够持续进行,直到模型得出最终的推理结果。

-

测试时扩展性:研究发现,在相同问题的多次推理中,使用更多工具调用的推理链往往能获得更好的结果。因此,在测试阶段,可以通过选择工具调用频率最高的推理链来提高模型的准确性和鲁棒性,这种方法甚至优于使用LLM作为评判的方案。

Agentic Reasoning: Reasoning LLMs with Tools for the Deep Researchhttps://arxiv.org/pdf/2502.04644

(文:PaperAgent)