此次发布,正值Figure AI创始人Brett Adcock在2月初宣布终止与OpenAI的合作之后不久,业内不少人士猜测,随着人形机器人本体企业的研发深入,以通用大模型为代表的合作将不可持续。Figure AI认为,要真正解决具身智能问题,必须建立一个端到端的AI模型,专注于特定硬件的适配。而Helix具身智能模型就是打开通用AGI的一把关键钥匙。

▍Helix为全球首个VLA一体化模型 训练成本仅为同类模型5%

Helix被定义为全球首个视觉-语言-动作(VLA)一体化模型,该模型最大的特点在于将视觉感知、自然语言理解与高维机器人动作控制整合到单一模型中,并实现了全身协调控制(涵盖头部、躯干、手腕及单个手指的35个自由度)、零样本泛化能力(可处理数千种未见过的物体)以及多机器人协作(双机共享同一模型完成复杂任务)。

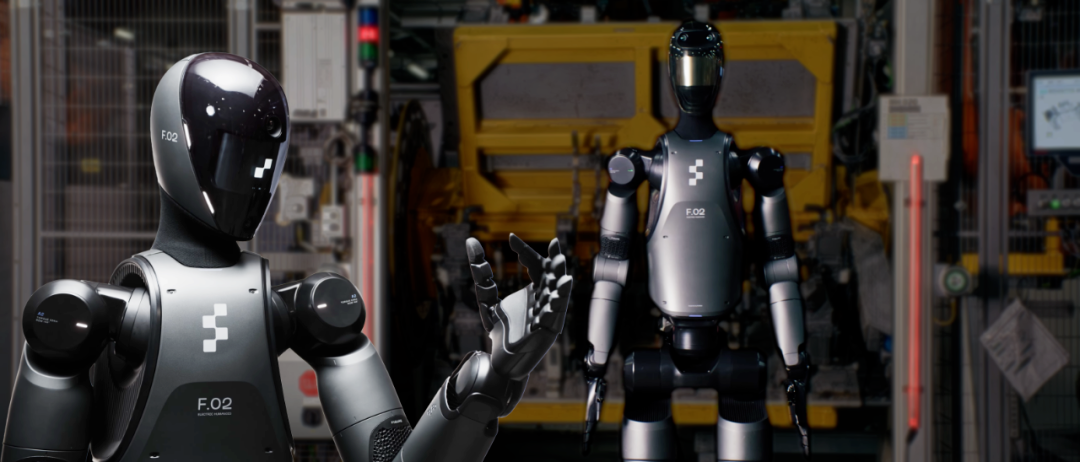

在官方演示中,两台Helix驱动的机器人通过语音指令协同完成厨房杂货分类与收纳,过程中无需任何预编程或物体特定训练。

Figure AI表示,Helix模型已具备在嵌入式低功耗GPU上本地化运行的能力,仅需500小时训练数据(仅为同类模型的5%)。这使得其在家庭服务、仓储物流等场景中具备快速落地的潜力。此外,公司正在计划推进一轮15亿美元的融资,估值飙升至395亿美元(较一年前的26亿美元增长超15倍)。

▍核心技术解析 双系统架构与端到端学习

Helix的技术突破源于其独特的“系统1+系统2”双模块架构设计,系统1为高速响应式视觉运动策略。系统2为基于VLM的场景理解与语义解析。通过解耦架构和高效协同,平衡了通用性与实时性矛盾,同时解决传统机器人学习中的数据效率与泛化难题。

系统1(S1):实时控制的“快反应”模块

功能定位:S1是一个8000万参数的视觉运动Transformer,以200Hz的高频输出精确的连续动作控制信号。其接收S2生成的潜在语义向量,并融合实时视觉与状态数据,实现从意图到动作的毫秒级转化。

技术优势:通过卷积神经网络预训练与端到端联合优化,S1能够直接输出高维动作空间的控制指令(如手指屈曲角度、躯干姿态调整),避免了传统方法中复杂的动作离散化处理。

系统2(S2):语义理解的“慢思考”模块

功能定位:S2是一个70亿参数的开源视觉语言模型(VLM),负责处理自然语言指令与场景理解,以7-9Hz的频率更新任务目标。其核心能力在于从复杂环境中提取语义信息(如“拿起沙漠里的东西”),并将其转化为机器人的高层意图。

训练基础:基于互联网规模的多模态数据预训练,结合机器人操作视频的自动化标注(通过VLM生成事后指令),大幅降低了对人工标注数据的依赖。

端到端训练与异步推理机制

训练策略:Helix采用完全端到端的训练方式,从原始像素和文本指令直接映射到连续动作,并通过时间偏移校准解决双系统延迟差异,能够确保训练与部署的一致性。

部署架构:S2与S1分别运行于独立GPU,通过共享内存实现异步通信。这种设计既保留了S2的深度语义推理能力,又确保了S1的实时控制需求,使整体系统速度媲美单一任务专用策略。

▍抛弃Open AI后Figure 02正在实现从语言智能到具身智能跨越

尽管Open AI在语言模型(如GPT系列)领域占据主导地位,但并非人形机器人的最终解,Helix的发布恰巧印证了人形机器人本体需要的并非语音智能,而是基于VLA模式的具身智能,这也是Figure AI抛弃Open AI的底层逻辑。

Open AI的模型虽在语言理解与生成上表现卓越,但缺乏与物理世界的直接交互接口。Helix通过VLA一体化架构,将语言指令直接转化为机器人动作,实现了感知-认知-行动闭环。

例如,当接收到“将水果放入冰箱”指令时,Helix不仅能识别物体与场景,还能实时规划双机协作路径,而无需依赖外部动作规划器,执行效率上明显高于Open AI。

传统基于VLM的机器人方案(如OpenAI早期探索的Dactyl项目)受限于推理速度与动作离散化问题,且缺乏必要的3D空间理解能力,难以实现人形机器人的精细操作。此外,基于传统的VLM模型进行控制,推理速度很慢,难以满足机器人实时控制的需求。同时连续动作离散化也带来了动作精度上的损失,进一步限制机器人在精细操作任务中的表现。

而Helix通过双系统解耦,在保持语义泛化能力的同时,将控制频率提升至200Hz,并支持35个自由度的连续控制,这在抓取易碎物品或动态避障场景中至关重要。

在算力方面,Helix仅用500小时的多机器人操作数据即实现跨物体泛化。其关键在于利用预训练VLM的常识知识迁移,例如通过“沙漠”语义关联识别仙人掌玩具,而非依赖物体特征库。而传统VLM模型依旧需要海量数据与算力才可完成,训练成本极高。

此外,Helix的本地化部署(无需云端依赖)与低功耗需求(嵌入式GPU即可运行)能够大幅降低用户的使用门槛。相比之下,Open AI的模型更多的依赖于云端API,在实时性与隐私性上存在很大问题。正如Figure AI的CEO Brett Adcock所说,大型语言模型(LLM)已趋商品化,而Helix的护城河在于机器人专属的垂直整合能力。

▍具身智能的“寒武纪时刻”

Helix模型的发布,让我们首次看到人形机器人本体之间的多机协同作业。从技术上进行预测,双系统架构未来衍生的分布式机器人系统,有可能会让未来的人形机器人形成自主协作网络,通过动态分配任务并共享经验。配合低数据依赖与本地化部署,Figure AI很有可能会加速人形机器人大规模部署的商业化进程。

根据高盛、ABI Research等机构数据,全球人形机器人市场规模预计从2023年的18亿美元增长至2035年的380亿美元,年复合增长率(CAGR)达30%。未来随着Figure AI、特斯拉Optimus、波士顿动力Atlas等产品的竞合,人形机器人或将迎来属于它的“寒武纪大爆发”时代。

来源:具身智能大讲堂

(文:机器人大讲堂)