Datawhale干货

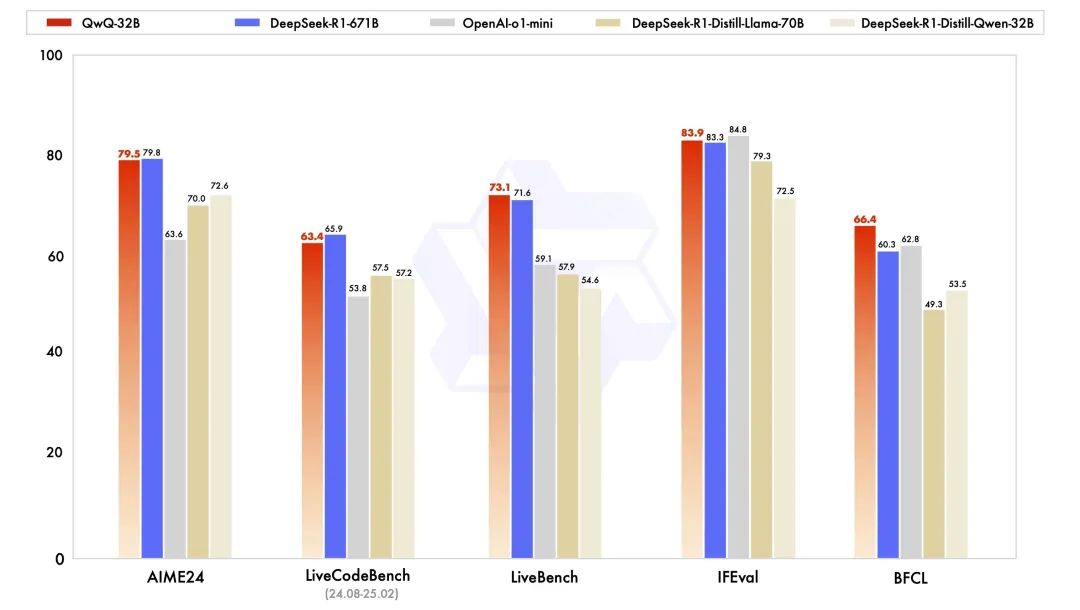

可以看到在官方放出的评测图中, QwQ-32B 与满血版 DeepSeek R1(671B)在五项基准测试的得分不相上下,更是远超同尺寸 R1 蒸馏模型。

看到了这些消息后,我就开始上手深度测试。

QwQ-32B开源链接:

魔搭开源链接:https://modelscope.cn/models/Qwen/QwQ-32B

huggingface开源链接:https://huggingface.co/Qwen/QwQ-32B

在线体验地址:

https://chat.qwen.ai/?models=Qwen2.5-Plus

本地部署:保姆级实战教程

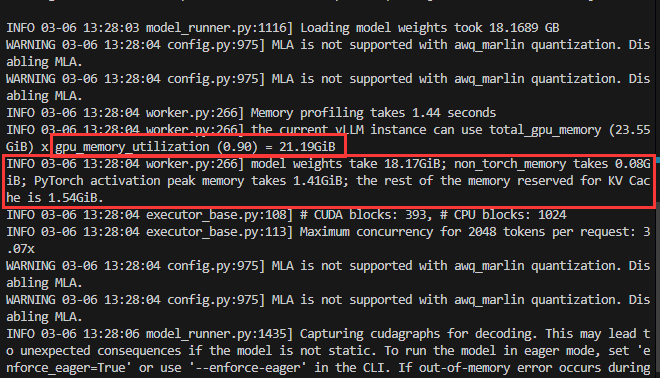

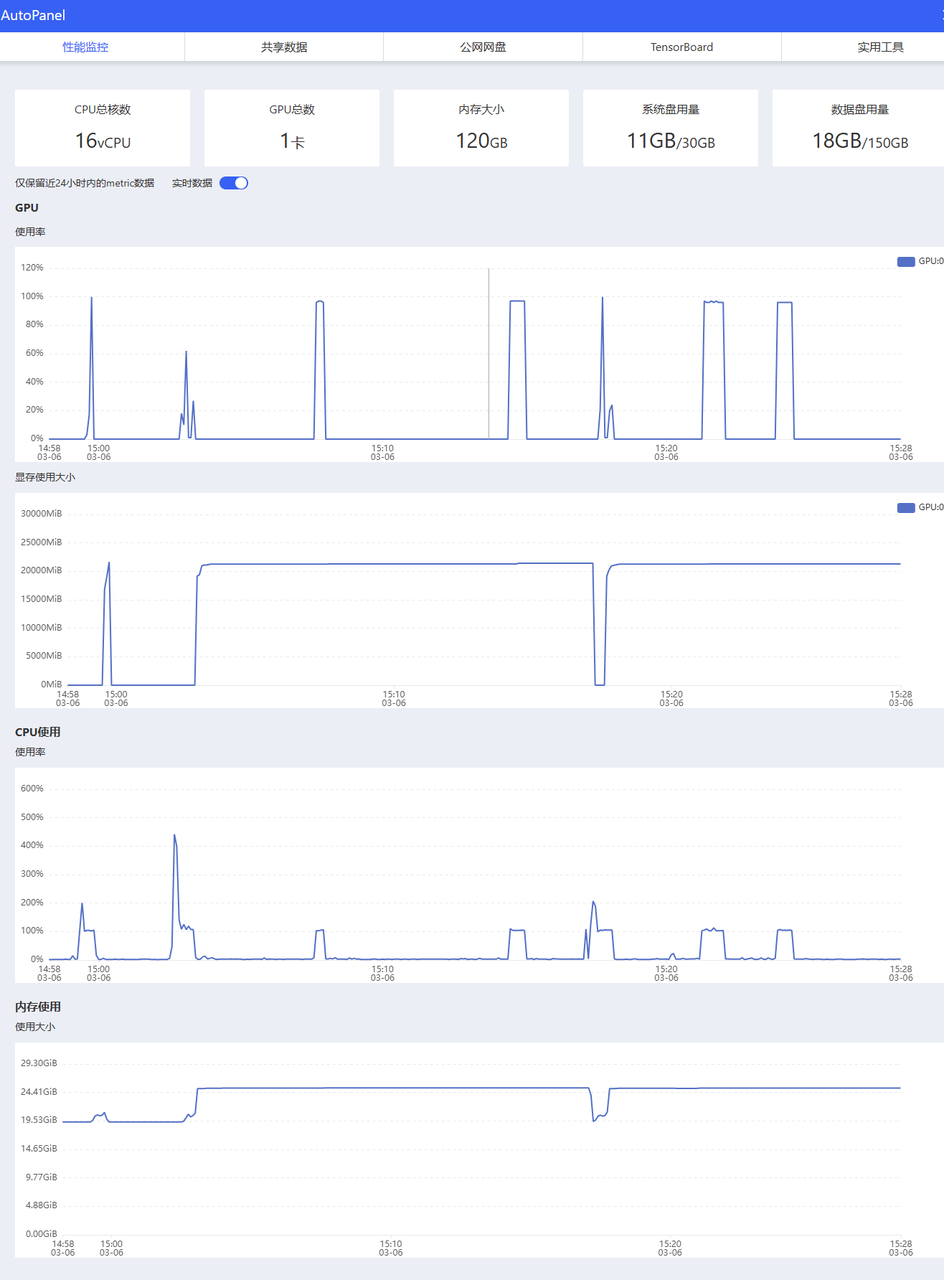

我在 AutoDL 上租用一张 4090,本地部署了一个 QwQ-32B-AWQ 量化版本。

写了个保姆级部署教程,因篇幅原因,大家可以按需查看~

教程地址:https://datawhaler.feishu.cn/docx/Wz2NdqSx1oEZsuxB9zHcEQ20nNe

根据命令行打印的信息可以看到模型在一张 4090 GPU 上完美运行。我给他测试了最近很火的问题:

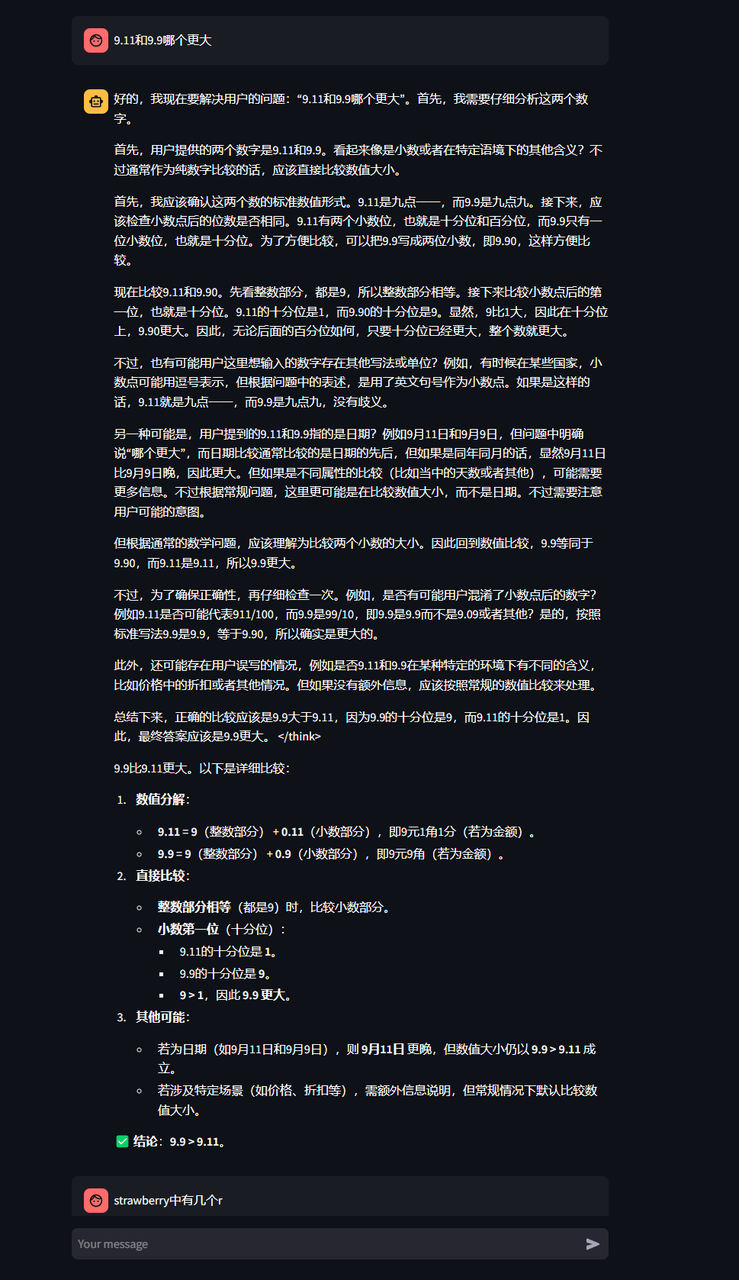

9.11 和 9.9 哪个更大?

推理一共花了 21.39 秒,结果如下所示:

实测下来,QwQ-32B-AWQ 量化版本显存占用不到 18GB ,一张 4090 绰绰有余。而 32B 的 QwQ,也是完美适配消费级硬件。

性能实测

在 QwQ-32B 的性能方面,我分了代码能力、数学能力和逻辑能力三个维度进行测评。

首先是代码能力,我让它“编写一个 python 脚本,显示一个球在旋转的六边形内部弹跳。球应该受到重力和摩擦的影响,并且必须真实地弹跳 off 转动的墙壁。”

可以看到,整个球体的弹跳和撞击特别真实,就连小球带动大框的效果都做出来了,很好的还原了真实的物理场景。

而 Grok-3 在这个问题上直接就炸了,小球直接自由落体。

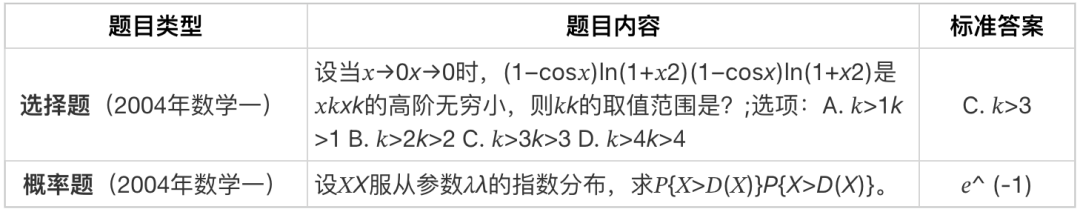

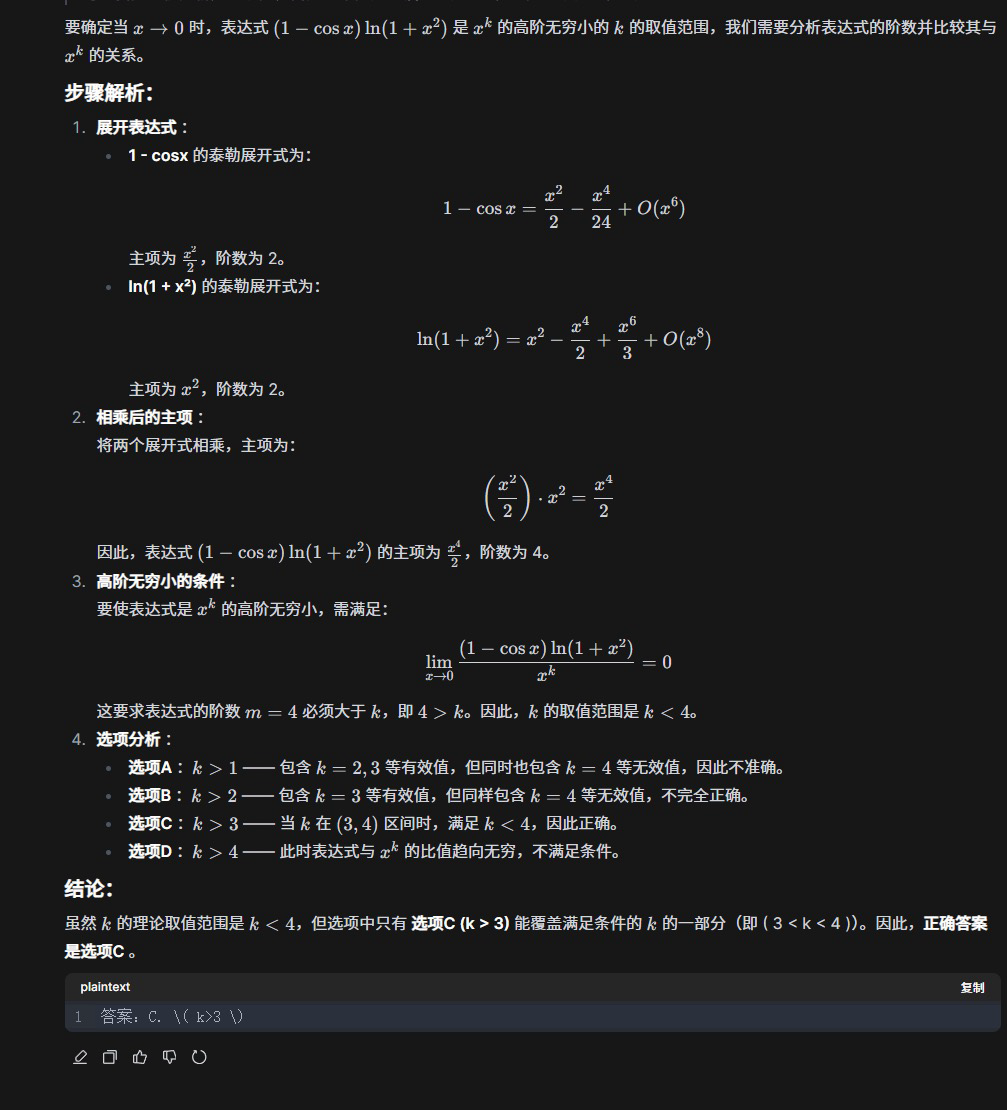

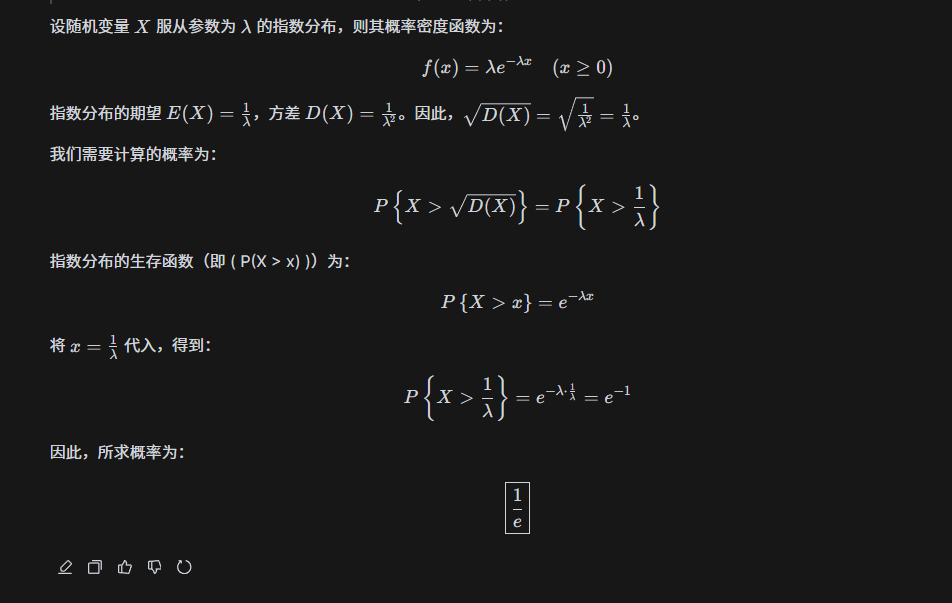

然后我试了试它的数学能力。最近正好考研成绩出了,我就拿了两道数一的考研题进行了测试:

题目一:回答完全正确。

下面我会给你一道数学单选题,请选出正确答案。题目信息如下:

下面说法正确的是( ).

A:跳远测距离,根据的是两点之间线段最短.

B:跳高杆不会掉落,是因为两点确定一条直线.

C:多条跑道找捷径,根据的是垂线段最短.

D:同一路口白色斑马线互相平行,是因为过直线外一点有且只有一条直线与已知直线平行.

结合数学、代码、逻辑推理三个维度的实测,QwQ 的实力还是挺强悍的,一点也不输几个主流的超大杯参数的推理模型。

Agent 相关能力:Function Call

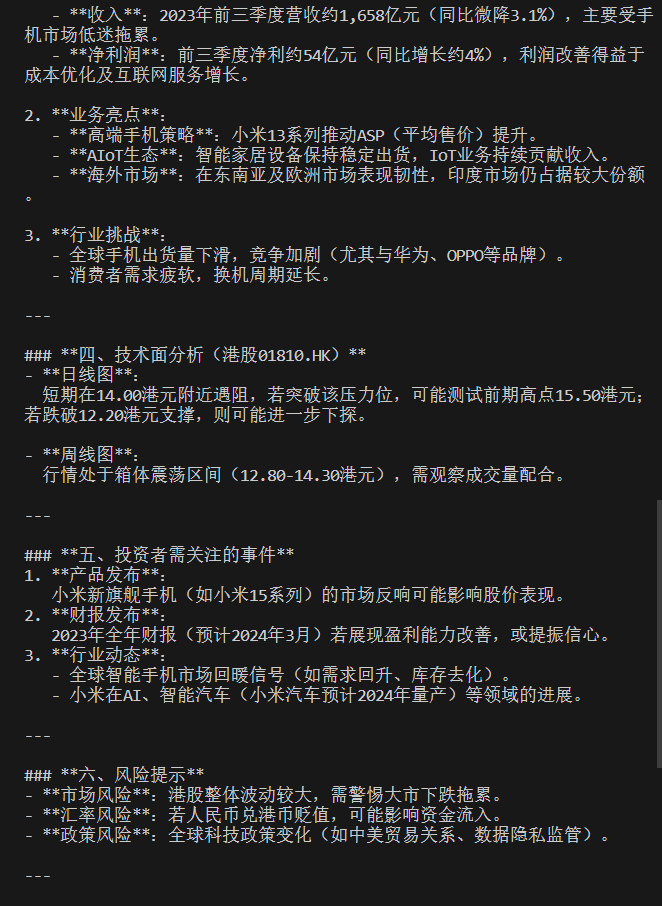

QwQ-32B 中还集成了与 Agent(智能体)相关的能力,支持函数调用。于是我也测试使用了一下,搭建了一个股票数据分析 Agent:

import osfrom openai import OpenAIimport efinance as efimport json# 设置模型的 API 地址openai_api_base = "http://localhost:8000/v1"api_key = "dummy_key" # 本地部署不需要真实 key# 实例化 OpenAI 客户端client = OpenAI(api_key=api_key,base_url=openai_api_base,)# 定义可用的函数def query_stock_code(stock_name):"""查询股票代码"""try:stock_data = ef.stock.get_realtime_quotes(stock_name)return stock_data.to_dict('records')except Exception as e:return {"error": str(e)}def get_stock_history(stock_code, start_date=None, end_date=None):"""获取股票历史数据"""try:history_data = ef.stock.get_quote_history(stock_code, start_date, end_date)return history_data.to_dict('records')except Exception as e:return {"error": str(e)}def get_stock_financial(stock_code):"""获取股票财务数据"""try:financial_data = ef.stock.get_financial_report(stock_code)return financial_data.to_dict('records')except Exception as e:return {"error": str(e)}# 定义函数映射function_map = {"query_stock_code": query_stock_code,"get_stock_history": get_stock_history,"get_stock_financial": get_stock_financial}# 定义函数描述,用于告诉模型可用的函数functions = [{"name": "query_stock_code","description": "查询股票的实时行情数据","parameters": {"type": "object","properties": {"stock_name": {"type": "string","description": "股票名称或代码"}},"required": ["stock_name"]}},{"name": "get_stock_history","description": "获取股票的历史行情数据","parameters": {"type": "object","properties": {"stock_code": {"type": "string","description": "股票代码"},"start_date": {"type": "string","description": "开始日期,格式为YYYY-MM-DD"},"end_date": {"type": "string","description": "结束日期,格式为YYYY-MM-DD"}},"required": ["stock_code"]}},{"name": "get_stock_financial","description": "获取股票的财务报表数据","parameters": {"type": "object","properties": {"stock_code": {"type": "string","description": "股票代码"}},"required": ["stock_code"]}}]def interactive_stock_query():"""交互式股票查询功能"""print("欢迎使用股票查询助手!您可以询问任何有关股票的问题。输入'退出'结束对话。")# 保存对话历史conversation_history = []while True:user_input = input("\n请输入您的问题: ")if user_input.lower() in ['退出', 'exit', 'quit']:print("感谢使用,再见!")break# 添加用户输入到对话历史conversation_history.append({"role": "user", "content": user_input})try:# 调用模型,允许函数调用response = client.chat.completions.create(model="QwQ-32B",messages=conversation_history,functions=functions,function_call="auto")assistant_message = response.choices[0].message# 添加助手回复到对话历史conversation_history.append(assistant_message)# 检查是否有函数调用if assistant_message.function_call:function_call = assistant_message.function_callfunction_name = function_call.name# 解析函数参数try:function_args = json.loads(function_call.arguments)except json.JSONDecodeError:print("函数参数解析错误")continueprint(f"正在调用函数: {function_name}")# 执行函数if function_name in function_map:function_to_call = function_map[function_name]function_response = function_to_call(**function_args)# 将函数执行结果添加到对话历史conversation_history.append({"role": "function","name": function_name,"content": json.dumps(function_response, ensure_ascii=False)})# 再次调用模型,让它解释函数执行结果second_response = client.chat.completions.create(model="QwQ-32B",messages=conversation_history)# 输出模型解释print("\n助手:", second_response.choices[0].message.content)# 添加到对话历史conversation_history.append(second_response.choices[0].message)else:print(f"未知函数: {function_name}")else:# 直接输出模型回复print("\n助手:", assistant_message.content)except Exception as e:print(f"发生错误: {str(e)}")if __name__ == "__main__":interactive_stock_query()

成果展示:

支持 Function Call 不仅增强了模型的实际应用能力,还能使它能够在使用工具的同时进行批判性思考,并根据环境反馈调整推理过程。

写在最后

总体来说,这次通义开源的 QwQ-32B 推理模型还是很不错的:

-

第一是 32B 小参数模型性能与超大参数的推理模型性能不相上下,做到了在保证性能的同时降低对计算资源的依赖,从而实现更加环保、可持续的AI技术发展;

-

第二是响应速度也是相当不错的,不会遇到服务器繁忙的情况;

-

第三是它支持

function call功能,这一点对于模型开发来说有多重要就不必多说了。

如今,距离 o1 模型发布不过五个月,推理模型领域已经迎来了百花齐放的新局面。

犹记得前段时间大家还在全网寻找 “满血版”DeepSeek-R1 的使用渠道,转眼间就出现了小尺寸且性能强悍的 QwQ-32B 模型。这个量级在本地部署没太大压力,也可以在阿里云百炼平台调用 QwQ 的 API 进行开发。对于创业者、小型团队,或者想要做专业 AI 应用的公司而言,成本大大降低。

自 2023 年 8 月以来,通义千问累计开源了 200 多款模型。很低调,但在做实事,真正在推动大模型技术的普惠和应用的落地,促进国内大模型生态的繁荣。

向通义千问团队致敬。

一起“点赞”三连↓

(文:AI工程化)