梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

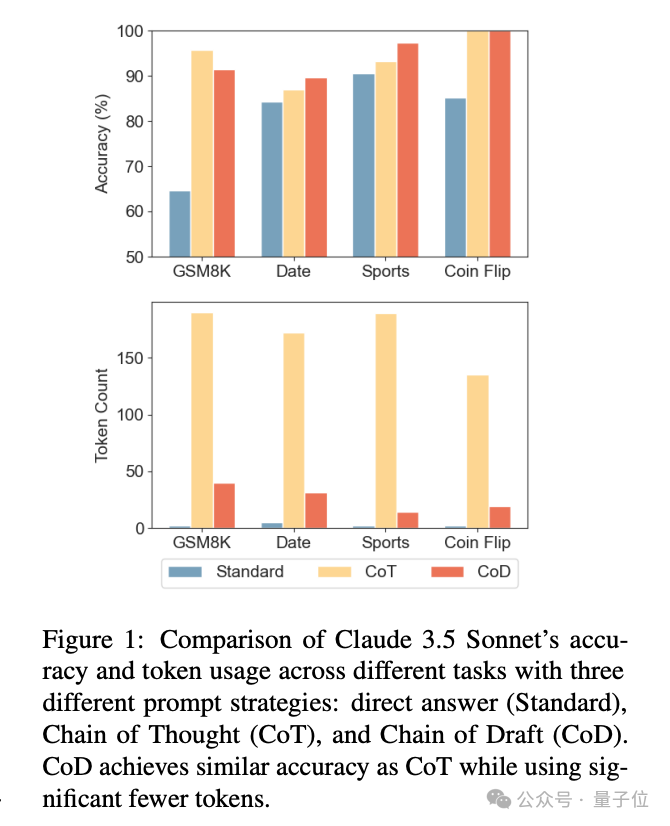

推理token减少80%-90%,准确率变化不大,某些任务还能增加。

Zoom团队提出思维链替代品“草稿链”,显著降低延迟和算力成本。

原理很简单,要求模型为每个推理步骤生成简洁、信息密集的token。

这一思路受到人类解题过程启发,人类通常不会详细阐述每一个细节,只是简单几下关键的中间结果,作为草稿来辅助思考。

此外,草稿链方法简单且易于实现,不需要修改模型、微调或强化学习,只需更新提示词中的示例即可,相关代码和数据已在GitHub上开源。

研究团队认为,与另一种降低延迟和计算成本的方法“在连续潜空间推理”相比,草稿链保留了可解释性,且可以应用于闭源的黑盒模型。

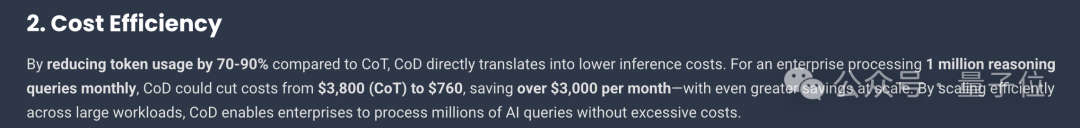

第三方分析测算,对于每个月处理100万个推理请求的企业, 可以将成本从思维链的3800美元降低到760美元,每月节省超过3000美元。

实验验证:准确率不降,成本大幅降低

实验遵循原始思维链论文,评估3类任务:算术推理、常识推理和符号推理。

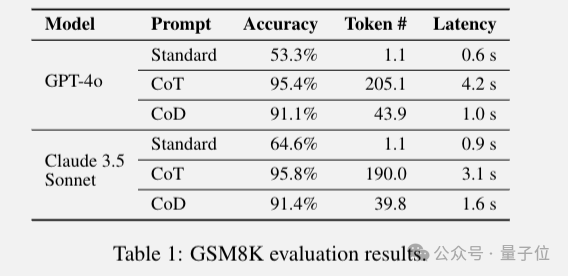

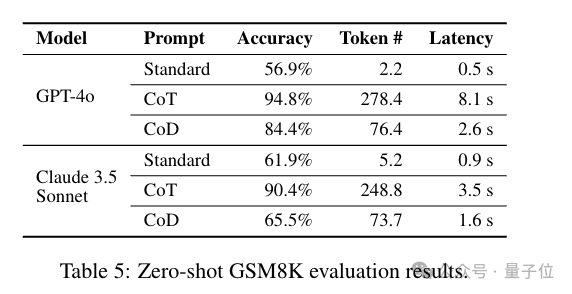

算数推理任务选择GSM8k数据集,从准确率看,标准提示下GPT-4o和Claude 3.5 Sonnet的准确率分别仅53.3%和64.6%,思维链使两者均超95%,草稿链也达到91%左右。

在token使用上,思维链生成约200个token/响应,草稿链仅约40个,减少约80%。

延迟方面,草稿链使GPT-4o和Claude 3.5 Sonnet的平均延迟分别降低76.2%和48.4%。

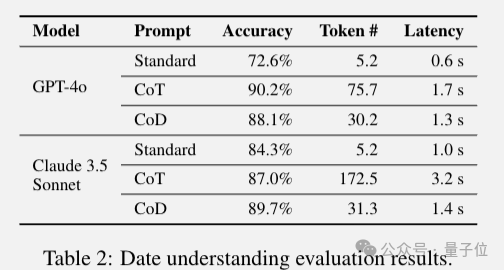

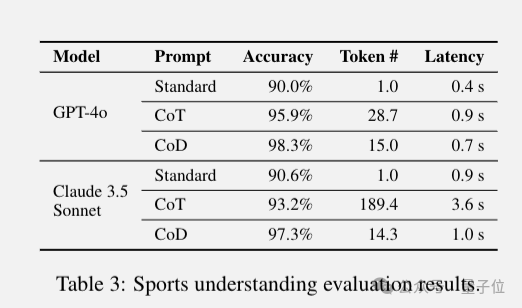

常识推理选择BIG-bench 的日期理解和运动理解任务也取得了相似的结果,特别值得注意的是Claude 3.5 Sonnet在草稿链下准确率还有所上升。

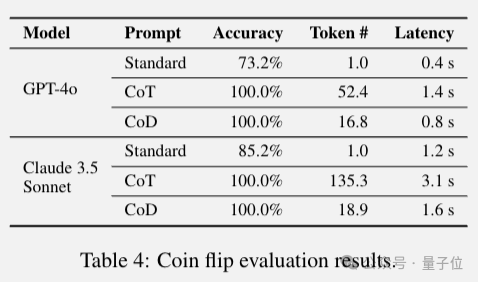

符号推理选择抛硬币任务,由于原数据集未公开,作者合成了250个示例的测试集。

草稿链在保持100%准确率的情况下大幅减少了推理token和延迟。

但草稿链方法也有一定的局限性:在零样本设置下有效性会显著下降。

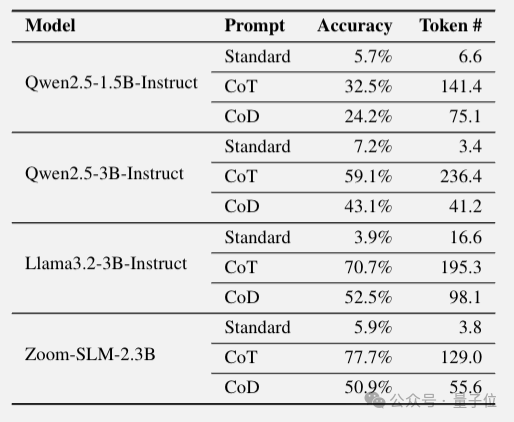

此外,在参数量小于30亿的小模型上,虽然草稿链仍能有效减少每个回答所需的token数并提高准确率,但与思维链相比,性能差距更大。

研究团队推测,可能是由于训练数据中缺乏草稿链风格的推理模式,在不提供few-shot样本指导的情况下,很难生成简洁而有帮助的”草稿”。

论文地址:

https://arxiv.org/abs/2502.18600v2

(文:量子位)