极市导读

上海人工智能实验室发布了通用具身智能仿真平台GRUtopia 2.0,通过通用模块化框架、场景资产自动化生成和高效数据采集系统三大革新,实现了仅用三行代码定义任务,数据采集效率最高提升20倍,为具身智能研究提供了一站式的高效开发解决方案。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

2月22日,2025 GDC“浦江AI生态论坛”在上海徐汇举行。论坛现场,上海人工智能实验室(上海AI实验室)发布通用具身智能仿真平台桃源2.0(GRUtopia2.0),并面向全球开发者开放。

在首个“城市级”大规模仿真平台GRUtopia1.0的基础上,升级后的GRUtopia2.0凭借通用模块化框架、场景资产自动化生成、高效数据采集系统三大革新,进一步向通用化、多样化、易用化迈进。仅通过单一平台、简单代码输入,即可实现仿真环境中机器人灵活训练,提升数据采集效率,为研究者提供了“一站式”具身智能开发解决方案。

近期,上海AI实验室完成首次“虚实贯通”技术体系全闭环验证,在“真实-模拟-真实”(Real-to-Sim-to-Real)路径下,加速打造可自主演进的具身智能进程。作为该体系“模拟”环节的核心,GRUtopia 2.0以高性能仿真,推动具身智能“在虚拟中走向现实”。平台数据集、模型、工具链等将陆续开源,与业界伙伴共同促进技术进步与生态繁荣。

项目链接:https://github.com/OpenRobotLab/GRUtopia

针对真实场景训练数据匮乏的核心痛点,上海AI实验室在业内较早开展数字模拟平台构建,于2024年7月发布的GRUtopia1.0,涵盖89种功能性场景、10万级别高质量可交互数据,以数据、工具链、评测三位一体赋能仿真训练。

本次全新升级的GRUtopia2.0版本,具备大规模数据生产能力,数据采集方式实现了三大方面的革新,并可以多样化和易用性适配多类型机器人:

-

新增通用模块化仿真框架: 支持包含导航、操作、运动控制在内的任意具身任务,用户无需切换多平台,“三行代码”即可定义任意任务,简化开发流程 -

场景资产自动化功能增强: 集成百万级标准化物体资产,结合场景的自动化生成和随机化工具,实现复杂场景“一键生成”。 -

数据采集系统更高效: 提供面向操作任务的多种低门槛遥操作工具,以及面向导航的批量化数据采集工具。遥操效率相较空间鼠标提升5倍,导航任务数据采集效率最高提升20倍。

通用平台:单平台实现控制到决策任务训练

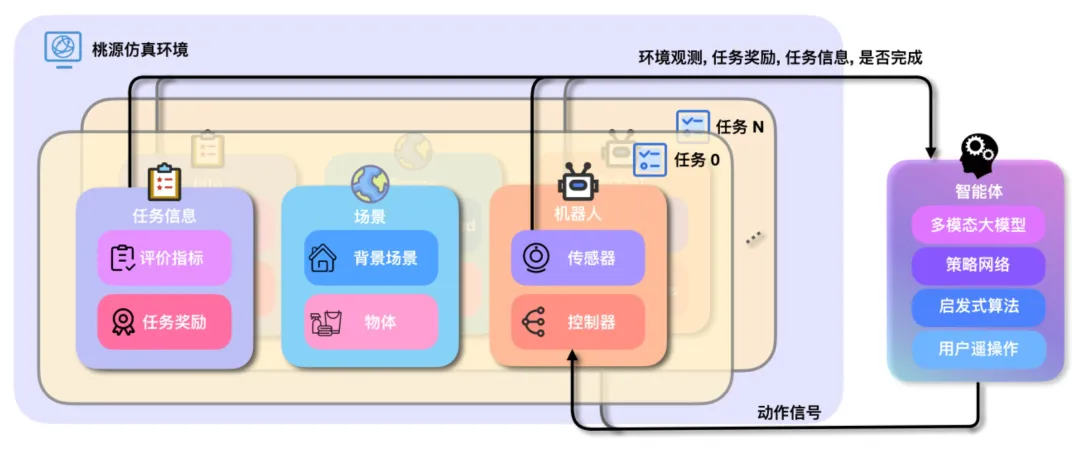

为实现单一平台覆盖从底层控制到顶层决策任务的“通用性”训练需求,上海AI实验室研究团队为GRUtopia2.0设计了功能全面的模块化框架,具备代码轻量和灵活拓展的特性,从而提升用户使用体验。

模块化框架将训练任务拆解为“场景、机器人、任务指标”三要素,用户仅需三行代码即可完成任意具身任务的定义。平台内置多种机器人、控制器、评价指标、任务奖励等模块的实现,仅通过对原生模块的组合即可实现多种导航、操作和控制任务。

模块化设计同时赋予了GRUtopia2.0极高的扩展性。通过代码指令,用户可为机器人增加腰部雷达、加装灵巧手,为任务添加新的评价指标。得益于平台设计的扁平继承关系,用户可以快速定位并修改具体的功能逻辑,从而实现个性化的功能扩展。

为满足从底层控制到高层决策的多层级研究需求,平台提供了广义控制器模块,用户可根据需要定制机器人控制方式。多个控制器可以级联使用,实现复杂的控制行为。以人形机器人导航任务为例,用户可以定义多个控制器层次,如步态控制器、路径跟踪控制器和路径规划器,并通过级联实现高效的导航任务。

此外,GRUtopia2.0平台兼容标准Gym接口,支持与第三方算法库(如SB3)的对接,使得任务算法的训练更加便捷。

多样化生成:百万物体资产导入,复杂场景“一键生成”

当前,由于搭建难度高,高质量数字场景资产匮乏,成为仿真训练的主要限制之一。为此,GRUtopia2.0提供了高质量物体资产数据及自动化场景生成工具,使具身训练更贴近复杂的真实世界场景。

延续GRScenes-100场景数据集的多样化特性,研究人员对其进行了进一步标准化处理,将场景拆分成物体组合、模型、材质,允许用户多粒度灵活复用。同时提供标准化工具,将3D物体数据集Objaverse的数据资产进行统一标准的结构化管理,转化为百万级可复用的物体资产。

GRUtopia2.0的自动化场景搭建工具,在Infinigen场景布局生成框架的基础上,引入高质量的物体资产和材质填充场景,并在生成过程加入一致性约束,使得生成的场景更加真实与和谐。用户使用随机化工具,可实现自动化的灯光、物体材质、模型和局部布局的随机替换,满足训练过程中对数据增强的高质量需求。

高效易用:导航遥操“全家桶”,最高增效20倍

真实定制化数据的匮乏,催生仿真平台数据采集。为满足用户对于定制化数据采集的需求,GRUtopia2.0提供了面向操作、导航任务等高效数据收集管线,让系统更易用高效。

弥补传统遥操作工具活动范围、距离感知、动作精度弱等带来的数据采集方式限制,研究人员为GRUtopia2.0引入VR、动作捕捉、双手协调的等机器人遥操作手段,提升模拟数据采集效率。进一步拉低使用门槛,首创设计双手协调的“隔空操作模式”,无需视觉及操作硬件,通过动作捕捉即可控制机器人的运动、视角转换、坐标系重定位和运动精度调整的功能。相较传统空间鼠标方式,可实现5倍的操作效率提升,单人一天即可采集上百条复杂操作数据。

在面向导航的数据采集管线中,GRUtopia2.0利用全局地图ESDF并行采样合成海量轨迹数据,较人工操作传统方式提升近20倍。同时设置了针对轮式、足式及虚拟机器人提供了默认的路径规划控制器,以实现在GRScenes-100、Matterport3D场景中自动化的路径跟随和观测、动作数据采集。平台还提供了批量化工具,支持进行并行的大规模导航数据采集。

(文:极市干货)