Shark 投稿

量子位 | 公众号 QbitAI

从自动驾驶、机器人导航,到AR/VR等前沿应用,SLAM都是离不开的核心技术之一。

现有基于3D高斯分布(3DGS)的SLAM方法虽在室内场景表现出色,但使用仅RGB输入来处理无界的户外场景仍然面临挑战:

-

准确的深度和尺度估计困难,这影响了姿态精度和3DGS初始化

-

图像重叠有限且视角单一,缺乏有效的约束,导致训练难以收敛

为了解决上述挑战,港科广团队提出全新解决方案——OpenGS-SLAM。仅凭RGB图像实现高精度定位与逼真场景重建。

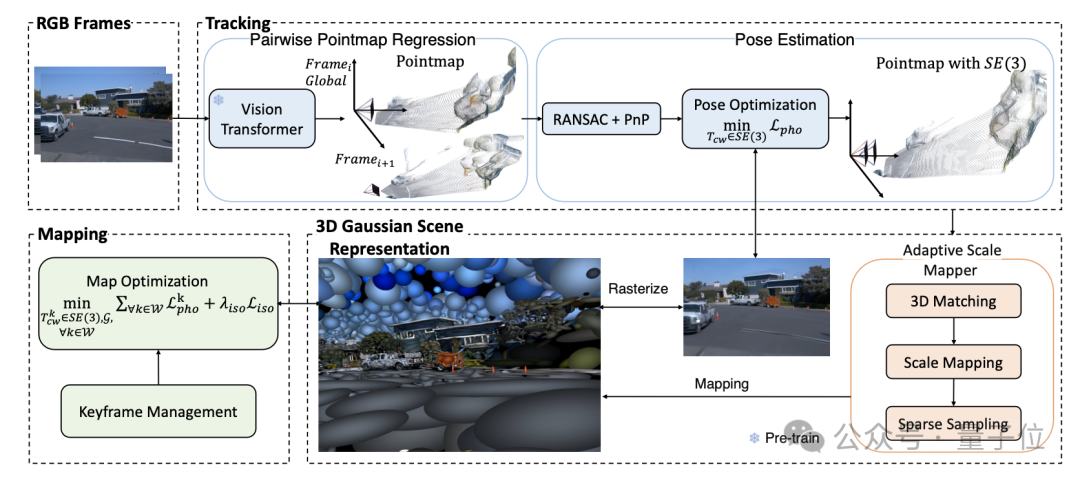

△OpenGS-SLAM管线示意图

具体来说,研究人员采用了一个点图回归网络来生成帧间一致的点图。

这些点图储存了来自多个标准视角的3D结构,包含了视角关系、2D到3D的对应关系和场景几何信息。这使得相机位姿估计更加稳健,有效缓解了预训练深度网络的误差问题。

此外,OpenGS-SLAM将相机位姿估计与3DGS渲染集成到一个端到端可微的管道中。通过这种方式,实现了位姿和3DGS参数的联合优化,显著提高了系统的跟踪精度。

研究人员还设计了一种自适应比例映射器和动态学习率调整策略,能够更准确地将点图映射到3DGS地图表示。

值得注意的是,在Waymo数据集上的实验表明,OpenGS-SLAM将追踪误差降低至现有3DGS方法的9.8%。研究人员还在新视角合成任务上建立了一个新的基准,达到了最先进的结果。

基于3DGS表示的RGB-only SLAM系统

来看具体技术细节。

在OpenGS-SLAM的管线示意图可以看到,每一帧都会输入一张RGB图像用于追踪。

当前帧和上一帧作为图片对输入到Pointmap回归网络进行位姿估计,随后基于当前的3D高斯地图进行位姿优化。

在关键帧处,系统执行地图更新,并通过自适应尺度映射器(Adaptive Scale Mapper)对Pointmap进行处理,以插入新的3D高斯点。

此外,相机位姿与3D高斯地图会在局部窗口内进行联合优化,确保更精准的追踪与场景重建。

追踪

帧间点图回归与位姿估计

之前基于3DGS和NeRF的SLAM工作,主要集中在室内和小规模场景中,其中相机的运动幅度较小,视角密集。在这种情况下,NeRF或3DGS可以直接用于优化相机位姿。

然而,户外场景通常涉及基于车辆的摄影,特征是运动幅度较大且视角相对稀疏。这使得直接优化相机位姿难以收敛。

鉴于点图包含视角关系、2D到3D的对应关系和场景几何信息,OpenGS-SLAM团队提出了一种基于帧间点图回归网络的位姿估计方法,旨在实现稳健且快速的当前帧相机位姿估计。

他们利用一个预训练的点图回归网络,该网络结合了ViT编码器、带有自注意力和交叉注意力层的Transformer解码器以及一个MLP回归头,生成连续帧图像的点图。特别地,两个图像分支之间的信息共享有助于点图的正确对齐。

尽管应用点图可能看起来有些反直觉,但它能够在图像空间中有效表示3D形状,并且允许在不同视角的射线之间进行三角测量,而不受深度估计质量的限制。随后,团队使用稳健且广泛应用的RANSAC和PnP来推断两帧之间的相对姿态 ,使用这种方法,可以估计第k帧的位姿为:

,使用这种方法,可以估计第k帧的位姿为: 。

。

位姿优化

为了实现精确的相机位姿追踪,团队基于3DGS可微光栅化管道,构建了一套可微的相机位姿优化方法。

定义光度损失为:

其中 表示每个像素的可微渲染函数,通过高斯

表示每个像素的可微渲染函数,通过高斯 和相机位姿

和相机位姿 生成图像,

生成图像, 表示真实图像。光度损失

表示真实图像。光度损失 关于位姿

关于位姿

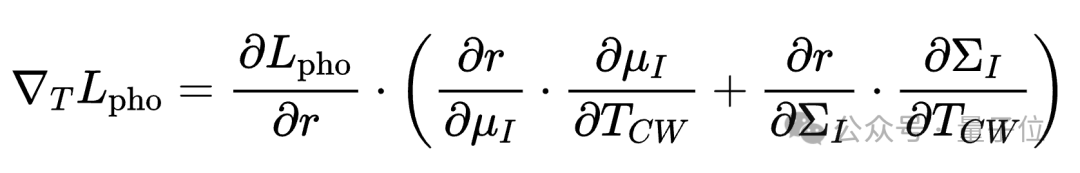

的梯度为:

通过这些步骤,利用渲染函数的微分,将增量位姿更新与光度损失紧密关联。这一策略使得相机位姿能够基于3DGS 渲染结果进行端到端优化,从而确保高精度且稳定的位姿跟踪。

3DGS场景表示

研究人员使用3DGS作为场景表示,提出自适应尺度映射器(Adaptive Scale Mapper),在关键帧时为地图插入新的高斯点。

利用先前获得的点图来映射3D高斯地图,由于帧间点图存在尺度不稳定的问题,研究人员基于点匹配关系计算连续帧之间的相对尺度变化因子,以确保整个场景的尺度一致性。

建图

高斯地图优化

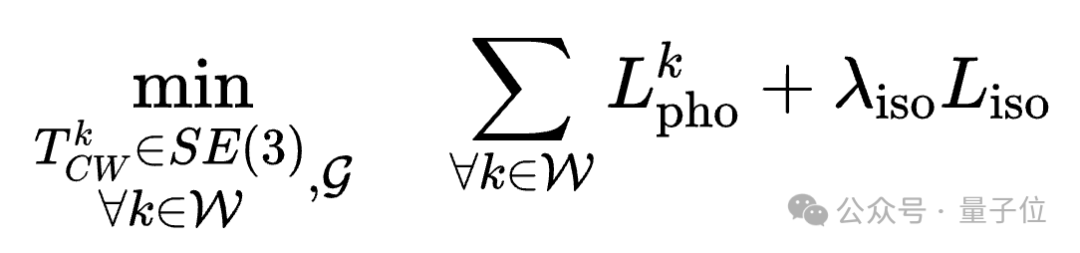

管理一个局部关键帧窗口 ,以选择观察相同区域的非冗余关键帧,为后续的建图优化提供更高效的多视角约束。在每个关键帧上,通过联合优化

,以选择观察相同区域的非冗余关键帧,为后续的建图优化提供更高效的多视角约束。在每个关键帧上,通过联合优化 窗口中的高斯属性和相机位姿来实现局部BA。

窗口中的高斯属性和相机位姿来实现局部BA。

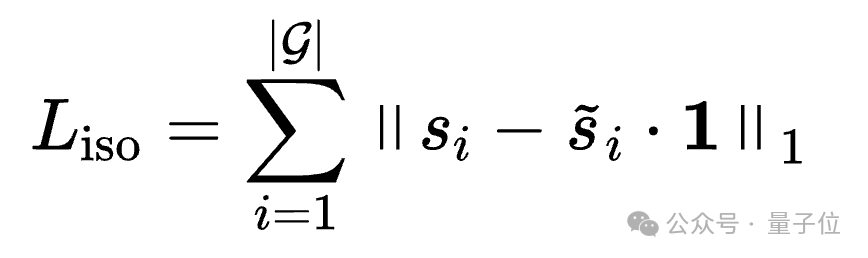

优化过程仍然通过最小化光度损失进行。为了减少高斯椭球体的过度拉伸,研究人员采用了各向同性正则化:

高斯地图优化任务可以总结为:

自适应学习率调整

在经典的室内 SLAM 数据集中,相机通常围绕小范围场景运动并形成闭环,使高斯优化的学习率随迭代次数逐渐衰减。然而,户外数据由前向车辆相机捕获,所经过区域不会重访,因此需要不同的学习率衰减策略。

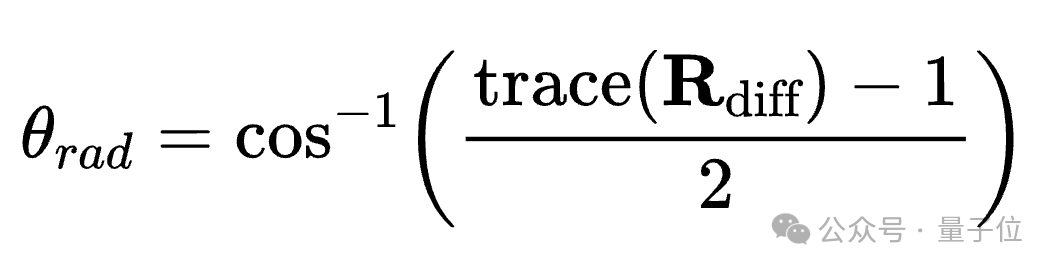

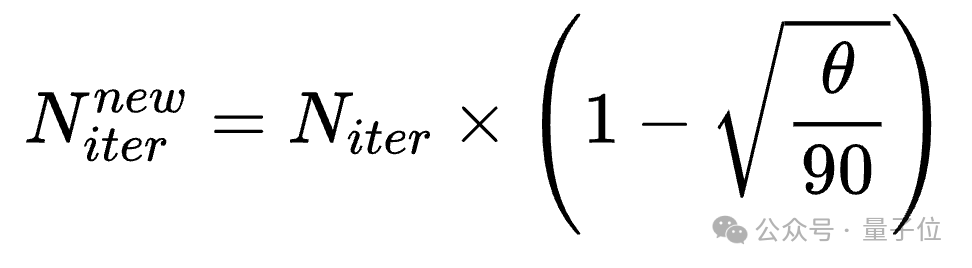

为此,研究人员提出了一种基于旋转角度的自适应学习率调整策略:当车辆沿直路行驶时,学习率逐步衰减;在遇到坡道或转弯时,动态提升学习率,以更有效地优化新场景。

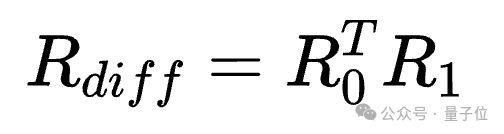

首先,计算当前关键帧和上一关键帧之间的旋转矩阵 和

和 ,其相对旋转矩阵为:

,其相对旋转矩阵为:

接着计算旋转弧度:

接着将弧度 转换为度数

转换为度数 ,并根据以下公式调整累计迭代次数:

,并根据以下公式调整累计迭代次数:

当旋转角度达到90度时,累积迭代次数将被重置。

实验结果

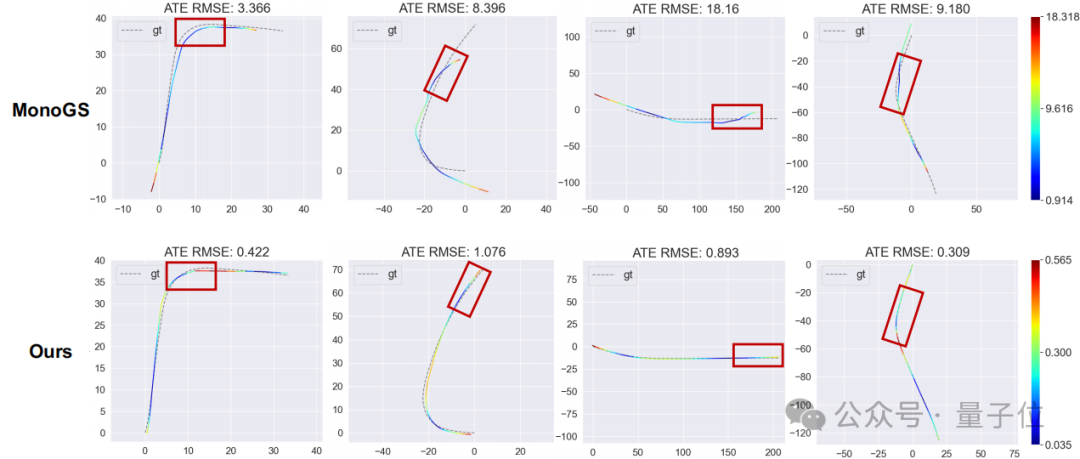

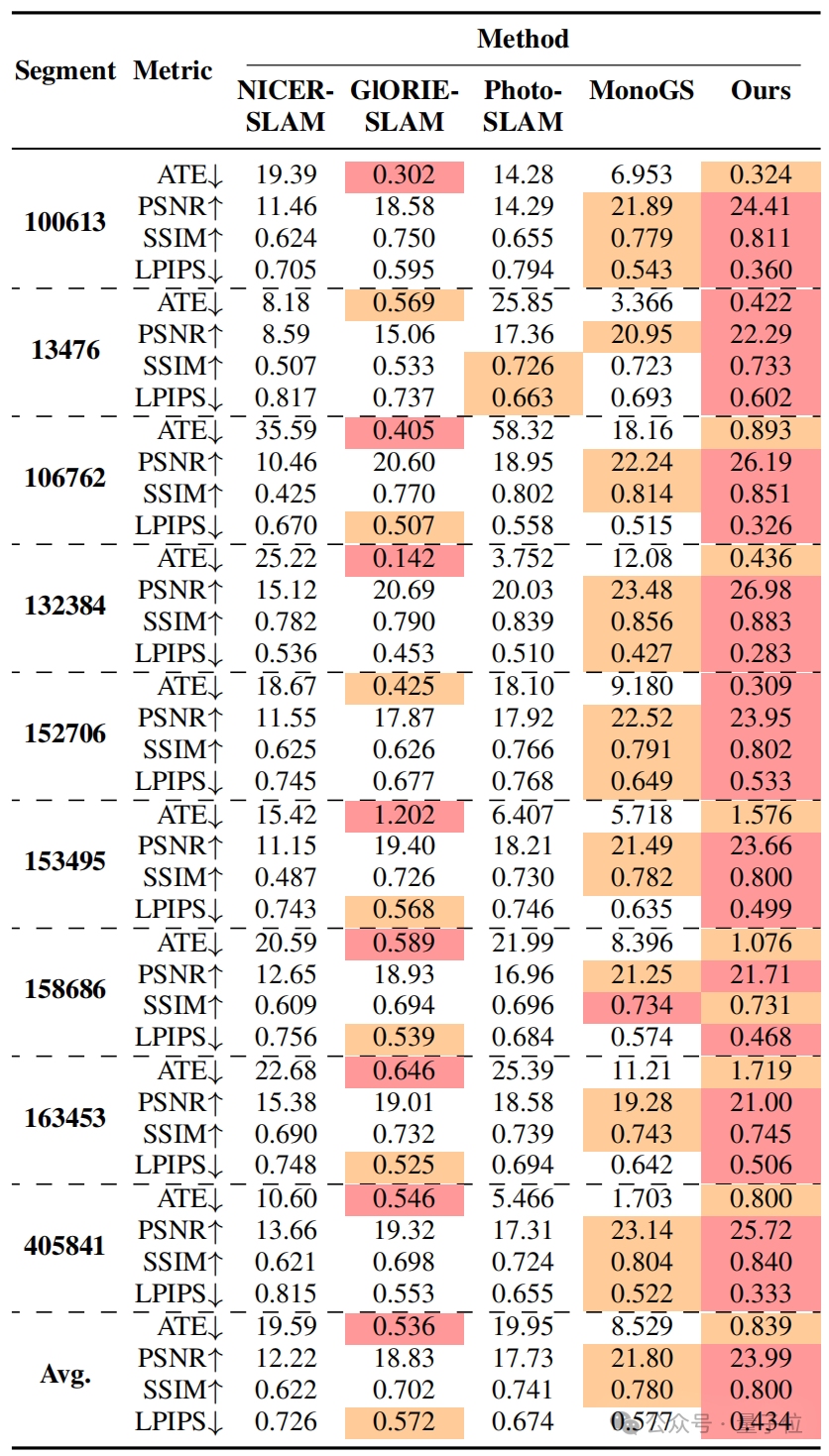

如下图所示,在Waymo数据集的无界户外场景上,OpenGS-SLAM能渲染高保真的新视角图片,准确捕捉车辆、街道和建筑物的细节。相比之下,MonoGS和GlORIE-SLAM存在渲染模糊和失真的问题。

精度方面,OpenGS-SLAM在Waymo数据集上实现了新视角合成(NVS)的最佳性能。在追踪精度方面,与GlORIE-SLAM相当;而相比同样基于3DGS的SLAM方法MonoGS,OpenGS-SLAM误差降低至 9.8%,显著提升了系统的鲁棒性和准确性。

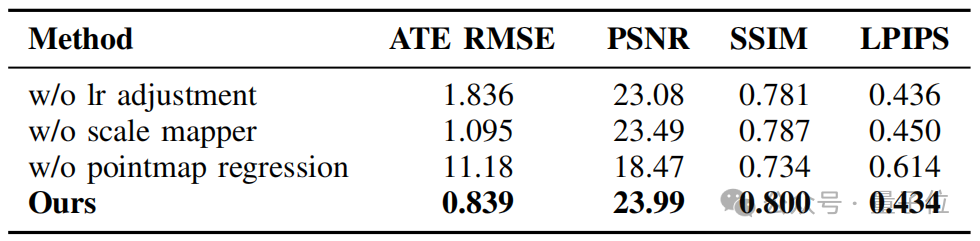

消融研究结果显示,自适应学习率调整和自适应尺度映射均对整体性能产生积极影响,而Pointmap回归网络更是本方法的核心支撑,对系统性能至关重要。

总结

OpenGS-SLAM是一种基于3DGS表示的RGB-only SLAM系统,适用于无界的户外场景。

该方法将点图回归网络与3DGS表示结合,确保精确的相机姿态跟踪和出色的新视图合成能力。

与其他基于3DGS的SLAM系统相比,该方法在户外环境中提供了更高的跟踪精度和鲁棒性,使其在实际应用中具有较高的实用性。

论文链接:https://arxiv.org/abs/2502.15633

代码链接:https://github.com/3DAgentWorld/OpenGS-SLAM

官方主页:https://3dagentworld.github.io/opengs-slam/

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

—

(文:量子位)