跳至内容

老黄会前穿着“外卖”围裙送汉堡(图片来源:视频截图)

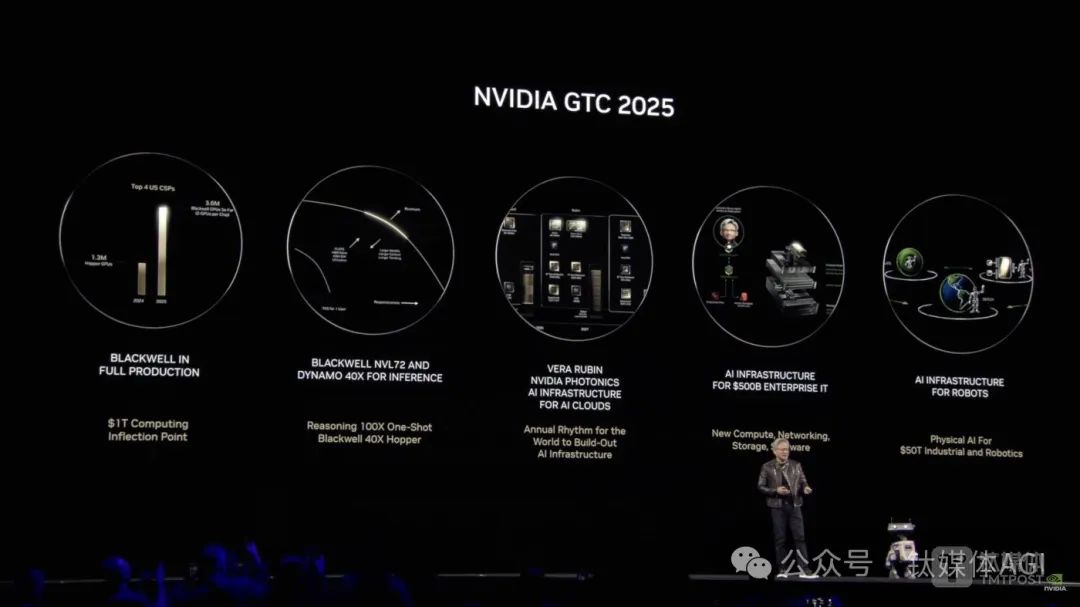

北京时间3月19日凌晨,“AI超级碗”GTC大会上,英伟达创始人兼CEO黄仁勋向全球推出最强AI芯片GB300,个人AI超级计算机DGX Spark,并预告新一代芯片Vera Rubin等新品。

其中,GB300基于全新Blackwell Ultra架构,和去年发布的GB200相比,性能提升1.5倍,新的注意力机制(New Attention instructions)提升2倍,拥有20TB HBM高带宽存储提升1.5倍,预计将在今年下半年出货。

英伟达表示,基于GB300的英伟达GB300 NVL72 机架级解决方案的 AI 性能比 GB200 NVL72 高出 1.5 倍,与使用英伟达Hopper构建的工厂相比使Blackwell的AI工厂收入机会增加50倍。

同时,与Hopper一代相比,NVIDIA HGX B300 NVL16 在大型语言模型上的推理速度提高11倍,计算能力提高7倍,内存增加4倍,从而为 AI 推理等最复杂的工作负载提供突破性能。首批当中,预计思科、戴尔、联想、超微电脑、华硕、富士康等提供基于Blackwell Ultra服务器,AWS、谷歌云、微软云、甲骨文云等云厂商将首批提供Blackwell Ultra支持实例。

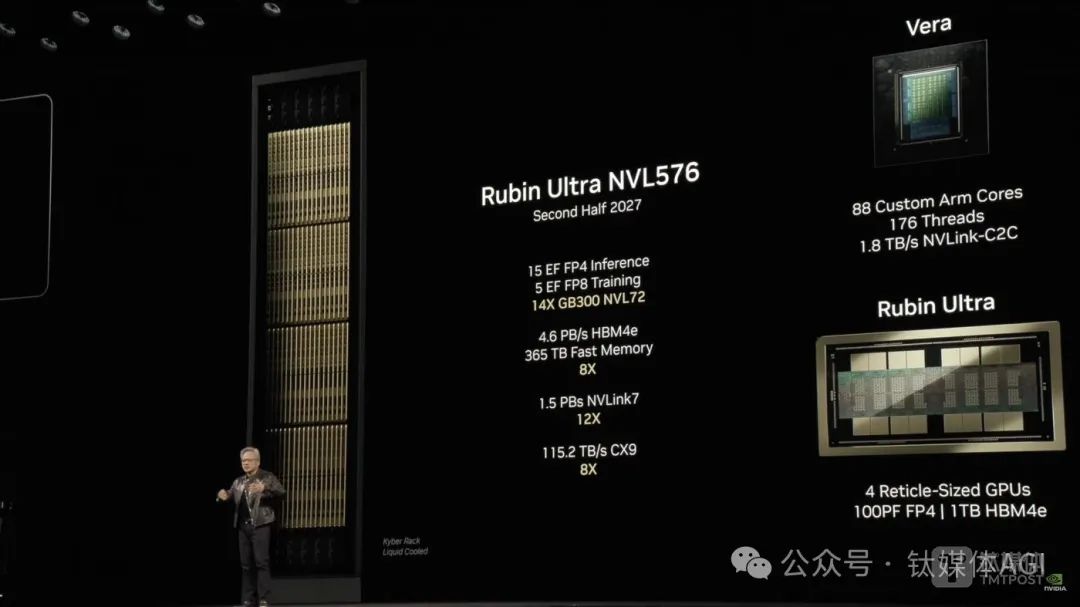

Vera Rubin方面,与Grace Blackwell(GB)类似,Vera是CPU,Rubin是GPU,而Vera Rubin整体性能是GB300的3.3倍,CPU内存容量是Grace的4.2倍,内存带宽是Grace的2.4倍,预计将于2026年下半年量产出货;此外,黄仁勋还预览了下一代AI超级芯片Rubin Ultra,内存带宽是前代的8倍,性能是GB300的14倍;Rubin下一代GPU架构则是Feynman。

黄仁勋表示:“AI已经取得了巨大的飞跃——推理和Agentic AI需要更高数量的计算性能。我们为这一刻设计了 Blackwell Ultra——它是一个单一的多功能平台,可以轻松高效地进行预训练、后训练和推理 AI 能力。”

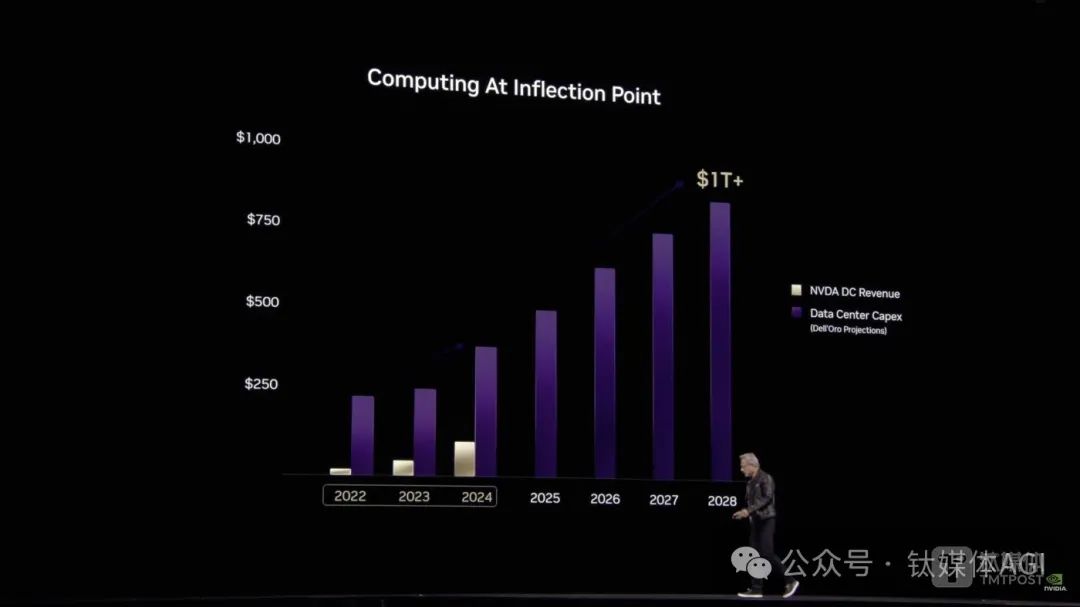

据黄仁勋透露,今年,微软、谷歌、亚马逊和Meta四家大型云服务商已经购入360万颗Blackwell芯片,预计2028年数据中心资本支出规模突破1万亿美元。

事实上,当前对于华尔街来说,这场演讲也可以看作是黄仁勋的“股价保卫战”。

随着中国开源 AI 模型DeepSeek风靡全球,尽管黄仁勋坦言当前AI模型所需的算力是此前模型的100倍,带动算力需求增加的关键是AI推理,但资本市场质疑 AI 算力需求减弱,英伟达年内股价已下跌超10%。

随着下一代Rubin Ultra架构最强 AI 芯片揭开面纱,虽然当日英伟达股价没能重回巅峰,18日收盘时下跌3.43%,但CNBC表示,黄仁勋已经推动英伟达开始从数据中心转型,预测未来几年,就AI革命而言,英伟达仍然发挥着真正的作用,而不是躺在“功劳簿”上。

“我们现在必须以10倍的速度计算,我们要做的计算量要是当前的十倍、一百倍。”黄仁勋称,10年间,AI从感知和计算机视觉发展到生成式AI,现在又发展到具有推理能力的Agentic AI。如今,AI理解上下文,理解我们在问什么,现在它生成的答案,从根本上改变了计算的方式,而大规模推理是一种极限计算。

黄仁勋强调,下一波 AI 浪潮已经到来:机器人技术。

四大业务重新组合,个人超算每秒运算1000万亿次

英伟达主要有四个营收来源:数据中心、游戏、专业可视化、汽车,后两者目前占比较小,营收贡献主要依赖于数据中心业务和游戏业务。

因此,GTC大会上,黄仁勋演讲也是围绕五个板块顺序介绍——RTX消费级显卡、汽车、GB系列数据中心AI芯片、CUDA和可视化等软件、以及最后的机器人技术。

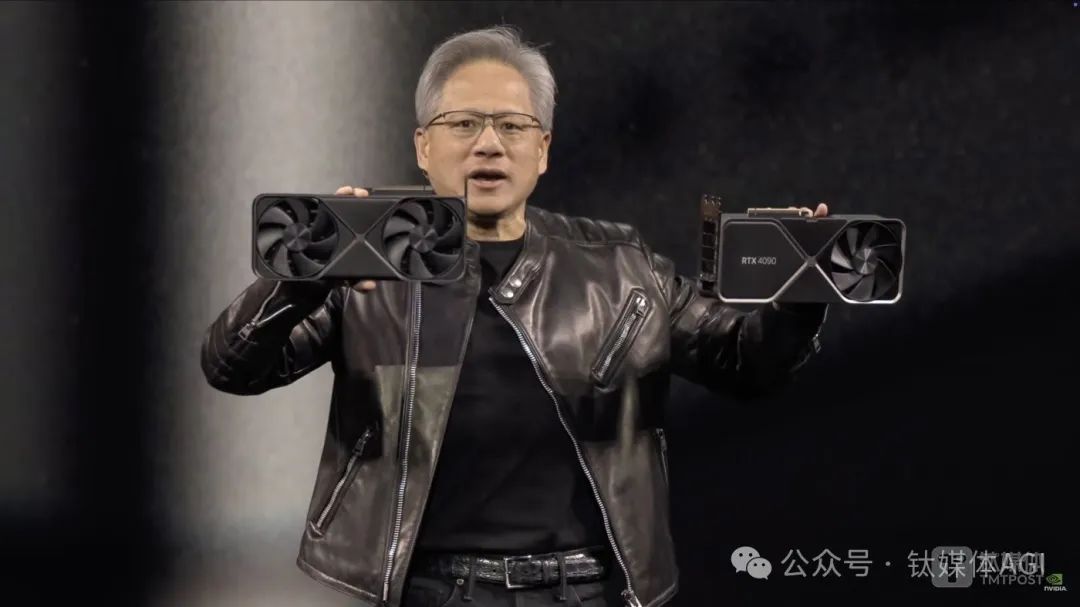

首先是消费级显卡,黄仁勋表示,基于BlackWell架构的RTX5090已经快卖没了,与4090比较,体积小了30%,消耗能量方面提高了30%,性能令人难以置信,是因为 AI 取得了非凡的进步,给世界计算机图形带来了革命性的变化。因此,英伟达推出新一代工作站和服务器GPUNVIDIA RTX PRO Blackwell系列,专为复杂的AI驱动工作负载、技术计算和高性能图形而打造,而ChatRTX 更新现已支持 NVIDIA NIM,RTX Remix推出测试版。英伟达强调,NVIDIA RTX PRO 6000 Blackwell 是医疗保健、制造业、零售业、直播和其他行业中 AI 和视觉计算工作负载的终极通用 GPU。

同时,今年1月,CES上黄仁勋发布全球最小的个人AI超级计算机Project Digits,如今则被命名为DGX Spark,大小和Mac Mini4相当,它内置英伟达GB10芯片,能够提供每秒1000万亿次的AI运算,用于微调和推理最新AI模型,采用NVLink-C2C互连技术,内存带宽是第五代PCIe的5倍。该产品售价3000美元(约合人民币21685元)。

值得注意的是,英伟达还公布了下一代个人超级电脑DGX Station,称是人工智能和数据科学的终极工作站,拥有GB300 Superchip 784GB统一系统内存,高达20000 AI TFLOPS计算能力。

其次是汽车,英伟达推出 NVIDIA Halos,这是一款适用于自动驾驶汽车的全栈综合安全系统,将英伟达的汽车硬件和软件安全解决方案系列与其在自动驾驶安全领域的尖端 AI 研究结合在一起,加速自动驾驶汽车的发展。至此,英伟达将其开发技术套件从云端到汽车统一起来,涵盖车辆架构到 AI 模型,包括芯片、软件、工具和服务。此外,英伟达还宣布,通用汽车与NVIDIA合作开发 AI,助力下一代汽车体验和制造。

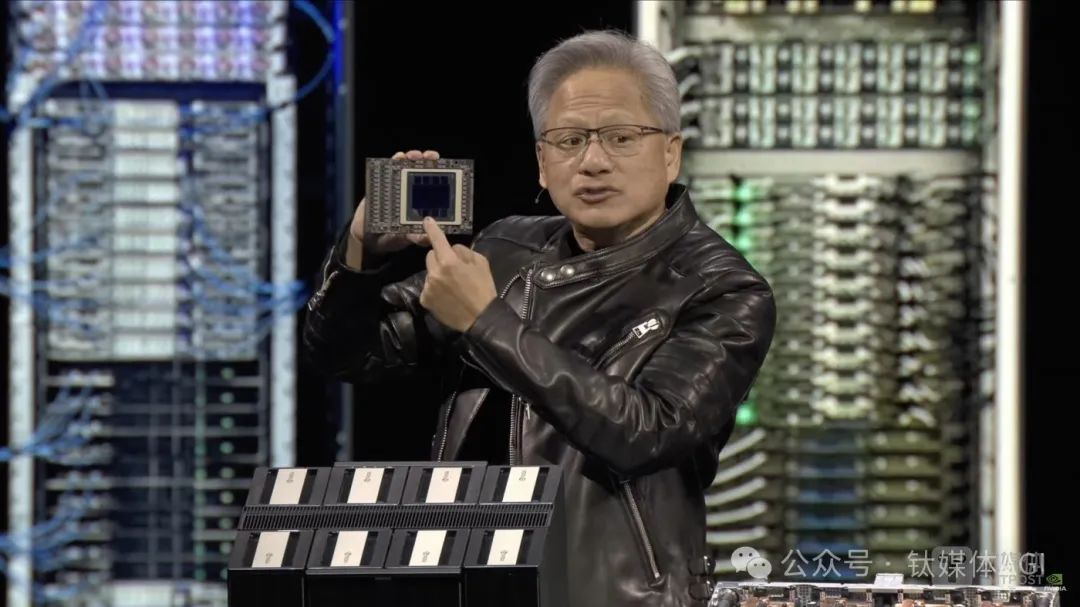

再次是GTC大会重头戏数据中心AI芯片,英伟达发布了一系列计算、通讯和高带宽产品和信息。

黄仁勋表示,在使用现成的电脑后,超大规模数据中心能够解决巨大规模的问题。然而,我们试图解决的问题是如此复杂。而英伟达的目标是“扩大规模”,我们本质上想要建造 AI 超级芯片,只是没有激进的技术可以做到这一点,没有工艺技术可以做到这一点。他直言,在计算机科学和工厂中,延迟、响应、时间和吞吐量之间存在根本的紧张关系,因此,世界需要一个伟大的超级电脑。

会上,英伟达发布了支持 AI 推理的NVIDIA Blackwell Ultra、NVIDIA横向扩展基础设施(通讯、网络),以及英伟达软件创新等。

其中,NVIDIA GB300 NVL72采用机架级设计,连接72个 Blackwell Ultra GPU和36个基于 Arm Neoverse 的NVIDIA Grace CPU,充当专为测试时间扩展而构建的单个大型 GPU。借助其设施,AI 模型可以访问平台增强的计算能力,探索问题的不同解决方案,并将复杂请求分解为多个步骤,从而获得更高质量的响应。此外,Blackwell Ultra 平台还适用于:Agentic AI,使用复杂的推理和迭代规划来自主解决复杂的多步骤问题,可以推理、规划并采取行动来实现特定目标;Physical AI,使公司能够实时生成合成的、逼真的视频,以大规模训练机器人和自动驾驶汽车等应用。

网络和通讯层面,英伟达首次推出 Spectrum-X Photonics,同封装光学网络交换机,将 AI 工厂扩展至数百万个 GPU,每端口 1.6 兆兆位/秒交换机,英伟达称其光子交换机是世界上最先进的网络解决方案。与传统方法相比,它们将光学创新与 4 倍更少的激光器相结合,从而实现 3.5 倍的能效、63 倍的信号完整性、10 倍的大规模网络弹性和 1.3 倍的部署速度。

同时,英伟达称,借助 GB200 和 GH200 架构的 NVLink-CNC 互连(可提供 CPU 和 GPU 内存一致性),可以在单个 GPU 上扩展内存和应用,使用 NVIDIA Warp(一种基于 Python 的加速数据生成和空间计算应用框架),Autodesk 使用八个 GH200 节点执行了多达 480 亿个单元的模拟,这比使用八个H100节点进行的模拟大5倍以上。

此外,英伟达宣布,Blackwell Ultra与NVIDIA Spectrum-X 以太网和NVIDIA Quantum-X800 InfiniBand平台无缝集成,通过ConnectX-8 SuperNIC 为系统中的每个 GPU 提供 800 Gb/s 的数据吞吐量。而DPU方面,拥有英伟达BlueField-3 DPU的Blackwell Ultra 系统,可支持多租户网络、GPU 计算弹性、加速数据访问和实时网络安全威胁检测。

英伟达强调,先进的横向扩展网络是 AI 基础设施的关键组成部分,可提供最佳性能,同时减少延迟和抖动。

软件创新上,整个Blackwell产品组合均由全栈英伟达AI平台支持。其中,今天推出的NVIDIA Dynamo开源推理框架,扩展了推理 AI 服务,实现了吞吐量的飞跃,同时缩短了响应时间和模型服务成本;同时,NVIDIA Dynamo 是一款新型 AI 推理服务软件,旨在为部署推理 AI 模型的 AI 工厂最大限度地提高token收入,确保最大程度地利用 GPU 资源。此外,NVIDIA AI Enterprise包括NVIDIA NIM 微服务,以及企业可以在 NVIDIA 加速云、数据中心和工作站上部署的 AI 框架、库和工具。

英伟达强调,Blackwell平台建立在英伟达强大的开发工具生态系统、NVIDIA CUDA-X库、超过600万开发人员和4000多个应用之上,可在数千个GPU上扩展性能。

事实上,英伟达全场都在谈及软件对GPU和 AI 计算的影响。比如,利用NVIDIA cuDSS 加速工程求解器,用于解决涉及稀疏矩阵的大型工程模拟问题,适用于设计优化、电磁模拟工作流程等应用,利用 Grace CPU 内存和超级芯片架构,使用相同的 GPU 和 cuDSS 混合内存,可将最繁重的解决方案步骤加速高达4倍,从而进一步提高效率。

模型层面,英伟达宣布,经过英伟达后期训练,全新开源Llama Nemotron 推理模型为 Agentic AI 提供业务基础,使模型的准确率较基础模型提升高达 20%,推理速度较其他领先的开放推理模型提升5倍,埃森哲、德勤、微软、SAP和ServiceNow 与英伟达合作开发推理 AI 代理,以改变工作方式。此外,英伟达还宣布与Alphabet和 Google就Agentic和Physical AI的未来展开合作。

黄仁勋宣布,英伟达发布全球首个开放式人形机器人基础模型 Isaac GR00T N1,以及加速机器人开发的仿真框架。

GR00T N1基础模型采用双系统架构,灵感来自人类认知原理,“系统 1”是一种快速思考的行动模型,反映了人类的反应或直觉。“系统 2”是一种慢速思考的模型,用于深思熟虑、有条不紊的决策。而在视觉语言模型的支持下,系统 2 可以推理其环境和收到的指令,从而规划行动。然后,系统 1 将这些计划转化为精确、连续的机器人动作,并接受人类演示数据和NVIDIA Omniverse平台生成的大量合成数据的训练,因此,GR00T N1 可以轻松实现常见任务,例如抓取、用一只或两只手臂移动物体以及将物品从一只手臂转移到另一只手臂,或者执行需要长时间上下文和一般技能组合的多步骤任务。这些功能可应用于物料搬运、包装和检查等用例。

目前,GR00T N1已经上市,是英伟达将预先训练并发布给全球机器人开发人员的一系列完全可定制模型中的第一个,加速了全球劳动力短缺(估计超过 5000 万人)所带来的行业转型。此外,英伟达对NVIDIA GR00T N1 训练数据和任务评估场景已经开源。而用于合成操作运动生成的 NVIDIA Isaac GR00T 蓝图现在也可以下载,而英伟达DGX Spark个人 AI 超级计算机为开发人员提供了一个相关系统,无须大量定制编程即可扩展 GR00T N1 的功能,以适应新的机器人、任务和环境。

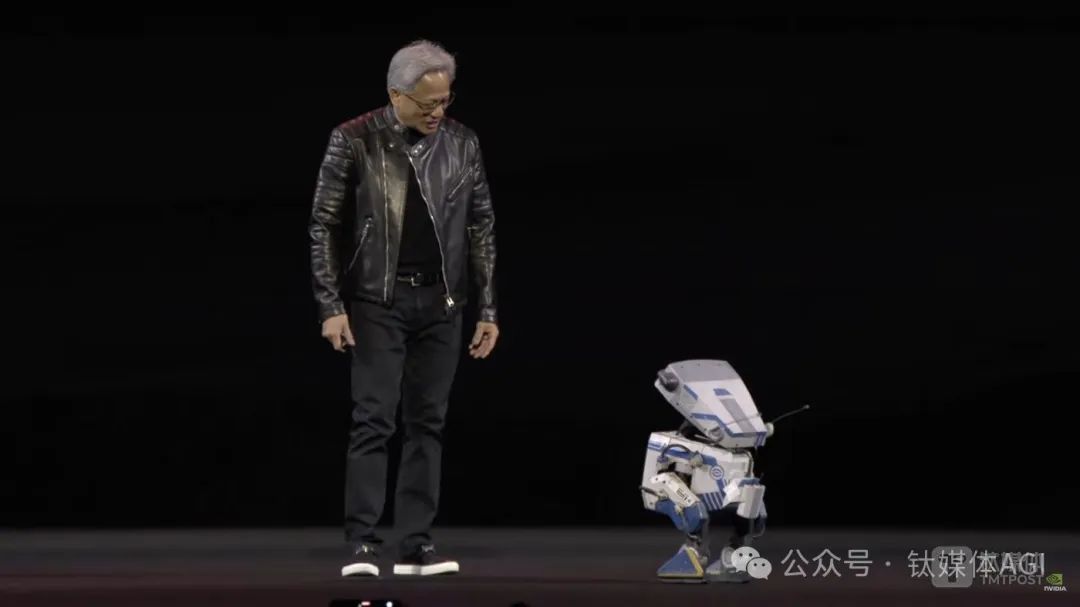

最后的最后,老黄在谢幕之前还成功“召唤”出了配有GR00T N1模型的机器人——Blue(星球大战机器人)。

黄仁勋表示,“通用机器人时代已经到来。借助 NVIDIA Isaac GR00T N1 以及新的数据生成和机器人学习框架,世界各地的机器人开发人员将开拓 AI 时代的下一个前沿。”

此外,英伟达还宣布与 Google DeepMind 和迪士尼研究中心合作开发 Newton,这是一个开源物理引擎,可让机器人学习如何更精确地处理复杂任务。

总结这场演讲,黄仁勋提及最多的几个关键词:tokens、推理和Agentic AI。

在他看来,未来 AI 需要更多的tokens和推理能力,算力需求也会攀升,进一步加速Agentic AI和Physical AI发展,使得 AI 从虚拟世界转向物理世界。

黄仁勋表示,BlackWell正在全力生产,客户需求令人难以置信,因为 AI 出现一个拐点,作为推理的结果,AI 计算量要大得多,AI 和推理训练,AI系统和代理AI系统;第二,Blackwell、Vera Rubin与Dynamo性能不断提升,用于计算和推理的 AI 工厂将成为未来十年最重要的工作负载之一。

市场对英伟达GPU供不应求,但算力“霸主”难持续

尽管ChatGPT热潮至今已有两年多,但全球对于 AI 算力需求依旧不减。

据统计,2024年,微软、谷歌、亚马逊和Meta四家大型云服务商合计资本支出高达2283亿美元,比2023年的1474亿美元增长55%。预计2025年,四家大型云服务商资本支出总额将超过3200亿美元,增长超40%。

黄仁勋透露,四大云厂商今年已采购360万个Blackwell芯片,预计2028年数据中心资本支出规模突破1万亿美元。

“回看历史,半导体大爆发,第一个是PC,第二个爆发是手机,第三个大爆发是AI,未来半导体最少还有10-15年来消化 AI 需求。”群联电子董事长潘健成对钛媒体AGI表示。

2025年,DeepSeek重新燃起 AI 大模型产业发展新热潮。

Omdia最新报告显示,2023年,全球生成式 AI 市场规模占总 AI 市场的9%,达68亿美元;2024年,生成式AI市场预计增长一倍以上,达到146亿美元;预计到2029年,生成式 AI 市场规模占比达三分之一,约合73亿美元,五年复合增长率达38%,市场前景广阔。

然而,DeepSeek在架构和算法上实现了训练推理效率提升,同时模型训练成本也大幅下降至560万美元。因此,行业普遍认为,AI推理会让英伟达GPU需求降低。今年1月,DeepSeek热潮使得投资人抛售英伟达股票,导致其市值蒸发6000亿美元。黄仁勋本人的净资产在这场暴跌中也一度缩水近20%,如今稍有回落。

潘健成对钛媒体AGI表示,云端的训练GPU可能已经达到顶峰,但推理 AI 还没开始。意味着,市场需求已经进入GPU发展瓶颈期,英伟达算力“霸主”难以持续。

2月27日英伟达发布的四季度财报显示,英伟达Q4营收393.31亿美元,同比增长78%;调整后毛利率为73.5%,同比下降3.2个百分点;公认会计准则下,季度净利润220.91亿美元,同比增长80%,环比增长14%,非GAAP下调整后同比增长72%,均低于分析师预期。

整个2025财年,英伟达营收首次突破1000亿美元,达1305亿美元,较上年同期增长114%;非公认会计准则下,净利润达742.65亿美元,较上年同期增长130%;毛利率75.5%,同比上涨1.7个百分点,调整后EPS2.99美元。

其中,去年全年,英伟达中国区营收171.08亿美元,为史上最高,比前一年103.06亿美元增长66%。英伟达现在的营收中,大约有53%是在美国之外。

黄仁勋表示,AI 芯片Blackwell的需求惊人,目前公司已成功实现 Blackwell AI 超级计算机的大规模生产,第一季度的销售额就达到数十亿美元。预计Blackwell Ultra将于2025年下半年发布,一旦Blackwell完成增产,利润将改善,重申利润率到2025年年底为“70%-80%区间中部”。

黄仁勋今天提供了数据中心和英伟达 AI 芯片的份额。Dell Oro预测,到2028年,全球数据中心资本支出高达1万亿美元以上,而英伟达数据中心收入将在其中发挥关键作用。

很显然,黄仁勋非常有信心在数据中心方面取得更大进展。

“推理带来的潜在需求让人感到兴奋。这将要求比大语言模型更多的计算。这可能会要求比当前多出(至少)数百万倍的计算。”黄仁勋强调,AI 行业正以光速发展。下一波浪潮即将到来,企业的agentic AI,机器人的Physical AI),以及不同地区为自己的生态系统构建主权 AI,每一个都刚刚离开地面。“很明显,我们处于这一发展的中心。”

长期来看,英伟达希望构建一座基于计算基础设施的 AI 工厂。

与传统数据中心不同,AI 工厂不仅存储和处理数据,它们以规模制造智能,将原始数据转化为实时洞察。对于全球的企业和国家来说,这意味着价值实现时间将大大缩短,将 AI 从长期投资转变为立即推动竞争优势的动力,今天投资于专门设计的 AI 工厂的公司将在明天的创新、效率和市场竞争中领先。

黄仁勋称,智能不是副产品,而是核心。这种智能通过 AI Token吞吐量来衡量——即驱动决策、自动化以及全新服务的实时预测。AI 工厂则优化于从 AI 中创造价值,它们协调整个 AI 生命周期,包括从数据摄取到训练、微调和最关键的高量推理。

当然,黄仁勋的目的很简单:多买英伟达GPU,尽管性能很难快速提升但可以多买芯片实现庞大计算规模,AI 需要的大量算力都可以在英伟达平台计算,计算、通信、模型、工具、软件平台通通都有,英伟达能得到收入,各国能得到 AI 最强国地位。

此外,黄仁勋再次更新了“黄氏定律”,他认为,推理已成为 AI 经济的主要驱动力,因此Scaling Law有三个层面:

-

预训练扩展:更大的数据集和模型参数可带来可预测的智能增益,但要达到这一阶段需要对熟练的专家、数据管理和计算资源进行大量投资。在过去五年中,预训练扩展使计算需求增加了 5000 万倍。但是,一旦模型经过训练,其他人在其基础上进行构建的门槛就会大大降低。

-

训练后扩展:针对特定实际应用对 AI 模型进行微调,在 AI 推理过程中所需的计算量是预训练的30 倍。随着组织根据其独特需求调整现有模型,对 AI 基础设施的累计需求猛增。

-

测试时间扩展(又称长期思考):代理 AI或物理 AI等高级 AI 应用需要迭代推理,其中模型会探索多种可能的响应,然后再选择最佳响应。这比传统推理消耗的计算量最多高出 100 倍。

所以,黄仁勋如此努力,连前英特尔CEO基辛格(Pat Gelsinger)都来现场夸奖老黄,成为黄仁勋最新拥趸者。

基辛格表示,英伟达团队对 AI 做出了巨大贡献。据悉,如今“退休”的基辛格,创立了教会通讯平台Gloo,他担任董事长,并将大模型作为其聊天机器人的基石,当然,他们也买了英伟达的算力。

基辛格还谈到量子计算,认为其发展对于通用 AI 至关重要。基辛格称,不太同意老黄的一点是,他认为量子计算将在这个十年结束之前以可实现的形式出现,即未来5年内人类将在生产中使用可实现的量子计算机。

“绝对的,未来数据中心有部分工作负载、数据处理等,会有训练工作量,因此,我们会有量子计算处理器,如果你想想量子,人类的大部分,人类最有趣的事情就是量子效应。有一个计算模型来研究这些事情是非常合适的。就像GPU看起来更像是大脑,用于训练、人类和语言以及所有这些东西,所以我坚信这就是未来的数据中心。”基辛格表示。

因此,今年GTC大会,除了黄仁勋的主题演讲,还有一件事最值得期待:首次设立“量子日”活动。

届时,黄仁勋将与D-Wave Quantum和Rigetti Computing等十余家量子计算行业领军企业的高管同台,讨论量子计算的技术现状、潜力以及未来发展方向。

今天,英伟达已经宣布在波士顿建立一个量子研究中心 (NVAQC) ,以提供推动量子计算发展的尖端技术,把领先的量子硬件与 AI 超级计算机集成在一起,实现所谓的加速量子超级计算,帮助解决量子计算最具挑战性的问题,从量子比特噪声到将实验性量子处理器转变为实用设备。

该研究院包括Quantinuum、Quantum Machines 和QuEra Computing,以及哈佛大学科学与工程量子计划 (HQI) 和麻省理工学院 (MIT) 的工程量子系统 (EQuS) 小组等。

“NVAQC 是一个强大的工具,将有助于引领整个量子生态系统的下一代研究,”麻省理工学院电子工程与计算机科学教授、物理学教授、EQuS 小组负责人兼量子工程中心主任 William Oliver 表示。“NVIDIA 是实现实用量子计算的重要合作伙伴。”

黄仁勋则强调,量子计算将增强 AI 超级计算机的能力,以解决从药物发现到材料开发等世界上一些最重要的问题。英伟达加速量子研究中心将与更广泛的量子研究界合作,推动 CUDA-量子混合计算的发展,并取得突破,打造出大规模、实用、加速的量子超级计算机。

很显然,下一个 AI 计算未来,黄仁勋也想全面布局,推动英伟达成为 AI 算力领域的持续性“霸主”。

(文:钛媒体AGI)