DeepSeek R2细节流出,参数直接飙到1.2万亿,还把成本砍到了骨折价!

刚刚,一份来自韭研公社的爆料刷屏了整个AI圈——

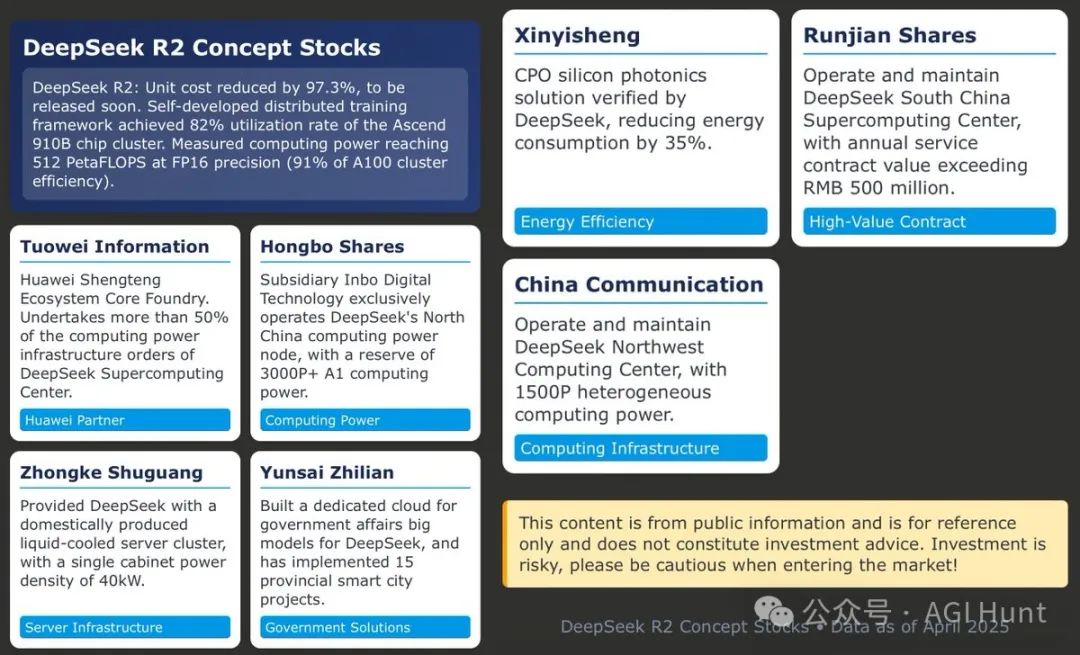

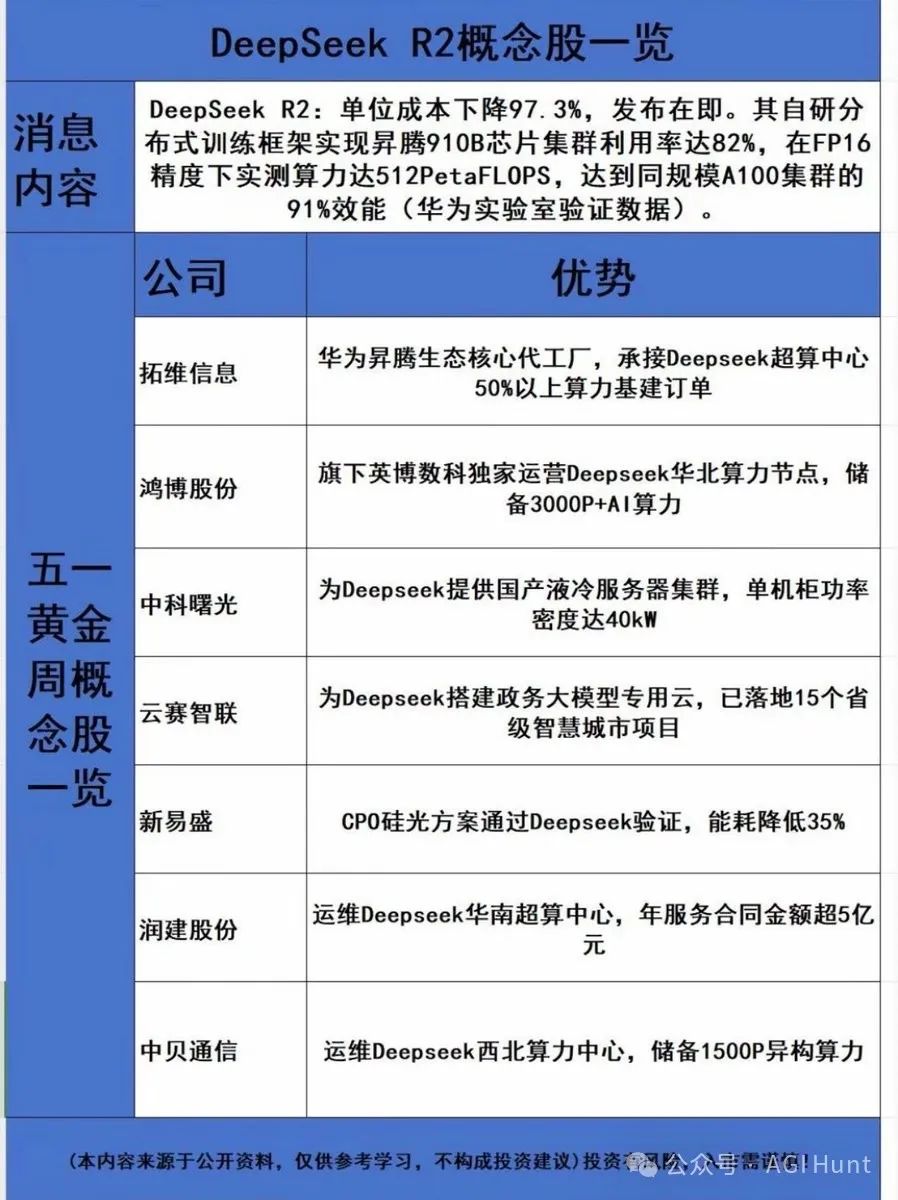

DeepSeek R2被曝即将发布,参数规模达到惊人的1.2万亿,并首次采用Hybrid MoE 3.0架构,实现了动态激活780亿参数。

而成本呢?

相比GPT-4 Turbo暴降97.3%,这几乎是AI模型的白菜价了。

Aliyun的实际测试数据指出,DeepSeek R2在长文本推理任务中,每单位token的成本大幅下降,真是AI界的降维打击。

Aryan Pandey(@AryanPa66861306) 对此性能表现表示了极度的兴奋:

DeepSeek R2将单位成本削减97.3%,即将发布。自主研发的分布式训练框架,把华为Ascend 910B芯片集群利用率推到了82%,FP16精度算力实测达到512PetaFLOPS,接近同规模A100集群91%的性能(华为实验室数据)。

不仅参数猛增,DeepSeek R2这次的多模态能力更是惊人:

视觉理解模块采用ViT-Transformer混合架构,在COCO数据集物体分割任务中精准度达到92.4% mAP,超过CLIP模型整整11.6个百分点。

此外,工业质检场景方面也表现抢眼。

它采用自适应特征融合算法,在光伏EL缺陷检测中的误检率降到了极低的7.2E-6,甚至医疗诊断能力也已超过人类专家,胸部X光片多病种识别准确率高达98.1%,完胜协和医院专家组的96.3%。

最不可思议的是,DeepSeek R2在8bit量化压缩模式下,还能将模型体积压缩83%,精度损失小于2%,这为终端部署打开了大门。

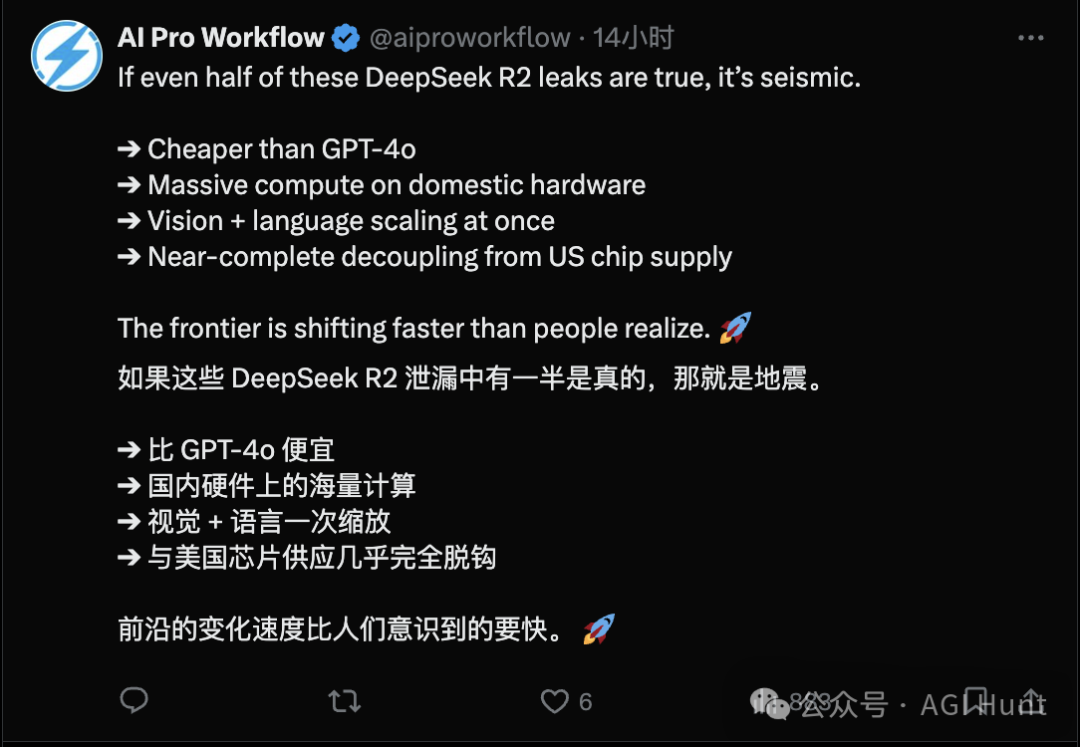

这些亮眼的数据让推特炸开了锅,纷纷称为疯狂、大东西、太猛了!

不过,自称最权威的DeepSeek粉丝 Teortaxes▶️ (DeepSeek 推特🐋铁粉 2023 – ∞)(@teortaxesTex) 却给狂热的气氛泼了点冷水:

我已经说过,除了确认这些公司存在并可能与DeepSeek有合作外,其它爆料我并不相信。

而最初分享这一消息的 Deedy(@deedydas) 也承认了这点:

这些只是传言,图片内容实际上是用Claude翻译自泄露文件。

但即使传言属实度待确认,这也阻止不了网友们开始疯狂想象。

Jeff Brines(@JeffBrines) 就对美国企业表示担忧:

如果是真的,这会不会对Nvidia造成巨大冲击?

Alice Le Portier(@SeekingAlphaQ) 更加直白:

如果中国的半导体供应链变得有竞争力,美国的半导体公司可能会稀释,严重限制美企从AI大潮中获得的垄断收益。

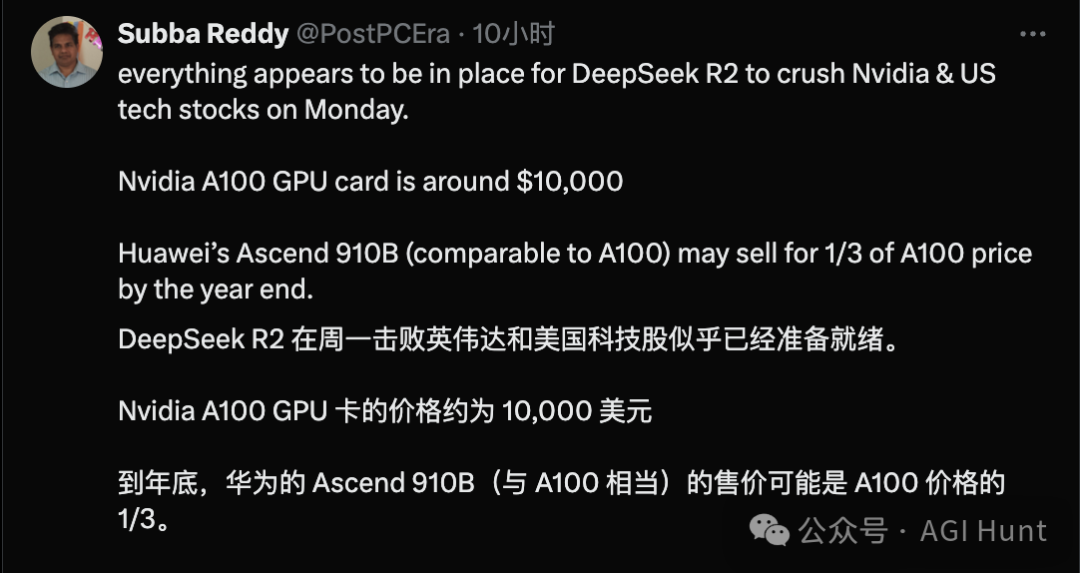

甚至有网友 Subba Reddy(@PostPCEra) 直接断言:

如果是真的,Nvidia和美股周一可能遭遇一波暴击。毕竟A100的GPU卡售价大约1万美元,而华为的Ascend 910B年底可能只要A100三分之一的价格。

当然,也有网友直接将DeepSeek R2定义为「AI冷战」的新武器。

LIGHT ⇌ SIGNAL//FORM(@AITrailblazerQ) 评论得十分激烈:

DeepSeek R2不仅是便宜的模型,更是一场主权压缩战,背后有官方的支持,其目的是瓦解美国AI优势。

Haha Packet(@haha_packet) 也是秀起了语言的艺术进行嘲讽:

对啊,开源模型都很邪恶。快来保护那些闭源的亿万富豪吧!

而AI圈著名乐观派 çelebi(@celebi_int) 的观点很简单:

如果是真的,这才是正确的世界线!

虽然众说纷纭,但DeepSeek R2如果真的能在技术和成本上达成这些突破,这无疑会是AI行业的一次重大洗牌。

或许,AI大战的序幕正悄然拉开。

这个五一,或将不同寻常!

(本文不构成投资建议,信息仅为传言,请谨慎吃瓜。)

(文:AGI Hunt)