DeepSeek 又一次在假期前搞事情了。明天就是五一假期,今天突然发布新模型,直接把热度拉满(不确定五一期间会不会有其他大模型发布,例如 R2?)。

DeepSeek 这次发布的是 DeepSeek-Prover-V2-671B。

新模型发布

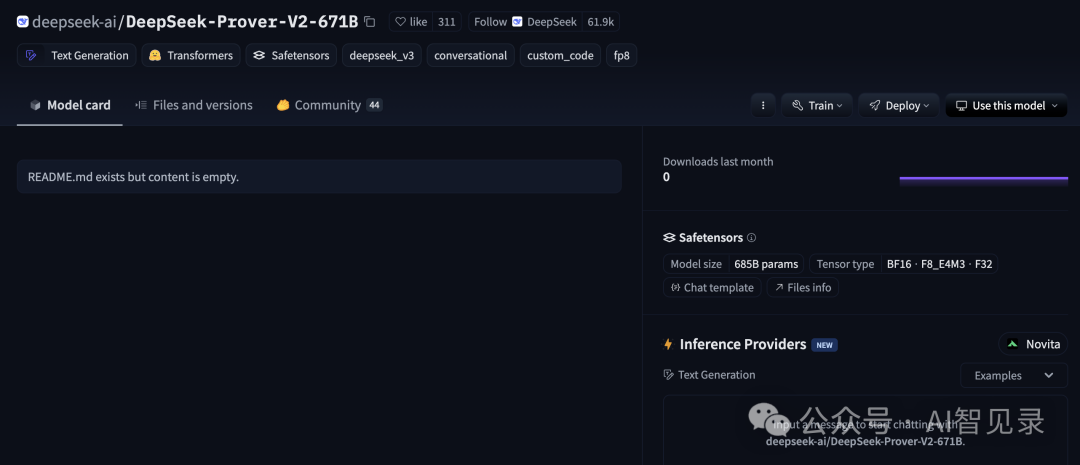

DeepSeek 官方在 Hugging Face 上突然上线了 DeepSeek-Prover-V2-671B。这个模型一上线就引发了关注,短时间内获得了大量点赞。大家都在讨论它的参数和潜力。

模型参数

DeepSeek-Prover-V2-671B 的参数量是 671B。这个数字很大。上一代 DeepSeek-Prover-V1.5 只有 7B。新模型的规模提升很明显。

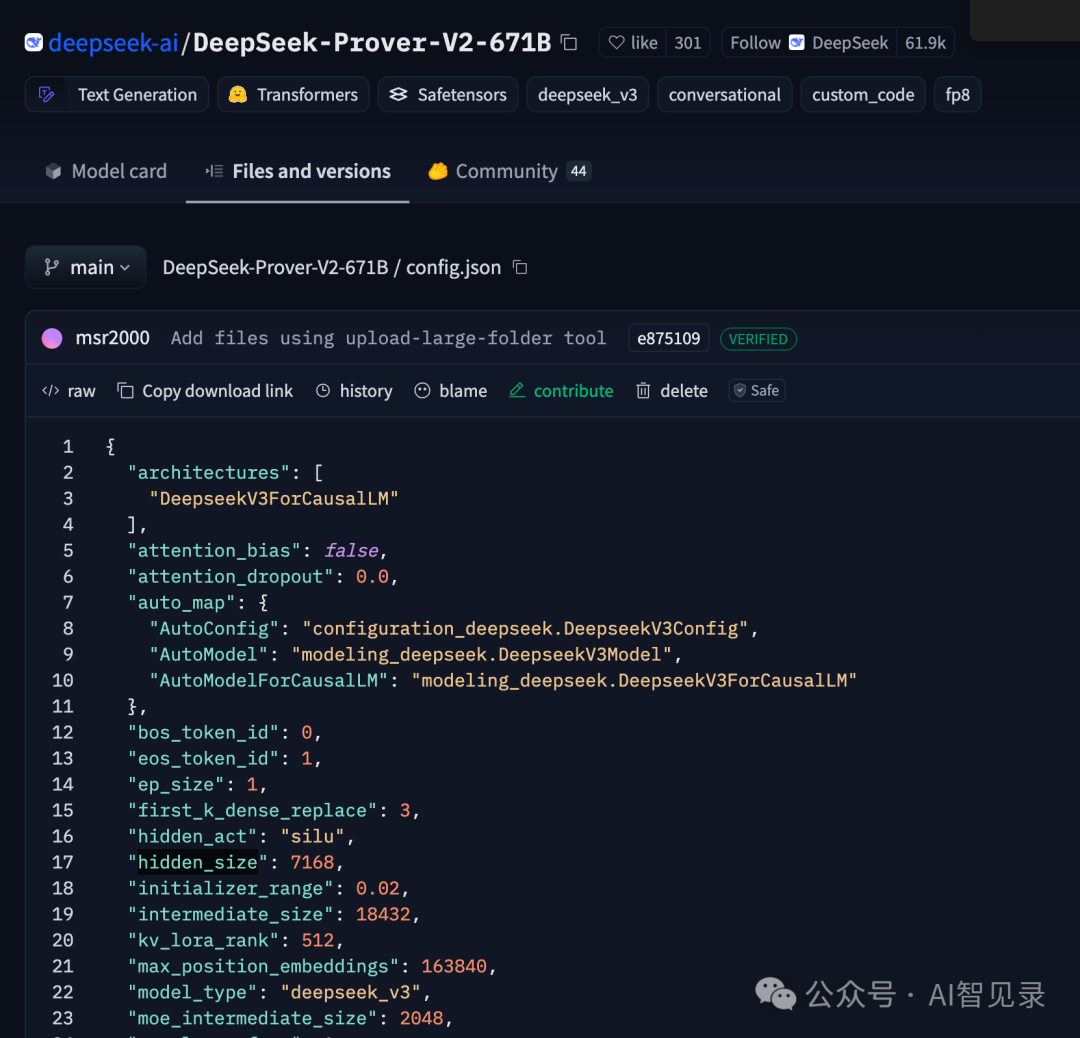

模型采用 Deepseek-V3 架构。很多配置和 DeepSeek-V3 一致。比如 MoE(Mixture of Experts)结构。每一层都是 MoE 层。每层包含 1 个共享专家和 256 个路由专家。每个 token 会激活 8 个专家。中间层大小为 2048。最大可处理 163,840 长度的上下文。

模型的 attention 头数为 128,隐藏层大小为 7168,隐藏层总数为 61。激活函数用的是 silu。词表大小为 129,280。

量化方式采用 fp8,权重块大小为 128×128。支持 bfloat16。

Prover 系列介绍

Prover 系列是 DeepSeek 专门为数学问题和定理证明设计的。上一代 V1.5 在 Lean4 定理证明上表现不错。这次直接升级到 671B,性能值得期待。

官方信息

目前 DeepSeek 还没有发布官方技术报告。模型已经可以在 Hugging Face 上找到。大家可以关注后续官方消息。

总结

DeepSeek-Prover-V2-671B 的发布让大家看到了大模型在数学推理领域的进步。参数量大,架构新,应用场景广。后续表现如何,值得持续关注。

模型地址:https://huggingface.co/deepseek-ai/DeepSeek-Prover-V2-671B/tree/main

欢迎留言讨论你的看法。

(文:AI智见录)