引言

近年来,基于规则的强化学习(RFT)在多模态大语言模型(MLLMs)中的应用取得了显著进展,并且在一些模型上取得了优于监督微调(SFT)的成果。

RFT 利用可验证的奖励进行训练,鼓励模型在回答之前先进行思考。显式思考被认为是 RFT 成功的关键因素,许多关于多模态 RFT 的研究也致力于复现 “aha moment” 的效果。

然而,对于一些简单的视觉任务,例如空间理解,可能并不需要复杂的推理。最近的研究表明,过度思考反而可能对某些任务的推理性能产生不利影响。

此外,相比于 SFT,RFT 通常需要更多的微调时间,因为它涉及生成多个较长的响应。因此,显式思考过程的作用值得进一步探讨,特别是从准确性和训练效率的角度考虑。

在此背景下,来自上海 AI Lab 的研究团队针对多模态大语言模型中的思考过程进行了深入研究。该团队首先探讨了使用 MLLMs 进行闭式分类任务的挑战。由于预训练数据的限制,当前的 MLLMs 在分类能力上表现较差。

论文标题:

Think or Not Think: A Study of Explicit Thinking in Rule-Based Visual Reinforcement Fine-Tuning

论文链接:

https://arxiv.org/abs/2503.16188

代码链接:

https://github.com/minglllli/CLS-RL/tree/main

尽管 SFT 在将 MLLMs 与最先进的分类模型对齐方面已取得显著成效,但大规模标签数据集的获取仍然带来了巨大的成本和计算开销。因此,少样本微调成为了一个有前景的替代方法,尤其是在对比视觉-语言模型中的应用,但在自回归的 MLLMs 中的应用仍未得到充分探索,需要更深入的研究。

受到基于规则的 RFT 最新成功的启发,该团队提出了 CLS-RL,这是一个用于分类微调的强化学习框架。与 SFT 通过令牌级损失来指导微调过程不同,CLS-RL 使用可验证的奖励损失来微调 MLLMs,并引导模型探索多样化的推理思维。

实验结果显示,CLS-RL 在 11 个数据集的少样本和基础到新类设置中,表现优于 SFT,在领域内学习和新类泛化方面均取得了更好的结果。

此外,研究团队还发现了 CLS-RL 微调中的一个“免费午餐”现象。在少样本对比 VLM 微调中,已有研究表明,当 VLM 在特定数据集上进行微调时,它在其他数据集上的性能会急剧下降,这种现象被称为灾难性遗忘。

然而,当使用 CLS-RL 在一个特定数据集上进行微调时,模型在其他数据集上的表现也得到了提升,这一现象被称为“免费午餐”现象。研究表明,基于规则的 RFT 不仅能够缓解少样本微调中的灾难性遗忘问题,还能有效地教会模型图像分类的基础知识。

接下来,研究团队重新审视并探讨了思考过程在规则基础 RFT 中的作用。与 Deepseek-R1 中的数学问题逐渐增加响应长度不同,CLS-RL 中的响应长度在某些步骤急剧下降,而准确度奖励则显著上升。

这表明,分类任务中的思考过程可能没有数学问题中那么关键,因此模型逐渐倾向于采用最简单的思考方式来得出最终答案。此外,过度思考对某些任务的负面影响也得到了进一步验证。

在此基础上,研究团队提出了一种新的方法——No-Thinking-RL,旨在抑制思考过程。在 No-Thinking-RL 中,模型被直接要求回答问题,奖励机制也做出了相应调整,只有当模型的输出与标签完全一致时,才会给予奖励。

令人惊讶的是,No-Thinking-RL 在许多任务中表现优于 CLS-RL,且训练时间显著减少。

研究团队推测,No-Thinking-RL 优于 CLS-RL 的原因在于,显式思考反而可能在可验证答案之前抑制了学习。因此,他们进一步提出了“思考后答”方法(Think-After-Answer),即将思考放在答案之后,以减轻这种负面影响。后续实验将进一步验证这一假设。

最后,研究团队在包括数学、空间推理和难题等多种任务上评估了 No-Thinking-RL,涵盖了 2B 和 7B 模型大小。

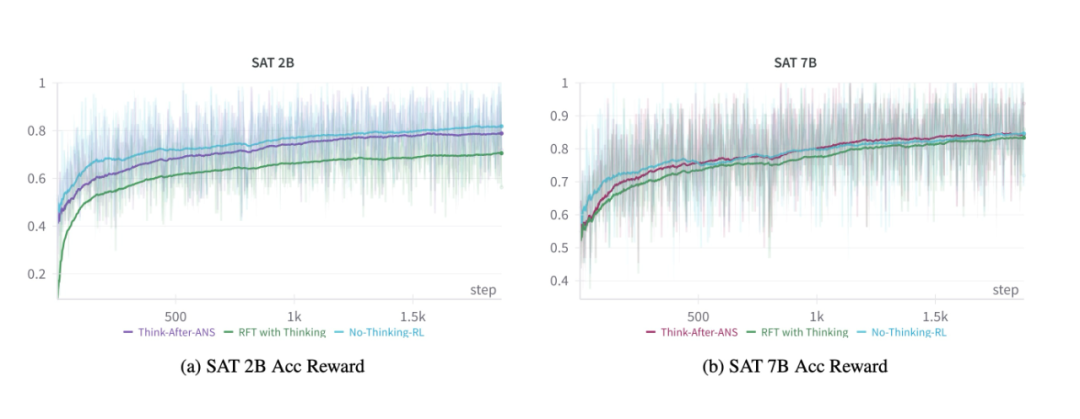

结果表明,对于 2B 模型,No-Thinking-RL 在所有任务上均优于带思考的 RFT,尤其是在数学任务中。而在 7B 模型上,三种方法在空间理解任务上的表现相似,但在数学问题上,带思考的RFT明显优于 No-Thinking-RL。

这些结果表明,小模型(如 2B)在微调过程中无法生成高质量的思考,且低质量的思考可能会降低性能;而对于简单的视觉任务,思考并非关键,No-Thinking-RL 在小模型上的表现优于带思考的 RFT,并且在 7B 模型上表现相似。

方法

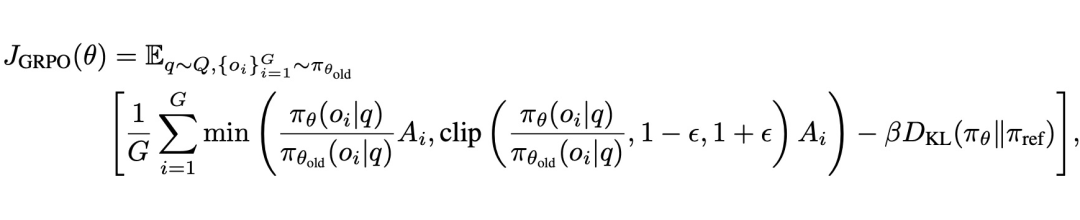

为了优化模型,采用了 Group Relative Policy Optimization(GRPO)作为强化学习(RL)算法。与通过令牌级损失优化模型的 SFT 方法不同,像 GRPO 这样的 RL 方法利用来自奖励损失的策略梯度进行优化,促使模型在更广阔的解空间中进行推理探索。

在该方法中,使用了一组响应来估算相对优势,并通过正则化控制模型的偏离程度。这种方法通过采样响应并对其奖励进行标准化,计算相对优势,避免了 PPO 中的评论模型,计算效率更高。

2.1 CLS-RL

CLS-RL 方法引入了指令提示和奖励函数。指令提示鼓励模型在给出答案前进行思考,并输出思考过程和最终答案。奖励函数由格式奖励和准确性奖励组成,格式奖励鼓励模型正确地展示思考过程,而准确性奖励则基于规则,检查模型输出是否与真实标签匹配。

2.2 No-Thinking-RL

与 CLS-RL 不同,No-Thinking-RL方法鼓励模型直接输出答案,避免思考过程。奖励函数仅关注准确性,模型的输出必须与真实标签精确匹配。这种方法显著减少了训练和推理时间,适用于不需要复杂推理的简单视觉任务。

分类实验部分

在这部分,作者展示了其分类实验的结果,重点评估了少样本学习能力和“自由午餐”现象,并分析了从基础任务到新任务的迁移性能及开集分类的表现。

3.1 实验设置

实验目标:本实验的主要目标是通过封闭表单的方式进行分类,即给定一部分类别标签,模型需从中选择正确的类别。实验中的问题格式为“这张照片里是什么物体?{指令提示}”,其中指令提示会根据不同的方法进行调整。

数据集:为了全面评估三种方法(SFT、CLS-RL 和 No-Thinking-RL),作者选取了 11 个公共的分类基准数据集,包括 ImageNet、Caltech101、OxfordPets、StanfordCars、Flowers102、Food101、FGVCAircraft、SUN397、DTD、EuroSAT 和 UCF101。

对于封闭表单的分类任务,从这些数据集中随机选择了 40% 的标签(基础到新任务使用 80% 标签),并包含真实标签。

实现细节:所有实验均在 8 张 A100 GPU 上进行,采用 Pytorch 框架实现。作者使用 Qwen2-VL-2B-Instruct 作为基础模型,并对所有参数进行微调。每张 GPU 的批量大小设为 1,并使用 2 步梯度累积。图像分辨率统一调整为 328×328。

3.2 少样本学习结果

少样本学习旨在检验模型在样本数量极少的情况下,能否有效地学习到任务相关的知识。作者在 4-shot 设置下训练了 SFT 和 CLS-RL,并对比了它们在不同数据集上的表现。

从实验结果可以看出,CLS-RL 在大多数数据集上的表现明显优于 SFT,整体平均准确率也更高。这表明,规则强化微调能够帮助模型在下游任务中取得更好的效果。尽管在某些数据集中 SFT 的表现超过了 CLS-RL,但整体上 CLS-RL 更具优势。

此外,No-Thinking-RL 在 10 个数据集上超过了 CLS-RL,最终获得比 CLS-RL 高出 3.14% 的平均准确率。这表明,去除思考过程的强化学习微调能够有效提升模型的性能,并且在下游任务中的表现优于含思考过程的微调方法。

3.3 “免费午餐”现象

在少样本学习中,作者还讨论了“免费午餐现象”。以往的研究表明,当模型在一个特定数据集上进行微调时,其在其他数据集上的表现可能会显著下降,这一现象被称为灾难性遗忘。

然而,实验结果表明,CLS-RL 和 No-Thinking-RL 的微调可以提升模型在其他数据集上的表现,即使这些数据集的分布差异较大,甚至类列表完全不同。

例如,当模型在 SUN397 数据集上进行微调后,它在 ImageNet、StanfordCars 和 UCF101 数据集上的表现分别提高了 16.98%、15.88% 和 11.10%。这表明,规则化的强化学习微调可以帮助模型获得更广泛的分类知识,而不仅仅是记忆特定数据集的信息。

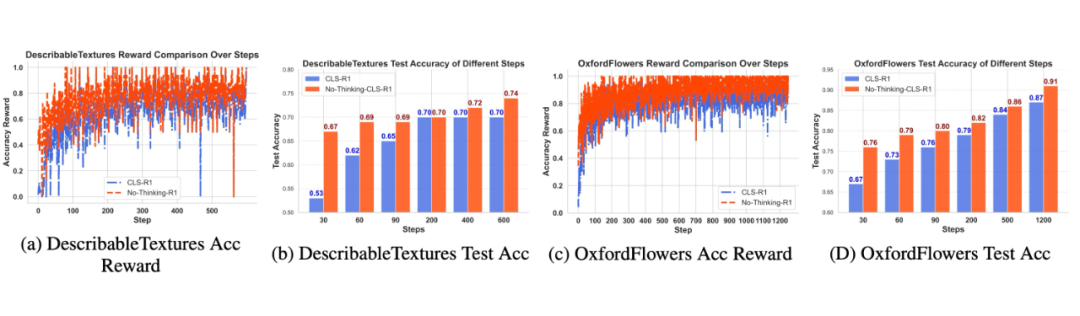

3.4 收敛性对比

作者还比较了 CLS-RL 和 No-Thinking-RL 的收敛速度。实验结果显示,No-Thinking-RL 的收敛速度比 CLS-RL 更快。在大部分训练步骤中,No-Thinking-RL 的准确率奖励更高,并且在训练的早期阶段(前 30 步)测试准确率也显著领先。

作者认为,CLS-RL 由于引入了奖励损失格式,可能在训练初期会产生一定噪声,导致准确率奖励的不稳定。

3.5 效率对比

最后,作者比较了 CLS-RL 和 No-Thinking-RL 的训练和推理效率。结果显示,CLS-RL 在训练和推理阶段的时间消耗明显高于 SFT 和 No-Thinking-RL,原因在于其在微调和推理过程中需要生成多个较长的响应。

相比之下,SFT 只在微调过程中优化标签,No-Thinking-RL 则通过准确性奖励来优化模型,从而显著减少了训练和推理的时间。

在更多多样任务上的实验与分析

在这一部分,作者介绍了在更多多样任务上的实验结果,涵盖了空间理解、数学问题和拼图任务。实验在 2B 和 7B 模型上进行。作者首先介绍了 “Think-After-Answer” 方法,并报告了相应的实验结果。

4.1 Think-After-Answer

作者探讨了为什么 No-Thinking-RL 比 CLS-RL 表现更好。如所示,CLS-RL 的收敛速度比 No-Thinking-RL 慢。因此,作者假设在可验证答案之前进行明确的思考可能会阻碍学习和收敛。为了验证这一假设,作者提出了 “Think-After-Answer” 方法,该方法首先让模型回答问题,然后再给出简短的推理过程。

这样可以减轻在 RFT 过程中明确思考的负面影响。“Think-After-Answer” 的提示是:\texttt{{Question} 请先输出答案,格式为 <answer> </answer>,然后输出简短的推理过程,格式为 <reason> </reason>}。准确性奖励保持不变。

如果假设成立,Think-After-Answer 的收敛速度应当比带思考的 RFT 更快,并且在某些任务上的最终表现应当更好。后续的实验结果验证了这一假设。

4.2 在CVBench上的结果

作者在 SAT 数据集上进行 2 轮微调后,测试了模型在 CVBench 数据集上的表现。表总结了 VisualThinker-R1-Zero、Think-After-Answer 和 No-Thinking-RL 模型的结果。

对于 2B 模型,No-Thinking-RL 在准确性上比 VisualThinker-R1-Zero 提高了 6.4%,在所有子任务上都表现出色。Think-After-Answer 的表现介于 No-Thinking-RL 和 VisualThinker-R1-Zero 之间。对于 7B 模型,三种方法的结果相似。

实验结果表明,空间理解任务中,RFT 过程中不进行思考能够提升表现,而带思考的 RFT 甚至在小模型上表现较差。

此外,作者还可视化了准确性奖励曲线(见图)。从中可以看出,Think-After-Answer 的收敛速度快于带思考的 RFT。准确性结果和收敛速度验证了作者的假设,即在可验证答案之前进行明确思考会阻碍学习和收敛。

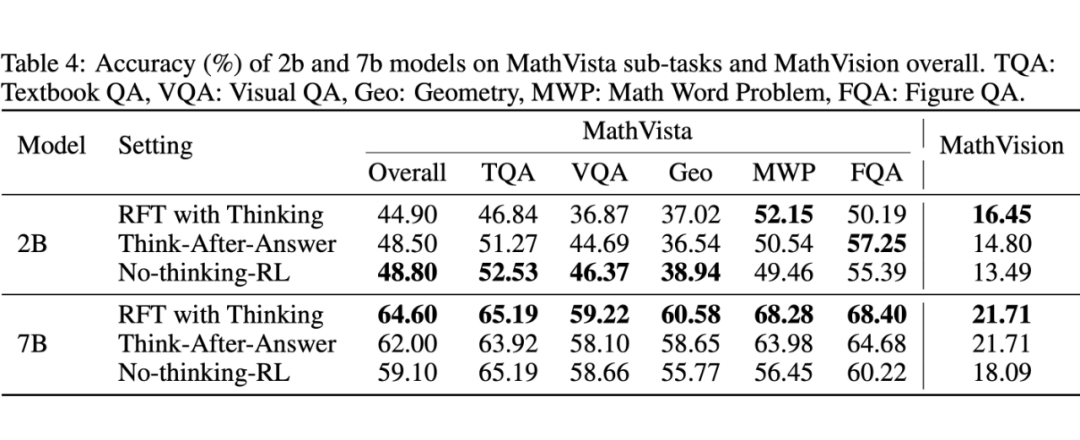

4.3 数学问题的实验结果

在本小节中,作者对数学问题进行了实验。为了得到最终答案,需要生成复杂的中间步骤。作者使用 Math-40K 数据集进行微调,并在 MathVista 和 MathVision 上测试微调后的模型。

结果如表所示。对于 2B 模型,No-Thinking-RL 的表现优于带思考的 RFT。这一结果颇为惊讶,因为数学问题通常需要复杂的中间步骤才能得到最终答案。这意味着当基础模型的能力较弱时,在 RFT 过程中生成推理链会导致性能下降,相较于没有思考的 RFT,RFT 表现较差。

作者进一步将 MathVista 划分为多个子任务,并发现 No-Thinking-RL 在除了数学文字问题(MWP)之外的所有任务中都优于带思考的 RFT。

此外,作者还发现,带思考的 RFT 在 MWP 任务中能超越 No-Thinking-RL。因为 MWP 和 MathVision 中的问题需要大量计算才能得出最终答案,因此直接输出正确答案非常困难。对于其他子任务,计算要求可能不那么高,因此 No-Thinking-RL 也能够表现良好。

对于 7B 模型,带思考的 RFT 显著优于 No-Thinking-RL,这表明当模型的推理能力足够强时,RFT 中的推理链会提升模型的推理能力,进而提高最终性能。

然而,作者注意到,在教材问答(TQA)和视觉问答(VQA)任务中,带思考的 RFT 和 No-Thinking-RL 的表现接近。由于这些任务通常不需要复杂推理,因此相似的结果进一步表明,在某些视觉任务中,思考并不是 RFT 的必要条件。

4.4 谜题问题的实验结果

在这一部分,作者介绍了谜题问题的实验结果。作者生成了一个包含 6.5k 数据的训练数据集,并在 PuzzleVQA(作为领域内测试)和 AlgoPuzzleVQA(作为领域外测试)上测试了微调后的模型。

实验结果如表所示。作者发现,在 2B 和 7B 模型中,No-Thinking-RL 在领域内和领域外测试上均表现优于带思考的 RFT。原因可能是 2B 和 7B 基础模型在拼图任务上的推理能力较弱,因此在 RFT 过程中生成的推理链会妨碍学习过程,而 Think-After-Answer 的表现明显优于常规的带思考的 RFT。

此外,图显示,Think-After-Answer 的准确性奖励收敛速度远快于 No-Thinking-RL。所有这些结果进一步验证了作者的假设:在 RFT 过程中,过早的明确思考会妨碍学习。

结论

本文系统地研究了显式思考在规则强化微调(RFT)中的作用,提出了三种不同的训练范式:CLS-RL、No-Thinking-RL 和 Think-After-Answer,并在多个视觉任务中进行了实证分析。研究发现:

1. CLS-RL 能有效引导多模态大模型(MLLM)进行可验证的推理,显著优于传统的监督微调(SFT),并具有良好的迁移能力,能够在未见过的数据集上实现 “free-lunch” 式的泛化。

2. No-Thinking-RL 进一步挑战了“思考是否必要”的假设,通过直接输出答案而非生成思维链,不仅在性能上超越了 CLS-RL,还显著降低了训练和推理成本。

3. 在更多复杂任务上的实验表明,小模型(如 2B)生成的低质量思考内容反而阻碍了RFT的收敛与性能,而在简单视觉任务中,“不思考”甚至能带来更优的结果。

4. Think-After-Answer 的引入验证了一个关键假设:在生成可验证答案之前进行显式思考会干扰模型学习。

综上,这项研究不仅挑战了“思考即合理”的直觉认知,更为如何在不同任务、模型规模下设计更高效的视觉强化学习范式提供了新的理论依据与实践路径。它启示我们:在多模态推理中,思考的“时机”与“方式”比“是否思考”本身更为重要,为后续 RFT 范式的设计提供了全新思路。

(文:PaperWeekly)