在人机交互日益普及的背景下,语音以其自然、便捷的优势正成为主流交互方式。虽然已有多款语音模型支持流式音频输出,有效降低了体感延迟,但在生成首个音频片段时仍存在较高的等待时间,成为制约实时部署的关键瓶颈。

针对这一挑战,VITA 团队最新推出了突破性成果—VITA-Audio。作为一款端到端的语音模型,VITA-Audio 能在第一次前向传播中直接生成可解码的 Audio Token Chunk,大幅提升响应速度。

在 7B 参数规模下,VITA-Audio-7B 从接收文本到输出首个包含 8 个 Audio Token 的可解码片段仅需 92 ms;若不计入 Audio Encoder 时间,延迟进一步缩短至 53 ms。整体推理速度相比同规模模型提升 3–5 倍,充分满足实时交互对低延迟的严格要求。

同时,VITA-Audio 支持中英双语,且训练过程中仅使用开源数据,却在同等参数量级中稳居性能第一梯队。项目训练和推理代码以及模型权重完全开源,为构建高效、低延迟的实时语音交互系统树立了全新标杆。

代码仓库:

如何高效生成Audio Token?

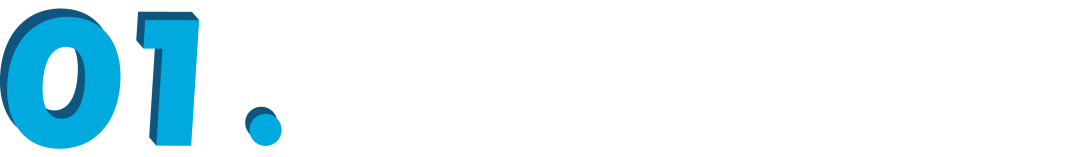

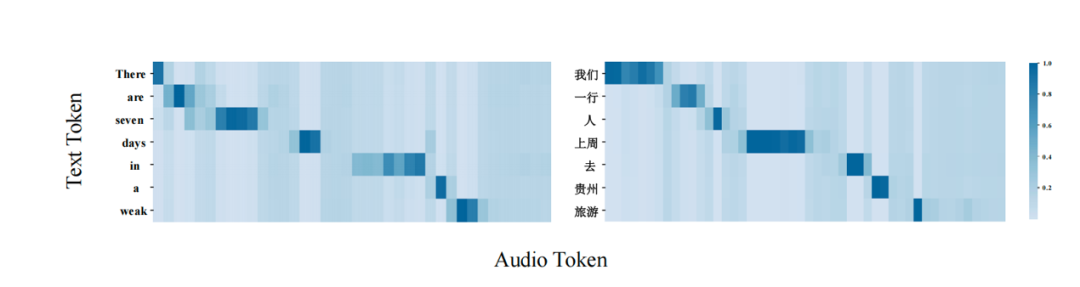

-

当屏蔽所有文本位置的 Hidden States 时,模型无法生成正常的音频; -

但如果仅保留与当前音频 Token 对应的那一位置的文本 Hidden States,模型依然能够输出准确、连贯的语音,且这些 Hidden States 已隐含了足够的上下文信息(例如,区分多音字“行”读作“xíng”还是“háng”)。

方法概述

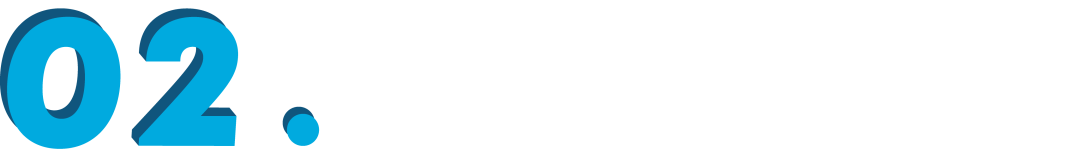

模型结构

VITA-Audio 的核心组件包括音频编码器、音频解码器、LLM、十个轻量级 MCTP 模块。其推理流程如下:

1. 文本与音频特征分别经编码后输入 LLM,LLM 在单次前向传播中生成文本 Token 或音频 Token。

2. 将 LLM 最后一层的隐藏态和输出先输入第一个 MCTP 模块,其输出再依次传递给后续的 9 个 MCTP 模块;每个模块各自预测一个音频 Token,累计得到 10 个 Token,并由音频解码器合成为音频片段。

3. 在下一次前向传播中,LLM 生成的 Token 会与 MCTP 模块生成的音频 Token 一并作为 LLM 输入,进行下一次前向传播。

由于每个 MCTP 子模块的参数量远小于 LLM,单次预测耗时仅需约 2.4 ms(约为 LLM 推理时间的 11%),显著降低了首个音频片段的生成延迟,并大幅提升整体推理速度。

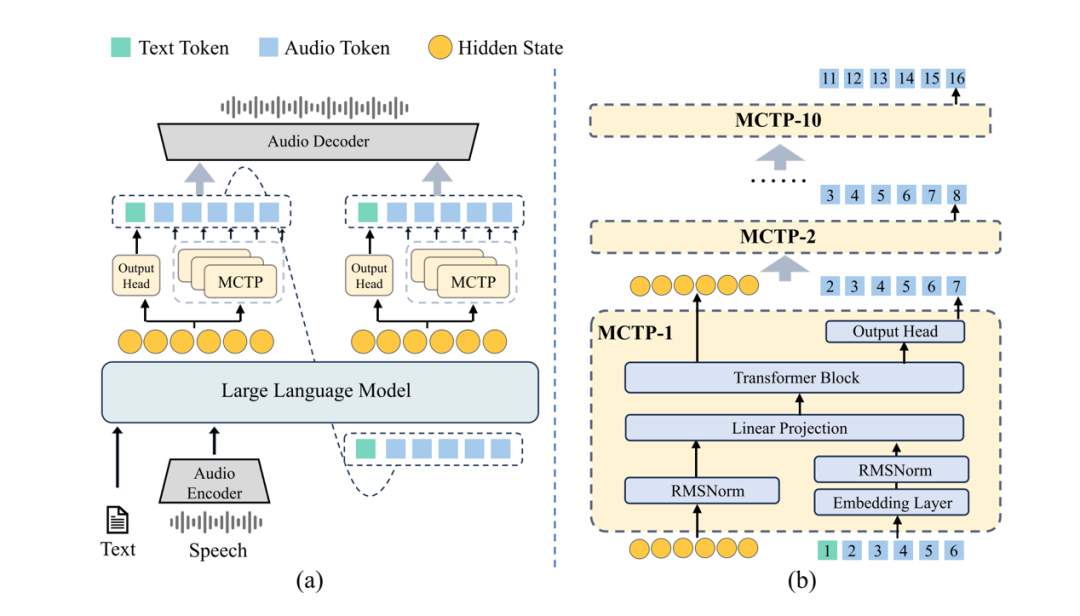

训练策略

为了解决同时从头训练10个 MCTP 模块带来的不稳定性,VITA-Audio 采用了如下四阶段渐进式训练策略:

1. 第一阶段-音频–文本对齐:利用大规模语音预训练任务,将音频建模能力融入 LLM,使其 Hidden states 同时承载文本和音频信息。

2. 第二阶段-单 MCTP 模块训练:训练初始 MCTP 模块,使其能够基于 LLM 的输出 Token 和 Hidden States 预测下一个标记。

3. 第三阶段-多 MCTP 模块训练:将首个 MCTP 模块的能力扩展到多个 MCTP 模块,每个模块根据前一个 MCTP 模块的输出标记和 Hidden States 预测其对应位置的标记。

4. 第四阶段-监督微调:以语音问答数据集为主进行监督微调,同时穿插 TTS、ASR 及纯文本数据,确保模型在各类任务上的泛化能力与训练收敛的平衡。

推理模式

VITA-Audio 提供四种推理范式,以满足不同应用场景对速度与质量的平衡需求:

VITA-Audio-Turbo:最高效的方式,每次前向传播 LLM 生成一个标记,MCTP 模块生成 10 个标记,但因 MCTP 模块也参与文本预测,性能会略有下降,常用于 ASR 和 TTS 任务中。

VITA-Audio-Boost:LLM 专注生成文本 Token,MCTP 模块生成 Audio Token,并且第一次前向中就使用全部的 MCTP 模块,可以在第一次前向中就生成可以用于解码的 Audio Token Chunk。

VITA-Audio-Balance:在前两次前向中仅激活部分 MCTP 模块,保以维持文本与音频 Token 的合理配比(1:2),随后逐步激活部模块,通过动态调节文本/音频 Token 输出比例,实现生成速度与质量的最优平衡。

VITA-Audio-Vanilla:完全依赖 LLM 自回归生成所有 Token,不调用 MCTP 加速模块,推理速度最慢,但可获得最高的音频细节与一致性。

性能评估

模型能力![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

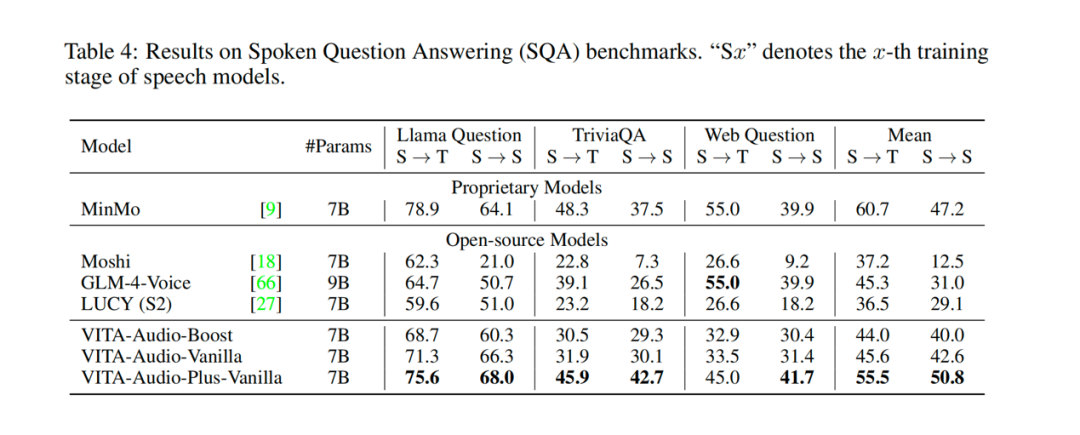

作为一款完全基于开源数据训练的模型,VITA-Audio 在 TTS、ASR 及 Speech QA(涵盖 Llama Question、Seed-TTS 与 WenetSpeech)等任务中表现卓越,在同等参数规模的开源模型中表现位列第一梯队。

并且 S→T(语音输入文本输出)和 S→S(语音输入语音输出)之间的性能下降仅有 4 个点,表明 VITA-Audio 在文本和语音模态之间实现了高质量对齐。

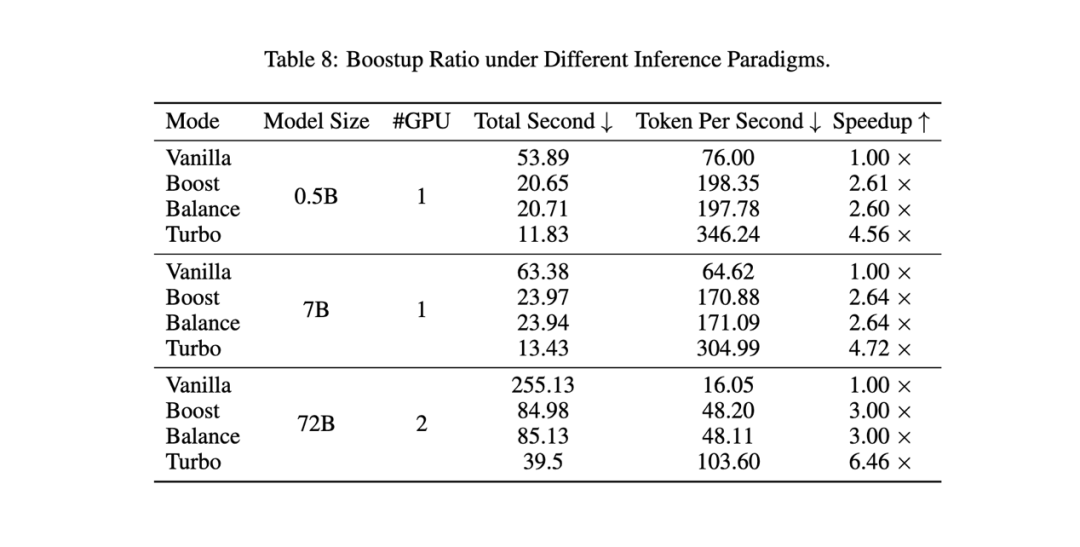

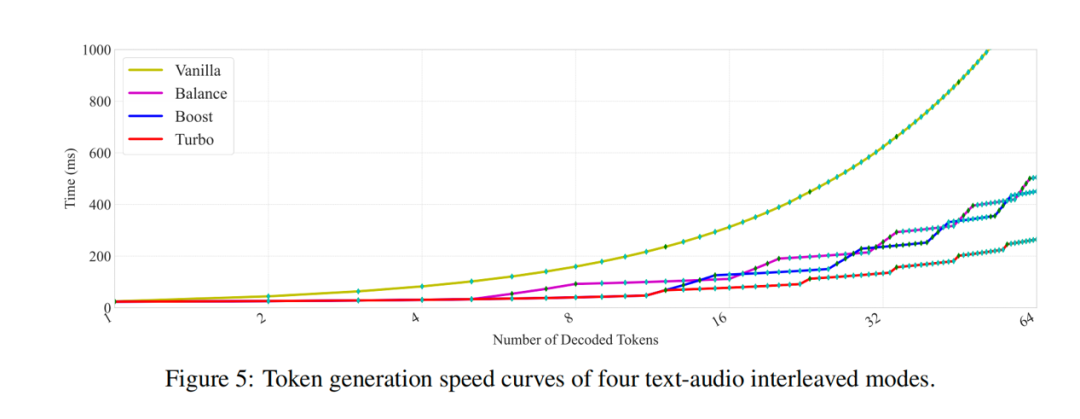

推理加速

高效的文本–语音映射是 VITA-Audio 的核心优势。在不同规模的模型中,VITA-Audio 均展现了显著的推理加速效果:Turbo 模式下,从 0.5B 到 72B 参数规模均可实现约 5 倍的吞吐量提升;Speed 模式下,各尺寸模型亦获得约 3 倍加速,为实时语音对话系统提供了理想性能。

且随着模型规模的增大,加速效果愈加显著—即便在 72B 参数级别,VITA-Audio 也能达到每秒约 50 个 Token 的生成速度,配合 12.5 Hz 音频解码器即可合成约 3 秒的音频及对应文本,其性能完全能够满足高流畅度的人机交互需求。

VITA-Audio-7B 在 Boost 模式下生成速度约为 Vanilla 的 3 倍。

VITA-Audio-7B 在 Turbo 模式下生成速度约为 Vanilla 的 5 倍。

总结

本文介绍了 VITA-Audio,这是一个轻量级框架,其核心在于引入独立高效的多重跨模态令牌预测(MCTP)模块,能够直接从文本 Token 与 LLM Hidden States 中生成音频响应,无需依赖 LLM 的全局语义建模,仅通过简单映射即可完成文本隐藏态到音频令牌的转换。

实验表明,VITA-Audio 在仅仅使用开源数据的情况下,在 ASR、TTS 和 SQA 任务的多个基准测试中均跻身同参数量级开源模型的第一梯队;同时,其推理速度与响应延迟也取得了显著突破。由此,VITA-Audio 为实时语音到语音生成树立了全新的范式。

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

(文:PaperWeekly)