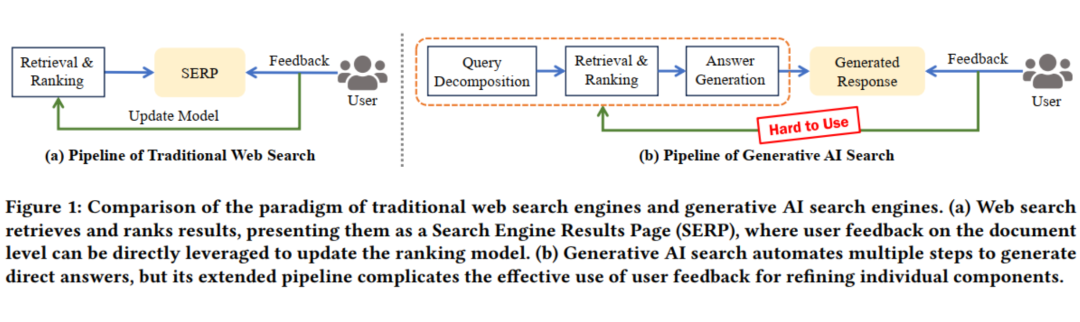

以大语言模型(LLMs)为基础的生成式AI搜索正在重塑信息获取的方式,为用户提供了端到端的答案,极大地降低了用户手动浏览与总结多个网页的繁琐时间成本。然而,虽然这种新范式提升了便捷性,却也破坏了传统网页搜索中长期依赖的用户反馈循环机制。

传统网页搜索通过用户的点击行为、停留时间等精细化反馈,不断地优化搜索排序模型;而生成式 AI 搜索的链路更加长而复杂,包括查询分解、文档检索和答案生成多个阶段,但其获得的用户反馈却通常非常粗粒度(仅针对最终答案),导致反馈难以映射回具体的中间阶段,阻碍了各个中间阶段的持续优化(比如难以利用反馈来更新检索模型)。

为了解决上述问题,我们提出了一个名为 NExT-Search 的新一代搜索范式,旨在重新引入精细化、过程级别的用户反馈机制。这一提案包含两个互补的模式:

-

用户调试模式(User Debug Mode)允许有意愿的用户在关键阶段进行干预,例如优化查询分解、评估检索到的文档以及修改初步生成的答案;

-

影子用户模式(Shadow User Mode)则创建个性化的用户代理,在用户参与度较低时模拟用户偏好,提供辅助反馈。

同时,我们还提出了反馈存储(Feedback Store)的构想,使用户能够共享甚至商业化自身的反馈数据,以进一步激励用户参与。

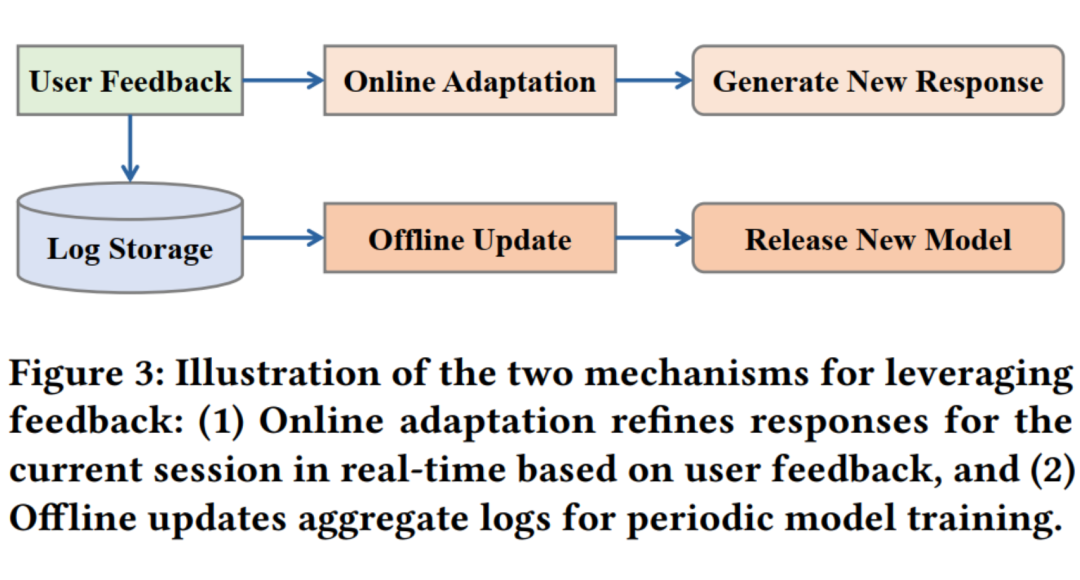

此外,我们探讨了如何通过在线自适应(Online Adaptation)和离线更新(Offline Update)两种方式利用这些反馈数据:前者在实时搜索过程中动态优化当前结果,后者则通过汇总交互日志,定期精细调整搜索流程的各阶段模型。

我们期望通过 NExT-Search 范式,重新建立一个可持续的、富有反馈循环的搜索生态系统,使用户的深度参与有助于持续提升生成式 AI 搜索的性能。

论文标题:

NExT-Search: Rebuilding User Feedback Ecosystem for Generative AI Search

论文作者:

戴孙浩,王文杰,庞亮,徐君,See-Kiong Ng,文继荣,Tat-Seng

作者单位:

中国人民大学,中国科学技术大学,中科院计算所,新加坡国立大学

论文链接:

http://arxiv.org/abs/2505.14680

Web Search vs. Generative AI Search:便利的代价是反馈机制的断裂

生成式 AI 搜索让我们少点了无数次鼠标,却也让搜索引擎失去了最宝贵的‘体感神经’。

生成式 AI 搜索(Generative AI Search)正以对话式、端到端的答案生成方式重塑信息获取方式,对传统网页搜索(Web Search)的主导地位构成挑战。尽管 Microsoft Bing Copilot、Perplexity AI 等产品在初期获得了一定关注和快速增长的用户,但它们在全球搜索市场中的实际份额依然有限。

这一现象引发了一个值得深思的问题:传统搜索引擎为什么能在过去二十年中建立起坚不可摧的技术与市场壁垒?而生成式 AI 搜索在提供更便捷答案的同时,是否也牺牲了支撑传统搜索成功的关键机制?

1.1 Web Search:细粒度反馈驱动的正循环

以谷歌、Bing、百度等为代表的传统 Web Search,大体会经过如下几个关键环节:

1. 查询检索与排序:用户输入关键词后,系统从索引库中检索文档,基于关键词匹配、语义匹配、链接权重(如 PageRank)等特征进行排序。

2. 结果展示(SERP):系统返回一个网页链接列表(通常是前 10 个),附带标题与摘要,供用户点击查看。

3. 用户反馈机制:用户的点击行为、停留时间、跳出率等都作为隐式反馈被记录。这些隐式反馈数据可以很好的直接反应用户的查询和文档之间的相关性以及文档本身的质量,能够直接用于优化排序模型,实现效果闭环。

4. 持续优化(数据飞轮):反馈越多,训练数据越丰富,排序模型越精准,用户体验越好,从而进一步吸引更多用户与数据,形成正向循环。

过去二十多年,Google、Bing、百度等早期的搜索引擎巨头能长期保持巨大的领先,靠的就是“细粒度用户反馈→模型更新”的闭环:每天海量的点击、停留时长等行为日志被实时写入系统,经在线/离线增量训练和 A/B 测试迅速反映到检索与排序模型。

模型效果提升带来更佳体验,吸引更多用户和数据,进一步加速优化,形成正向的反馈循环,使传统 Web Search 成为迄今最成熟、最稳健的大规模 AI 应用之一。

1.2 Generative AI Search:端到端便利带来的反馈断裂

近年来,以 ChatGPT、Bing Copilot、Perplexity 为代表的生成式 AI 搜索迅速崛起,其工作流程发生了显著变化:

1. 查询分解:系统会将用户的复杂查询自动拆分为多个子问题(Sub-queries),提高理解与处理能力。

2. 段落级文档检索:系统根据每个子问题,检索更细粒度的信息单元(如段落),而非整篇文档。

3. 答案生成:基于 LLM(大语言模型),将检索到的证据汇总、重构为一段自然语言答案。

4. 结果呈现与简单反馈: 用户直接收到一段合成答案, 且用户通常只能对最终答案给出粗粒度反馈(如👍/👎或评论),而无法精准指出具体问题出在哪一步。

Generative AI Search 将多个搜索步骤(查询拆解、文档检索、答案生成)打包成一个端到端过程。对于复杂问题, 用户无需再亲自动手反复“拆分-检索-核查-汇总”,对话即可获得复杂问题的完整答案,效率大幅提升。

但这份便利以牺牲细粒度反馈为代价:用户只能对最终答案进行点赞、评论等粗粒度反馈,系统无法追溯是哪一环节(如子查询不合理、文档召回错误、生成幻觉)导致失败。 结果是传统依赖大规模用户行为日志的“反馈飞轮”失灵,搜索质量的自我迭代难以为继。

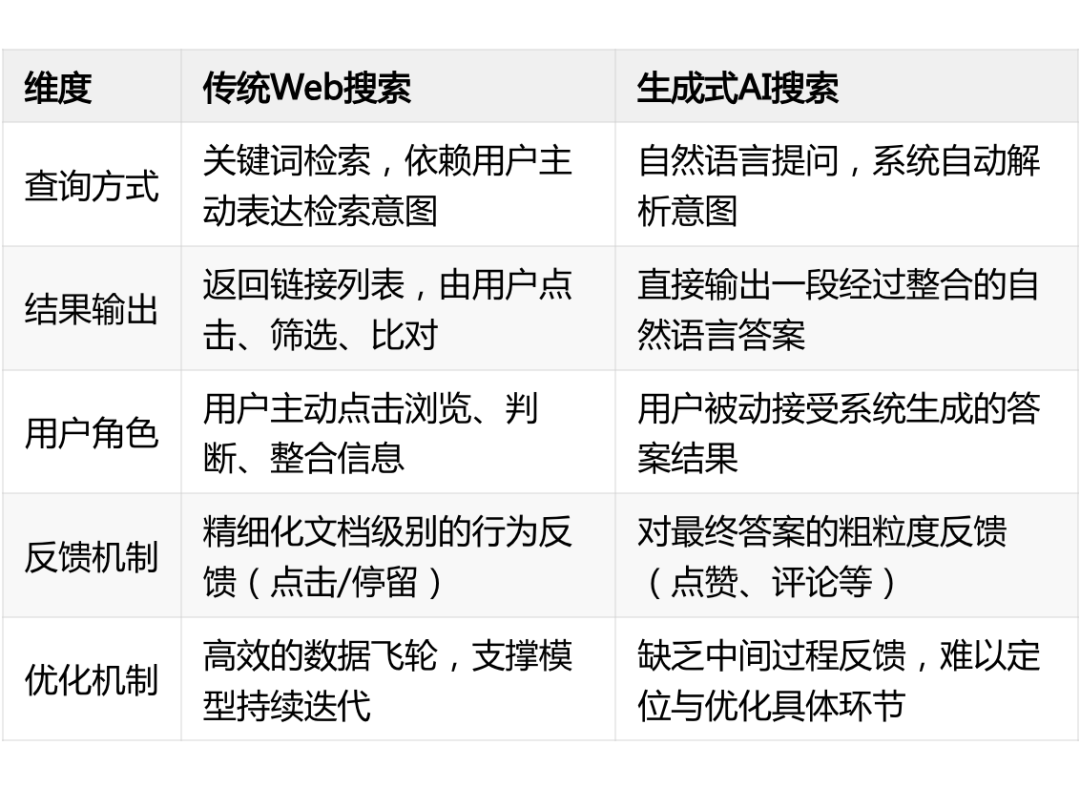

1.3 两种范式总结对比

从上表的对比分析中可以看到,生成式 AI 搜索通过端到端生成答案,大幅提升了用户获取复杂信息的效率,几乎无需点击即可完成整个查询过程,带来了前所未有的便利。

然而,这种便利的背后也伴随着关键机制的缺失——系统接管了原本由用户完成的查询拆解、信息筛选与整合过程,用户不再参与中间决策,用户行为被压缩为对最终答案的简单评价,系统无法像传统搜索那样获取细粒度的文档级反馈,导致模型难以定位问题所在,优化链条中断。

因此,若想让生成式搜索形成与传统搜索类似的正向反馈循环,就需要重新引入对中间过程的可感知、可利用的反馈机制,同时尽可能的减少用户的交互代价,这也正是我们提出 NExT-Search 框架所要解决的核心问题。

NExT-Search:下一代智能搜索的反馈机制探索

用户反馈机制曾是传统搜索引擎持续优化的核心动力。点击、停留时间、跳出率等文档级别的行为数据,构成了细粒度的隐式监督信号,驱动检索与排序模型不断迭代,形成“数据越多、性能越好、体验越佳”的正向飞轮。

但随着基于大语言模型的生成式 AI 搜索系统兴起,用户被“解放”出搜索流程,无需再点击、判断或整合信息。尽管这极大提升了便捷性,却也带来了代价:系统失去了对中间过程的可观测性与反馈链路,难以定位问题、持续改进,优化机制由此陷入停滞,严重制约了生成式搜索的进一步发展。

本文所提出 NExT-Search 的框架正是聚焦于这个关键问题:如何在生成式搜索中重建细粒度、可利用的用户反馈机制,支撑系统的持续演进。

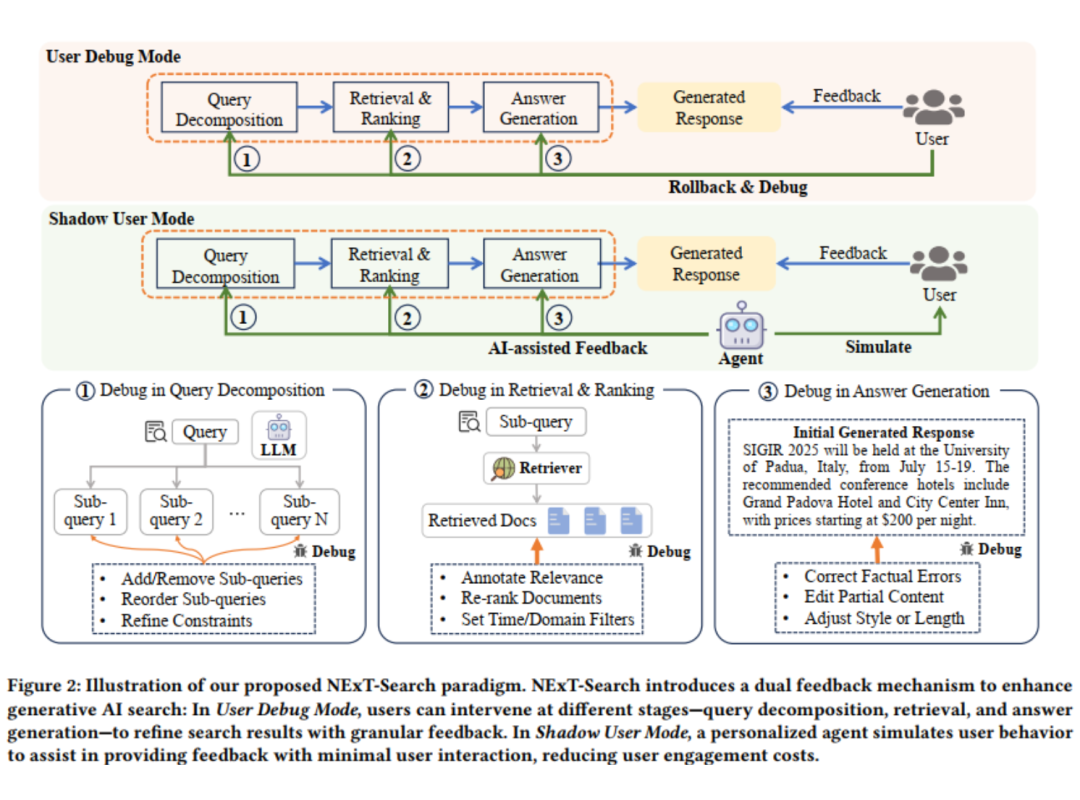

2.1 双模式用户反馈机制

NExT-Search 首先设计了两种互补的用户参与模式:User Debug Mode 和 Shadow User Mode。User Debug Mode 提供了高质量、精准定位的问题反馈;而 Shadow User Mode 则提供了持续、低成本的大规模反馈流。两者结合,让每一次搜索行为——不管是人工介入还是自动模拟——都为模型优化提供可用信息,构建起一个持续学习、持续进化的反馈生态。

2.1.1 User Debug Mode(主动调试模式)

面向有意愿深度参与的用户,系统开放每个阶段的“调试窗口”,允许用户以更细粒度地介入和修正错误, 逐步反馈每个子环节(如调整子查询、标注文档相关性、纠正答案错误),实现对整个搜索过程的透明控制和实时改写。例如在查询分解阶段,用户可以直接进行干预,从而补全意图:

-

增删子查询

-

调整顺序

-

修改约束条件

这种类似“逐层 debug” 的机制,不仅能改善当前会话结果(实时优化),也为系统提供了高质量监督信号(长期学习),重建起了“反馈–优化”的数据闭环。

2.1.2 Shadow User Mode(影子用户模式)

但大多数用户并不愿意频繁手动调整系统。那么有没有办法在用户不参与的情况下,也能获取过程级反馈?

Shadow User Mode 旨在引入一个个性化用户代理(Personalized User Agent),它能学习用户的历史偏好,在用户无反馈时“模拟”他们可能的反馈行为。这就像一个了解每个用户风格的 “AI 小助手”,帮忙做选择、提建议。例如:

-

它可以自动判断哪些子查询可能是多余的;

-

优先保留你偏好的信息源;

-

甚至按你的习惯修改生成答案的语言风格。

这一模式极大降低了参与成本,也确保系统依旧能在低参与度场景中积累反馈信号。

2.2 双阶段反馈利用策略

在 NExT-Search 框架中,我们可以通过两种用户参与模式(主动调试与智能代理)采集到覆盖多个子环节、具有精细颗粒度的反馈信号。为充分发挥这些反馈的价值,我们进一步设计了一套双阶段反馈利用策略,分别面向当前查询会话的即时优化与系统长期性能的持续提升:

在线自适应(Online Adaptation):在用户当前的一次搜索过程中,系统会实时采纳每一个反馈动作(如添加子查询、重排文档、修正文案),对后续环节即时调整。

这种机制类似于“搜索过程中的在线 Debug”,每一次用户修改都向系统注入明确的偏好与意图,使搜索过程在反馈驱动下动态演进,从而更精准地满足用户当前需求。

离线更新(Offline Update):系统会定期收集并汇总用户交互日志(包括人工反馈与 AI 模拟反馈),用于针对三大核心阶段(查询分解 / 检索排序 / 答案生成)的训练数据构建,从而进行增量式微调或再训练,实现工业级搜索系统的“每日增量训练”策略,让模型始终在最新用户行为数据上保持更新,确保长期鲁棒性与用户适应性。

通过“会话内即刻响应 + 长周期迭代优化”的结合,NExT-Search 旨在实现从“反馈”到“优化”的完整闭环,既关注当下结果的准确性,也推动搜索引擎能力的稳步演进。

2.3 反馈商城

为了进一步激励用户参与,我们还设想了一个“反馈商城(Feedback Store)”机制:

-

用户可以把自己的“调试模板”保存、上架;

-

其他人可购买复用,平台给予收益;

-

高质量的调试过程也能成为“知识资产”。

这样一来,反馈不仅是改进模型的手段,更是用户可以分享、交易的“有价值的劳动成果”。

未来研究方向

尽管 NExT-Search 提出了全新的生成式搜索反馈机制构想,但当前仍处于理论框架与可行性探索阶段,尚未在大规模系统中完成端到端部署与实证验证,我们希望这一新范式能激发更多学术与产业界的关注与研究。我们也列了一些未来潜在的值得深入的研究方向:

个性化用户模拟器的构建与训练:Shadow User Mode 的核心在于构建能够准确模拟用户偏好的智能代理。这一目标需要结合用户画像建模、行为轨迹挖掘、上下文理解等关键技术,进一步探索如何在数据隐私可控的前提下,利用少量交互数据生成可靠的 “AI 模拟反馈”。

此外,还需要研究代理系统的学习机制与稳定性,确保其生成的反馈对模型更新具有指导意义而非引入偏差。

多源反馈融合与高效学习算法设计:NExT-Search 同时采集来自主动用户与模拟代理的反馈信息,这些信号在质量、密度和置信度上存在显著差异。

如何融合稀疏但高质量的用户反馈与高频但可能噪声较多的 “AI 模拟反馈”,并针对不同模块采用差异化的训练策略,是实现稳定迭代优化的关键。未来可探索多任务学习和噪声鲁棒训练等方向,提升系统对异构反馈的利用效率。

人机交互设计与可用性优化:NExT-Search 所强调的“过程级调试”虽然为模型带来可解释性与优化可能,但也对用户的参与成本与操作负担提出了新挑战。如何以可视化、模块化的方式呈现搜索过程,让用户愿意并有能力高效提供反馈,是系统设计的关键环节。后续可借助 HCI 研究,优化界面交互流程,甚至基于任务复杂度、用户习惯等因素实现交互模式的自适应切换。

(文:PaperWeekly)