DeepSeek-R1 爆火后,类 R1 的结果奖励训练范式在各领域掀起了推理热潮。基于规则的结果奖励实现简单、判断严格。但是,这真的够了吗?

在推理任务中,如果我们只是用「结果对错」来奖励模型,那模型就很可能学会了「靠捷径答题」。

这种模式下,模型的「正确思考策略」没有完全建立起来,它甚至会因为一次「瞎蒙对」的奖励,而在之后反复强化错误策略,越走越偏。

为了解决这个问题,港中文联合上海人工智能实验室团队发布了多模态推理模型 SophiaVL-R1,它在类 R1 强化学习训练框架上做了一次关键进化:不再只奖励结果是否正确,而是将「思考过程」也纳入奖励体系。

-

论文链接:https://arxiv.org/abs/2505.17018

-

项目地址:https://github.com/kxfan2002/SophiaVL-R1

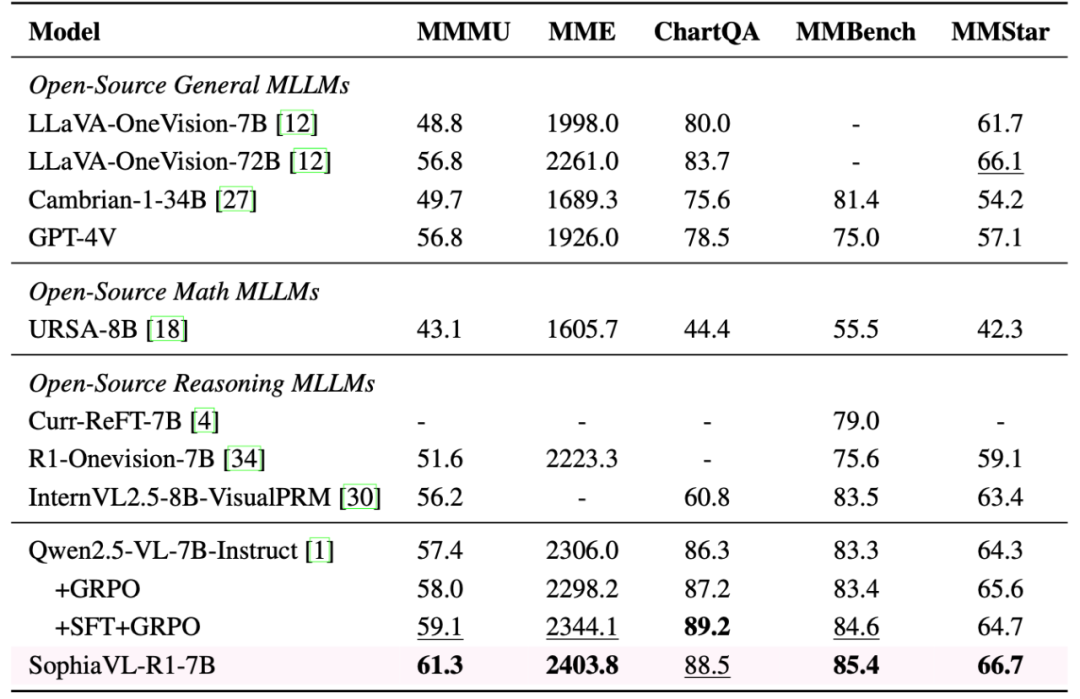

这一套设计不仅能让模型学会更通用、更靠谱的推理策略,还显著提升了泛化能力——在多个数学和通用多模态基准测试中,SophiaVL-R1-7B 甚至击败了参数量是其 10 倍的 LLaVA-OneVision-72B 模型。 目前,研究团队已将所有模型、数据和代码开源。

思考过程也要评分,才是好模型

SophiaVL-R1 的关键突破点,就在于它引入了「思考奖励」机制 —— 不再只看答案对不对,而是开始评估模型整个推理过程是否合理、连贯、靠谱。

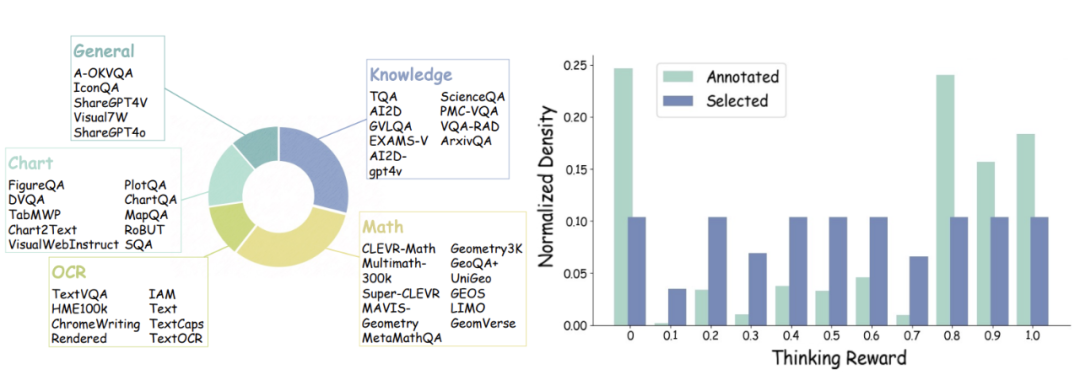

研究团队精心制作了一个思考过程评分的数据集,包含多样化的思考模式和错误,并训练了一个「思考评分模型」,基于多个角度对思考过程输出一个整体的评分。

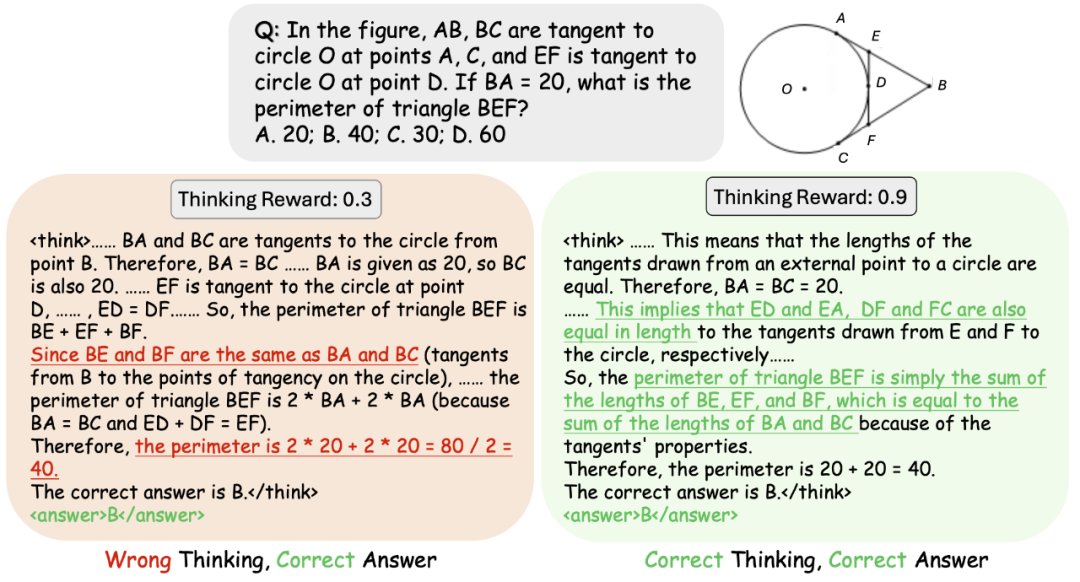

举个例子,比如一段推理过程,答案是对的,但中间逻辑跳跃明显、甚至完全胡扯,那这个过程可能只能得个 0.3 的思考分;而另一个推理过程最终也选了 B,但过程缜密、推导清晰,思考分可能达到 0.9。就像老师改卷,不只是看结果,还会给「过程分」。

这一招,不仅提升了模型推理质量,更重要的是 —— 它教会模型「怎么想」,而不是「怎么猜」。

SophiaVL-R1 的「奖励改革」

不过,把「过程」纳入奖励机制,并不意味着直接相加就能奏效。

由于模型生成的思考过程是自由文本,容易「伪装认真」——比如它可能写了一长段貌似合理的「逻辑」,但其实是在重复废话,甚至是掩盖思考漏洞。这种奖励欺骗(Reward Hacking)现象是强化学习中极常见的问题。

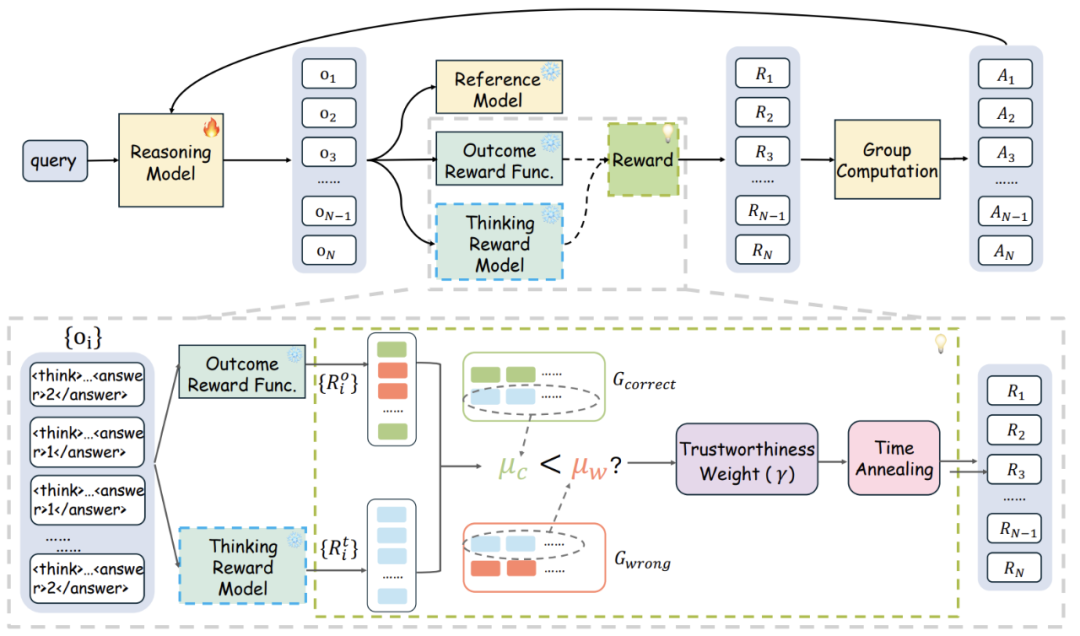

为了解决这个痛点,SophiaVL-R1 引入了一个名为 Trust-GRPO 的训练算法,它的核心理念是:基于 GRPO 组内信息判断思考奖励的可信程度。

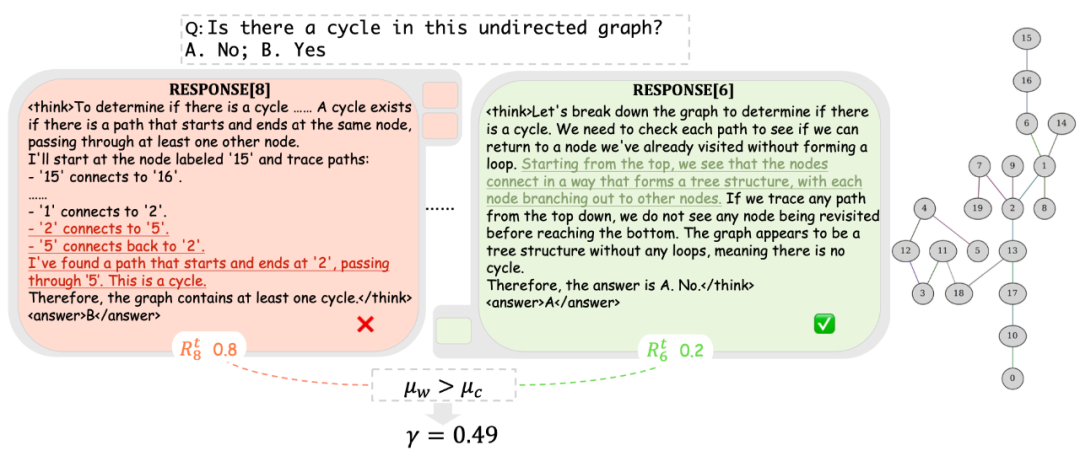

该方法通过对同一问题中,正确与错误答案对应的思维奖励进行对比,如果发现错误答案获得的思维奖励异常高,就会自动降低该奖励的可信度评分,从而提升整体训练的稳定性与可信性。一个例子如下图所示。

实验结果

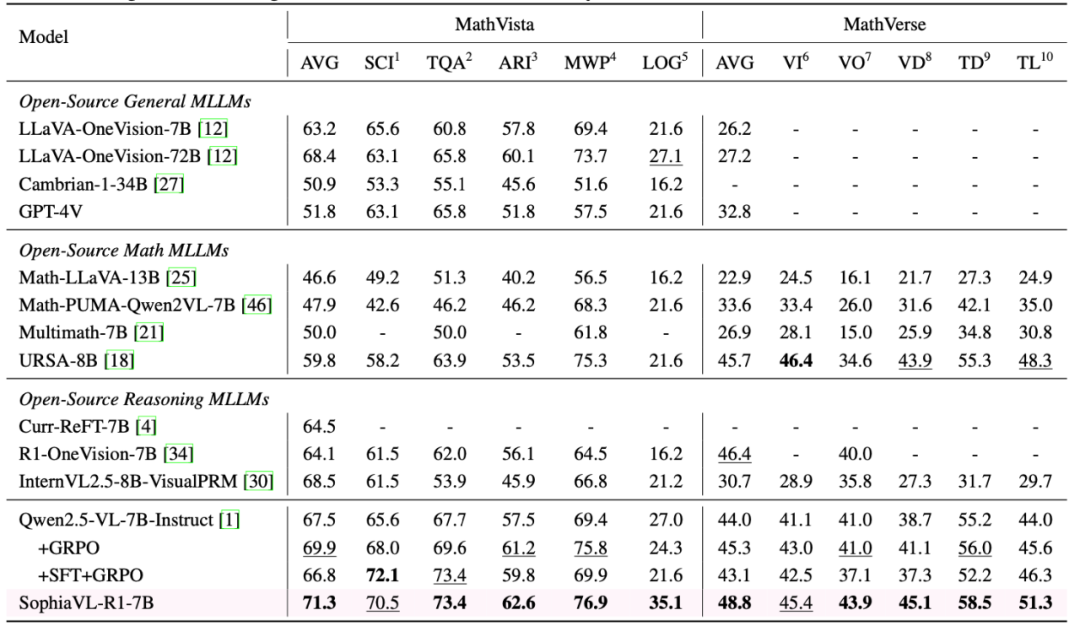

在多项常用的评测基准中(MMMU、MME、MathVista 等),SophiaVL-R1-7B 展现出极为强大的推理能力和泛化能力,跟 GRPO、SFT+GRPO 和基于 PRM 的方法相比都很能打,在多个多模态数学和通用测评数据集上表现直接对标甚至超越了体量是其 10 倍的 LLaVA-OneVision-72B 模型。

这说明了一个非常核心的点:推理能力,是靠正确的训练范式教出来的。SophiaVL-R1 的成功,正是对这一点的最好注解。

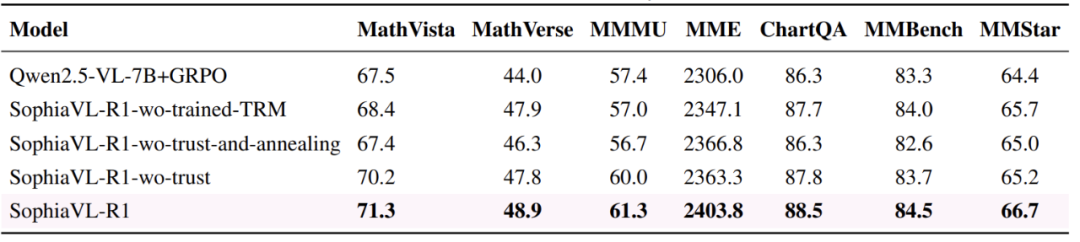

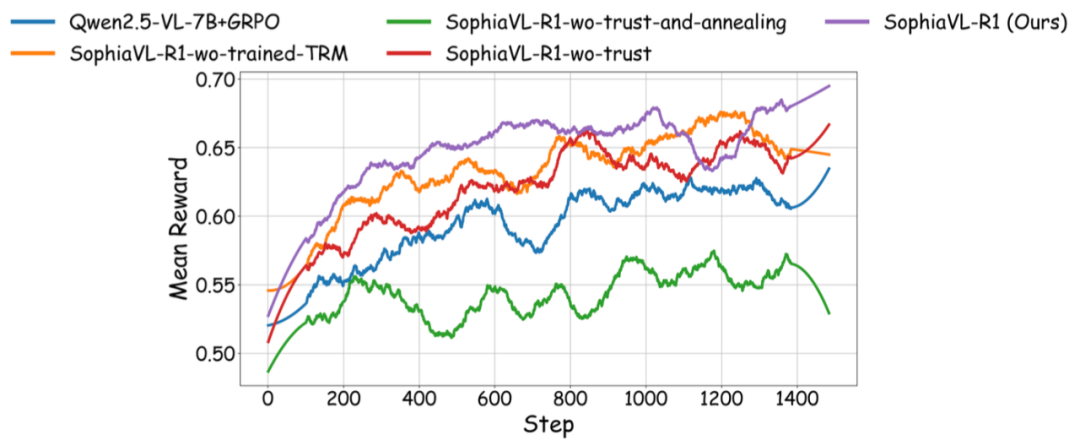

在消融实验中,也可以发现,SophiaVL-R1 的各个部分都是有效的。

同时,从训练曲线来看,SophiaVL-R1 不仅训练得更好,而且训练得更快,说明了思考奖励信号的有效性和 Trust-GRPO 算法的重要性。

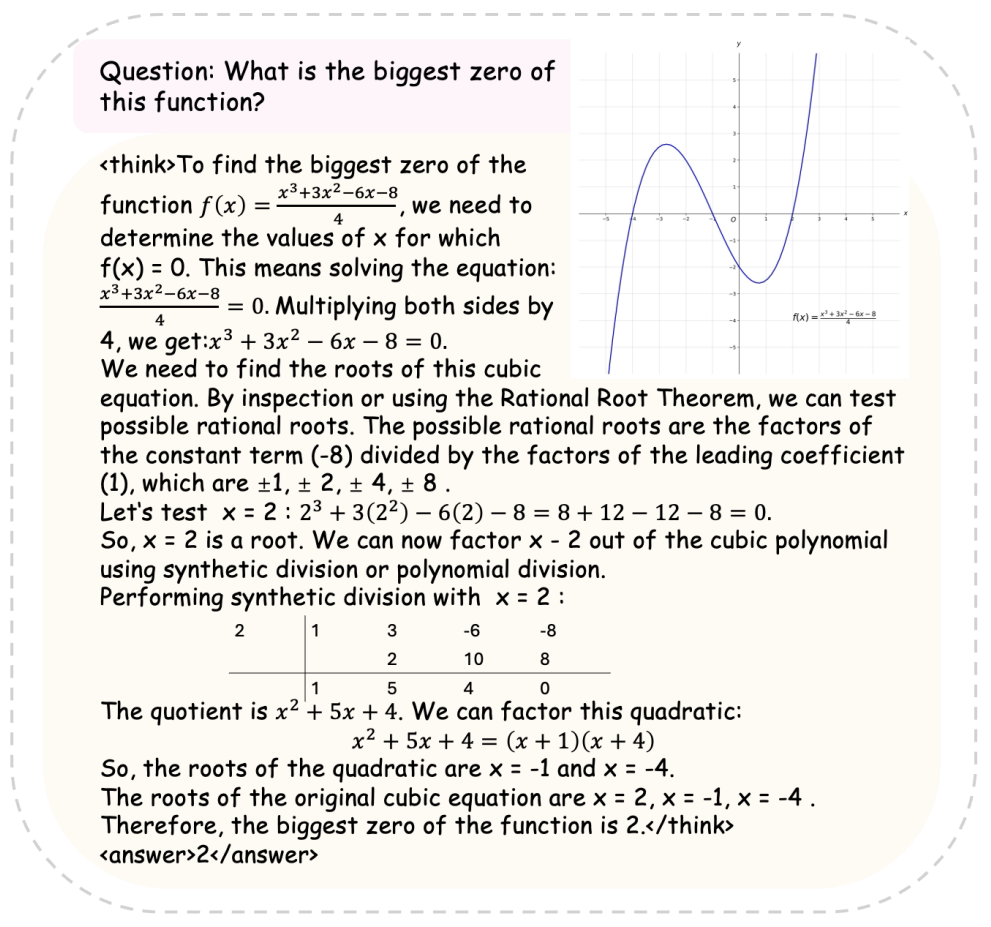

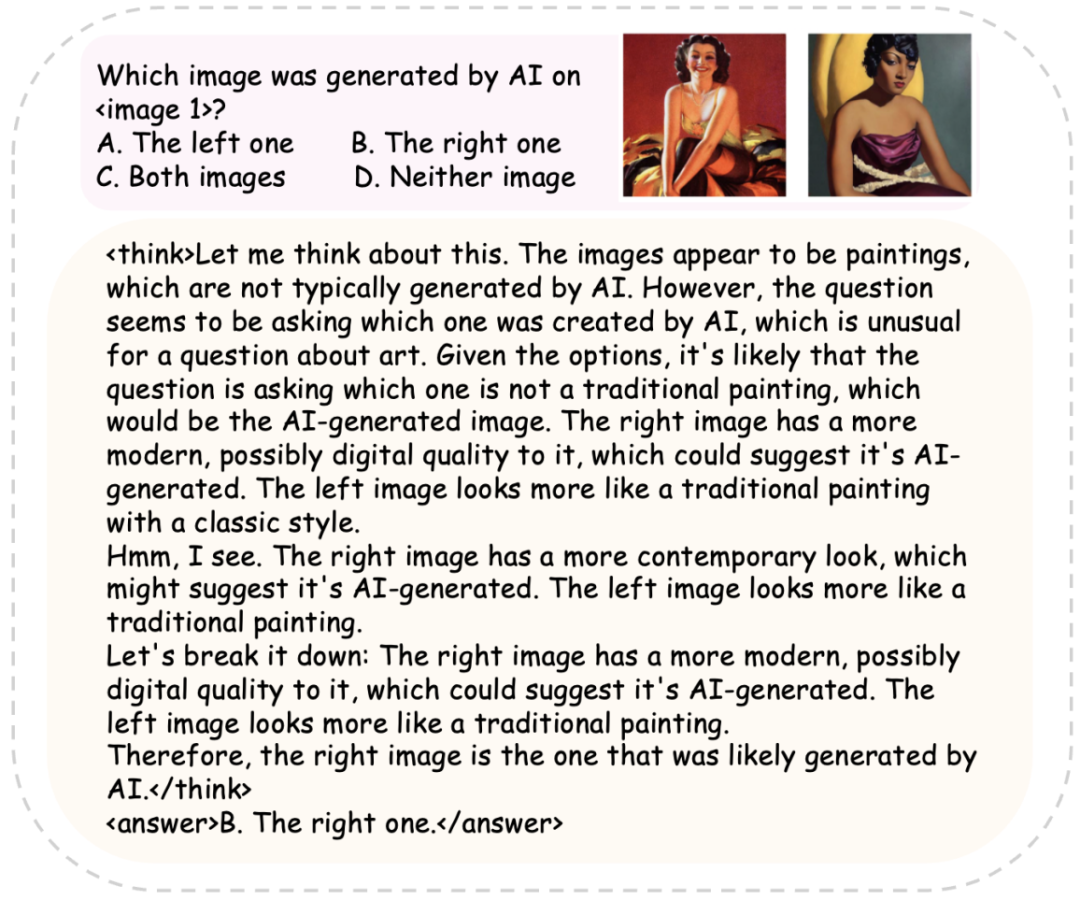

一些 SophiaVL-R1 的推理例子如下所示,可以看到,模型能够输出高质量的推理过程。

更多细节请参考论文原文。

©

(文:机器之心)