跳至内容

— 本周为您解读 ③ 个值得细品的 AI & Robotics 业内要事 —

1. No More Next-Token Prediction?

NTP 有什么根本缺陷?Next-Concept Prediction 有何优势?LCM 如何学习 Concept?LCM 会解锁什么样的未来?Latent Space 会是下一个研究热点吗?LCM+BLT+JEPA=未来?…

2. Altman:不装了!一半是赚钱,一半是「神奇药水」

OpenAI 要如何构建 AGI?OpenAI 对于 AGI 定义的转变是为了其商业化战略调整铺路?为什么说「通用」二字直接代表着「钱」?为什么通用人工智能系统才是「金苹果」?Agent 的重要机会在哪?…

3. Agent 成为 25 年产品落地最佳方式?谷歌发布最全 Agent 白皮书

Agent 是什么?缘何而来?与传统的 LLM 哪些区别?Agent 具体是如何工作的?为什么说编排层才是 Agent 架构的核心?Agent 与外界环境进行交互的工具是什么?如何更有效地提升 Agent 的性能?…

…本期完整版通讯含 3 项专题解读 + 28 项本周 AI & Robotics 赛道要事速递,其中技术方面 11 项,国内方面 9 项,国外方面 8 项。

消耗 99 微信豆即可兑换完整本期解读(约合人民币 9.9 元)

要事解读① No More Next-Token Prediction?

引言:Meta 团队在 2024 年 12 月中旬提出了无需 tokenizer 的 BLT 架构,在多模态对齐、融合问题中展现了极大潜力。而同期发布的另一项工作提出的大型概念模型(LCM)同样舍弃了 token,试图粘合符号主义和连接主义,让 AI 直接在语义空间中进行推理和生成,被许多声音认为是大模型范式变革的新起点。

从质疑 Transformer 到质疑「Next-token Prediction」?LLM 的「底层逻辑」还能 Hold 多久?

Meta 的研究者在 2024 年 12 月发布了多项工作中探索了模型的潜在空间(Latent Space),试图通过改变潜空间的排列方式,彻底改变模型的思维表征,进而实现更符合人类思维方式的推理。对潜在空间探索的背景部分原由在于,当前所有开源、闭源的 LLM 均缺乏在抽象层面、独立于特定语言或模态的信息处理和生成的显式分层结构。[1-1]

1、传统 LLM 中,预测下一个 token 的范式得以广泛应用的原因之一在于,其在工程实现上相对容易,也因此在实践中取得了显著的成效。

① 由于计算机只能处理离散的数值表示,因此需要将文本转换为向量进行数学运算,token 则是实现这种转换的最简单直接的方式。

2、Ilya Sutskever 曾在与黄仁勋的对谈中指出,模型预测下一个词时,实际上是理解了文本背后的现实世界过程和情感等信息,形成了「世界模型」。(详见 Pro 会员通讯 2024 Week 48 期)

3、然而,业内对这种用离散的符号系统来捕捉连续且复杂的人类思维的方式的诟病在于,它和人类思维的本质存在冲突,因为人类并不会以 token 的方式进行思考。[1-1] [1-2]

① 人类在解决复杂任务或撰写长篇文档时,往往采用分层方法,通常先在高层次规划整体结构,再逐步添加细节。

② 以准备演讲稿为例,人类通常不会准备好每个具体的用词,而是罗列需要在演讲中传达的核心观点和流程。即便进行多次同主题演讲,其中的具体用词、语言均可能不同,但核心观点的逻辑流程保持不变。

③ 以撰写论文为例,人类通常会准备一个整体框架,将文档分为若干章节,然后逐步细化。人们还能在抽象层面上识别和记住长篇文档各部分之间的关联。

4、Meta 的研究者在「LCM」(大型概念模型)工作中提出了让模型从抽象的概念层面进行学习和推理的架构,模型输入和输出均为「concept」而非「token」,并在多语言零试泛化能力上超越了所有同尺寸 LLM,引起业内热议。

① Hyperbolic 的 CTO Yuchen Jin 在社交平台评论 LCM 称,他越来越确信 tokenization 会消失,LCM 用「next-concept prediction」取代 LLM 的「next-token prediction」,他的直觉认为 LCM 可能更擅长推理和多模态。[1-2]

② LCM 同样引发了大量 reddit 网友的热议,认为 LCM 带来的是 AI 认知的新范式,并十分期待 LCM 与 Meta 的 BLT、JEPA、Coconut 等工作相结合带来的化学作用。[1-3] [1-4] [1-5] [1-6] [1-7]

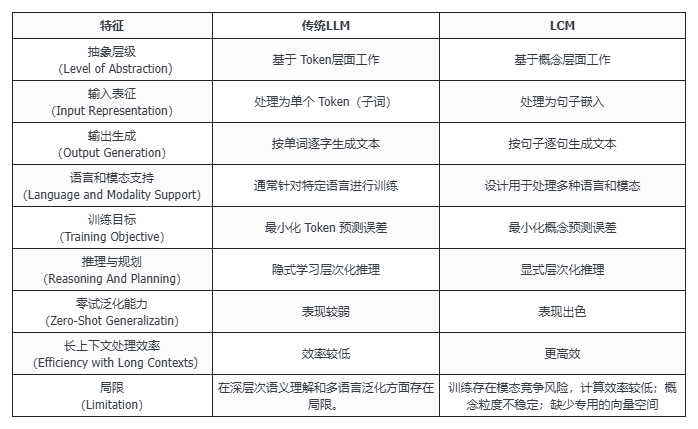

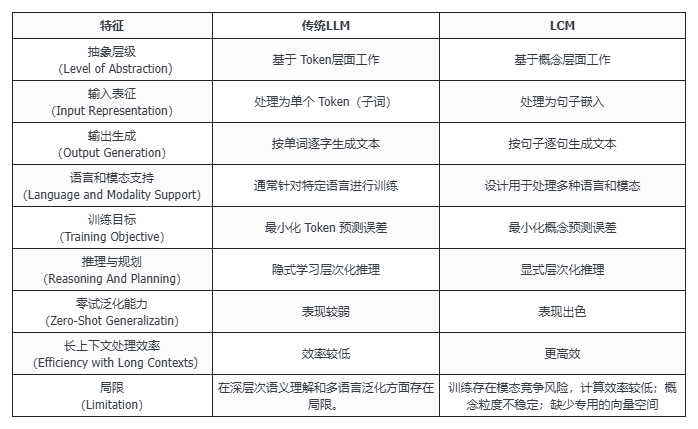

表:LLM 与 LCM 的特征对比 [1-1] [1-8]

不再预测下一个 token 的 LCM 如何学会抽象推理?[1-1]

1、LCM 的核心思路在于尝试在更高层次的抽象层面上进行语言建模,是一种「以概念为中心」的范式。

① LCM 将抽象层次限定为 subword token 和 concept(概念)两个层面。

② 「概念」的定义是与语言和模态无关的抽象实体,代表了流程中更高层次的想法或行为。在实践中通常对应文本文档中的一个句子或等效的语音表述。

③ 换言之,LCM 的思路可以理解为让模型直接学习「概念」,通过转换器把句子还原成一组组概念序列来取代 token 序列,然后进行训练。

(文:机器之心)