一个仅有8B参数量的全能模型力战GPT-4、Gemini 1.5 Pro!

华人团队打造的MiniCPM-o 2.6多模态大模型刚刚发布,就在多项基准测试中展现出了惊人实力!

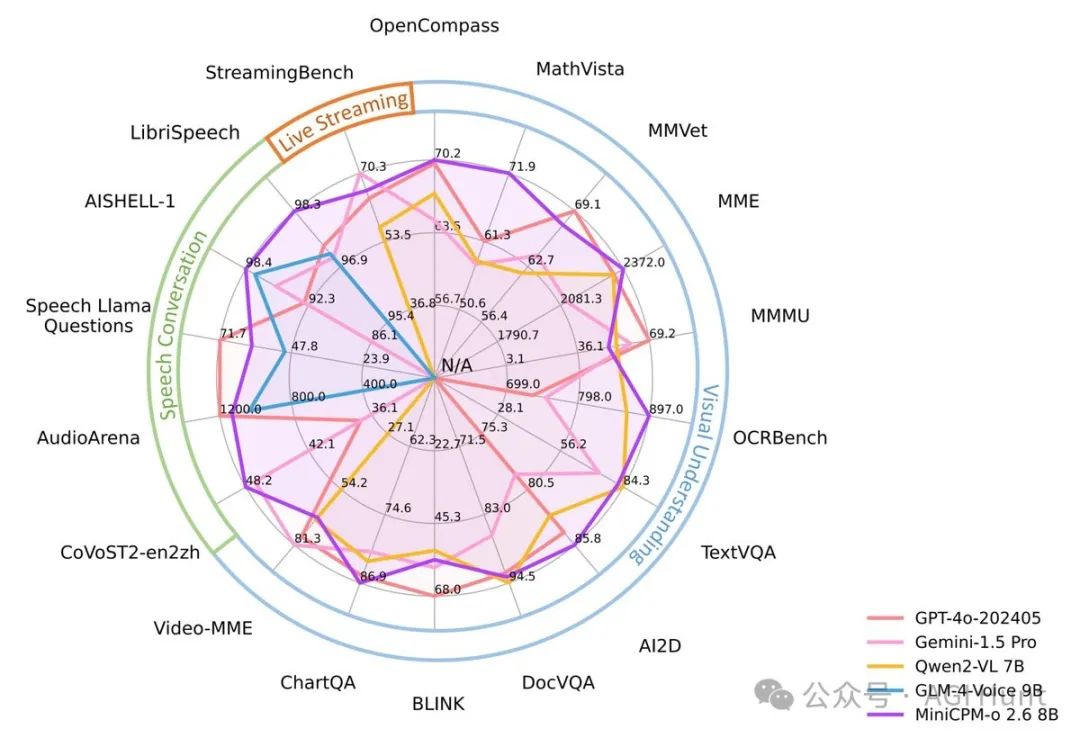

视觉能力上,在OpenCompass评测中平均得分达到70.2,支持1344×1344高分辨率图像处理,而且仅需其他模型25%的视觉tokens就能完成任务。

语音方面,支持实时双语语音识别,在ASR/STT任务上甚至超越了GPT-4o实时识别的表现。

最厉害的是,它还支持30多种语言,真正做到了「小而全」!

VB Srivastav(@reach_vb) 兴奋地分享了这个消息:

MiniCPM-o 2.6是一个8B的多模态LLM,在视觉(OpenCompass平均得分70.2,1.8M像素 – 1344 x 1344)、语音(双语实时,在ASR/STT上超越GPT-4o实时)方面表现优异,使用75%更少的视觉tokens,支持30+种语言。

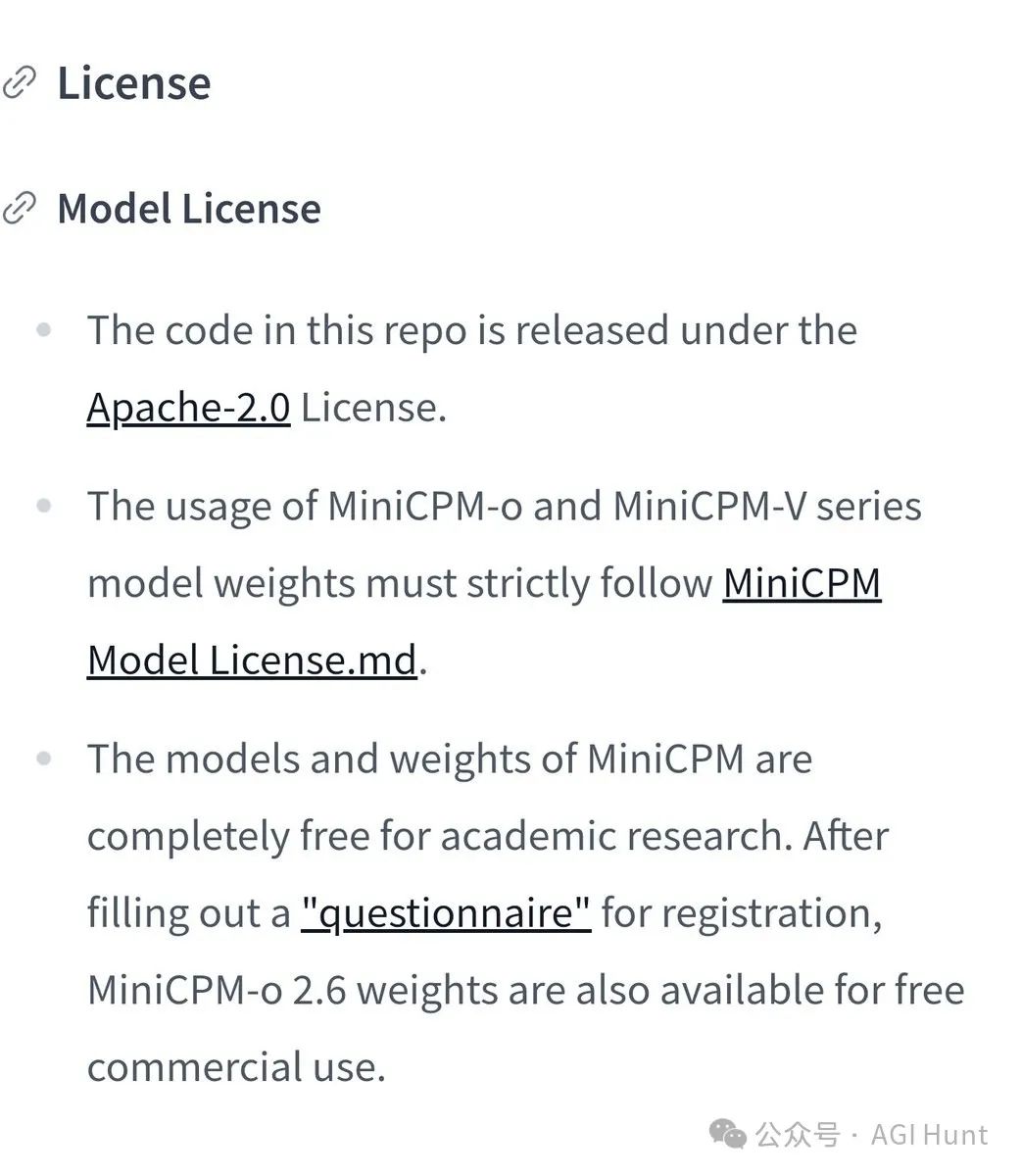

模型许可有变

一开始,VB误以为这是一个Apache 2.0许可的模型,引发了不小的讨论。

Allen Zhou(@zhoujinjing09) 立即指出了这个错误:

模型权重并不是apache 2.0许可。

随后,Yossi(@elkriefy) 详细解释了许可情况:

这没有改变。代码是Apache许可,权重需要获得许可批准。

事实上,MiniCPM-o的许可政策是这样的:

-

代码采用Apache-2.0许可证

-

模型权重对于学术研究完全免费

-

商业使用需要注册并填写问卷,对于日活少于100万用户或5000个实例的用户可以申请免费商业许可

Janek Mann(@janekm) 对此表示乐观:

免费商用限制在日活100万用户/5000个实例以下,需要他们批准。还不错,我已经提交申请了,看看结果如何。

业内反响热烈

Victor(@victor_explore) 直言不讳地表示:

这简直是一场悄然革命!

一个仅有8B参数的模型能在如此多的任务上挑战甚至超越GPT-4、Gemini 1.5 Pro这样的顶级模型,这绝对是一个重大突破。

这次MiniCPM-o 2.6的发布,不仅展示了小模型的潜力,也为商业应用提供了更多可能性。

它用实力证明:参数量小,一样可以很强大!

🔗 体验链接

-

GitHub:https://github.com/OpenBMB/MiniCPM-o

-

Hugging Face:https://huggingface.co/openbmb/MiniCPM-o-2_6

-

Demo:https://minicpm-omni-webdemo-us.modelbest.cn/

(文:AGI Hunt)