TL;DR:本研究提出了一种新的语法纠错系统评估指标,能够根据评估句子类型不同,动态调整子指标的权重,确保评估分数更加符合人类反馈。

作者单位:

论文链接:

代码链接:

Highlights

-

提出了 DSGram 这一创新的评估框架,它通过动态调整子指标的权重,提供了更为精准的评估方法。

-

整合了语义一致性、编辑水平和流畅性三个关键评价维度,确保评估结果更加符合人类反馈。

-

开发了两个新数据集,DSGram-Eval 和 DSGram-LLMs,用于模拟人类评分来验证和微调算法。

背景简介

语法纠错(Grammatical Error Correction, GEC)模型旨在自动纠正自然语言文本中的语法错误,提升书面内容的质量和准确性。传统上,GEC 模型的评估运用了多种指标,这些指标可以分为需要参考文本的(reference-based)和不需要参考文本的(reference-free)两类。

基于参考的评估指标,如 BLEU、ERRANT 和 M²,通过将模型生成的文本与正确的参考文本进行比较来评估语法纠正的准确性,并且在这一领域得到了广泛的应用。

尽管这些指标很有用,但它们存在固有的局限性。例如,黄金参考答案(golden reference)可能无法涵盖所有可能的纠正方法,而且现有的自动评估指标与人类判断的一致性通常较弱。

此外,基于 LLM 的 GEC 模型可能会过度纠正句子,导致传统指标无法捕捉到的不必要编辑。相反,无参考评估指标,如困惑度、GLEU 和 SOME,直接评估生成文本的质量,在没有正确参考文本,或者单个(或几个)参考文本不足时是有益的。

尽管现有的无参考评估指标,如 SOME,提供了一个分析基础,但它们不再完全涵盖 LLM 时代 GEC 评估的范围。有必要根据 LLM 时代的新需求设计新的评价指标。

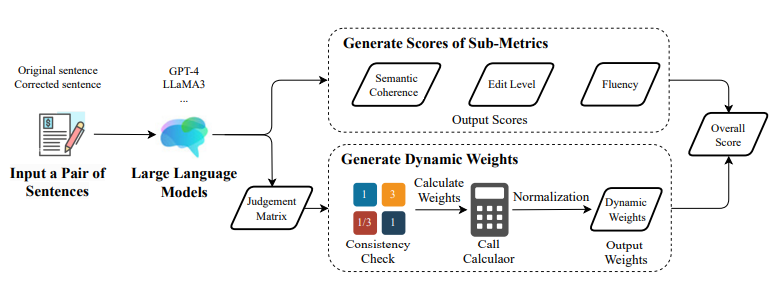

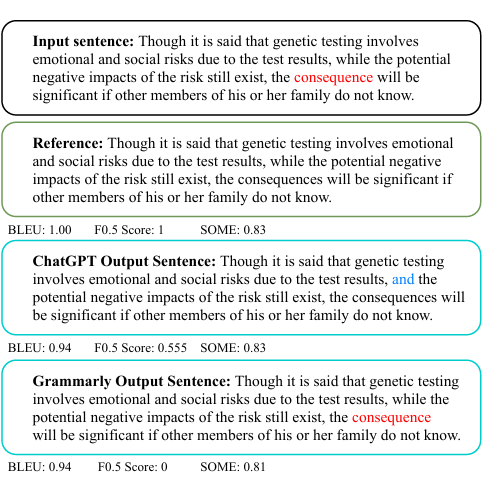

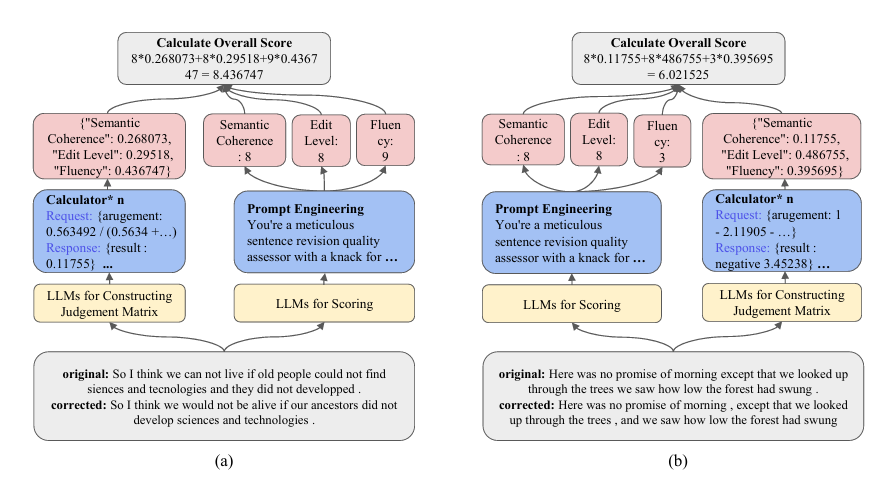

图 2 展示了代表性 GEC 系统的运行示例和当前评估指标的局限性。本研究旨在通过引入一个新的 GEC 模型评估框架 DSGram 来克服这些局限性。DSGram 整合了语义连贯性、编辑水平和流畅性,并确定这些标准的适当权重。通过根据评估场景的上下文调整这些权重,可以开发出一种更细致、更具情境敏感性的评估方法。

研究方法

2.1 动态权重的评价方法

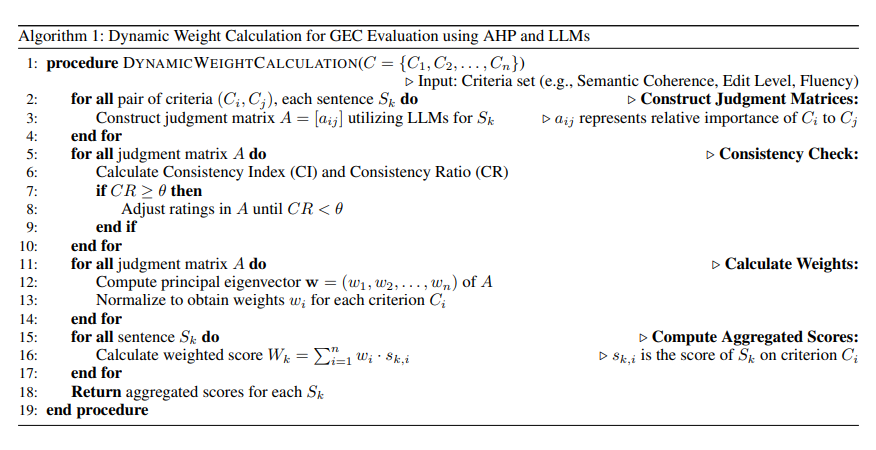

动态权重评价方法,即 DSGram 框架中的核心机制,是一种根据评估场景的上下文动态调整不同评估方面权重的方法。这种方法旨在更准确地反映人类评估者在评分时的直觉过程,并提高评估结果的可靠性和一致性。

DSGram 框架结合了层次分析法(AHP),这是一种决策框架,通过成对比较将复杂决策分解为更简单、更易于管理的元素。

传统的 AHP 将主观判断综合成客观的优先级,并根据专家对重要性的评估适当地加权。但专家评估存在成本高、耗时长的问题,本文将 AHP 与大语言模型结合,让大语言模型来判断各个子指标之间的相对重要性,解决了原有专家评估的局限性,大大提高了 AHP 的可用范围。

DSGram 框架使用大语言模型(如 GPT-4 和 LLaMA3)来生成这些子指标的动态权重,主要步骤如下:

-

构建判断矩阵:对于每对子指标,使用大语言模型构建一个成对比较矩阵 A = (a_ij),其中 a_ij 表示标准 i 相对于标准 j 的重要性。这个矩阵是通过特定的Prompt来生成的,要求模型评估一个子指标相对于另一个子指标的重要性。

-

一致性检查:计算判断矩阵的一致性指数(CI)和一致性比率(CR),以检查成对比较的一致性。如果 CR 低于预设阈值(通常为 0.1),则认为矩阵具有足够的一致性。

-

计算权重:解决特征方程 Aw = λw 以获得最大特征值λ和对应的特征向量 w,然后将特征向量 w 归一化,得到每个子指标的权重。

-

计算综合得分:对于每个句子对(原始句和修正句),根据生成的动态权重计算加权得分。这个得分是通过对每个子指标的得分乘以其相应的权重并求和来得到的。

通过在不同数据集上的实验,DSGram 框架验证了动态权重方法的有效性。实验结果表明,使用动态权重的总体得分与人类评估者提供的总体得分之间的相关性显著高于使用平均权重方法的得分。

DSGram 框架中的动态权重评价方法通过模拟人类评估者的直觉评分过程,为 GEC 模型提供了一个更为精确和上下文相关的评估工具,能够根据不同的评估场景和文本类型动态调整,从而提高评估的准确性和可靠性。

2.2 全面评估GEC模型的三个子指标

全面评估 GEC 模型的三个子指标是 DSGram 框架的核心组成部分,它们的构建过程是基于对现有 GEC 评估方法的深入分析和对大语言模型时代需求的理解。

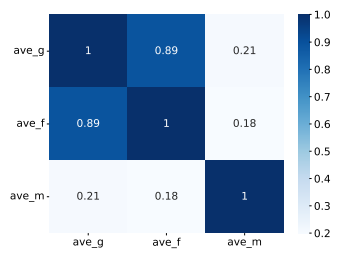

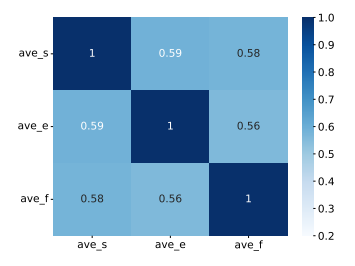

在研究人员的分析中,Asano 等人引入的三个子指标存在冗余和不足。研究人员使用 SOME 的数据集计算这些指标的相关性,结果如图 3 所示。热图显示语法性和流畅性之间的相关性很强。

-

语义一致性(Semantic Coherence)

语义一致性评估的是纠正后的句子是否保留了原始句子的意义。这个指标检查修正后的句子是否传达了与原始句子相同的意图,没有引入语义错误或改变核心信息。语义一致性的重要性在于,即使句子在语法上是正确的,如果它改变了句子的原意,那么这种修正也是不可取的。

-

编辑水平(Edit Level)

编辑水平关注的是 GEC 模型对句子所做的修改程度。这个指标评估所做的修正是否必要和适当,或者句子是否被不必要或过度地修改,从而偏离了原始文本。编辑水平的考虑是为了防止过度纠正,即模型进行了过多的修改,导致句子失去了原有的风格和语境。

-

流畅性(Fluency)

流畅性评估的是纠正后的句子的语法正确性和自然流畅度。这个指标检查句子是否遵循正确的语法规则,结构是否连贯,读起来是否流畅,没有尴尬的措辞或不自然的构造。流畅性是评估 GEC 模型输出质量的关键指标,因为它直接影响到读者对文本的理解和接受。

2.3 模拟人类评分以优化模型

研究人员使用提示工程技术,如 CoT、Few-shot 和在打分前输出理由等来设计 prompt,使 LLM 能够根据上述三个子指标生成分数。

为了验证 DSGram 框架的有效性和降低评估成本,他们开发了 DSGram-Eval 和 DSGram-LLMs 两个数据集。DSGram-Eval 是用人工评分创建的数据集,包含了人类对各类纠正结果的评分,从而为 GEC 模型的评估提供了一个更为真实和全面的基准。DSGram-LLMs 是使用 GPT-4 标注的一个模拟人类评分的数据集,以微调开源 LLM,探索它们用于评分的可行性。

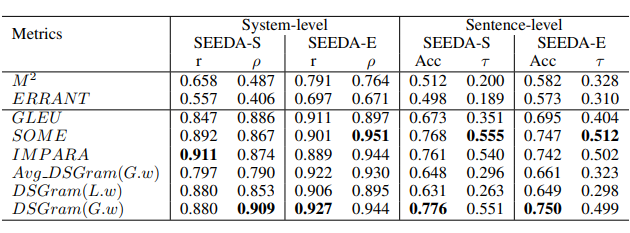

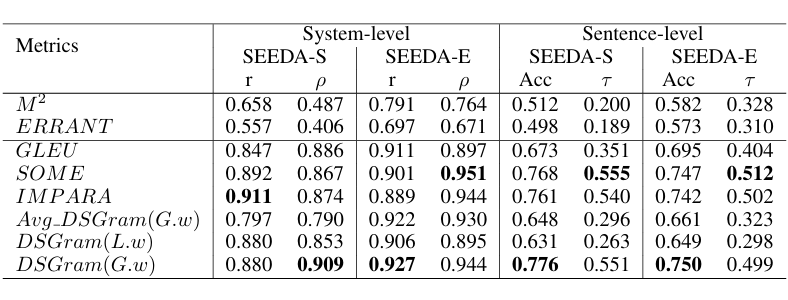

以下是研究人员的方法在公开数据集 SEEDA 上做 meta-evaluation 的结果:

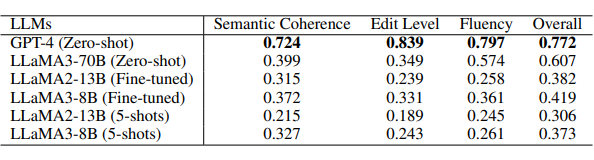

以下是研究人员得方法在不同 LLM 上的表现对比:

总结

当下,虽然 LLM 已经作为评估工具被研究者广泛应用,但在实际实验过程中,输出的 bias 和不稳定性还是很影响 LLM 评分的可信度。为了提高 LLM 评分的透明度和稳定性,研究人员提出了这个评分框架 DSGram,用预先输出各个子指标来提高评分的透明度,然后用动态加权的过程尽可能模拟人类的评分过程。

为什么要使用动态的权重?拿研究人员的三个子指标「流畅性,语义相似度和编辑水平」举例,人类在评分过程中虽然不会给这三个指标赋予一个显式的权重,但还是会在心里对他们三个的重要性有所考量,不同人心目中子指标的重要性也会有所不同。大模型带有推理又具有一定随机性的输出恰好能模拟这个过程。

通过这些努力,DSGram 评估框架,DSGram-Eval 和 DSGram-LLMs 数据集为 GEC 模型的评估提供了一个更为坚实的基础,使得研究者们能够更准确地衡量模型的性能,并探索如何通过动态加权机制来优化评估过程。

(文:PaperWeekly)