大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的“外挂”,所以创建了“AI信息Gap”这个公众号,专注于分享AI全维度知识,包括但不限于AI科普,AI工具测评,AI效率提升,AI行业洞察。关注我,AI之路不迷路,2025我们继续出发。

前有DeepSeek-V3以“黑马”之势火遍国内和海外的AI圈,后有MiniMax-01继续以“惊艳”之姿登场,重拳出击。壮哉我大中国。

1月15日,MiniMax官方正式发布并开源了MiniMax-01系列模型。

同样是国产模型,同样是开源,也是同样的“有实力”。

你很可能还没有听说过MiniMax,这很正常,因为这位“佬”,其在国内的低调程度和前段时间才迅速走红的“DeepSeek”不相上下。

但实际上,MiniMax早已在海外声名远扬。MiniMax有两个面向C端用户的核心产品,一个叫Talkie,中文名:星野;另一个是Hailuo AI,中文名:海螺 AI。Talkie是星野的海外版本,在全球“陪伴AI”类应用中持续位列下载量前三,其他两个是美国的Character.ai和Replika。

而海螺 AI的主力市场依然在国外。据统计,去年11月,海螺 AI的海外版(Hailuo AI)访问量达到了1635万,而国内版只有258万。而实际上,海螺 AI的这两个版本除了域名、语言、登录方式外,可以说一模一样。

海螺 AI国内版长这样。

海外版则长这样。

MiniMax这次发布的MiniMax-01是一个系列模型,包括两个模型:通用文本模型MiniMax-Text-01和多模态模型MiniMax-VL-01。

其中,通用模型MiniMax-Text-01参数量为456B,即4560亿,激活参数为459亿。和传统Transformer架构不同的是,MiniMax-Text-01采用混合注意力机制(Lightning Attention + Softmax Attention)和MoE架构。最值得一提的是上下文窗口长度,MiniMax-Text-01支持100万tokens的训练上下文和400 万tokens的推理上下文。

从MiniMax官方给出的基准测评结果来看,MiniMax-Text-01的表现绝对是“一线水准”,很多测试超过了同样是开源的Llama 3.1 405B,基本上和GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Flash以及DeepSeek V3持平。其实把Gemini 2.0 Flash放在这里对比并不是很合适,因为Gemini系列中的Flash是小参数模型,最强的应该是Gemini-Exp-1206。

MiniMax-VL-01则是基于MiniMax-Text-01构建,增加了多模态能力。

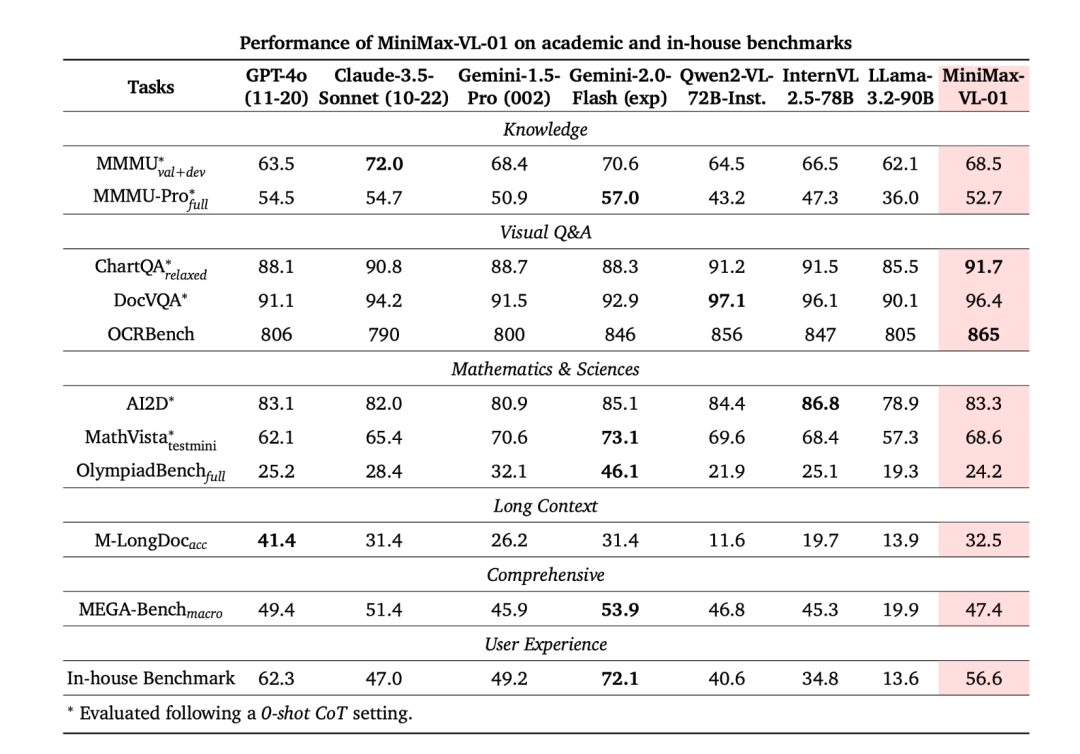

这是在各项针对多模态输入的测试集上,MiniMax-VL-01的表现。

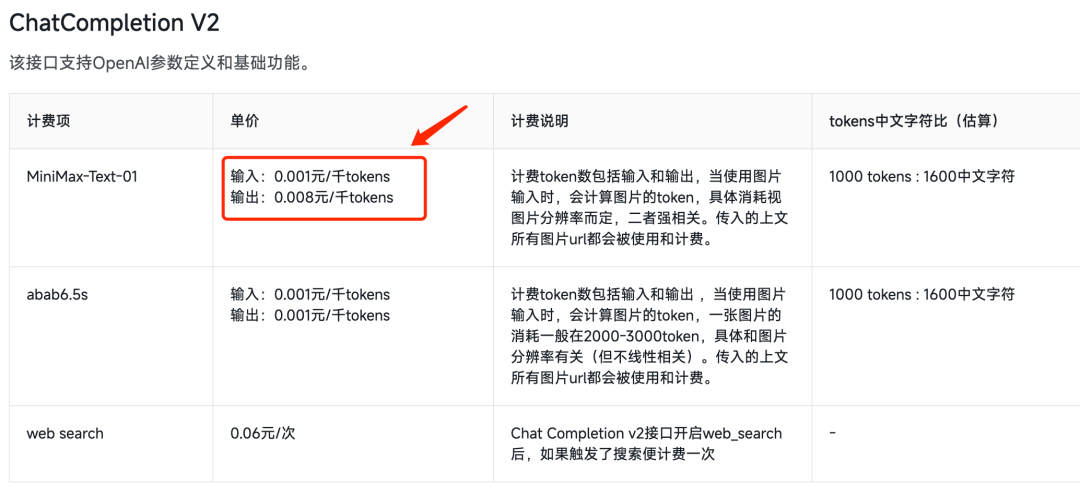

和DeepSeek V3一样,MiniMax-01也同样支持网页端、API调用和本地部署三种使用方式。网页端就是前面介绍的“海螺AI”,免费用;API价格每百万输入和输出tokens分别是1元和8元,这个价格和免费也没什么差了。

但有一说一,模型的基准测试结果仅供参考,真正效果还需要在使用中才能得到验证。

最后,附上MiniMax-01的各个体验地址。

海螺AI国内版:https://hailuoai.com/ 海螺AI海外版:https://www.hailuo.ai/ MiniMax-01 GitHub 仓库:https://github.com/MiniMax-AI/MiniMax-01 MiniMax开发者平台:https://www.minimaxi.com/platform

结语

AI开源领域的“国产之光”,这不就又多了一位。

(文:AI信息Gap)