近日,面壁智能发布并开源了全新一代小钢炮 MiniCPM-o 2.6,这款端到端模型参数规模仅 8B,但在视觉、语音和多模态方面达到了与 GPT-4o-202405 相当的性能。

据悉,MiniCPM-o 2.6 支持双语实时语音对话,声音可配置,还可以实现情绪、语速、风格控制、端到端语音克隆、角色扮演等趣味功能,并在 MiniCPM-V 2.6 的视觉能力上进行了提升,如强大的 OCR 能力、可信行为、多语言支持和视频理解。由于优越的 token 密度,MiniCPM-o 2.6 首次可以支持在 iPad 等端侧设备上进行多模态实时流。

MiniCPM-o 2.6 开源地址:

GitHub:https://github.com/OpenBMB/MiniCPM-o

Huggingface:https://huggingface.co/openbmb/MiniCPM-o-2_6

MiniCPM-o 2.6 采用了端到端全模态架构,不同模态编码器 / 解码器以端到端方式连接和训练,以充分利用丰富的多模态知识;全模态直播流机制,将离线模态编码器 / 解码器改为在线编码器 / 解码器,用于流式输入 / 输出,团队还设计了一种时分复用 (TDM) 机制,用于 LLM 主干中的全模态流处理;可配置语音建模设计,团队设计了一个多模态系统提示,包括传统的文本系统提示和一个新的音频系统提示来确定助手语音,这使得在推理时间内可以灵活地配置语音,同时有助于端到端语音克隆和基于描述的语音创建。

根据面壁的评估,MiniCPM-o 2.6 取得实时流式全模态开源模型 SOTA,性能比肩代表全球最高水平的 GPT-4o、Claude-3.5-Sonnet;在语音方面,取得理解、生成开源双 SOTA,问鼎最强开源语音通用模型;在一贯优势凸显的视觉领域,稳坐最强端侧视觉通用模型。

在评估全模态模型音视频能力的多个榜单上,MiniCPM-o 2.6 能力全面且优秀

在实时流式视频理解能力的代表榜单 StreamingBench 上,MiniCPM-o 2.6 性能惊艳,比肩 GPT-4o、Claude-3.5-Sonnet。

实时流式视频理解能力比肩 GPT-4o、Claude 3.5 Sonnet。

实时流式视频理解能力比肩 GPT-4o、Claude 3.5 Sonnet。

注:GPT-4o API 无法同时输入语音和视频,目前定量评测输入文本和视频

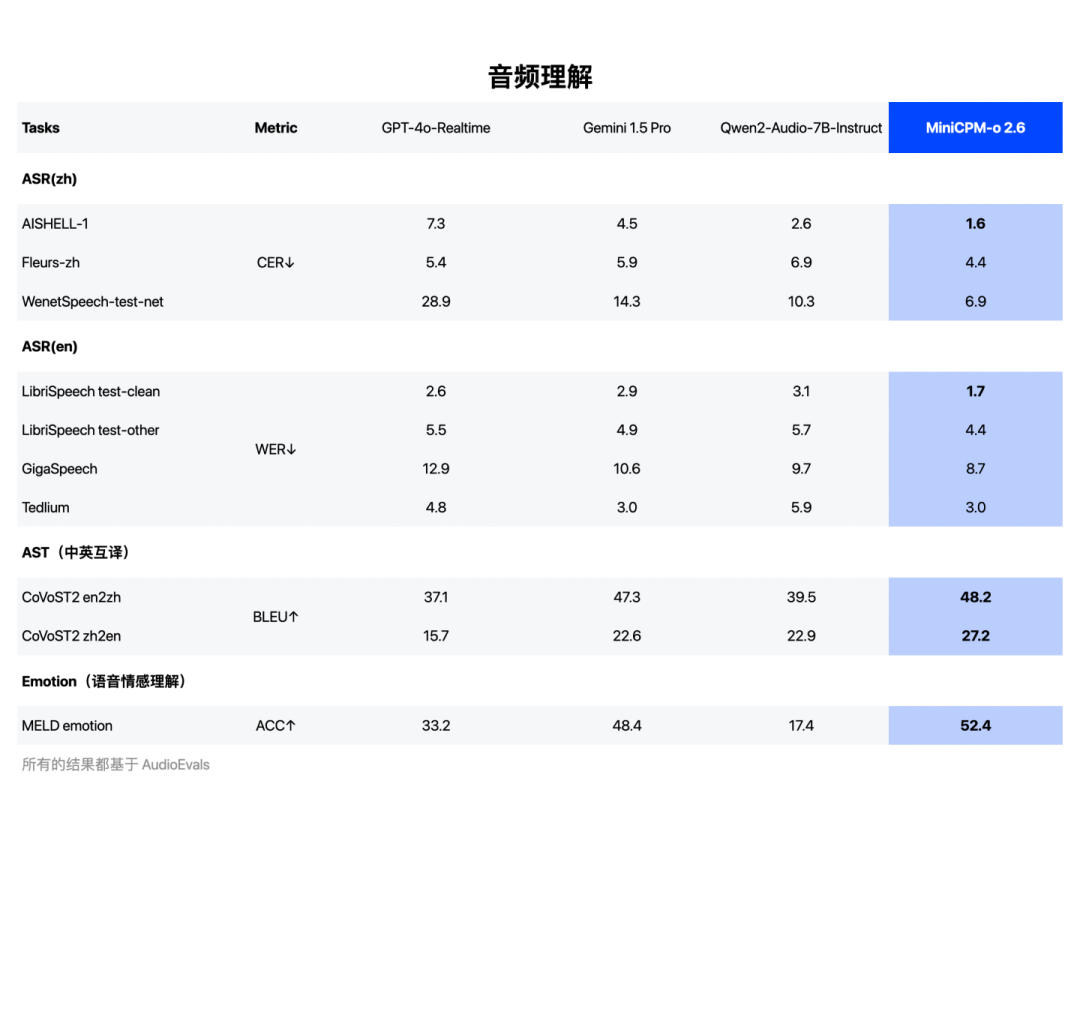

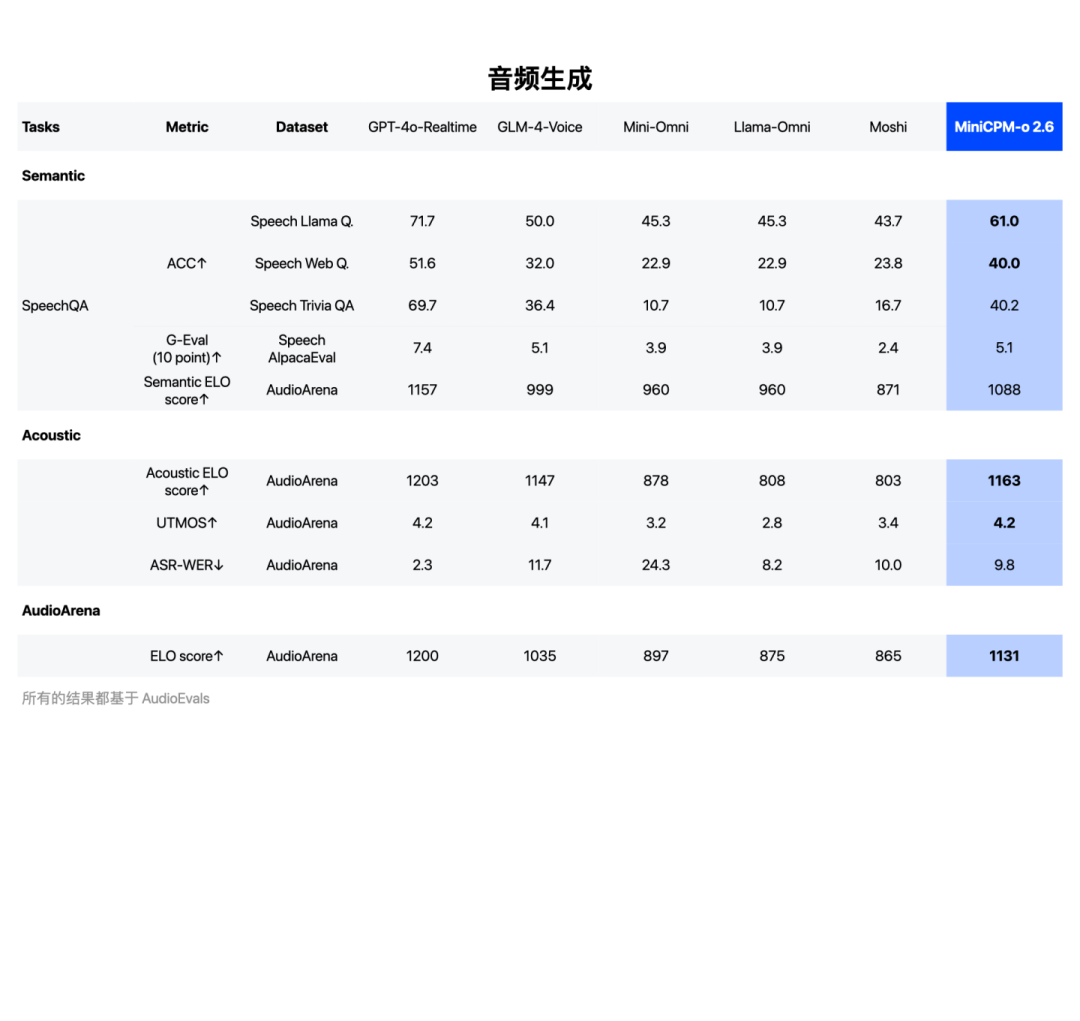

在语音理解方面,超越 Qwen2-Audio-7B-Instruct,实现通用模型开源 SOTA(包括 ASR、语音描述等任务);在语音生成方面,MiniCPM-o 2.6 超越 GLM-4-Voice 9B,实现通用模型开源 SOTA。

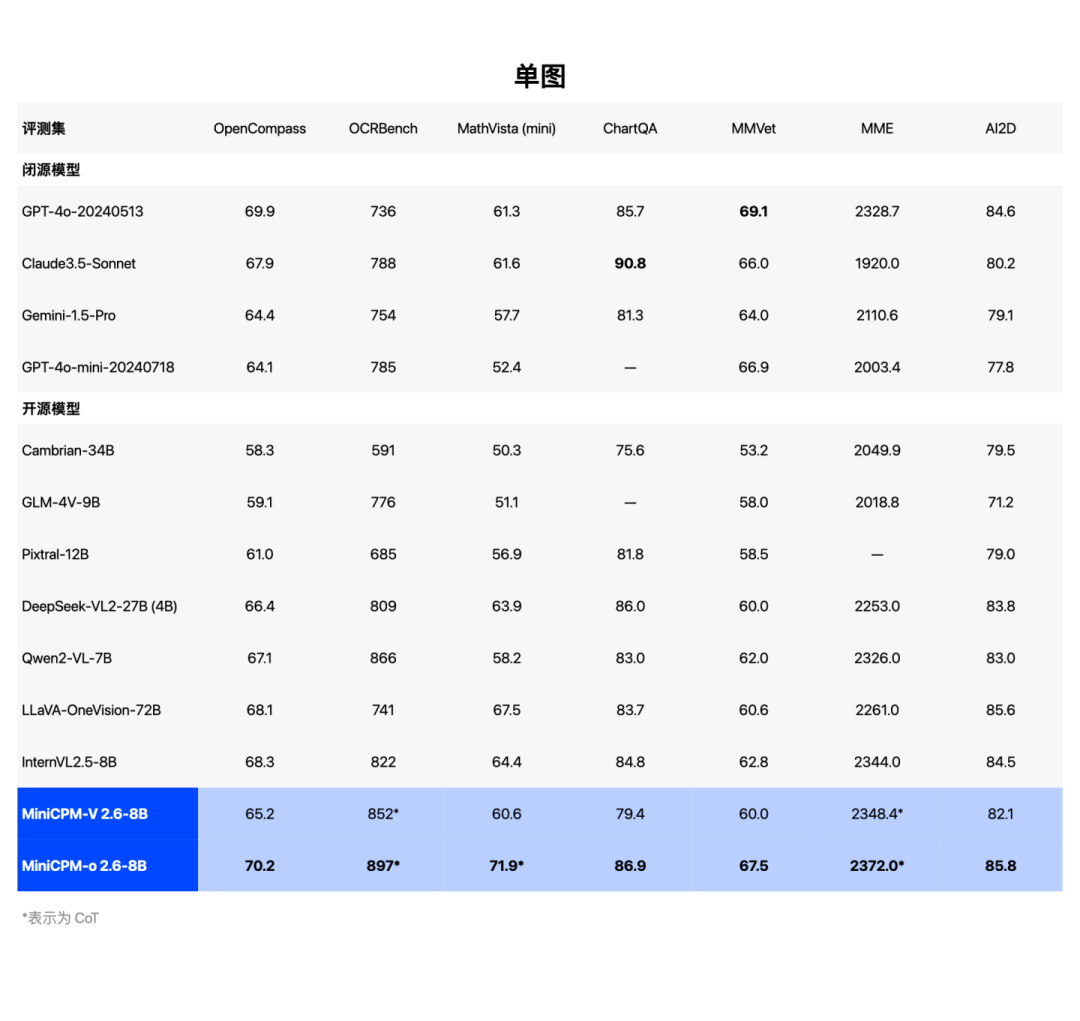

音频理解能力 SOTA,超越 Qwen2-Audio 7B音频生成能力 SOTA,超越 GLM-4-Voice 9B自发布以来,小钢炮多模态系列一直保持着最强端侧视觉通用模型的纪录。光荣再续,MiniCPM-o 2.6 视觉理解能力也达到端侧全模态模型最佳水平。

视觉理解能力 SOTA,超越 GPT-4o、Claude-3.5-Sonnet。

OpenCompass 榜单

为什么我们常常对 AI 味儿避之不及?因为感觉假、和真实的世界隔着一层。MiniCPM-o 2.6 则凭借类似 GPT-4o 的全模态实时流式视频理解与高级语音对话,支持持续看、实时听、自然说,开启实时流式、端到端的丝滑交流。

不是照片大模型

面壁只能表示,市场上主流“音视频通话”模型,实际上只能算作静态的“照片大模型”:仅在用户提问后才开始对视频进行一帧或极少数几帧画面的抽取,无法捕捉用户提问之前的画面,缺乏对前文情境的感知。

而真正的视频大模型,则能够感知用户提问之前的画面和声音,并持续对实时视频和音频流进行建模,这种方式更贴近人眼的自然视觉交互。面壁小钢炮在上一代 MiniCPM-V 2.6 发布时,在视频能力上即已达到。

有了全方面的观察,才能导出正确的推理思考。在三仙归洞、记忆卡牌等游戏中,新一代小钢炮的观察力可以说是明察秋毫,点滴细节不错过,能猜出游戏中小球藏到了哪个杯子,还能记住翻牌游戏中相似图案卡片的细节、位置,神奇极了!

能听懂 GPT-o 听不到的背景声音

MiniCPM-o 2.6 除了听到说话的声音,还有像翻书、倒水、敲门声等生活细节里的声音。而 GPT-4o 不会识别这些环境声音。

实时打断不迷糊

“Her” 中能和人类有情感自然对话的 AI 助手令人印象深刻,继 GPT-4o 的高级情感语音对话模型后,MiniCPM-o 2.6 同样对此进行了演绎,并且即使中间打断也能接着聊。

据介绍,MiniCPM-o 2.6 在高级情感语音方面,总体有以下特征:

-

真人质感的语音生成能力,达到开源通用模型最佳水平;

-

低延迟、可实时打断,如真人交谈般自然

-

具备情感与语气表达:支持可控语音生成(情感、音色、风格控制)

-

可语音模拟定制:支持语音克隆,以及基于语言描述的声音创建等

此外,MiniCPM-o 2.6 避免了传统“语音转文字,再转语音”方案因中间反复信息翻译,而导致的速度慢、信息流失风险,可以捕捉语气、情绪等更丰富的信息。高性能低延迟、更加自然连贯、更强上下文理解、随时打断、抗噪能力等。

面壁智能表示,押注端侧大模型的原因主要有两方面:一是端侧模型具备隐私性好、更可靠、响应快、不惧弱网断网环境等优势;二是公司看到了端侧大模型更早、更快落地的潜力。

MiniCPM-o 2.6 视、听、说全模态的诸多特性,实时的视频流、自然语音交互,接近人类的多模态认知、理解、推理能力,在端侧具有肉眼可见的巨大潜力。比如在智能座舱场景中,全天候、全地域,可以进行舱内控制、舱外识别、智能巡航;教育场景中,前所未有的沉浸式学习体验,特别是跟虚拟现实或增强现实技术结合使用;商务场景中,为国际会议和多语言环境提供实时翻译服务,个人旅行者能够与不同语言的本地人无障碍沟通等。

进入 2025 年,大模型规模定律(Scaling Law )面临训练数据和计算资源方面的可持续发展问题,但规模定律并非预测大模型发展的唯一视角。面壁团队提出大模型密度定律(Densing Law)—— 模型能力密度随时间呈指数级增长,实现相同能力的模型参数每 3.3 个月(约 100 天) 下降一半 ,并且模型推理开销随时间指数级下降,以及模型训练开销随时间迅速下降。

根据大模型的密度定律预测,在通往 AGI 的道路上,大模型能力密度不断提升,大约每 3.3 个月翻一番,模型推理开销、训练开销随时间快速下降到大规模应用临界水平。当模型在同一参数量上能释放更强的智能,训练和推理成本持续下降,芯片在同样的面积 / 功耗上,算力能支撑更大的模型,双向驱动下,大模型就能运行在各类终端上。

(文:AI前线)

这不就等于拥有了一个全能大神!这也太强了吧!