跳至内容

中国AI模型DeepSeek引发的全球讨论热潮持续近半个月,美国OpenAI公司终于发布新模型对此进行“反击”。

北京时间2月1日凌晨,OpenAI CEO奥尔特曼(Sam Altman)在 2 周前预告后,今天在ChatGPT和API服务中推出 AI 推理模型o3-mini,性能响应速度比o1-mini提升 24%,答案准确性也有所提高。

目前ChatGPT免费用户首次可以体验一个有限速率的o3-mini版本,速率限制与现有的 GPT-4o 限制类似;Plus用户可选择o3-mini-high更高智能版本;每月支付200美元的 Pro 用户可无限使用o3-mini和o3-mini-high;API层面,o3-mini输入1.10美元/百万token、输出4.40美元/百万token,价格比o1-mini便宜63%,比满血版o1便宜93%,但仍是GPT-4o mini的7倍左右。

OpenAI表示,o3-mini的发布是在追求高效能智能技术道路上的又一重要里程碑。通过优化科学(Science)、技术(Technology)、工程(Engineering)和数学(Mathematics)领域的推理能力,同时保持较低的成本,让高质量AI技术变得更加平易近人。

事实上,过去一周内,DeepSeek R1和V3两款开源 AI 模型都颠覆世界对于“尺度定律”(Scaling Law)的看法,其模型的优异表现以及不及OpenAI近1/20的算力成本令OpenAI内部震动,而且让华尔街开始质疑 AI 公司是否需要在算力成本投入大量资金实现AGI模型迭代,英伟达股价一夜暴跌17%,损失近6000亿美元市值。

然而,据SemiAnalysis,与外界认为DeepSeek公司拥有5万张H100 GPU计算卡看法不同,该机构认为,DeepSeek堆积了6万张英伟达GPU卡,其中包括1万张H100、1万张H100、1万张“特供版”H800、3万张“特供版”H20,算力资本支出的总体拥有成本(TCO)超过140亿元,达19.96亿美元(约合人民币143.45亿美元)。其中,CapEx总服务器资本支出12.81亿元、运营成本7.15亿美元。

要知道,英伟达过去一年内才生产100万张“特供版”GPU卡。

最新消息是,OpenAI正在进行新一轮400亿美元的融资,软银将领投,公司价值高达3000亿美金(约合人民币2.16万亿元),对此OpenAI并未置评。

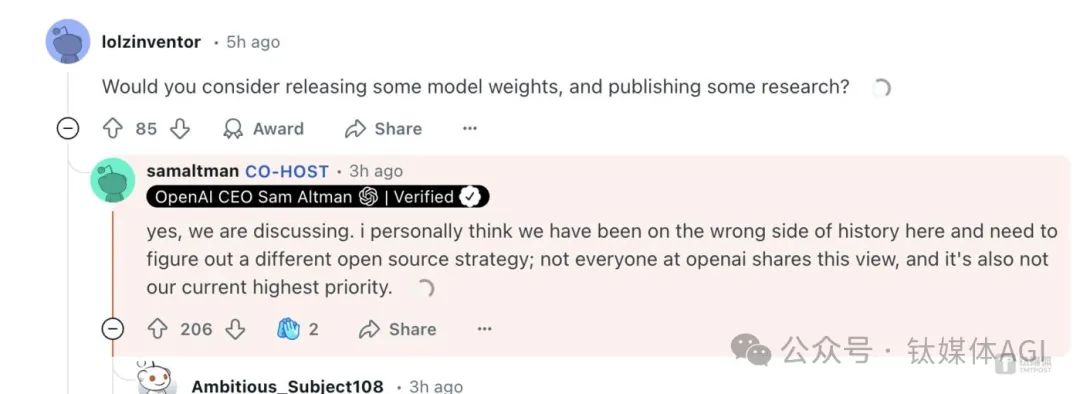

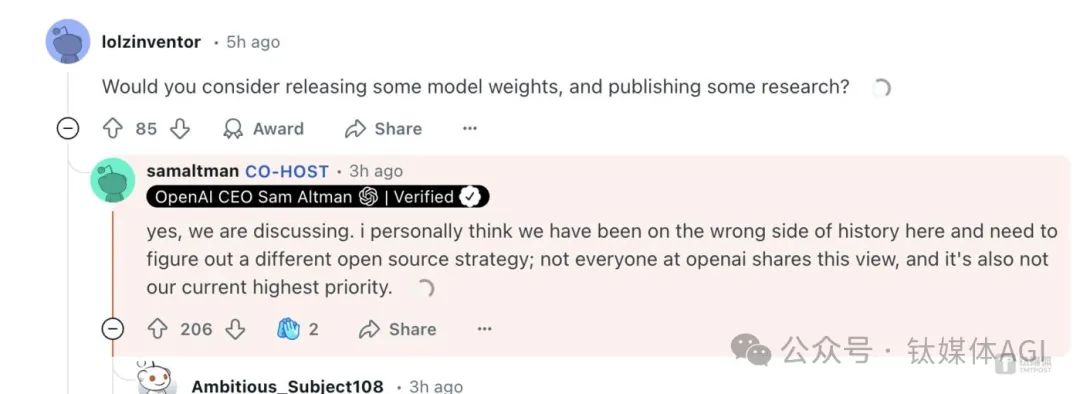

而在o3mini正式推出之时,奥特曼今晨在回答网友问题时,罕见承认OpenAI 过去在开源方面一直站在“历史错误的一边”。他表示,“我个人认为,我们在这里站在了历史的错误一边,需要找出一个不同的开源策略。OpenAI中并非所有人都认同这一观点,这也不是我们当前的最高优先事项。”这意味着,OpenAI正在考虑开源。

在价格、性能等层面,o3-mini是目前OpenAI性价比高的模型,多项技术能力超越了DeepSeek R1(从上图看)。

那么,随着DeepSeek好评如潮,OpenAI 这个昔日AI霸主如何对战?140亿(算力)VS 2.16万亿(公司价值),一场围绕中国、美国两家有实力的 AI 公司战争已经打响。

模型转向后训练和算法,

300万美金的AI能力也能超GPT

回顾过去4年,“DeepSeek缔造者”梁文锋带领200多人的团队围绕 AI 大模型进行深入研发。

由于DeepSeek背后的幻方量化是国内少数拥有数百亿管理规模的量化私募基金机构,既不缺钱又不融资,甚至DeepSeek没有准备做To B/To C商业化,手里的万卡算力也没有做云计算生意。

人才层面,DeepSeek目前约有不到200名研发人员,并且只从中国招聘人才,不看重过往资历,高度关注能力和求知欲,据称为研发人员提供最高超过130万美元的年薪,远超中国其他科技大厂,以及“大模型六小虎”这类 AI 创业公司。

简单来说,梁文锋认为的DeepSeek,就是好奇心驱使,不需要靠大模型赚钱,只为推动AGI(通用人工智能)。因此,基于梁文锋对于高端算力限制的需求,DeepSeek不断堆砌数万张英伟达 AI 算力卡。

SemiAnalysis称,即便考虑到出口管制因素,DeepSeek和幻方在GPU上的投资也超过5亿美元。

从结果上来看,这种“降本增效”的效果是很好的:DeepSeek V3模型整个训练在2048块英伟达H800 GPU集群上完成,仅花费57天、共计约557.6万美元,不到其他顶尖模型训练成本的十分之一;最新的开源多模态模型Janus-Pro-7B用256张英伟达A100 GPU卡训练了14天,最少的10亿参数模型用128张英伟达A100训练7天,成本仅数千美金。

这种低成本转化模型能力和应用落地,与所谓的“杰文斯悖论”(Jevons Paradox)现象有些类似。

“杰文斯悖论”是由英国经济学家威廉·斯坦利·杰文斯(William Stanley Jevons)在1865年发现的重要现象:蒸汽机效率的提高并非减少了,而是导致了对煤炭需求的持续增长,这是因为高效的蒸汽机逐渐进入了社会生产的每一个角落。

因此,相较于OpenAI GPT-4这类大语言模型(LLM),无论是GPT-o1、o3系列,还是DeepSeek R1,核心就是用更低的成本实现更高的(推理)模型性能和更多的智能思维能力。而计算能力越强,推理模型就可以思考更多步骤,从而提高得出正确答案的可能性,在这其中,算力软件优化成为关键要素。

清华大学计算机系长聘教授、高性能计算研究所所长、清程极智首席科学家翟季冬表示,DeepSeek在MoE架构算法、系统软件层次做了很多创新,它给我们的启示,更多在于如何在有限的算力情况下,通过算法和软件的协同创新,充分挖掘硬件的极致性能,对中国未来发展 AI 产业至关重要。

翟季冬认为,在预训练模型完成后,还有一个很重要的阶段就是后训练(post training)。以OpenAI o1/o3 为代表的后训练技术,为整个训练过程带来了新的挑战。而后训练包括生成阶段、推理阶段和微调阶段,每个阶段的负载特点都不同,最优的并行策略也会不同,不能简单地追求每个阶段的局部最优,因为阶段之间的切换也会产生开销。我们要从整个pipeline(管道)的角度来考虑优化策略。后训练还面临着负载不均衡的问题,需要探索如何有效重叠不同阶段以提高资源利用率。

如今,o3 mini和DeepSeek R1都使用大量监督微调 (SFT)、强化学习 (RL) 、合成数据以及稀疏化MoE等能力。

苹果公司研究团队和麻省理工学院的合作者 Harshay Shah近期共同发表的《参数与 FLOPs:混合专家语言模型最优稀疏度的缩放定律》显示,包括DeepSeek 和其他最近创新在内,稀疏性是这类模型发展的关键要素,证明DeepSeek通过关闭越来越多的网络部分,在计算能力较低的情况下达到相同或更好的结果,因为重要的是模型的稀疏性,它能找到AI模型和可用计算之间的最佳匹配。

很显然,有效使用有限的计算能力,将模型发展的关键要素。

AI独角兽零一万物创始人兼CEO李开复曾表示,现在一个模型训练只用了2000张GPU,训练周期仅一个半月,成本只有300多万美元,是马斯克的xAI成本的1%、2%。

整体来说,正如SemiAnalysis所讲,到目前为止,这种“降本增效”模式的结果是,每年算法的进步速度快4倍,这意味着每过一年,实现相同功能所需的计算量就会减少4倍。整体来说,成本随时间变化,算法的改进和优化使成本降低了10倍,而能力提高了数倍。

Anthropic首席执行官Dario Amodei认为,算法的进步速度更快,可以带来10倍的改进。就GPT-3质量的推理定价而言,成本已下降了1200倍。

OpenAI准备开源?

完整版o3最快几周内上线

OpenAI在发布o3 mini时表示,其团队降低了token价格。自推出GPT-4以来,每个token的价格降低了95%,但同时保持了顶级的推理能力。

“是的,我们在讨论。我个人认为我们在某些方面可能站错了历史的一边,需要找出不同的开源策略;并不是所有来自OpenAI的人都持有这种观点,这也不是我们当前的最高优先事项。”

这是奥尔特曼首次正面承认OpenAI的闭源“是一个错误”。在DeepSeek热潮刺激下,奥尔特曼终于打算把推理o1,或基座GPT模型进行开源,在一定程度上,这将是一个突破性事件。

今晨发布的o3-mini模型,主要包括高、中、低三个版本,没有思考技术——奥尔特曼称将很快上线。

OpenAI表示,o3-mini模型擅长科学、数学和编码,测试人员在56%的时间里更喜欢o3-mini的回答,并观察到在困难的现实问题上重大错误减少了 39%。在中等推理努力下,o3-mini在一些最具挑战性的推理和智力评估(包括 AIME 和 GPQA)上的表现与o1相当。因此,与o1-mini相比,o3-mini的答案更准确、更清晰,推理能力更强。

根据OpenAI发布关于o3-mini研究论文显示,OpenAI o3-mini已在各种数据集上进行了预训练,其中包括多种公开数据,以及内部开发的定制数据集,因此,OpenAI o3-mini 在某些基准上的表现与最先进的⽔平相当。通过计划允许用户使⽤ChatGPT o3-mini 搜索互联⽹并汇总结果,OpenAI希望o3-mini成为⼀个有⽤且安全的模型。

幻觉方面,OpenAI有透露,o3-mini PersonQA 幻觉率(越低越好)低至14.8%,比4o的52%幻觉率大大降低,但PersonQA准确率却没有特别“缩水”。o3-mini整体表现与OpenAI o1-mini⽐较相似,但在模糊性问题的准确性、明确问题的准确性上均略有下降。

OpenAI API研究主管Michelle Pokrass表示:“我们发现o3-mini与美国托管的Deepseek版本相比具有竞争力。我们认为对于这种级别的智能来说,这是一个真正实惠的选择。”

谈及DeepSeek,奥尔特曼在Reddit回答中表示,“这是一个非常好的模型!我们将生产出更好的模型,但领先优势将比前几年有所减弱。”

那么,OpenAI会计划提高plus会员的价格吗?奥尔特曼回应称:“实际上我想随着时间的推移减少它。”

对于完整版o3模型发布时间,奥尔特曼一如既往开始画饼:“我猜会是几周以上,几个月以下。”

关于很多人都关心的GPT-5,奥尔特曼表示还没有时间表,但会有一些即将发布如高级语音模式的更新。

“是的,高级语音模式的更新即将到来!我认为我们会称之为 GPT-5 而不是 GPT-5o。(GPT-5)还没有时间表。”奥尔特曼称。

当前,DeepSeek正面临美国政企等各方面的调查承压。其中,微软和OpenAI都已开始调查DeepSeek是否采用其模型数据;美国总统特朗普警告称,DeepSeek为美国科技行业敲响了警钟,需要对美国AI开放、持续限制对华AI半导体出口;而美国商务部、美国议员都纷纷要求调查DeepSeek,以及持续限制半导体出口管制。

Dario Amodei近期发文表示,DeepSeek最新模型在特定基准测试中已逼近美国顶尖水平,基于此,他坦承,DeepSeek 的突破正在倒逼美国重新评估技术封锁政策的有效性,“我认为DeepSeek的进展反而令出口管制政策显得比一周前更具存在意义上的重要性。”在Dario看来,美国要在 AI 发展中保持领先地位,力所能及的情况下,美国不应将技术优势拱手让给中国。

在大众看来,对DeepSeek,中美的反应最好都适度冷却。对中国来说,要在庆祝和自豪的同时警惕危机,防止媒体和社会的“捧杀”;对美国而言,要客观理性看待DeepSeek的成功,用实际行动进行竞争,无论是OpenAI o3-mini,还是阿里通义新模型,都证明了这一点。

DeepSeek对于中国来说无疑是重大的新年礼物,如今只有+86手机号才能注册,这将对美国来说产生“壁垒”。

无论中美两国如何博弈,但过去一周的舆论场,已经对中美下一阶段 AI 竞争产生了深远影响。

中欧国际工商学院决策科学与管理信息系统教授谭寅亮对钛媒体AGI表示,对于DeepSeek这样的产品来说,其成功更多依赖于高效的算力调度和模型优化能力,而非单纯堆积硬件资源。因此,出口管制等外部限制可能影响行业发展速度,但并不一定会阻碍本土大模型的长期竞争力和全球化扩张。

“DeepSeek的成功表明,中国企业在AI应用层面和用户体验上具有强大的创新能力,尤其是在产品快速迭代和市场化方面更具优势。这为中国在全球AI竞争中提供了重要的信心,特别是在C端市场表现上,中国团队对用户需求的深刻理解起到了关键作用。但从技术底层来看,美国在基座模型和前沿研究上的持续领先仍是重要支撑,整体竞争格局依然呈现‘底层技术美国强、应用场景中国快’的局面。DeepSeek的崛起进一步推动了这种竞争的动态化发展。”谭寅亮表示。

(文:钛媒体AGI)