模型优化

阿里通义发布并行计算新策略:1.6B等效4.4B,内存消耗骤降95%

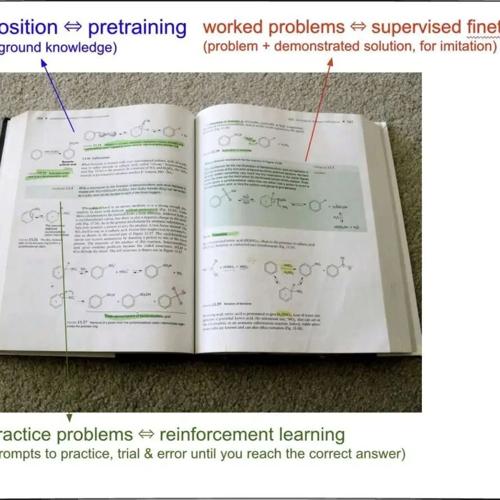

阿里通义团队提出的新范式PARSCALE通过扩展CFG的双路径到P条并行路径,显著提升了1.6B模型的性能,仅占用后者的1/22内存,并将延迟增加量减少至1/6。该方法无需从头训练现有模型(如Qwen-2.5),并在GSM8K数学推理任务中实现了34%的性能提升。

OpenAI背叛理想?DeepSeek才是AGI该有的样子!——独家揭秘Lex Fridman对话AI大神背后的真相!

王炸!王炸!王炸!重要的事情说三遍!

春节期间,DeepSeek,这家带着神秘东方力量的AI新贵,扔

OpenAI 推 Deep Research:复刻Google、“致敬”DeepSeek,啥也不管了就是追

OpenAI发布新工具Deep Research,能为用户提供高效的独立研究助手。它能在互联网上快速搜索、分析并整合大量信息源生成高质量综合报告,覆盖金融、科学等专业领域。目前仅提供Pro用户每月100次查询额度。